使用 DataX 實(shí)現(xiàn) MySQL 數(shù)據(jù)的高效同步

我們公司有個(gè)項(xiàng)目的數(shù)據(jù)量高達(dá)五千萬,但是因?yàn)閳?bào)表那塊數(shù)據(jù)不太準(zhǔn)確,業(yè)務(wù)庫和報(bào)表庫又是跨庫操作,所以并不能使用 SQL 來進(jìn)行同步。當(dāng)時(shí)的打算是通過 mysqldump 或者存儲(chǔ)的方式來進(jìn)行同步,但是嘗試后發(fā)現(xiàn)這些方案都不切實(shí)際:

mysqldump:不僅備份需要時(shí)間,同步也需要時(shí)間,而且在備份的過程,可能還會(huì)有數(shù)據(jù)產(chǎn)出(也就是說同步等于沒同步)

存儲(chǔ)方式:這個(gè)效率太慢了,要是數(shù)據(jù)量少還好,我們使用這個(gè)方式的時(shí)候,三個(gè)小時(shí)才同步兩千條數(shù)據(jù)…

后面在網(wǎng)上查看后,發(fā)現(xiàn) DataX 這個(gè)工具用來同步不僅速度快,而且同步的數(shù)據(jù)量基本上也相差無幾。

一、DataX 簡(jiǎn)介

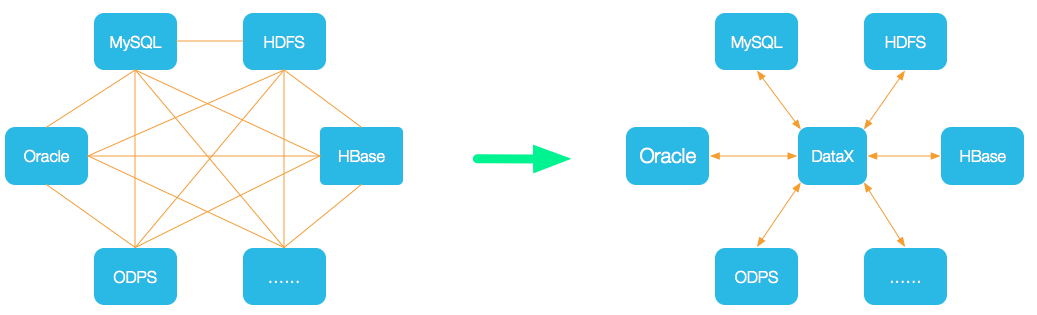

DataX 是阿里云 DataWorks 數(shù)據(jù)集成 的開源版本,主要就是用于實(shí)現(xiàn)數(shù)據(jù)間的離線同步。DataX 致力于實(shí)現(xiàn)包括關(guān)系型數(shù)據(jù)庫(MySQL、Oracle 等)、HDFS、Hive、ODPS、HBase、FTP 等 各種異構(gòu)數(shù)據(jù)源(即不同的數(shù)據(jù)庫) 間穩(wěn)定高效的數(shù)據(jù)同步功能。

為了 解決異構(gòu)數(shù)據(jù)源同步問題,DataX 將復(fù)雜的網(wǎng)狀同步鏈路變成了星型數(shù)據(jù)鏈路,DataX 作為中間傳輸載體負(fù)責(zé)連接各種數(shù)據(jù)源; 當(dāng)需要接入一個(gè)新的數(shù)據(jù)源時(shí),只需要將此數(shù)據(jù)源對(duì)接到 DataX,便能跟已有的數(shù)據(jù)源作為無縫數(shù)據(jù)同步。

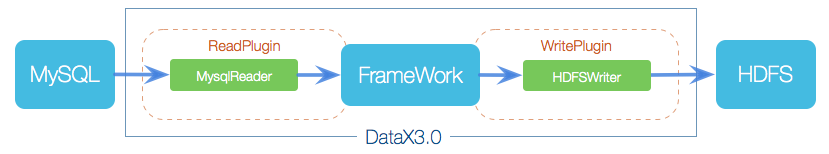

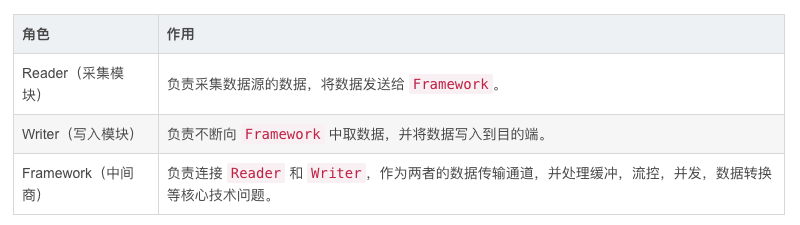

1.DataX 3.0 框架設(shè)計(jì)

DataX 采用 Framework + Plugin 架構(gòu),將數(shù)據(jù)源讀取和寫入抽象稱為 Reader/Writer 插件,納入到整個(gè)同步框架中。

2.DataX 3.0 核心架構(gòu)

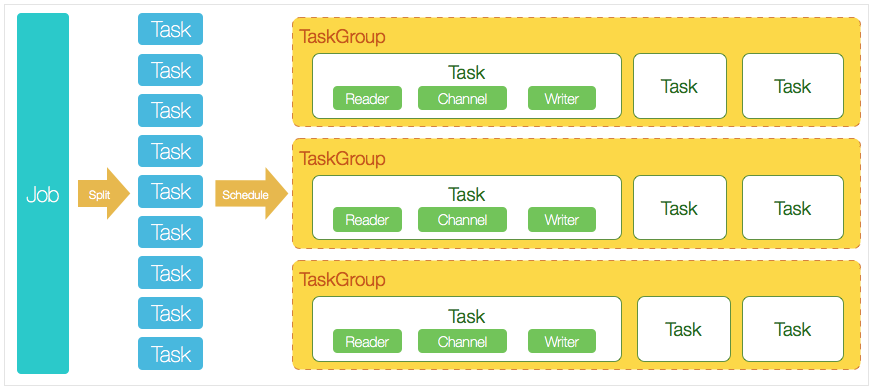

DataX 完成單個(gè)數(shù)據(jù)同步的作業(yè),我們稱為 Job,DataX 接收到一個(gè) Job 后,將啟動(dòng)一個(gè)進(jìn)程來完成整個(gè)作業(yè)同步過程。DataX Job 模塊是單個(gè)作業(yè)的中樞管理節(jié)點(diǎn),承擔(dān)了數(shù)據(jù)清理、子任務(wù)切分、TaskGroup 管理等功能。

DataX Job 啟動(dòng)后,會(huì)根據(jù)不同源端的切分策略,將 Job 切分成多個(gè)小的 Task (子任務(wù)),以便于并發(fā)執(zhí)行。 接著 DataX Job 會(huì)調(diào)用 Scheduler 模塊,根據(jù)配置的并發(fā)數(shù)量,將拆分成的 Task 重新組合,組裝成 TaskGroup(任務(wù)組) 每一個(gè) Task 都由 TaskGroup 負(fù)責(zé)啟動(dòng),Task 啟動(dòng)后,會(huì)固定啟動(dòng) Reader --> Channel --> Writer 線程來完成任務(wù)同步工作。 DataX 作業(yè)運(yùn)行啟動(dòng)后,Job 會(huì)對(duì) TaskGroup 進(jìn)行監(jiān)控操作,等待所有 TaskGroup 完成后,Job 便會(huì)成功退出(異常退出時(shí) 值非 0)

DataX 調(diào)度過程:

首先 DataX Job 模塊會(huì)根據(jù)分庫分表切分成若干個(gè) Task,然后根據(jù)用戶配置并發(fā)數(shù),來計(jì)算需要分配多少個(gè) TaskGroup; 計(jì)算過程:Task / Channel = TaskGroup,最后由 TaskGroup 根據(jù)分配好的并發(fā)數(shù)來運(yùn)行 Task(任務(wù))

二、使用 DataX 實(shí)現(xiàn)數(shù)據(jù)同步

準(zhǔn)備工作:

JDK(1.8 以上,推薦 1.8) Python(2,3 版本都可以) Apache Maven 3.x(Compile DataX)(手動(dòng)打包使用,使用 tar包方式不需要安裝)

安裝 JDK:下載地址(需要?jiǎng)?chuàng)建 Oracle 賬號(hào))

[root@MySQL-1 ~]# ls

anaconda-ks.cfg jdk-8u181-linux-x64.tar.gz

[root@MySQL-1 ~]# tar zxf jdk-8u181-linux-x64.tar.gz

[root@DataX ~]# ls

anaconda-ks.cfg jdk1.8.0_181 jdk-8u181-linux-x64.tar.gz

[root@MySQL-1 ~]# mv jdk1.8.0_181 /usr/local/java

[root@MySQL-1 ~]# cat <<END >> /etc/profile

export JAVA_HOME=/usr/local/java

export PATH=$PATH:"$JAVA_HOME/bin"

END

[root@MySQL-1 ~]# source /etc/profile

[root@MySQL-1 ~]# java -version

因?yàn)?CentOS 7 上自帶 Python 2.7 的軟件包,所以不需要進(jìn)行安裝。

1.Linux 上安裝 DataX 軟件

[root@MySQL-1 ~]# wget http://datax-opensource.oss-cn-hangzhou.aliyuncs.com/datax.tar.gz

[root@MySQL-1 ~]# tar zxf datax.tar.gz -C /usr/local/

[root@MySQL-1 ~]# rm -rf /usr/local/datax/plugin/*/._* # 需要?jiǎng)h除隱藏文件 (重要)

當(dāng)未刪除時(shí),可能會(huì)輸出:[/usr/local/datax/plugin/reader/._drdsreader/plugin.json] 不存在. 請(qǐng)檢查您的配置文件.

驗(yàn)證:

[root@MySQL-1 ~]# cd /usr/local/datax/bin

[root@MySQL-1 ~]# python datax.py ../job/job.json # 用來驗(yàn)證是否安裝成功

輸出:

2021-12-13 19:26:28.828 [job-0] INFO JobContainer - PerfTrace not enable!

2021-12-13 19:26:28.829 [job-0] INFO StandAloneJobContainerCommunicator - Total 100000 records, 2600000 bytes | Speed 253.91KB/s, 10000 records/s | Error 0 records, 0 bytes | All Task WaitWriterTime 0.060s | All Task WaitReaderTime 0.068s | Percentage 100.00%

2021-12-13 19:26:28.829 [job-0] INFO JobContainer -

任務(wù)啟動(dòng)時(shí)刻 : 2021-12-13 19:26:18

任務(wù)結(jié)束時(shí)刻 : 2021-12-13 19:26:28

任務(wù)總計(jì)耗時(shí) : 10s

任務(wù)平均流量 : 253.91KB/s

記錄寫入速度 : 10000rec/s

讀出記錄總數(shù) : 100000

讀寫失敗總數(shù) : 0

2.DataX 基本使用

查看 streamreader --> streamwriter 的模板:

[root@MySQL-1 ~]# python /usr/local/datax/bin/datax.py -r streamreader -w streamwriter

輸出:

DataX (DATAX-OPENSOURCE-3.0), From Alibaba !

Copyright (C) 2010-2017, Alibaba Group. All Rights Reserved.

Please refer to the streamreader document:

https://github.com/alibaba/DataX/blob/master/streamreader/doc/streamreader.md

Please refer to the streamwriter document:

https://github.com/alibaba/DataX/blob/master/streamwriter/doc/streamwriter.md

Please save the following configuration as a json file and use

python {DATAX_HOME}/bin/datax.py {JSON_FILE_NAME}.json

to run the job.

{

"job": {

"content": [

{

"reader": {

"name": "streamreader",

"parameter": {

"column": [],

"sliceRecordCount": ""

}

},

"writer": {

"name": "streamwriter",

"parameter": {

"encoding": "",

"print": true

}

}

}

],

"setting": {

"speed": {

"channel": ""

}

}

}

}

根據(jù)模板編寫 json 文件

[root@MySQL-1 ~]# cat <<END > test.json

{

"job": {

"content": [

{

"reader": {

"name": "streamreader",

"parameter": {

"column": [ # 同步的列名 (* 表示所有)

{

"type":"string",

"value":"Hello."

},

{

"type":"string",

"value":"河北彭于晏"

},

],

"sliceRecordCount": "3" # 打印數(shù)量

}

},

"writer": {

"name": "streamwriter",

"parameter": {

"encoding": "utf-8", # 編碼

"print": true

}

}

}

],

"setting": {

"speed": {

"channel": "2" # 并發(fā) (即 sliceRecordCount * channel = 結(jié)果)

}

}

}

}

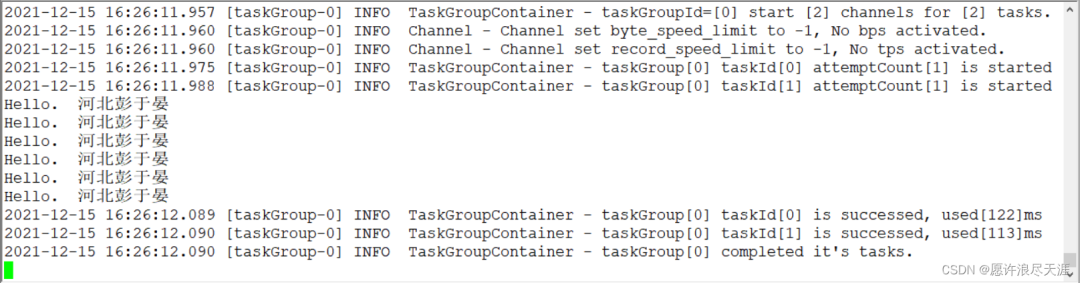

輸出:(要是復(fù)制我上面的話,需要把 # 帶的內(nèi)容去掉)

3.安裝 MySQL 數(shù)據(jù)庫

分別在兩臺(tái)主機(jī)上安裝:

[root@MySQL-1 ~]# yum -y install mariadb mariadb-server mariadb-libs mariadb-devel

[root@MySQL-1 ~]# systemctl start mariadb # 安裝 MariaDB 數(shù)據(jù)庫

[root@MySQL-1 ~]# mysql_secure_installation # 初始化

NOTE: RUNNING ALL PARTS OF THIS SCRIPT IS RECOMMENDED FOR ALL MariaDB

SERVERS IN PRODUCTION USE! PLEASE READ EACH STEP CAREFULLY!

Enter current password for root (enter for none): # 直接回車

OK, successfully used password, moving on...

Set root password? [Y/n] y # 配置 root 密碼

New password:

Re-enter new password:

Password updated successfully!

Reloading privilege tables..

... Success!

Remove anonymous users? [Y/n] y # 移除匿名用戶

... skipping.

Disallow root login remotely? [Y/n] n # 允許 root 遠(yuǎn)程登錄

... skipping.

Remove test database and access to it? [Y/n] y # 移除測(cè)試數(shù)據(jù)庫

... skipping.

Reload privilege tables now? [Y/n] y # 重新加載表

... Success!

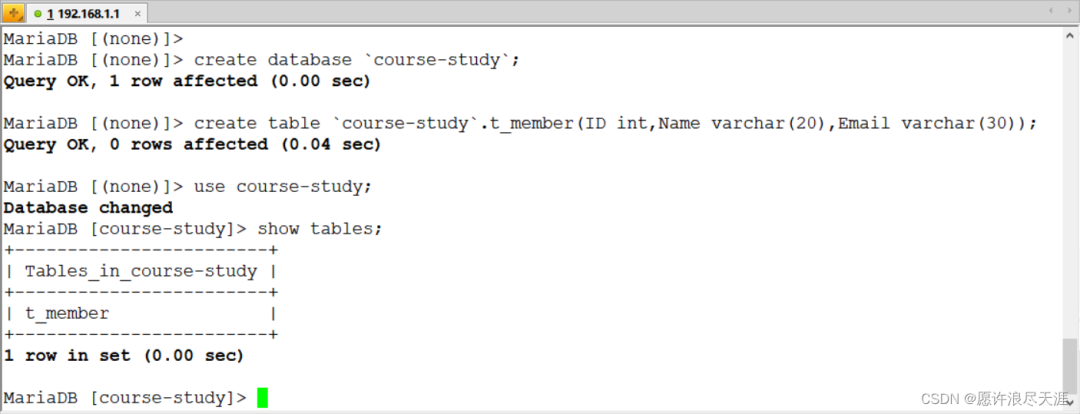

1)準(zhǔn)備同步數(shù)據(jù)(要同步的兩臺(tái)主機(jī)都要有這個(gè)表)

MariaDB [(none)]> create database `course-study`;

Query OK, 1 row affected (0.00 sec)

MariaDB [(none)]> create table `course-study`.t_member(ID int,Name varchar(20),Email varchar(30));

Query OK, 0 rows affected (0.00 sec)

因?yàn)槭鞘褂?DataX 程序進(jìn)行同步的,所以需要在雙方的數(shù)據(jù)庫上開放權(quán)限:

grant all privileges on *.* to root@'%' identified by '123123';

flush privileges;

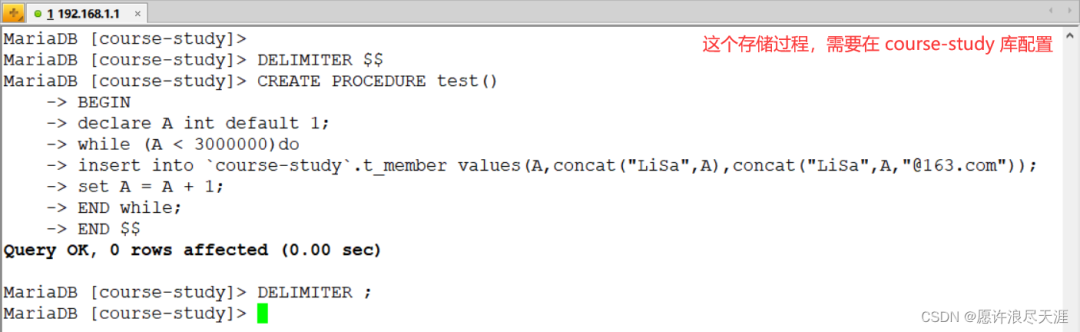

2)創(chuàng)建存儲(chǔ)過程:

DELIMITER $$

CREATE PROCEDURE test()

BEGIN

declare A int default 1;

while (A < 3000000)do

insert into `course-study`.t_member values(A,concat("LiSa",A),concat("LiSa",A,"@163.com"));

set A = A + 1;

END while;

END $$

DELIMITER ;

3)調(diào)用存儲(chǔ)過程(在數(shù)據(jù)源配置,驗(yàn)證同步使用):

call test();

4.通過 DataX 實(shí) MySQL 數(shù)據(jù)同步

1)生成 MySQL 到 MySQL 同步的模板:

[root@MySQL-1 ~]# python /usr/local/datax/bin/datax.py -r mysqlreader -w mysqlwriter

{

"job": {

"content": [

{

"reader": {

"name": "mysqlreader", # 讀取端

"parameter": {

"column": [], # 需要同步的列 (* 表示所有的列)

"connection": [

{

"jdbcUrl": [], # 連接信息

"table": [] # 連接表

}

],

"password": "", # 連接用戶

"username": "", # 連接密碼

"where": "" # 描述篩選條件

}

},

"writer": {

"name": "mysqlwriter", # 寫入端

"parameter": {

"column": [], # 需要同步的列

"connection": [

{

"jdbcUrl": "", # 連接信息

"table": [] # 連接表

}

],

"password": "", # 連接密碼

"preSql": [], # 同步前. 要做的事

"session": [],

"username": "", # 連接用戶

"writeMode": "" # 操作類型

}

}

}

],

"setting": {

"speed": {

"channel": "" # 指定并發(fā)數(shù)

}

}

}

}

2)編寫 json 文件:

[root@MySQL-1 ~]# vim install.json

{

"job": {

"content": [

{

"reader": {

"name": "mysqlreader",

"parameter": {

"username": "root",

"password": "123123",

"column": ["*"],

"splitPk": "ID",

"connection": [

{

"jdbcUrl": [

"jdbc:mysql://192.168.1.1:3306/course-study?useUnicode=true&characterEncoding=utf8"

],

"table": ["t_member"]

}

]

}

},

"writer": {

"name": "mysqlwriter",

"parameter": {

"column": ["*"],

"connection": [

{

"jdbcUrl": "jdbc:mysql://192.168.1.2:3306/course-study?useUnicode=true&characterEncoding=utf8",

"table": ["t_member"]

}

],

"password": "123123",

"preSql": [

"truncate t_member"

],

"session": [

"set session sql_mode='ANSI'"

],

"username": "root",

"writeMode": "insert"

}

}

}

],

"setting": {

"speed": {

"channel": "5"

}

}

}

}

3)驗(yàn)證

[root@MySQL-1 ~]# python /usr/local/datax/bin/datax.py install.json

輸出:

2021-12-15 16:45:15.120 [job-0] INFO JobContainer - PerfTrace not enable!

2021-12-15 16:45:15.120 [job-0] INFO StandAloneJobContainerCommunicator - Total 2999999 records, 107666651 bytes | Speed 2.57MB/s, 74999 records/s | Error 0 records, 0 bytes | All Task WaitWriterTime 82.173s | All Task WaitReaderTime 75.722s | Percentage 100.00%

2021-12-15 16:45:15.124 [job-0] INFO JobContainer -

任務(wù)啟動(dòng)時(shí)刻 : 2021-12-15 16:44:32

任務(wù)結(jié)束時(shí)刻 : 2021-12-15 16:45:15

任務(wù)總計(jì)耗時(shí) : 42s

任務(wù)平均流量 : 2.57MB/s

記錄寫入速度 : 74999rec/s

讀出記錄總數(shù) : 2999999

讀寫失敗總數(shù) : 0

你們可以在目的數(shù)據(jù)庫進(jìn)行查看,是否同步完成。

上面的方式相當(dāng)于是完全同步,但是當(dāng)數(shù)據(jù)量較大時(shí),同步的時(shí)候被中斷,是件很痛苦的事情; 所以在有些情況下,增量同步還是蠻重要的。

5.使用 DataX 進(jìn)行增量同步

使用 DataX 進(jìn)行全量同步和增量同步的唯一區(qū)別就是:增量同步需要使用 where 進(jìn)行條件篩選。(即,同步篩選后的 SQL)

1)編寫 json 文件:

[root@MySQL-1 ~]# vim where.json

{

"job": {

"content": [

{

"reader": {

"name": "mysqlreader",

"parameter": {

"username": "root",

"password": "123123",

"column": ["*"],

"splitPk": "ID",

"where": "ID <= 1888",

"connection": [

{

"jdbcUrl": [

"jdbc:mysql://192.168.1.1:3306/course-study?useUnicode=true&characterEncoding=utf8"

],

"table": ["t_member"]

}

]

}

},

"writer": {

"name": "mysqlwriter",

"parameter": {

"column": ["*"],

"connection": [

{

"jdbcUrl": "jdbc:mysql://192.168.1.2:3306/course-study?useUnicode=true&characterEncoding=utf8",

"table": ["t_member"]

}

],

"password": "123123",

"preSql": [

"truncate t_member"

],

"session": [

"set session sql_mode='ANSI'"

],

"username": "root",

"writeMode": "insert"

}

}

}

],

"setting": {

"speed": {

"channel": "5"

}

}

}

}

需要注意的部分就是:where(條件篩選) 和 preSql(同步前,要做的事) 參數(shù)。

2)驗(yàn)證:

[root@MySQL-1 ~]# python /usr/local/data/bin/data.py where.json

輸出:

2021-12-16 17:34:38.534 [job-0] INFO JobContainer - PerfTrace not enable!

2021-12-16 17:34:38.534 [job-0] INFO StandAloneJobContainerCommunicator - Total 1888 records, 49543 bytes | Speed 1.61KB/s, 62 records/s | Error 0 records, 0 bytes | All Task WaitWriterTime 0.002s | All Task WaitReaderTime 100.570s | Percentage 100.00%

2021-12-16 17:34:38.537 [job-0] INFO JobContainer -

任務(wù)啟動(dòng)時(shí)刻 : 2021-12-16 17:34:06

任務(wù)結(jié)束時(shí)刻 : 2021-12-16 17:34:38

任務(wù)總計(jì)耗時(shí) : 32s

任務(wù)平均流量 : 1.61KB/s

記錄寫入速度 : 62rec/s

讀出記錄總數(shù) : 1888

讀寫失敗總數(shù) : 0

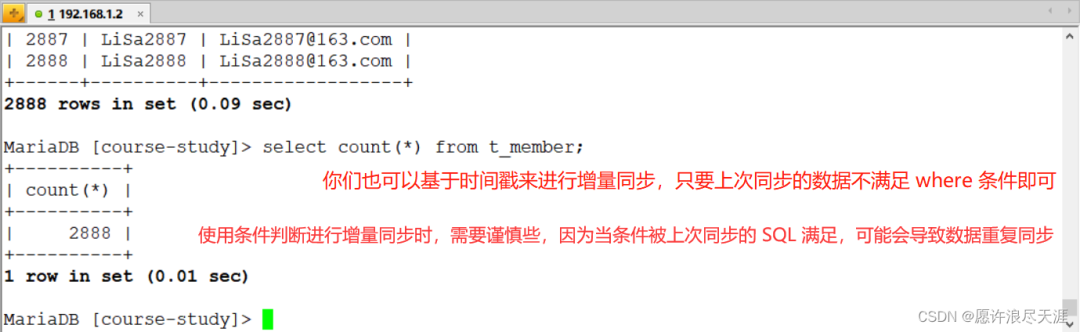

目標(biāo)數(shù)據(jù)庫上查看:

3)基于上面數(shù)據(jù),再次進(jìn)行增量同步:

主要是 where 配置:"where": "ID > 1888 AND ID <= 2888" # 通過條件篩選來進(jìn)行增量同步

同時(shí)需要將我上面的 preSql 刪除(因?yàn)槲疑厦孀龅牟僮鲿r(shí) truncate 表)

來源:https://blog.csdn.net/weixin_46902396/article/details/121904705

推薦閱讀

你好,我是程序猿DD,10年開發(fā)老司機(jī)、阿里云MVP、騰訊云TVP、出過書創(chuàng)過業(yè)、國(guó)企4年互聯(lián)網(wǎng)6年。從普通開發(fā)到架構(gòu)師、再到合伙人。一路過來,給我最深的感受就是一定要不斷學(xué)習(xí)并關(guān)注前沿。只要你能堅(jiān)持下來,多思考、少抱怨、勤動(dòng)手,就很容易實(shí)現(xiàn)彎道超車!所以,不要問我現(xiàn)在干什么是否來得及。如果你看好一個(gè)事情,一定是堅(jiān)持了才能看到希望,而不是看到希望才去堅(jiān)持。相信我,只要堅(jiān)持下來,你一定比現(xiàn)在更好!如果你還沒什么方向,可以先關(guān)注我,這里會(huì)經(jīng)常分享一些前沿資訊,幫你積累彎道超車的資本。