一文理解Ranking Loss/Margin Loss/Triplet Loss

點(diǎn)擊藍(lán)字

?關(guān)注我們

前言

ranking loss函數(shù):度量學(xué)習(xí)

ranking loss的表達(dá)式

使用一對(duì)的訓(xùn)練數(shù)據(jù)點(diǎn)(即是兩個(gè)一組) 使用三元組的訓(xùn)練數(shù)據(jù)點(diǎn)(即是三個(gè)數(shù)據(jù)點(diǎn)一組)

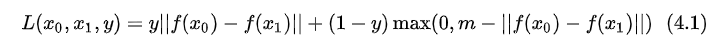

成對(duì)樣本的ranking loss

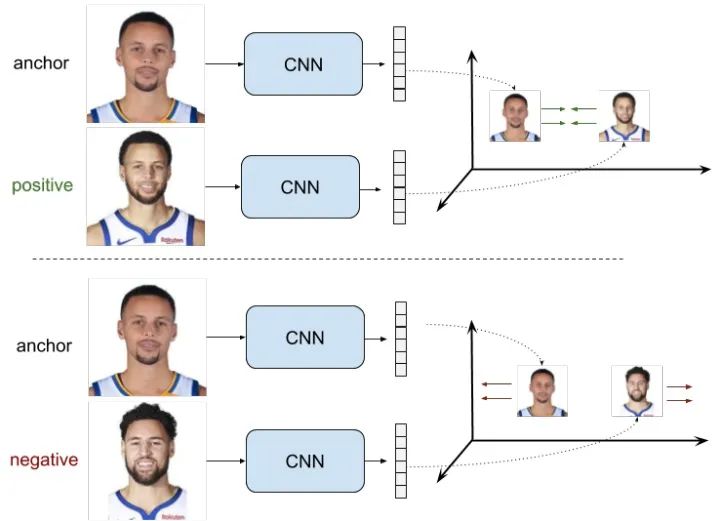

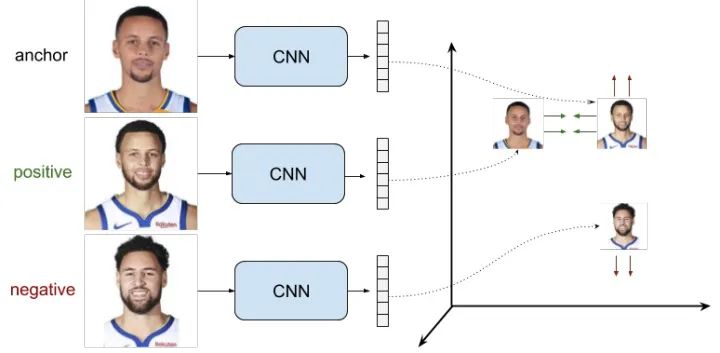

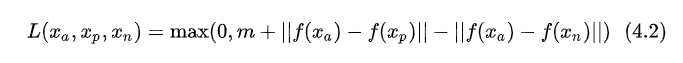

三元組樣本對(duì)的ranking loss

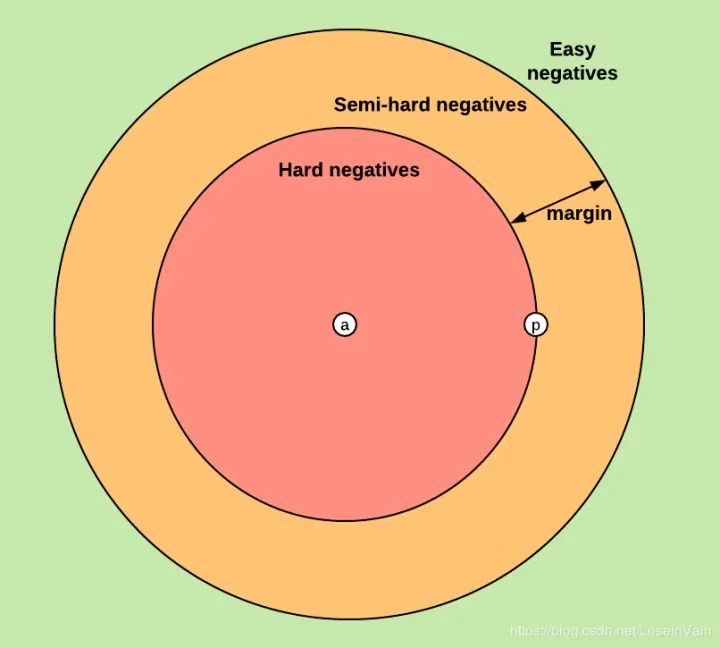

負(fù)樣本的挑選

ranking loss的別名們

Siamese 網(wǎng)絡(luò)和Triplet網(wǎng)絡(luò)

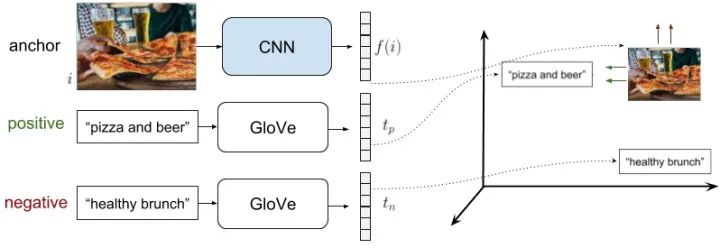

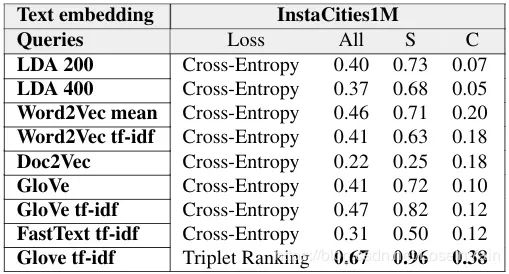

在多模態(tài)檢索中使用ranking loss

深度學(xué)習(xí)框架中的ranking loss層

Caffe

PyTorch

TensorFlow

評(píng)論

圖片

表情