OMGD:字節(jié)跳動開源的最新GAN壓縮算法

點擊上方“機(jī)器學(xué)習(xí)與生成對抗網(wǎng)絡(luò)”,關(guān)注星標(biāo)

獲取有趣、好玩的前沿干貨!

GAN是人工智能領(lǐng)域重要的深度學(xué)習(xí)模型,在圖像生成、音樂生成和視頻生成等方面應(yīng)用廣泛,還可以提高圖像質(zhì)量,實現(xiàn)圖像風(fēng)格化、圖像著色等任務(wù)。漫畫特效等人們常用的短視頻道具,就是通過GAN實現(xiàn)的。

由于GAN對計算資源和存儲空間的需求巨大,模型難以直接部署到手機(jī)、Pad等移動設(shè)備上,業(yè)界一直在努力改進(jìn)GAN的壓縮方法。2020年,麻省理工學(xué)院、Adobe和上海交通大學(xué)的研究者們提出一種GAN壓縮算法,將算力消耗成功減少到1/21。此次字節(jié)跳動提出的OMGD方法則進(jìn)一步提升了壓縮能力。

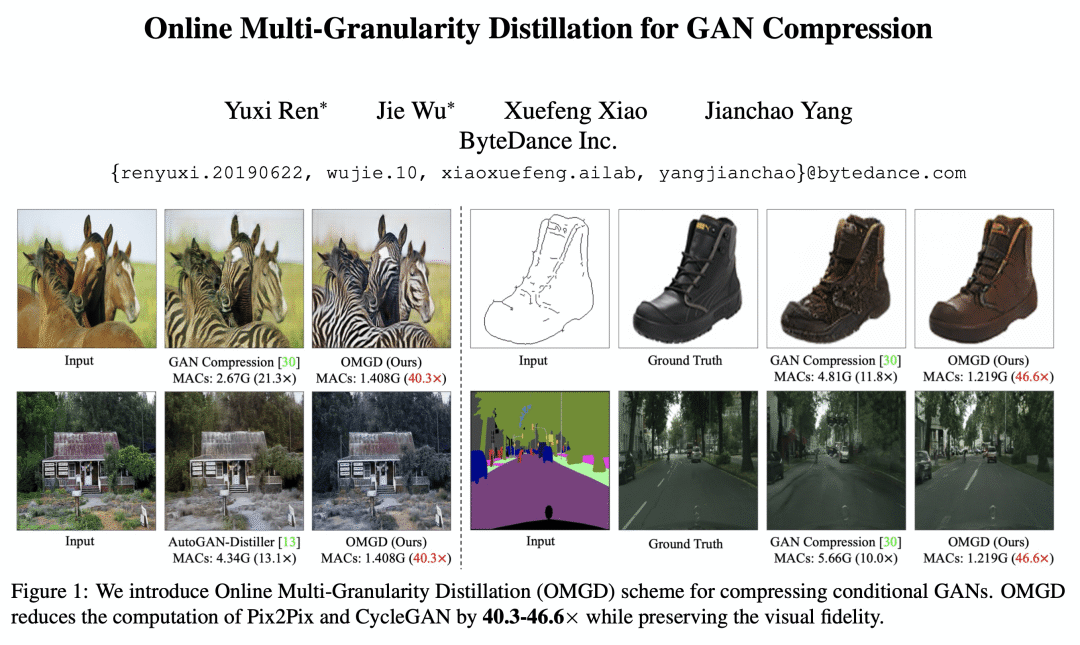

OMGD(Online Multi-Granularity Distillation)意為“在線多粒度蒸餾”。據(jù)字節(jié)跳動技術(shù)團(tuán)隊的論文顯示,該算法能靈活地在訓(xùn)練過程中優(yōu)化并壓縮GAN模型,從而實現(xiàn)更好的圖像效果和更少的計算成本。

測試數(shù)據(jù)表明,OMGD壓縮算法對Pix2Pix和CycleGAN這兩種常用的GAN解決方案效果顯著。Pix2Pix和CycleGAN主要應(yīng)用于圖像到圖像的“翻譯”,比如將照片轉(zhuǎn)換為繪畫,對黑白圖片著色等。OMGD壓縮算法可使其算力消耗分別減少到原來的1/40和1/46。

目前,OMGD壓縮算法已在抖音等產(chǎn)品中落地,為用戶提供更豐富的視頻創(chuàng)作能力。相關(guān)技術(shù)代碼也已發(fā)布在開源社區(qū),以幫助從業(yè)者提升GAN的創(chuàng)新和應(yīng)用效率。迄今,字節(jié)跳動已開源了機(jī)器學(xué)習(xí)平臺Klever、聯(lián)邦學(xué)習(xí)平臺Fedlearner、高性能分布式訓(xùn)練框架BytePS 、LightSeq推理和訓(xùn)練引擎等重磅項目。

節(jié)能環(huán)保是字節(jié)跳動一個重要的技術(shù)研究方向。在不久前的自然語言處理領(lǐng)域國際頂會ACL 2021上,字節(jié)跳動的詞表學(xué)習(xí)方案獲得年度唯一的“最佳論文”大獎,該論文同樣極具節(jié)能價值,相比主流詞表可以節(jié)約92%的算力。

OMGD論文鏈接:https://arxiv.org/abs/2108.06908

開源項目鏈接:https://github.com/bytedance/OMGD

猜您喜歡:

等你著陸!【GAN生成對抗網(wǎng)絡(luò)】知識星球!

CVPR 2021 | GAN的說話人驅(qū)動、3D人臉論文匯總

CVPR 2021 | 圖像轉(zhuǎn)換 今如何?幾篇GAN論文

CVPR 2021生成對抗網(wǎng)絡(luò)GAN部分論文匯總

最新最全20篇!基于 StyleGAN 改進(jìn)或應(yīng)用相關(guān)論文

附下載 | 經(jīng)典《Think Python》中文版

附下載 | 最新2020李沐《動手學(xué)深度學(xué)習(xí)》

附下載 | 《可解釋的機(jī)器學(xué)習(xí)》中文版

附下載 |《TensorFlow 2.0 深度學(xué)習(xí)算法實戰(zhàn)》