只有0.7M?超超超輕量SOTA目標(biāo)檢測模型揭秘!

目標(biāo)檢測作為計算機(jī)視覺領(lǐng)域的頂梁柱,不僅可以獨立完成車輛、商品、缺陷檢測等任務(wù),也是人臉識別、視頻分析、以圖搜圖等復(fù)合技術(shù)的核心模塊,在自動駕駛、工業(yè)視覺、安防交通等領(lǐng)域的商業(yè)價值有目共睹。

正因如此,YOLOv5、YOLOX、PP-YOLOE、PP-PicoDet等優(yōu)秀算法層出不窮,各有優(yōu)劣側(cè)重。而在當(dāng)前云、邊、端多場景協(xié)同的產(chǎn)業(yè)大趨勢下,運行速度、模型計算量、模型格式轉(zhuǎn)化、硬件適配、統(tǒng)一部署方案等實際問題都需要考慮,到底該怎么選呢?

今天小編就給大家推薦一個,針對云、邊、端各環(huán)境都深層優(yōu)化的超強(qiáng)目標(biāo)檢測開發(fā)套件 —?PaddleDetection。無論你追求的是高精度、輕量化,還是場景預(yù)訓(xùn)練模型,它其中的模型都能以業(yè)界最高標(biāo)準(zhǔn)滿足你的需求。同時,這些模型都擁有統(tǒng)一的使用方式及部署策略,不再需要進(jìn)行模型轉(zhuǎn)化、接口調(diào)整,更貼合工業(yè)大生產(chǎn)標(biāo)準(zhǔn)化、模塊化的需求!

還在等什么!趕緊查看全部開源代碼并Star收藏吧!!

傳送門:?https://github.com/PaddlePaddle/PaddleDetection

下面,讓我們來詳細(xì)解讀下這個開發(fā)套件中的模型,是如何達(dá)到業(yè)界最高標(biāo)準(zhǔn),又如何提供產(chǎn)業(yè)最佳實踐體驗的!

PP-YOLOE:

高精度SOTA目標(biāo)檢測模型

PP-YOLOE根據(jù)不同應(yīng)用場景設(shè)計了s/m/l/x,4個尺寸的模型來支持不同算力水平的硬件,無論是哪個尺寸,精度-速度都超越當(dāng)前所有同等計算量下的YOLO模型!

性能卓越:具體來說,PP-YOLOE-l在COCO test-dev上以精度51.4%,TRT FP16推理速度149FPS的優(yōu)異數(shù)據(jù),相較YOLOX,精度提升1.3%,加速25%;相較YOLOv5,精度提升0.7%,加速26.8%。訓(xùn)練速度較PP-YOLOv2提高33%,大幅降低模型訓(xùn)練成本。

部署友好:與此同時,PP-YOLOE在結(jié)構(gòu)設(shè)計上避免使用如deformable convolution或者matrix nms之類的特殊算子,使其能輕松適配更多硬件。當(dāng)前已經(jīng)完備支持NVIDIA V100、T4這樣的云端GPU架構(gòu)以及如Jetson系列等邊緣端GPU和FPGA開發(fā)板。

PP-YOLOE完整代碼實現(xiàn):

https://github.com/PaddlePaddle/PaddleDetection/tree/release/2.4/configs/ppyoloe

技術(shù)報告:

https://arxiv.org/abs/2203.16250

PP-PicoDet:

0.7M超超超輕量SOTA目標(biāo)檢測模型

超乎想象的超小體積及超預(yù)期的性能,使PP-PicoDet成為邊緣、低功耗硬件部署的最佳選擇。

更強(qiáng)性能:PP-PicoDet-S參數(shù)量僅有1.18M,卻有32.5%mAP的精度,不僅精度比相較YOLOX-Nano高6.7%,推理速度還提升了26%;相較比NanoDet-Plus,mAP也高出了2%,速度提升30%。最新增加的PP-PicoDet-XS更是僅有0.7M,在CPU上預(yù)測速度可達(dá)250FPS以上,在訓(xùn)練速度上也大幅提升一倍以上。

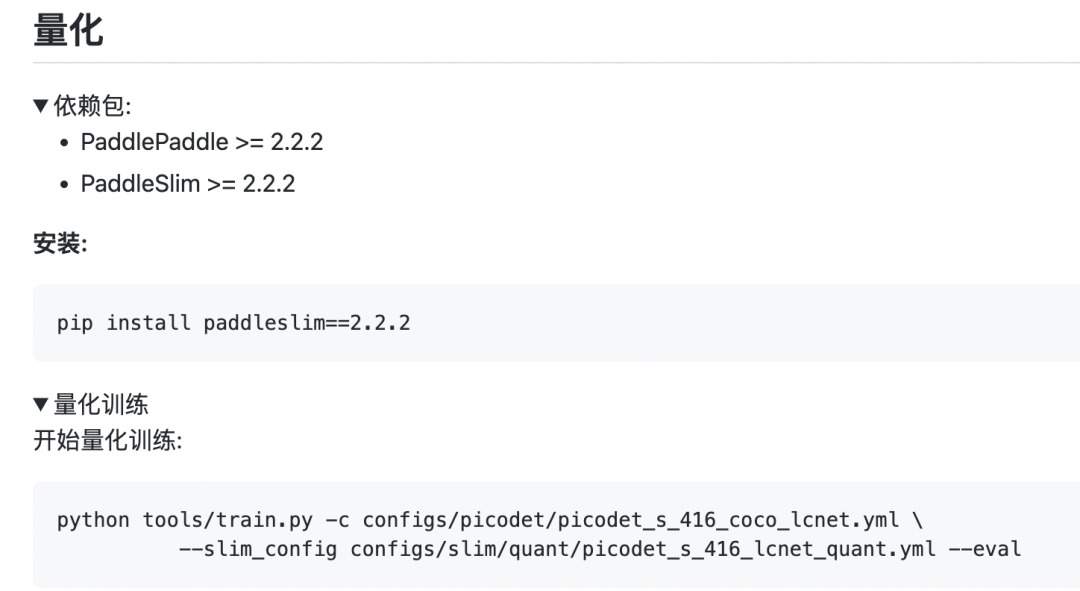

更好優(yōu)化支持:考慮到端側(cè)對計算量的優(yōu)化追求是極致的,PP-PicoDet在模型量化訓(xùn)練和稀疏化壓縮方案支持方面做了更深度的打磨,僅需兩步,即可實現(xiàn)在移動端部署加速30%以上的效果。

更友好部署:為了部署更加輕松高效, PP-PicoDet在模型導(dǎo)出環(huán)節(jié), 將模型的后處理包含在了網(wǎng)絡(luò)中,支持預(yù)測直接輸出檢測結(jié)果,無需額外開發(fā)后處理模塊,還能端到端加速10%-20%。

PP-PicoDet代碼實現(xiàn):

https://github.com/PaddlePaddle/PaddleDetection/tree/release/2.4/configs/picodet

技術(shù)報告地址:

https://arxiv.org/abs/2111.00902

更多開源社區(qū)優(yōu)秀算法

統(tǒng)一、極致的開發(fā)體驗

PaddleDetection還第一時間收錄了如YOLOv4、YOLOX及SwinTransformer等在內(nèi)的前沿優(yōu)秀算法,與Faster-RCNN、YOLOv3等經(jīng)典算法一同,為用戶提供極致簡單、統(tǒng)一的使用方式, 且得益于飛槳原生推理庫Paddle Inference及飛槳端側(cè)推理框架Paddle Lite的能力,通過支持TensorRT和OpenVino,開發(fā)者可以快速完成在服務(wù)端和邊緣端GPU或ARM CPU、NPU等硬件上的高性能加速部署。此外,PaddleDetection還支持一鍵導(dǎo)出為ONNX格式,順暢對接ONNX生態(tài)。

以上所有模型、代碼及使用文檔、Demo均在PaddleDetection中開源提供,從此無需再內(nèi)卷,通用目標(biāo)檢測,這一個項目就夠了!

趕緊??Star??收藏訂閱最新動態(tài)吧!

https://github.com/PaddlePaddle/PaddleDetection/tree/release/2.4

直播課預(yù)告

為了讓開發(fā)者們更深入的了解PaddleDetection這次的全新模型,解決落地應(yīng)用難點,掌握產(chǎn)業(yè)實踐的核心能力,飛槳團(tuán)隊精心準(zhǔn)備了精品直播課!

4月19日20:30,百度資深高工將為我們詳細(xì)介紹超強(qiáng)檢測矩陣,對各類型SOTA模型的原理及使用方式進(jìn)行拆解,之后兩天還有檢測拓展應(yīng)用梳理及產(chǎn)業(yè)案例全流程實操,對各類痛難點解決方案進(jìn)行手把手教學(xué),加上直播現(xiàn)場互動答疑,還在等什么!抓緊掃碼上車吧!

(?掃碼報名直播課,加入技術(shù)交流群)