2020年計(jì)算機(jī)視覺技術(shù)最新學(xué)習(xí)路線總結(jié) (含時(shí)間分配建議)

點(diǎn)擊上方“AI算法與圖像處理”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

本文轉(zhuǎn)載自:深度學(xué)習(xí)與計(jì)算機(jī)視覺

我們的計(jì)算機(jī)視覺學(xué)習(xí)路徑框架

目標(biāo):這個(gè)月你會學(xué)到什么?關(guān)鍵要點(diǎn)是什么?你的計(jì)算機(jī)視覺之旅將如何進(jìn)行?我們會在每個(gè)月初提及此問題,以確保你知道該月底的立場以及所處的位置 建議時(shí)間:你每周平均應(yīng)在該部分上花費(fèi)多少時(shí)間 學(xué)習(xí)資源:該月你將學(xué)習(xí)的計(jì)算機(jī)視覺主題的頂級資源集合,其中包括文章,教程,視頻,研究論文和其他類似資源

https://discuss.analyticsvidhya.com/t/heres-your-learning-path-to-master-computer-vision-in-2020/87785

2020年成為數(shù)據(jù)科學(xué)家和掌握機(jī)器學(xué)習(xí)的學(xué)習(xí)之路 https://www.analyticsvidhya.com/blog/2020/01/learning-path-data-scientist-machine-learning-2020 2020年掌握深度學(xué)習(xí)的學(xué)習(xí)道路 https://www.analyticsvidhya.com/blog/2020/01/comprehensive-learning-path-deep-learning-2020 自然語言處理(NLP)學(xué)習(xí)路徑 https://www.analyticsvidhya.com/blog/2020/01/learning-path-nlp-2020

第1個(gè)月 – 涵蓋基礎(chǔ)知識:Python與統(tǒng)計(jì)

OpenCV中文官方教程v4.1(可選):

http://woshicver.com

https://courses.analyticsvidhya.com/courses/introduction-to-data-science

https://www.khanacademy.org/math/engageny-alg-1/alg1-2

第2個(gè)月 – 使用機(jī)器學(xué)習(xí)解決圖像分類問題

機(jī)器學(xué)習(xí)基礎(chǔ) https://www.analyticsvidhya.com/blog/2015/06/machine-learning-basics/ sklearn中文官方教程0.22.1(可選): http://sklearn123.com 線性回歸 https://www.analyticsvidhya.com/blog/2017/06/a-comprehensive-guide-for-linear-ridge-and-lasso-regression/ 邏輯回歸 https://www.analyticsvidhya.com/blog/2015/10/basics-logistic-regression/ 斯坦福大學(xué)-機(jī)器學(xué)習(xí)的動(dòng)機(jī)與應(yīng)用 https://see.stanford.edu/Course/CS229/47 斯坦福大學(xué)的“過擬合”和“過擬合”的概念 https://see.stanford.edu/Course/CS229/42

從圖像中提取特征的3種技術(shù) https://www.analyticsvidhya.com/blog/2019/08/3-techniques-extract-features-from-image-data-machine-learning-python/ HOG特征 https://www.analyticsvidhya.com/blog/2019/09/feature-engineering-images-introduction-hog-feature-descriptor/ SIFT特征 https://www.analyticsvidhya.com/blog/2019/10/detailed-guide-powerful-sift-technique-image-matching-python/

使用邏輯回歸進(jìn)行圖像分類 https://www.kaggle.com/gulsahdemiryurek/image-classification-with-logistic-regression 使用Logistic回歸進(jìn)行圖像分類 https://mmlind.github.io/Using_Logistic_Regression_to_solve_MNIST/

https://datahack.analyticsvidhya.com/contest/practice-problem-identify-the-apparels/

第三個(gè)月 – ?Keras和神經(jīng)網(wǎng)絡(luò)簡介

Keras文檔 https://keras.io/ 使用Keras構(gòu)建神經(jīng)網(wǎng)絡(luò) https://www.analyticsvidhya.com/blog/2016/10/tutorial-optimizing-neural-networks-using-keras-with-image-recognition-case-study/

從零開始的神經(jīng)網(wǎng)絡(luò) https://www.analyticsvidhya.com/blog/2017/05/neural-network-from-scratch-in-python-and-r/ 斯坦福大學(xué)神經(jīng)網(wǎng)絡(luò)簡介 https://youtu.be/d14TUNcbn1k 3Blue1Brown的神經(jīng)網(wǎng)絡(luò): https://youtu.be/aircAruvnKk

https://datahack.analyticsvidhya.com/contest/practice-problem-identify-the-apparels/

第4個(gè)月 – 了解卷積神經(jīng)網(wǎng)絡(luò)(CNN),遷移學(xué)習(xí)和參加比賽

卷積神經(jīng)網(wǎng)絡(luò)(CNN)簡化 https://www.analyticsvidhya.com/blog/2017/06/architecture-of-convolutional-neural-networks-simplified-demystified 斯坦福大學(xué)的卷積神經(jīng)網(wǎng)絡(luò): https://youtu.be/bNb2fEVKeEo

掌握遷移學(xué)習(xí) https://www.analyticsvidhya.com/blog/2017/06/transfer-learning-the-art-of-fine-tuning-a-pre-trained-model 斯坦福大學(xué)實(shí)踐中的ConvNets: https://youtu.be/dUTzeP_HTZg

DataHack https://datahack.analyticsvidhya.com/contest/all Kaggle https://www.kaggle.com/competitions

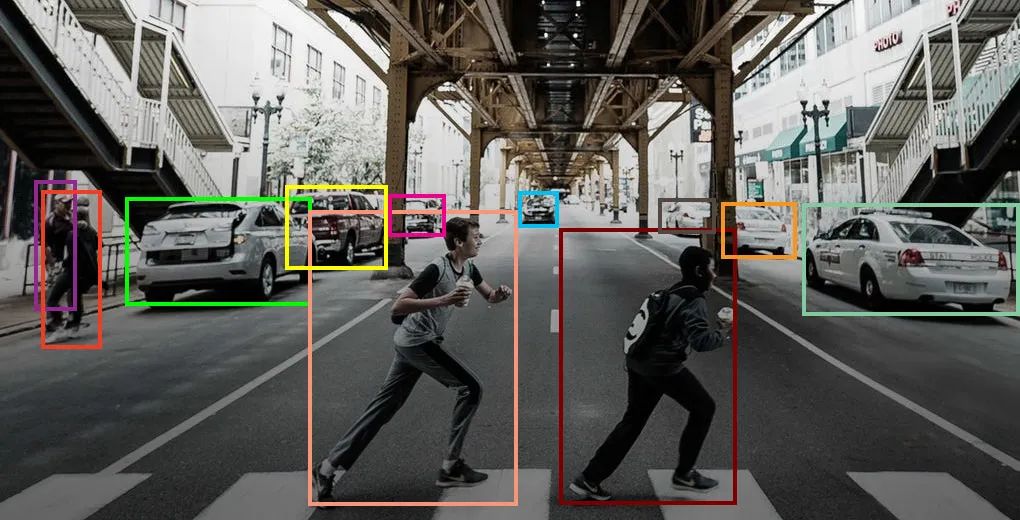

第5個(gè)月 – 解決對象檢測問題

目標(biāo)檢測技術(shù)的分步介紹 https://www.analyticsvidhya.com/blog/2018/10/a-step-by-step-introduction-to-the-basic-object-detection-algorithms-part-1 實(shí)現(xiàn)faster RCNN用于目標(biāo)檢測 https://www.analyticsvidhya.com/blog/2018/11/implementation-faster-r-cnn-python-object-detection 使用YOLO進(jìn)行物體檢測 https://www.analyticsvidhya.com/blog/2018/12/practical-guide-object-detection-yolo-framewor-python 斯坦福大學(xué)的物體檢測: https://youtu.be/nDPWywWRIRo YOLO論文 https://arxiv.org/pdf/1506.02640.pdf YOLO預(yù)訓(xùn)練模型 https://pjreddie.com/darknet/yolo/

數(shù)臉挑戰(zhàn) https://datahack.analyticsvidhya.com/contest/vista-codefest-computer-vision-1 COCO物體檢測挑戰(zhàn) http://cocodataset.org/#download

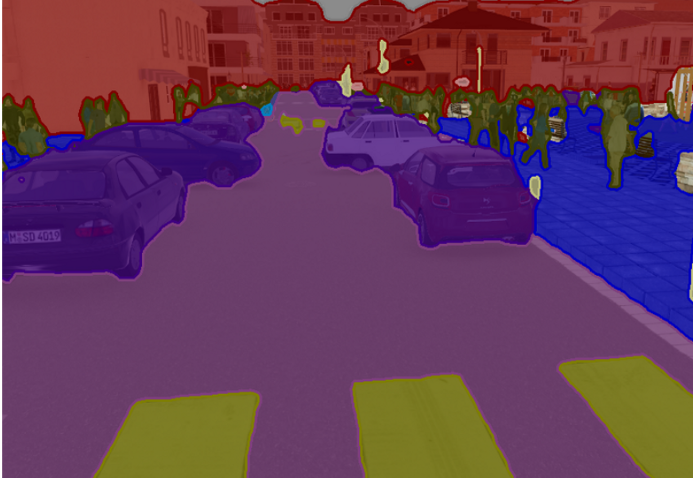

第6個(gè)月 – 了解圖像分割和注意力模型

圖像分割技術(shù)的分步介紹 https://www.analyticsvidhya.com/blog/2019/04/introduction-image-segmentation-techniques-python 實(shí)現(xiàn)Mask R-CNN進(jìn)行圖像分割 https://www.analyticsvidhya.com/blog/2019/07/computer-vision-implementing-mask-r-cnn-image-segmentation Mask R-CNN論文 https://arxiv.org/pdf/1703.06870.pdf Mask R-CNN GitHub存儲庫 https://github.com/matterport/Mask_RCNN

http://cocodataset.org/#download

Sequence-to-Sequence Modeling with Attention https://www.analyticsvidhya.com/blog/2018/03/essentials-of-deep-learning-sequence-to-sequence-modelling-with-attention-part-i Sequence-to-Sequence Models by Stanford https://nlp.stanford.edu/~johnhew/public/14-seq2seq.pdf

第7個(gè)月 – 探索深度學(xué)習(xí)工具

PyTorch教程 https://pytorch.org/tutorials/ PyTorch的初學(xué)者友好指南 https://www.analyticsvidhya.com/blog/2019/09/introduction-to-pytorch-from-scratch

PyTorch中文官方教程(可選) http://pytorch123.com

TensorFlow:

TensorFlow教程 https://www.tensorflow.org/tutorials TensorFlow簡介 https://www.analyticsvidhya.com/blog/2016/10/an-introduction-to-implementing-neural-networks-using-tensorflow

第8個(gè)月 – 了解NLP和圖像字幕的基礎(chǔ)

斯坦福-詞嵌入: https://youtu.be/ERibwqs9p38 遞歸神經(jīng)網(wǎng)絡(luò)(RNN)簡介: https://youtu.be/UNmqTiOnRfg RNN教程 http://www.wildml.com/2015/10/recurrent-neural-networks-tutorial-part-3-backpropagation-through-time-and-vanishing-gradients/

自動(dòng)圖像字幕 https://cs.stanford.edu/people/karpathy/sfmltalk.pdf 使用深度學(xué)習(xí)的圖像字幕 https://www.analyticsvidhya.com/blog/2018/04/solving-an-image-captioning-task-using-deep-learning

http://cocodataset.org/#download

第9個(gè)月 – 熟悉生成對抗網(wǎng)絡(luò)(GAN)

Ian Goodfellow的生成對抗網(wǎng)絡(luò)(GAN): https://youtu.be/HGYYEUSm-0Q GAN 論文 https://arxiv.org/pdf/1406.2661.pdf 生成對抗網(wǎng)絡(luò)的最新進(jìn)展 https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=8667290 Keras-GAN https://github.com/eriklindernoren/Keras-GAN

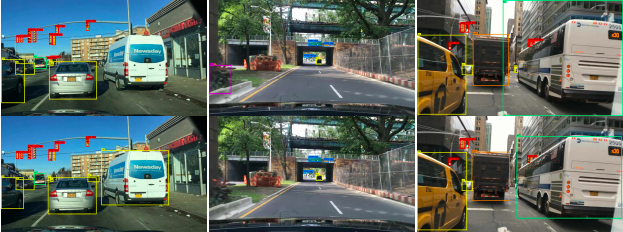

第10個(gè)月 – 視頻分析簡介

計(jì)算視頻中演員的放映時(shí)間 https://www.analyticsvidhya.com/blog/2018/09/deep-learning-video-classification-python 建立視頻分類模型 https://www.analyticsvidhya.com/blog/2019/09/step-by-step-deep-learning-tutorial-video-classification-python 通過視頻進(jìn)行人臉檢測 https://www.analyticsvidhya.com/blog/2018/12/introduction-face-detection-video-deep-learning-python

第11個(gè)月和第12個(gè)月 – 解決項(xiàng)目并參加競賽

數(shù)字識別器 https://www.kaggle.com/c/digit-recognizer ImageNet對象定位挑戰(zhàn) https://www.kaggle.com/c/imagenet-object-localization-challenge 年齡檢測 https://datahack.analyticsvidhya.com/contest/practice-problem-age-detection 空中仙人掌鑒定 https://www.kaggle.com/c/aerial-cactus-identification 超聲神經(jīng)分割 https://www.kaggle.com/c/ultrasound-nerve-segmentation 對抗性攻擊防御 https://www.kaggle.com/c/nips-2017-defense-against-adversarial-attack/overview

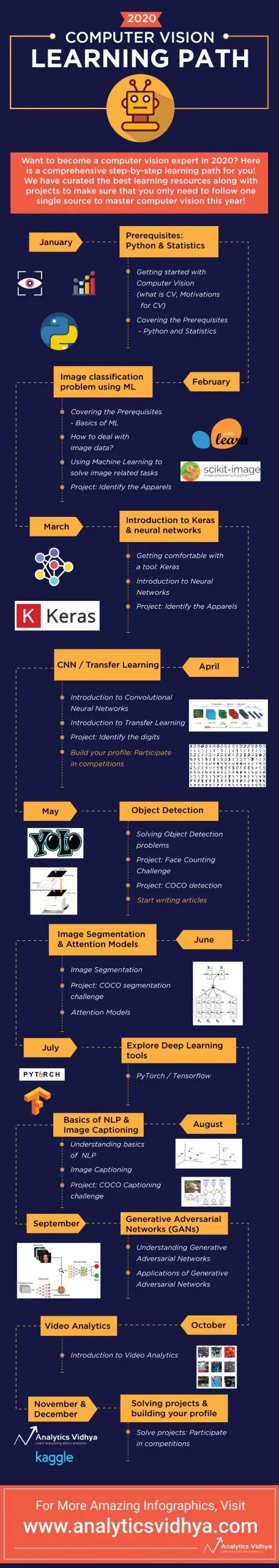

信息圖– 2020年計(jì)算機(jī)視覺學(xué)習(xí)之路

下載1:動(dòng)手學(xué)深度學(xué)習(xí)

在「AI算法與圖像處理」公眾號后臺回復(fù):動(dòng)手學(xué)深度學(xué)習(xí),即可下載547頁《動(dòng)手學(xué)深度學(xué)習(xí)》電子書和源碼。該書是面向中文讀者的能運(yùn)行、可討論的深度學(xué)習(xí)教科書,它將文字、公式、圖像、代碼和運(yùn)行結(jié)果結(jié)合在一起。本書將全面介紹深度學(xué)習(xí)從模型構(gòu)造到模型訓(xùn)練,以及它們在計(jì)算機(jī)視覺和自然語言處理中的應(yīng)用。

個(gè)人微信(如果沒有備注不拉群!) 請注明:地區(qū)+學(xué)校/企業(yè)+研究方向+昵稱

評論

圖片

表情