新視角:用圖像分類來建模文字識別也可以SOTA

共 942字,需瀏覽 2分鐘

·

2022-02-09 17:36

我們最近做了一個文字識別的工作:CSTR: A Classification Perspective on Scene Text Recognition,簡單介紹如下。

當前文字識別有兩種建模視角:seq2seq-based和segmentation-based。

seq2seq-based的方法首先將圖片encode為特征序列(比如CNN、RNN、Transformer encoder或者它們的組合),然后對特征序列進行decode(比如CTC、RNN、attention based RNN、Transformer decoder等)。

segmentation-based的方法首先定位出字符的位置,然后識別出各個位置的字符,最后將字符組合成字符串。

過去達到SOTA的文字識別方法大部分是seq2seq-based,但是seq2seq-based的方法pipeline復雜(大部分還需要STN模塊來對圖像進行矯正)。

segmentation-based的方法簡潔很多,但是需要字符級別的標注,字符級別的標注成本高昂,在實際生產(chǎn)環(huán)境中不太可能使用這樣精細的標注方式。

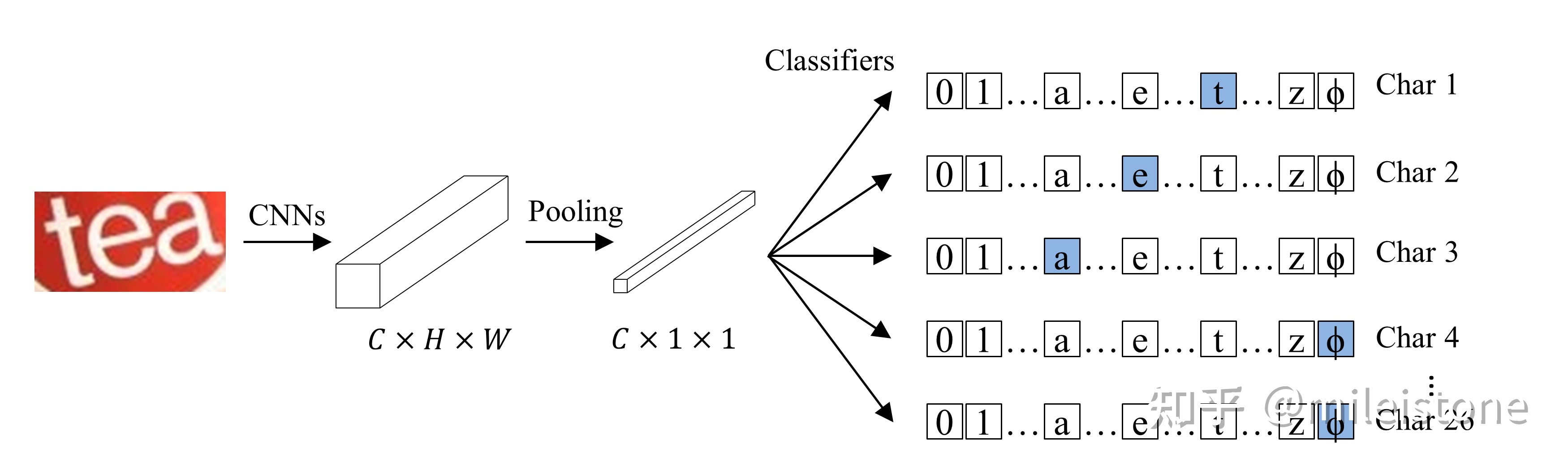

我們提出了一種圖像分類的建模視角:classification-based。即將文字識別任務(wù)建模為圖像分類,整體pipeline比segmentation-based的方法更簡單,而且不需要字符級別的標注。classification-based的模型像其他圖像分類模型一樣容易實現(xiàn),因為是純卷積所以訓練、推理非常高效。

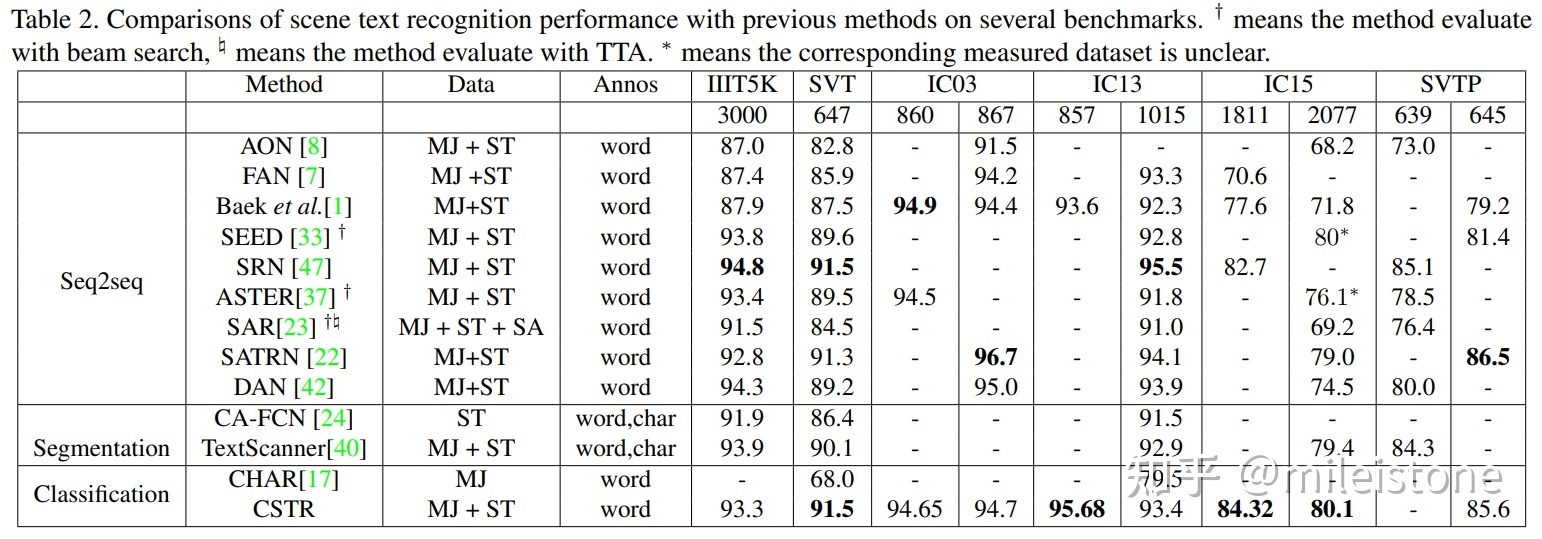

我們的classification-based模型即CSTR,在六個常用的公開數(shù)據(jù)集上的效果如下表所示。我們的模型沒有STN模塊,僅僅只有一個圖像分類器,訓練數(shù)據(jù)集為常用的兩個合成的數(shù)據(jù)集SynthText (ST)和MJSynth (MJ),僅使用單詞級別的標注,測試的時候沒用任何TTA,整體效果基本達到SOTA。

代碼將在我們的文字識別工具箱vedastr中開源。

CSTR: A Classification Perspective on Scene Text RecognitionMedia-Smart/vedastr