崩潰的一天,西安一碼通崩潰背后的技術(shù)問題

導讀:希望這次能夠吸取教訓,避免再次出現(xiàn)類似的問題!

作者 / 來源:純潔的微笑(ID:keeppuresmile)

為了減輕系統(tǒng)壓力,建議廣大市民非必要不展碼、亮碼,在出現(xiàn)系統(tǒng)卡頓時,請耐心等待,盡量避免反復刷新,也感謝廣大市民朋友們的理解配合。

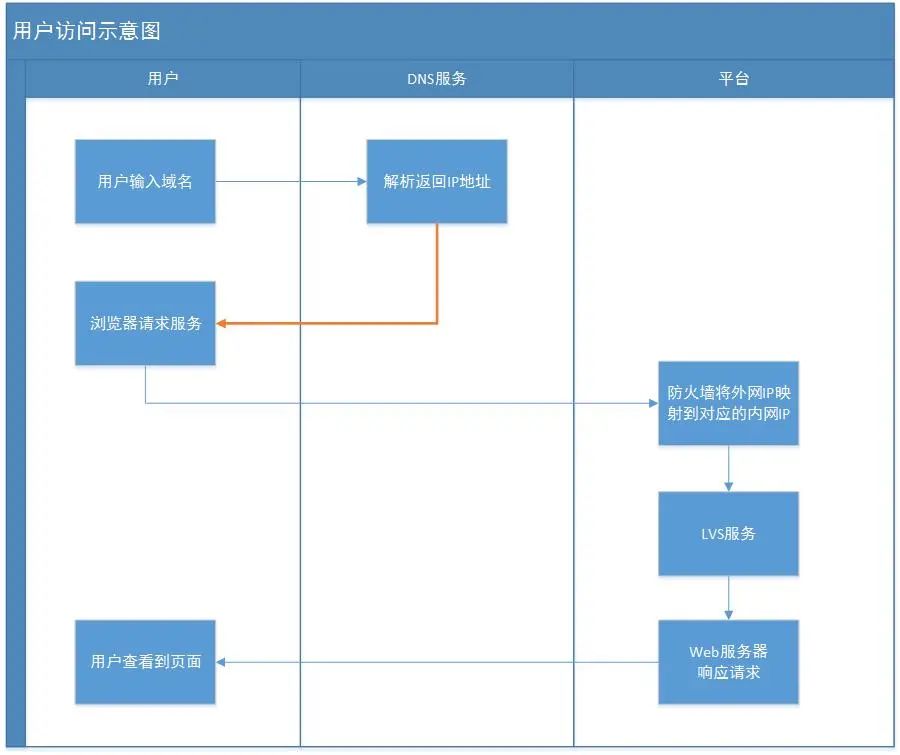

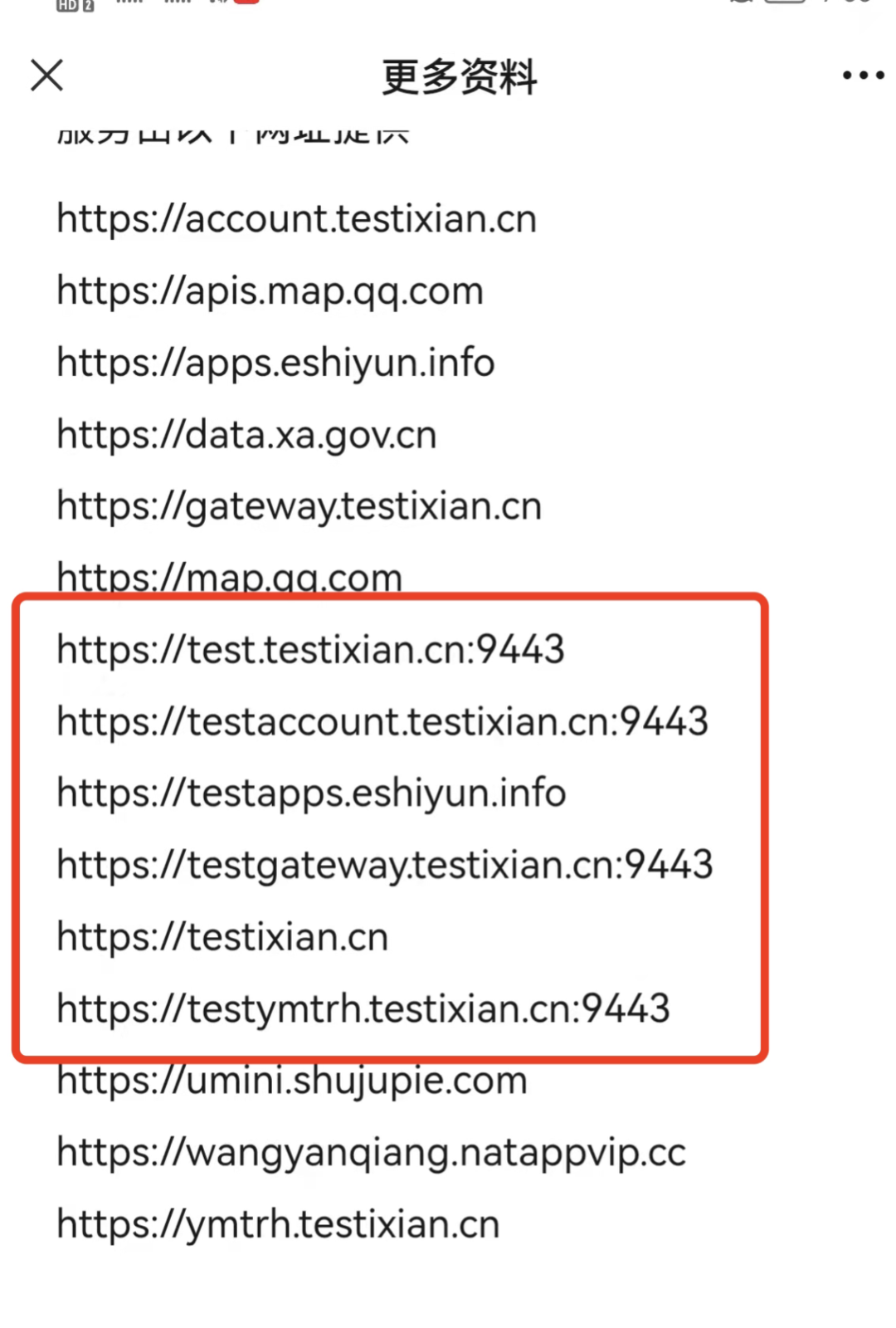

12月20日早7:40分左右,西安“一碼通”用戶訪問量激增,每秒訪問量達到以往峰值的10倍以上,造成網(wǎng)絡(luò)擁塞,致使包括“一碼通”在內(nèi)的部分應(yīng)用系統(tǒng)無法正常使用。“ 一碼通”后臺監(jiān)控第一時間報警,各24小時駐場通信、網(wǎng)絡(luò)、政務(wù)云、安全和運維團隊立即開展排查,平臺應(yīng)用系統(tǒng)和數(shù)據(jù)庫運行正常,判斷問題出現(xiàn)在網(wǎng)絡(luò)接口側(cè)。

干貨直達??

評論

圖片

表情