用MEG重構(gòu)人類大腦成像過程,Meta發(fā)布重磅研究!

專注AIGC領(lǐng)域的專業(yè)社區(qū),關(guān)注OpenAI、百度文心一言等大語言模型(LLM)的發(fā)展和應(yīng)用落地,關(guān)注LLM的基準(zhǔn)評(píng)測和市場研究,歡迎關(guān)注!

全球社交、科技巨頭Meta(Facebook、Instagram等母公司)在官網(wǎng)公布了一項(xiàng)重磅研究,通過MEG(腦磁圖)開發(fā)了一種AI模型用于解碼人類大腦中視覺活動(dòng)的成像過程,并公布了論文。

據(jù)悉,這是一種每秒可進(jìn)行數(shù)千次大腦活動(dòng)偵測的,非侵入式神經(jīng)成像技術(shù),可實(shí)時(shí)重構(gòu)出大腦在每一刻感知和處理的圖像。可為科學(xué)界理解大腦如何表達(dá)、形成圖像,提供了重要研究基礎(chǔ)。

從應(yīng)用場景來看,該技術(shù)能更好地理解、控制ChatGPT、Stable Difusion等AI模型的神經(jīng)網(wǎng)絡(luò)行動(dòng)、神經(jīng)元,提升內(nèi)容輸出準(zhǔn)確率降低風(fēng)險(xiǎn),向AGI(通用人工智能)演變奠定了基石。

放眼更大的目標(biāo),將加速“腦機(jī)接口”在臨床方面的研發(fā)進(jìn)程,幫助那些遭受腦損傷失去說話能力的人。

論文地址:https://ai.meta.com/static-resource/image-decoding

技術(shù)原理

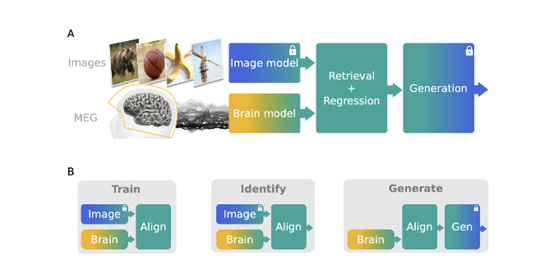

從Meta發(fā)布的論文來看,Meta通過MEG開發(fā)的AI模型原理并不復(fù)雜,主要包含圖像編輯、大腦、圖像解碼三大模塊。

當(dāng)我們的大腦進(jìn)行活動(dòng)時(shí),會(huì)產(chǎn)生微弱的電流。根據(jù)物理定律,這些電流會(huì)引起周圍磁場的變化。利用MEG高度敏感的儀器檢測這些磁場變化,從而獲得腦部活動(dòng)的數(shù)據(jù)。

具體來說,MEG使用特殊的超導(dǎo)扼流計(jì)作為探測器。這些扼流計(jì)由超導(dǎo)環(huán)路組成,可以精確地捕捉到磁場的微小波動(dòng)。

探測器的位置經(jīng)過精心設(shè)計(jì),覆蓋頭部周圍,測試者只需要坐在MEG儀器中保持頭部靜止即可。

MEG重構(gòu)實(shí)驗(yàn)者大腦成像,每個(gè)圖像大約每1.5秒呈現(xiàn)一次。

雖然大腦電流活動(dòng)引起的磁場強(qiáng)度非常微小,但MEG的探測器經(jīng)過放大和處理就可以清晰地記錄下來。

MEG包含200-300個(gè)探測器,每個(gè)探測器的位置都對(duì)應(yīng)大腦的特定區(qū)域。這樣,MEG可以獲得高時(shí)間分辨率的全頭腦活動(dòng)數(shù)據(jù)。

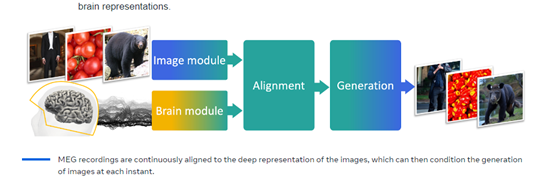

一旦獲得原始的MEG數(shù)據(jù),研究人員就可以利用強(qiáng)大的神經(jīng)網(wǎng)絡(luò)對(duì)其進(jìn)行解碼,提取重要的視覺信息,用于重構(gòu)大腦圖像。

Meta表示,最初想使用功能磁共振成像(fMRI)來搜集人類大腦的電流信息,但在圖像分辨率、圖像間隔以及連續(xù)性方面都不如MEG。

圖像編輯模塊

該模塊基于多個(gè)預(yù)訓(xùn)練的計(jì)算機(jī)視覺模型,從輸入圖像中提取語義特征向量,作為解碼的目標(biāo)表示。研究人員比較了監(jiān)督學(xué)習(xí)模型、圖像-文本匹配模型、自監(jiān)督模型等,發(fā)現(xiàn)CLIP和DINO的表現(xiàn)最佳。

CLIP(Contrastive Language-Image Pretraining)通過圖像-文本匹配進(jìn)行預(yù)訓(xùn)練,獲得泛化能力強(qiáng)的視覺語義特征。DINO(Distributional Invariance for Normalization)是一種自監(jiān)督對(duì)比學(xué)習(xí)方法。

以CLIP為例,可以提取圖像模塊(CLIP-Vision)的平均特征或分類標(biāo)記(CLS)特征,文本模塊(CLIP-Text)的平均特征,并拼接組合作為圖像的語義特征表示。

大腦模塊

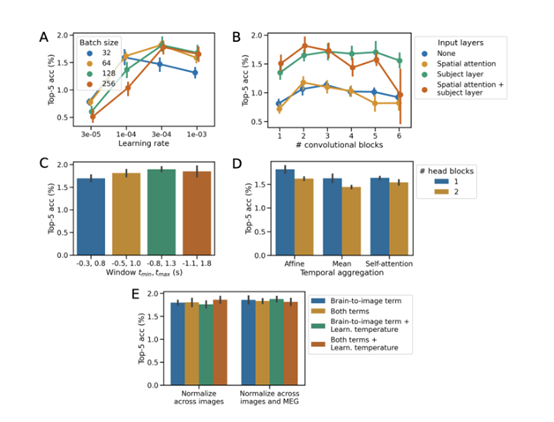

該模塊使用卷積神經(jīng)網(wǎng)絡(luò),用于輸入MEG數(shù)據(jù)窗口,輸出是預(yù)測的圖像特征向量。需要端到端訓(xùn)練,學(xué)習(xí)將MEG的數(shù)據(jù)映射到圖像輸出的latent space。

研究人員使用了卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),包含殘差塊和膨脹卷積塊,可以捕捉MEG時(shí)序信息。同時(shí)添加注意力層、主體專屬層等機(jī)制。

為了進(jìn)行圖像檢索,大腦模塊以CLIP損失函數(shù)為目標(biāo),學(xué)習(xí)最大化匹配圖像的特征相似度。為進(jìn)行圖像生成,大腦模塊以MSE損失為目標(biāo),直接預(yù)測圖像模塊的特征。

圖像解碼模塊

為了更好地解碼圖像,研究人員使用了latent diffusion擴(kuò)散模型,將大腦模塊預(yù)測的特征向量作為條件,可以生成與輸入圖像語義一致的新圖像。

將大腦模塊輸出的CLIP語義特征和AutoKL特征作為條件,指導(dǎo)模型生成語義一致的圖像。利用DDIM采樣算法,以及噪聲引導(dǎo)等技巧,逐步從噪聲分布生成清晰的圖像。一般采用50步采樣過程。

最后,使用感知指標(biāo)(SSIM)和語義指標(biāo)(CLIP相似度、SwAV特征相關(guān)度),評(píng)估圖像的解碼、生成質(zhì)量。

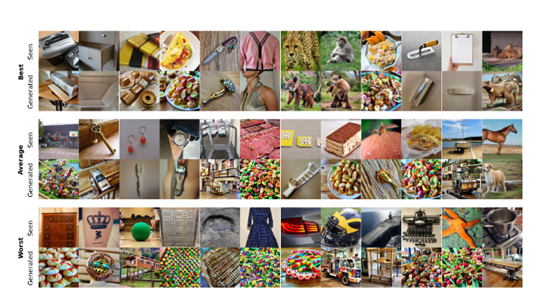

實(shí)驗(yàn)測試方面,研究人員使用包含4名參與者的MEG數(shù)據(jù)集THINGS-MEG,該數(shù)據(jù)集包含22,448張唯一的自然圖像。

通過MEG的測試,研究人員發(fā)現(xiàn)大腦對(duì)圖像的反應(yīng),主要集中在刺激出現(xiàn)后0-250ms的時(shí)間段,生成的圖像能夠保留語義信息。雖然生成的圖像不是很完美,但結(jié)果表明重構(gòu)的圖像保留了豐富的高級(jí)特征。

本文素材來源Meta官網(wǎng)、論文,如有侵權(quán)請聯(lián)系刪除

END