深入剖析:為什么MobileNet及其變體(如ShuffleNet)會變快?

極市導讀

?從MobileNet等CNN模型的組成部分出發(fā),本文剖析了它們如此高效的原因,并給出了大量清晰的原理圖。

Introduction

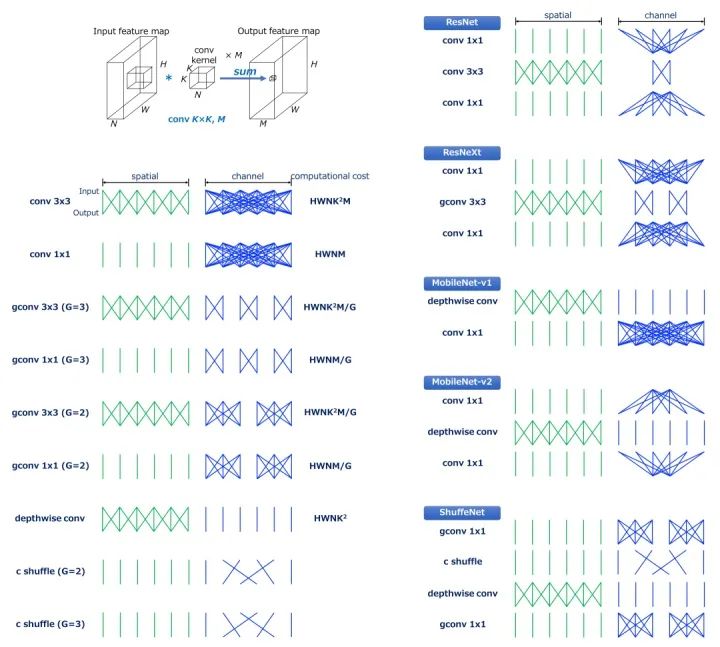

在高效的模型中使用的組成部分

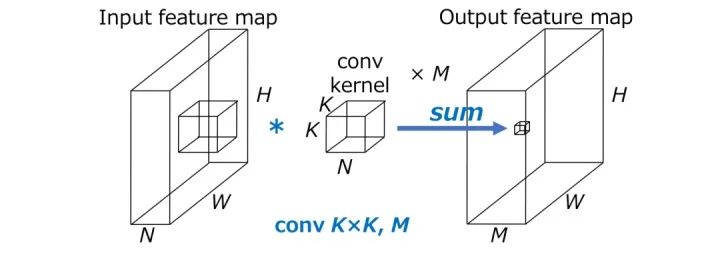

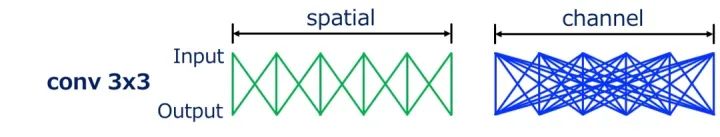

卷積

分組卷積(Grouped Convolution)

深度可分離卷積(Depthwise Convolution)

Channel Shuffle

Efficient Models

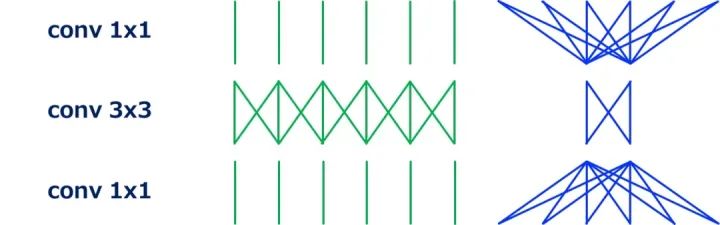

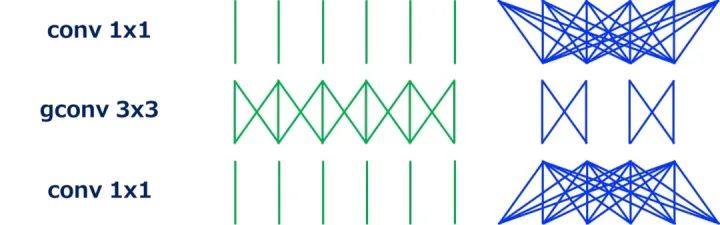

ResNet (Bottleneck Version)

ResNeXt

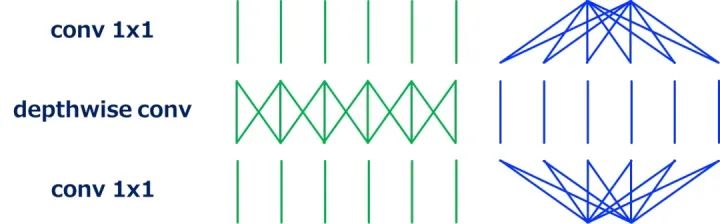

MobileNet (Separable Conv)

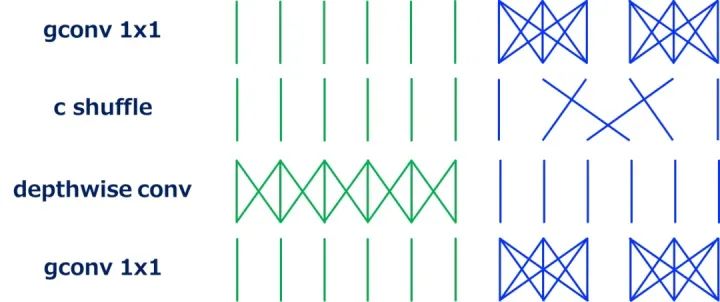

ShuffleNet

MobileNet-v2

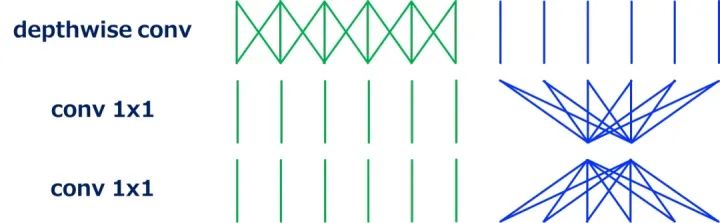

FD-MobileNet

參考資料

推薦閱讀

評論

圖片

表情