支持向量機(jī)背后的數(shù)學(xué)原理!

譯者:鄭沛,英國曼徹斯特大? 來源:數(shù)據(jù)派THU

支持向量機(jī)(SVM)介紹

支持向量機(jī)(SVM)是怎么工作的

處理異常值

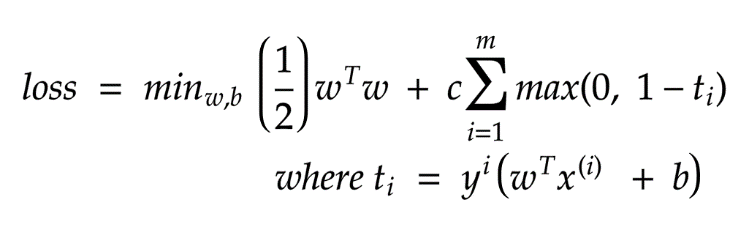

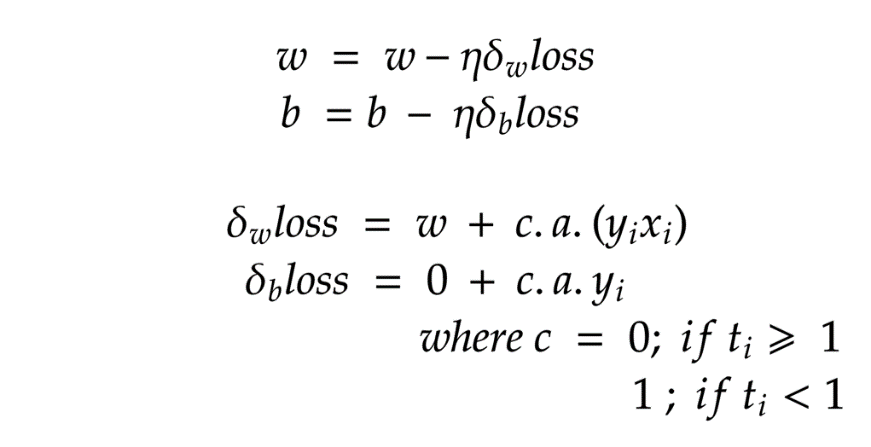

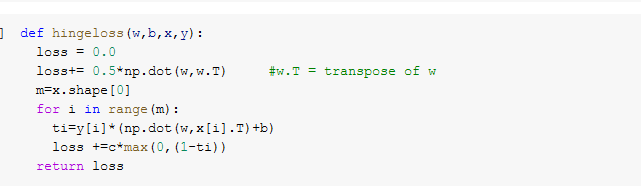

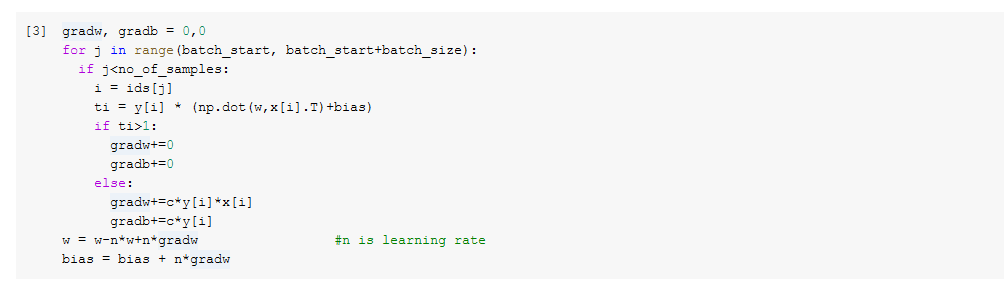

PEGASOS法

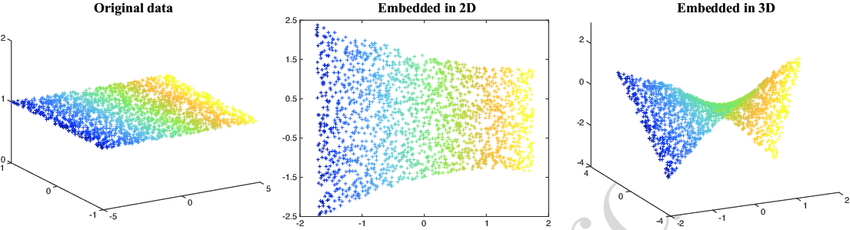

非線性回歸分類

支持向量機(jī)(SVM)的優(yōu)劣

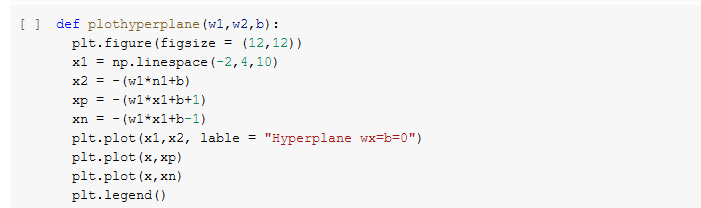

可視化支持向量機(jī)(SVM)

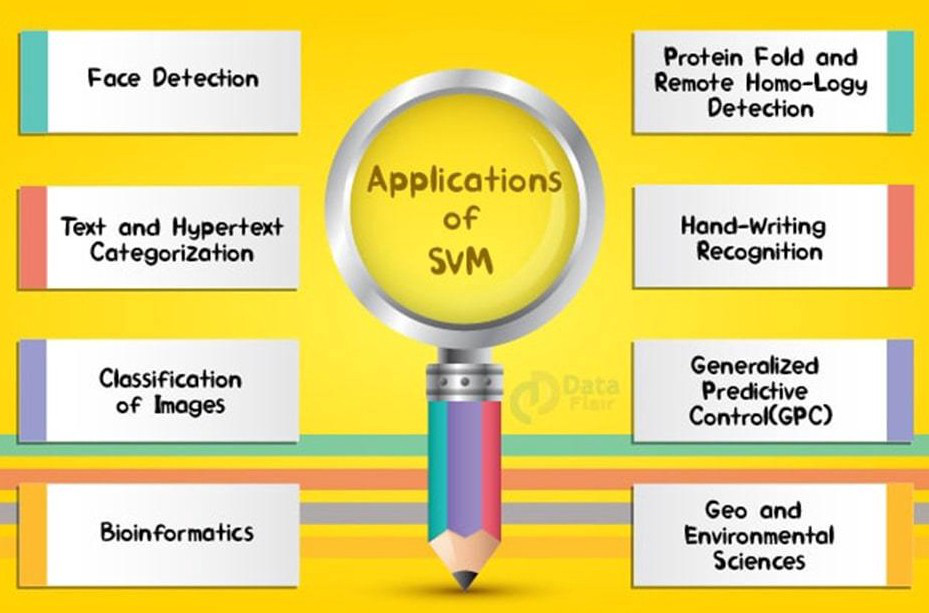

支持向量機(jī)(SVM)的應(yīng)用

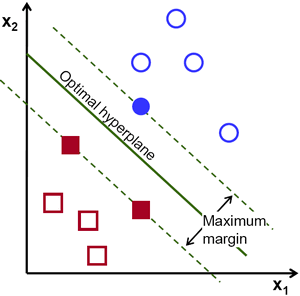

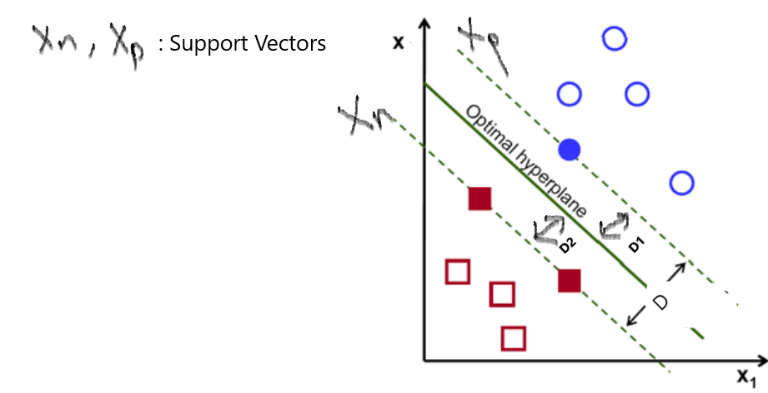

(上圖注釋:最優(yōu)超平面:Optimal hyperpline;最大間隔:Maximum margin)

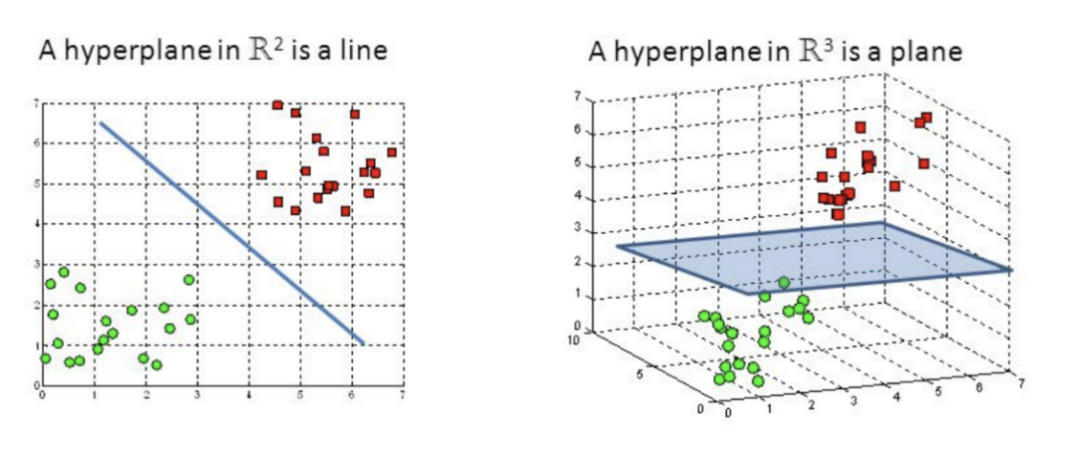

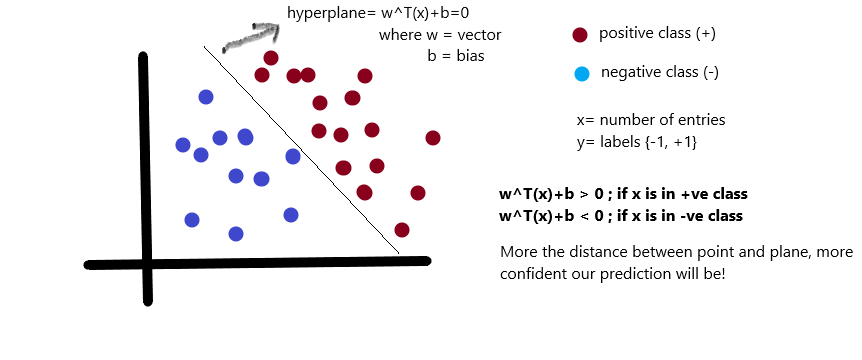

目標(biāo):找到最佳的超平面

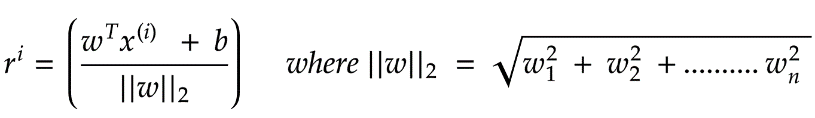

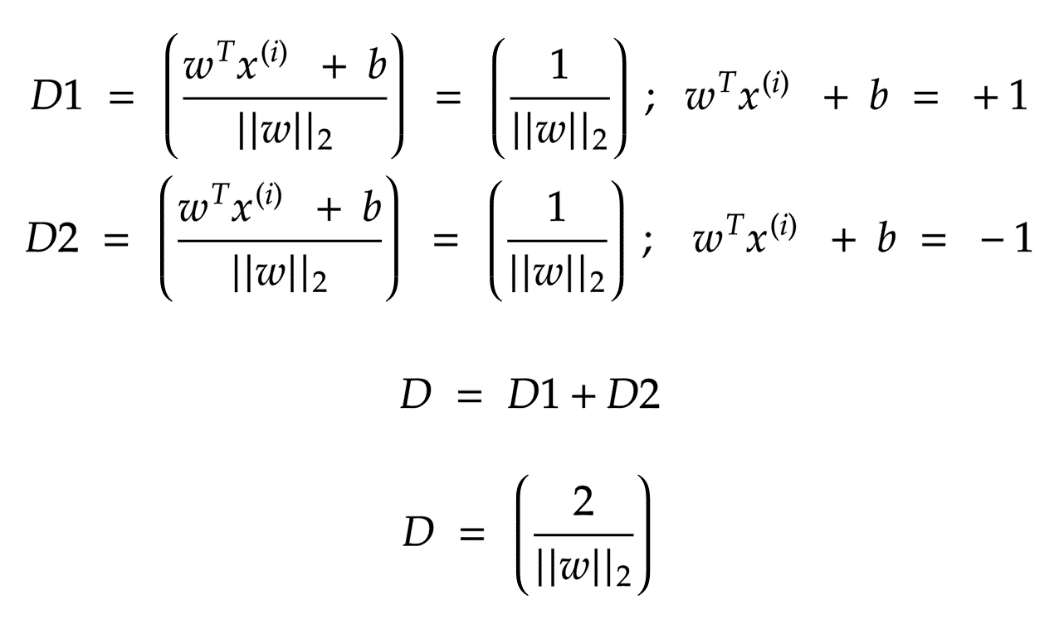

是正的,反之是負(fù)的。由于我們需要找到所謂的“最近距離”的支持向量,那么肯定點(diǎn)越多越好了,因?yàn)檫@樣提供距離的點(diǎn)越多,就越準(zhǔn)確)

是正的,反之是負(fù)的。由于我們需要找到所謂的“最近距離”的支持向量,那么肯定點(diǎn)越多越好了,因?yàn)檫@樣提供距離的點(diǎn)越多,就越準(zhǔn)確)

,

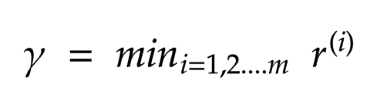

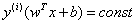

, 為函數(shù)間隔,結(jié)合兩者同號我們可以寫成

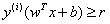

為函數(shù)間隔,結(jié)合兩者同號我們可以寫成 形式,最大化距離則意味著

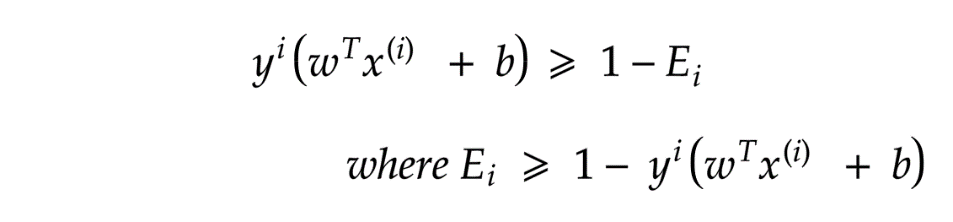

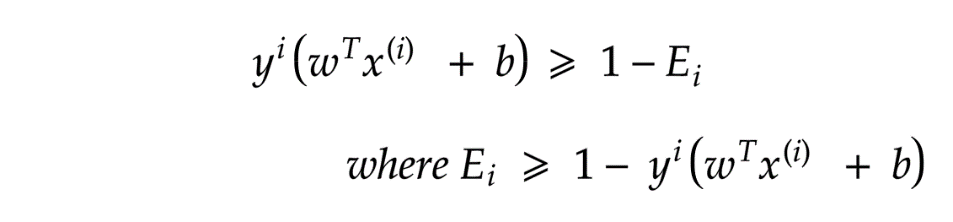

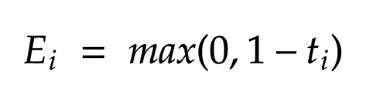

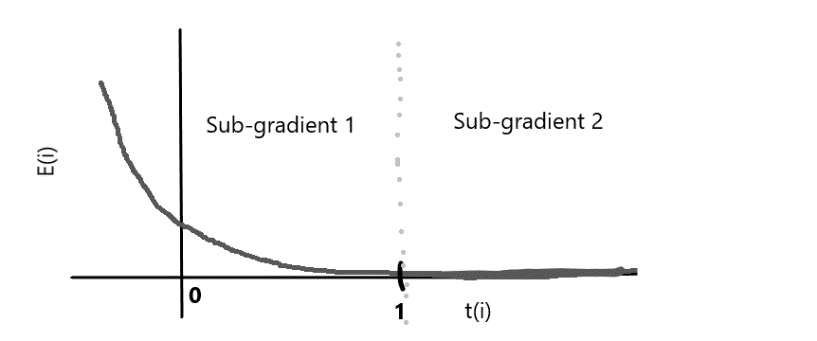

形式,最大化距離則意味著 ,因?yàn)槲覀兊哪繕?biāo)也是最大化r)。因此,我們將以支持向量必須位于超平面上的方式對數(shù)據(jù)重新正則化。

,因?yàn)槲覀兊哪繕?biāo)也是最大化r)。因此,我們將以支持向量必須位于超平面上的方式對數(shù)據(jù)重新正則化。

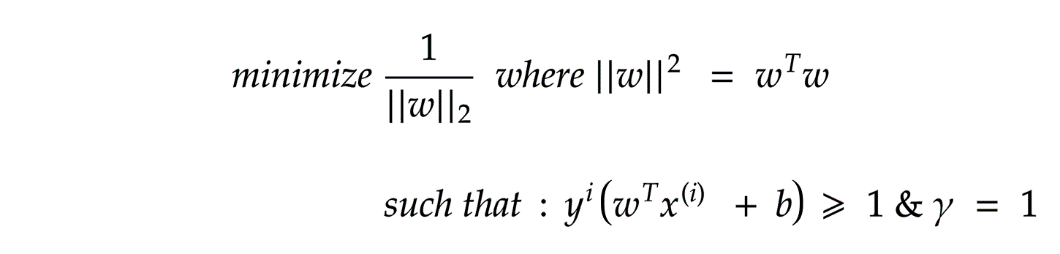

)的情況下減少“ || w ||”。

)的情況下減少“ || w ||”。

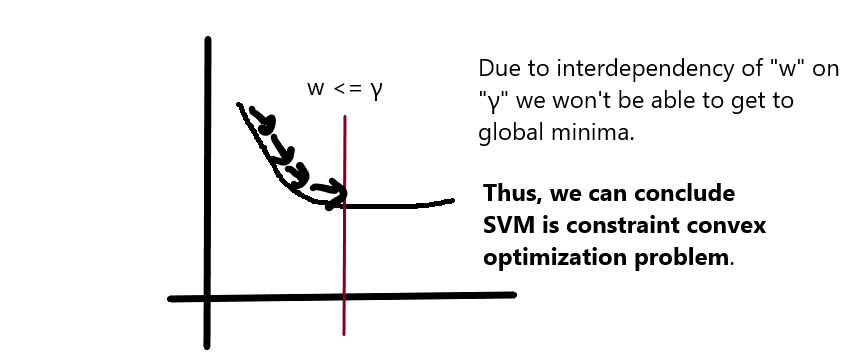

二次方程求解器

拉格朗日量密度

PEGASOS算法

線性核

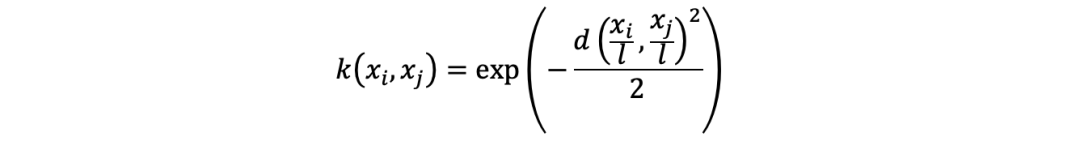

RBF(徑向基)核

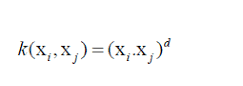

多項(xiàng)式核

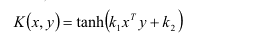

Sigmoid核

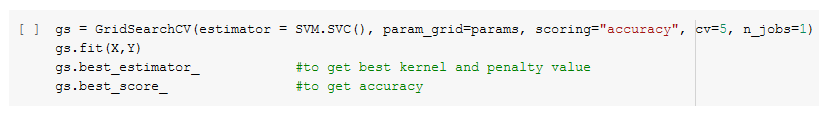

params= [{‘kernel’:[‘linear’, ‘rbf’, ‘poly’, ‘sigmoid’], ‘c’:[0.1, 0.2, 0.5, 1.0, 2.0, 5.0]}

cv: 交叉驗(yàn)證(cross-validation)

n_jobs: 可用的CPU數(shù)量

可以輕松處理大型特征空間

核技巧是支持向量機(jī)的真正優(yōu)勢,因?yàn)樗兄谡业缴踔粮鼜?fù)雜問題的解決方案

適用于線性和非線性數(shù)據(jù)

不容易出現(xiàn)過擬合的現(xiàn)象

甚至適用于非結(jié)構(gòu)化數(shù)據(jù)

對噪音敏感

選擇最佳核比較困難

大型數(shù)據(jù)集的訓(xùn)練時(shí)間長

支持向量機(jī)的應(yīng)用

“干貨學(xué)習(xí),點(diǎn)贊三連↓

評論

圖片

表情