詳細解讀 | CVPR 2021輕量化目標檢測模型MobileDets(附論文下載)

1簡介

構建在深度卷積上的Inverted bottleneck layers已經(jīng)成為移動設備上最先進目標檢測模型的主要構建模塊。在這項工作中,作者通過回顧常規(guī)卷積的實用性,研究了這種設計模式在廣泛的移動加速器上的最優(yōu)性。

作者研究發(fā)現(xiàn),正則卷積是一個強有力的組件,以提高延遲-準確性權衡目標檢測的加速器,只要他們被放置在網(wǎng)絡通過神經(jīng)結構搜索。通過在搜索空間中合并Regular CNN并直接優(yōu)化目標檢測的網(wǎng)絡架構,作者獲得了一系列目標檢測模型,MobileDets,并在移動加速器中實現(xiàn)了最先進的結果。

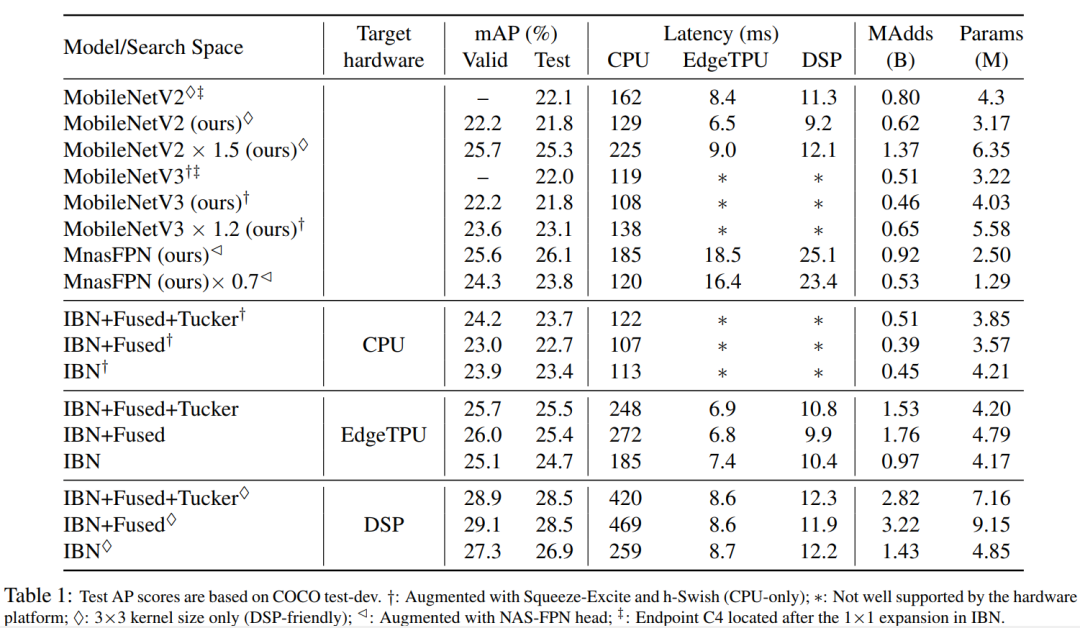

在COCO檢測任務上,在移動CPU上MobileDets比MobileNetV3+SSDLite提升了1.7 mAP。MobileDets比MobileNetV2+SSDLite提升了1.9mAP,

在不增加延遲的情況下,在谷歌EdgeTPU上提升了3.7 mAP,在Qualcomm Hexagon DSP上提升了3.4 mAP,在Nvidia Jetson GPU上提升了2.7 mAP。此外,MobileDets即使不使用金字塔也可以在移動cpu上媲美最先進的MnasFPN,并在EdgeTPUs和dsp上實現(xiàn)更好的mAP分數(shù)以及高達2倍的加速。

本文主要貢獻

-

不像許多現(xiàn)有的專門針對移動應用的IBN層的工作,本文提出了一種基于正則卷積構建塊的增強搜索空間系列。證明了NAS方法可以從這種擴大的搜索空間中獲得很大的收益,從而在各種移動設備上實現(xiàn)更好的延遲-準確性權衡。

-

提供了MobileDets,一組在多個硬件平臺(包括手機)上具有最先進的Mobile目標檢測模型。

2前人工作

2.1 Mobile Object Detection

物體檢測是一個經(jīng)典的計算機視覺任務,其目標是學習識別圖像中感興趣的物體。現(xiàn)有的目標檢測器可分為2類:

-

Two-Stage檢測器 -

One-Stage檢測器

對于Two-Stage檢測器,包括Faster RCNN, R-FCN和ThunderNet,在檢測器做出任何后續(xù)預測之前,必須首先生成區(qū)域建議。由于這種多階段的特性,Two-Stage檢測器在推理時間方面并不高效。

另一方面,One-Stage檢測器,如SSD、SSDLite、YOLO、SqueezeDet和Pelee,只需要通過一次網(wǎng)絡就可以預測所有的邊界框,使其成為邊緣設備高效推斷的理想候選。因此,在這項工作中將重點放在One-Stage檢測器上。

SSDLite是SSD的一個有效變體,它已經(jīng)成為最流行的輕量級檢測器之一。它非常適合移動設備上的應用。高效的backbone,如MobileNetV2、MobileNetV3,與SSDLite配對,以實現(xiàn)最先進的移動檢測結果。這兩個模型將被用作baseline,以證明所提出的搜索空間在不同移動加速器上的有效性。

2.2 Mobile Neural Architecture Search (NAS)

NetAdapt和AMC是第一批嘗試利用延遲感知搜索來微調預訓練模型的通道數(shù)量的公司。MnasNet和MobileNetV3擴展了這一想法,以便在NAS框架中找到資源效率高的架構。通過技術的組合,MobileNetV3在移動CPU上提供了最先進的架構。作為一個互補的方向,最近有許多致力于提高NAS的搜索效率的工作。

2.3 NAS for Mobile Object Detection

大部分NAS文獻主要集中于分類,只將學習到的特征提取器作為目標檢測的backbone,而沒有進一步的搜索。最近,多篇論文表明,通過直接搜索目標檢測模型可以獲得更好的延遲-精度權衡。

MnasFPN是移動檢測模型的一個強大的檢測NAS Baseline,它使用對移動友好的搜索空間搜索特征金字塔,極大地利用了深度可分離卷積。但是一九八存在幾個因素限制了它在移動加速器上的推廣:

-

到目前為止,深度卷積和特征金字塔在這些平臺上都沒有得到很好的優(yōu)化,

-

MnasFPN不搜索backbone,這是延遲的瓶頸。

相比之下,本文的工作依賴于SSD Heads,并提出了基于全卷積Backbone的搜索空間,更易于接受移動加速。

3重新回顧全卷積移動搜索空間

Are IBNs all we need ?

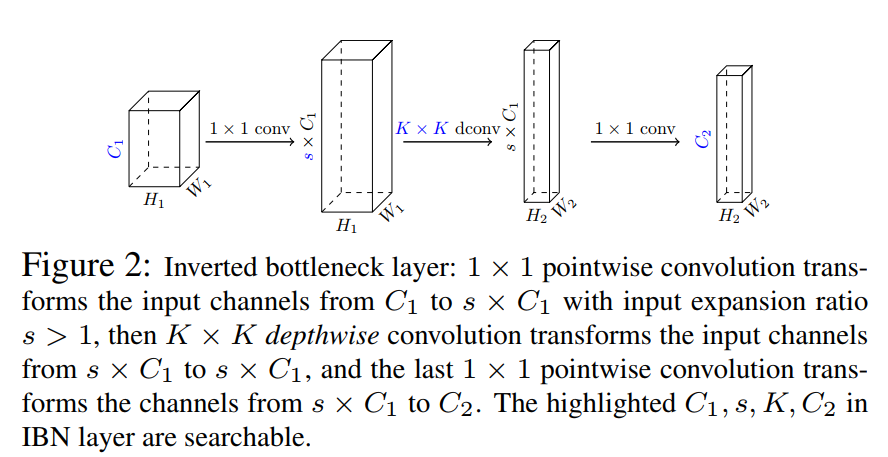

Inverted Bottleneck(IBN)的布局如圖2所示。IBN的設計目的是減少參數(shù)和FLOPS的數(shù)量,并利用depthwise和pointwise(1x1)卷積在移動cpu上實現(xiàn)高效率。

然而,并非所有的FLOPS都是一樣的,特別是對于EdgeTPU和dsp這樣的現(xiàn)代移動加速器來說。例如,一個常規(guī)的卷積在EdgeTPUs上的運行速度可能比它的深度變化快3倍,即使它有7倍的FLOPS。

觀察結果表明,目前廣泛使用的IBN-only搜索空間對于現(xiàn)代移動加速器來說可能是次優(yōu)的。這促使本文通過重新訪問規(guī)則(完全)卷積來提出新的構建塊,以豐富移動加速器的IBN-only搜索空間。具體來說,提出了2個靈活的層分別進行通道擴展和壓縮,具體如下。

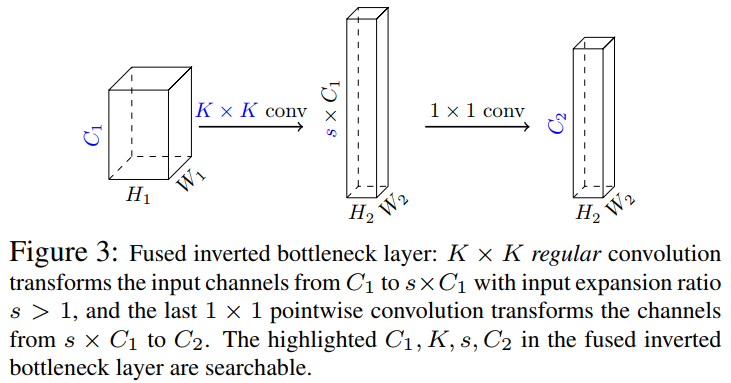

3.1 融合IBN層(擴展)

深度可分離卷積是IBN的關鍵(圖2)。深度可分離卷積背后的想法是將深度卷積(用于空間維度)和 點卷積(用于通道維度)的組合代替復雜的全卷積。

然而,復雜的概念在很大程度上是基于FLOPS或參數(shù)的數(shù)量來定義的,這與現(xiàn)代移動加速器的推理效率不一定相關。為了整合卷積,作者提出對IBN層進行修改,將其前 卷積和隨后的 深度卷積融合為單個 正則卷積(圖3)。融合IBN的初始卷積使Kernel的數(shù)量增加了一個因子 ;這一層的擴展比例由NAS算法決定。

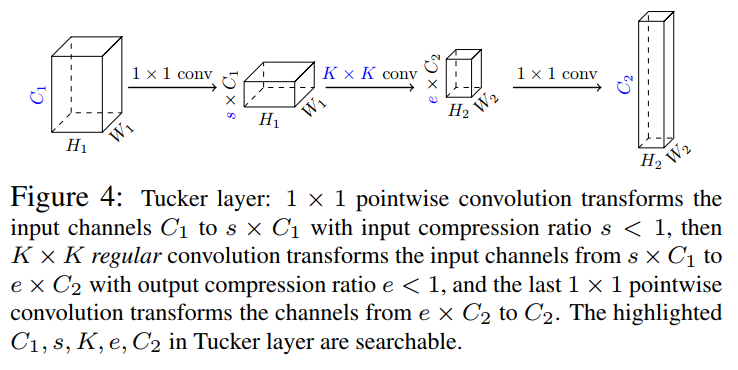

3.2 Tucker卷積層(壓縮)

在ResNet中引入瓶頸層,降低了在高維特征圖上進行大卷積的消耗。壓縮比s<1的瓶頸層有:

-

輸入通道為 輸出通道為 的1×1卷積; -

輸入通道為 輸出通道為 的K×K卷積; -

輸入通道為 輸出通道為 的1×1卷積;

作者概括了這些瓶頸(圖4)通過允許初始1×1卷積比K×K卷積有不同數(shù)量的輸出卷積核,并讓NAS算法決定最終的最佳配置。

作者將這些新的構建塊稱為Tucker卷積層,因為它們與Tucker分解有關。

4架構搜索方法

本文提出的搜索空間是互補的任何神經(jīng)結構搜索算法。

在實驗中使用了TuNAS,因為它的可伸縮性和相對于隨機baseline的可靠改進。TuNAS構建了一個one-shot模型,該模型包含給定搜索空間中的所有架構選擇,以及一個控制器,其目標是選擇優(yōu)化平臺感知的獎勵功能的架構。

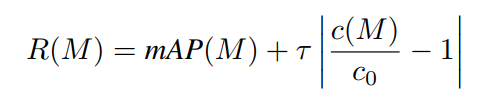

在搜索過程中,one-shot模型和控制器一起訓練。在每一步中,控制器從跨越選擇的多項分布中抽樣一個隨機體系結構,然后更新與抽樣體系結構相關的one-shot模型權值的部分,最后計算抽樣體系結構的獎勵,用于更新控制器。更新內容是通過對以下獎勵功能應用強化算法來實現(xiàn)的:

Cost Models

作者訓練了一個Cost Model, ——一個線性回歸模型,它的特征是,對于每一層,輸入/輸出通道規(guī)模和層類型之間的交叉乘積的指標。該模型跨平臺高保真度 。線性代價模型與之前提出的基于查找表的方法有關,但只要求在搜索空間內對隨機選取的模型的延遲進行基準測試,而不要求度量卷積等單個網(wǎng)絡操作的cost。

因為R(M)是在每次更新步驟時計算的,所以效率是關鍵。在搜索過程中,本文基于一個小型的小批處理估計了mAP(M)的效率,并使用回歸模型作為設備上延遲c(M)的替代。為了收集成本模型的訓練數(shù)據(jù),本文從搜索空間隨機抽取數(shù)千個網(wǎng)絡架構,并在設備上對每個架構進行基準測試。這在每個硬件和搜索之前只執(zhí)行一次,消除了服務器類ML硬件和移動設備之間直接通信的需要。對于最終的評估,所找到的體系結構將基于實際硬件測試而不是成本模型進行基準測試。

5實驗

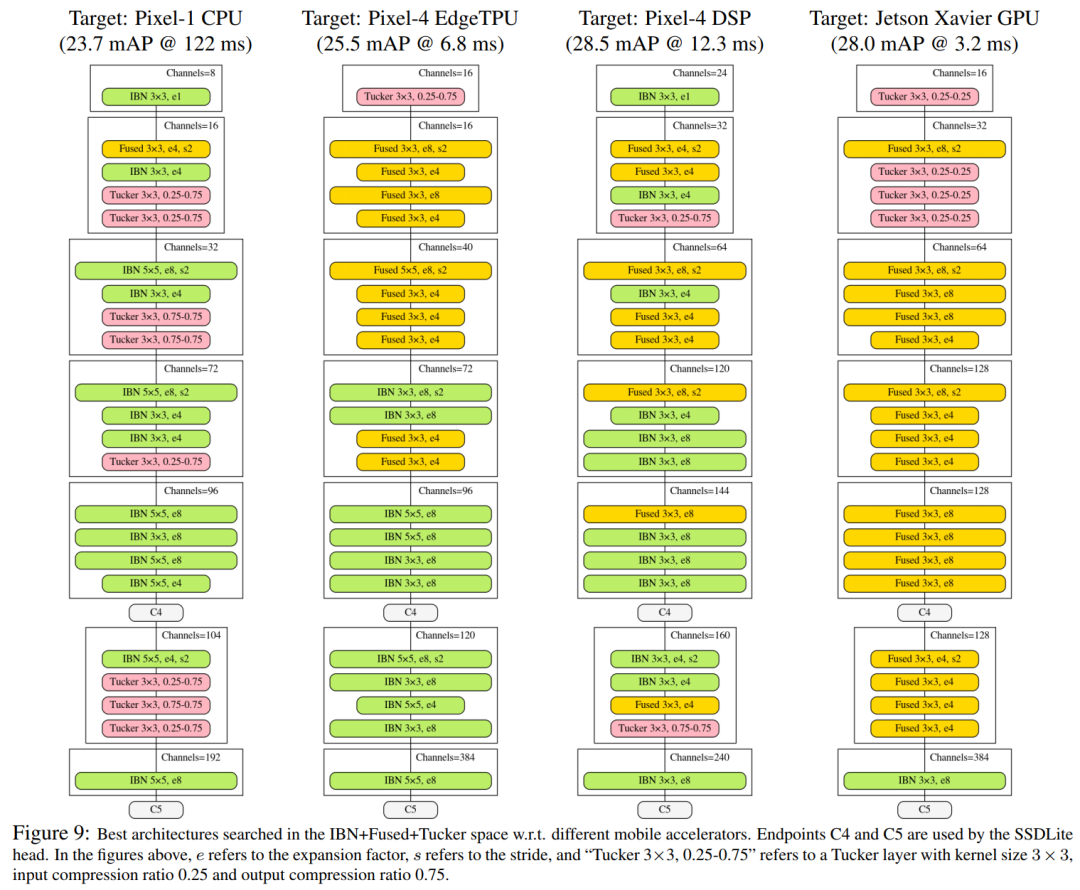

5.1 不同硬件的實驗

CPU

圖5顯示了pixel-1 cpu的NAS結果。正如預期的那樣,MobileNetV3+SSDLite是一個強大的baseline,因為它的backbone的效率已經(jīng)在相同的硬件平臺上對ImageNet上的分類任務進行了大量優(yōu)化。作者還注意到,在這種特殊情況下,常規(guī)卷積并沒有提供明顯的優(yōu)勢,因為IBN-only在FLOPS/CPU延遲下已經(jīng)很強大了。然而,w.r.t.進行特定領域的體系結構搜索,目標檢測任務在COCO上提供了不小的收益(150-200ms范圍內的+1mAP)。

EdgeTPU

圖6顯示了以Pixel-4 EdgeTPUs為目標時的NAS結果。使用這3種搜索空間中的任何一種進行硬件感知的體系結構搜索,都能顯著提高整體質量。這很大程度上是由于baseline架構(MobileNetV2)1對CPU延遲進行了大量優(yōu)化,這與FLOPS/MAdds密切相關,但與EdgeTPU延遲沒有很好地校準。值得注意的是,雖然IBN-only仍然提供了最好的準確性-madds權衡(中間圖),但在搜索空間中使用常規(guī)卷積(IBN+Fused或IBN+Fused+Tucker)在準確性-延遲權衡方面提供了明顯的進一步優(yōu)勢。實驗結果證明了完全卷積在EdgeTPUs上的有效性。

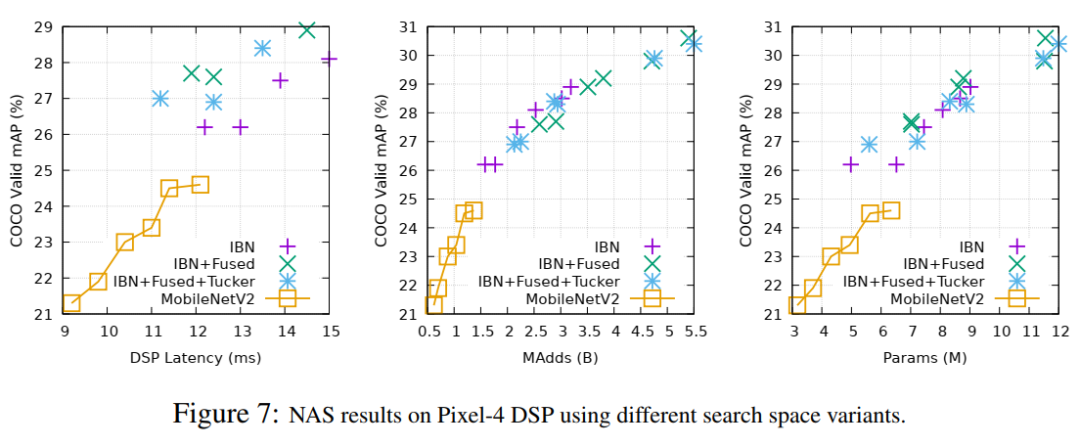

DSP

圖7顯示了Pixel-4 DSP的搜索結果。與EdgeTPUs類似,很明顯,在搜索空間中包含規(guī)則卷積可以在相當?shù)耐茢嘌舆t下顯著改善mAP。

5.2 SOTA對比結果

6參考

[1].MobileDets: Searching for Object Detection Architectures for Mobile Accelerators

7推薦閱讀

即插即用模塊 | CompConv卷積讓模型不丟精度還可以提速(附論文下載)

詳細解讀Google新作 | 教你How to train自己的Transfomer模型?

CVPR2021 GAN詳細解讀 | AdaConv自適應卷積讓你的GAN比AdaIN更看重細節(jié)(附論文下載)

本文論文原文獲取方式,掃描下方二維碼

回復【MobileDets】即可獲取論文

長按掃描下方二維碼添加小助手。

可以一起討論遇到的問題

聲明:轉載請說明出處

掃描下方二維碼關注【集智書童】公眾號,獲取更多實踐項目源碼和論文解讀,非常期待你我的相遇,讓我們以夢為馬,砥礪前行!