詳解:多模態(tài)知識圖譜種類及其應(yīng)用

極市導(dǎo)讀

本文系統(tǒng)的講述了一些關(guān)于多模態(tài)知識圖譜的相關(guān)知識,作者介紹了一些重要的開源多模態(tài)知識圖譜,基于百科多模態(tài)知識圖譜Richpedia以及相關(guān)使用網(wǎng)站和多模態(tài)知識圖譜的應(yīng)用。>>加入極市CV技術(shù)交流群,走在計(jì)算機(jī)視覺的最前沿

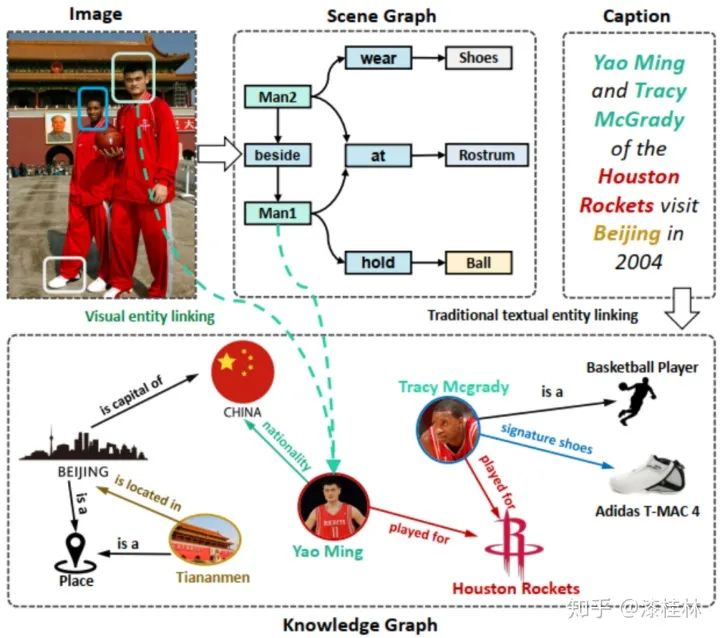

知識圖譜技術(shù)已經(jīng)被廣泛用于處理結(jié)構(gòu)化數(shù)據(jù)(采用本體+D2R技術(shù))和文本數(shù)據(jù)(采用文本信息抽取技術(shù)),但是還有一類非結(jié)構(gòu)化數(shù)據(jù),即視覺數(shù)據(jù),則相對關(guān)注度較低,而且相缺乏有效的技術(shù)手段來從這些數(shù)據(jù)中提取結(jié)構(gòu)化知識。最近幾年,雖然有一些多模態(tài)視覺技術(shù)提出,這些技術(shù)主要還是為了提升圖像分類、圖像生成、圖像問答的效果,不能很好地支撐多模態(tài)知識圖譜的構(gòu)建。視覺數(shù)據(jù)庫通常是圖像或視頻數(shù)據(jù)的豐富來源,并提供關(guān)于知識圖譜中實(shí)體的充分視覺信息。顯然,如果可以在在更大范圍內(nèi)進(jìn)行鏈接預(yù)測和實(shí)體對齊,進(jìn)而進(jìn)行實(shí)體關(guān)系抽取,可以使現(xiàn)有的模型在綜合考慮文本和視覺特征時(shí)獲得更好的性能,這也是我們研究多模態(tài)知識圖譜(multi-modal knowledge graph)的意義所在。

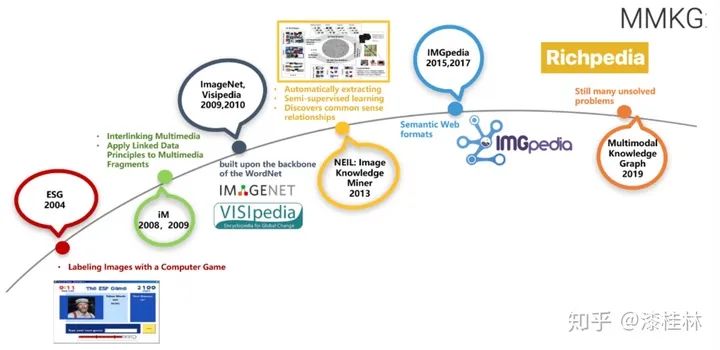

目前,已經(jīng)有很多開放知識圖譜(見https://lod-cloud.net/和http://www.openkg.cn/),而且不少企業(yè)也有自己的企業(yè)知識圖譜。然而,這些知識圖譜很少有可視化的數(shù)據(jù)資源。圖1所示為多模態(tài)知識圖譜的發(fā)展過程。

多模態(tài)知識圖譜與傳統(tǒng)知識圖譜的主要區(qū)別是,傳統(tǒng)知識圖譜主要集中研究文本和數(shù)據(jù)庫的實(shí)體和關(guān)系,而多模態(tài)知識圖譜則在傳統(tǒng)知識圖譜的基礎(chǔ)上,構(gòu)建了多種模態(tài)(例如視覺模態(tài))下的實(shí)體,以及多種模態(tài)實(shí)體間的多模態(tài)語義關(guān)系。例如在最新的一個(gè)多模態(tài)百科圖譜Richpedia中(如下圖2所示)[5],首先構(gòu)建了圖像模態(tài)倫敦眼圖像與文本模態(tài)知識圖譜實(shí)體(DBpedia實(shí)體:London eye)之間的多模態(tài)語義關(guān)系(rpo:imageof),之后還構(gòu)建了圖像模態(tài)實(shí)體倫敦眼與圖像模態(tài)實(shí)體大本鐘之間的多模態(tài)語義關(guān)系(rpo:nextTo)。

一、多模態(tài)知識圖譜相關(guān)工作

隨著人工智能技術(shù)的不斷發(fā)展,知識圖譜作為人工智能領(lǐng)域的知識支柱,以其強(qiáng)大的知識表示和推理能力受到學(xué)術(shù)界和產(chǎn)業(yè)界的廣泛關(guān)注。近年來,知識圖譜在語義搜索、問答、知識管理等領(lǐng)域得到了廣泛的應(yīng)用。其中在描述多媒體的可用數(shù)據(jù)集中,現(xiàn)有的工作重點(diǎn)是捕獲多媒體文件的高級元數(shù)據(jù)(如作者、創(chuàng)建日期、文件大小、清晰度、持續(xù)時(shí)間),而不是多媒體內(nèi)容本身的音頻或視覺特性。以下會介紹幾個(gè)重要的開源多模態(tài)知識圖譜:

1.DBpedia[1]

DBpedia作為近十年來語義網(wǎng)研究的中心領(lǐng)域,其豐富的語義信息也將會成為今后多模態(tài)知識圖譜的鏈接端點(diǎn),其完整的本體結(jié)構(gòu)對于構(gòu)建多模態(tài)知識圖譜提供了很大的便利。DBpedia項(xiàng)目是一個(gè)社區(qū)項(xiàng)目,旨在從維基百科中提取結(jié)構(gòu)化信息,并使其可在網(wǎng)絡(luò)上訪問。DBpedia知識庫目前描述了超過260萬個(gè)實(shí)體。對于每個(gè)實(shí)體,DBpedia定義了一個(gè)唯一的全局標(biāo)識符,可以將其解引用為網(wǎng)絡(luò)上一個(gè)RDF描述的實(shí)體。DBpedia提供了30種人類可讀的語言版本,與其他資源形成關(guān)系。在過去的幾年里,越來越多的數(shù)據(jù)發(fā)布者開始建立數(shù)據(jù)集鏈接到DBpedia資源,使DBpedia成為一個(gè)新的數(shù)據(jù)web互聯(lián)中心。目前,圍繞DBpedia的互聯(lián)網(wǎng)數(shù)據(jù)源網(wǎng)絡(luò)提供了約47億條信息,涵蓋地理信息、人、公司、電影、音樂、基因、藥物、圖書、科技出版社等領(lǐng)域。

2.Wikidata[2]

Wikidata中也存在大量的多模態(tài)資源,Wikidata是維基媒體基金會(WMF)聯(lián)合策劃的一個(gè)知識圖譜,是維基媒體數(shù)據(jù)管理策略的核心項(xiàng)目。充分利用Wikidata的資源,主要挑戰(zhàn)之一是提供可靠并且強(qiáng)大的數(shù)據(jù)共享查詢服務(wù),維基媒體基金會選擇使用語義技術(shù)。活動的SPARQL端點(diǎn)、常規(guī)的RDF轉(zhuǎn)儲和鏈接的數(shù)據(jù)api是目前Wikidata的核心技術(shù),Wikidata的目標(biāo)是通過創(chuàng)造維基百科全球管理數(shù)據(jù)的新方法來克服數(shù)據(jù)不一致性。Wikidata的主要成就包括:Wikidata提供了一個(gè)可由所有人共享的免費(fèi)協(xié)作知識庫;Wikidata已經(jīng)成為維基媒體最活躍的項(xiàng)目之一;越來越多的網(wǎng)站在瀏覽頁面時(shí)都從Wikidata獲取內(nèi)容,以增加大數(shù)據(jù)的可見性和實(shí)用性。

3.IMGpedia[3]

IMGpedia是一個(gè)大型的鏈接數(shù)據(jù)集,它從Wikimedia Commons數(shù)據(jù)集中的圖像中收集大量的可視化信息。它構(gòu)建并生成了1500萬個(gè)視覺內(nèi)容描述符,圖像之間有4.5億個(gè)視覺相似關(guān)系,此外,在IMGpedia中單個(gè)圖像與DBpedia之間還有鏈接。IMGpedia旨在從維基百科發(fā)布的圖片中提取相關(guān)的視覺信息,從Wikimedia中收集所有術(shù)語和所有多模態(tài)數(shù)據(jù)(包括作者、日期、大小等)的圖像,并為每張圖像生成相應(yīng)的圖像描述符。鏈接數(shù)據(jù)很少考慮多模態(tài)數(shù)據(jù),但多模態(tài)數(shù)據(jù)也是語義網(wǎng)絡(luò)的重要組成部分。為了探索鏈接數(shù)據(jù)和多模態(tài)數(shù)據(jù)的結(jié)合,構(gòu)建了IMGpedia,計(jì)算Wikipedia條目中使用的圖像描述符,然后將這些圖像及其描述與百科知識圖譜鏈接起來。

IMGpedia是一個(gè)多模態(tài)知識圖譜的先例。將語義知識圖譜與多模態(tài)數(shù)據(jù)相結(jié)合,面對多種任務(wù)下的挑戰(zhàn)和機(jī)遇。IMGpedia使用四種圖像描述符進(jìn)行基準(zhǔn)測試,這些描述符的引用和實(shí)現(xiàn)是公開的。IMGpedia提供了Wikidata的鏈接。由于DBpedia中的分類對一些可視化語義查詢不方便,所以IMGpedia旨在提供一個(gè)更好的語義查詢平臺。IMGpedia在多模態(tài)方向上是一個(gè)很好的先例,但也存在一些問題,比如關(guān)系類型稀疏,關(guān)系數(shù)量少,圖像分類不清晰等,也是之后需要集中解決的問題。

4.MMKG[4]

MMKG主要用于聯(lián)合不同知識圖譜中的不同實(shí)體和圖像執(zhí)行關(guān)系推理,MMKG是一個(gè)包含所有實(shí)體的數(shù)字特征和(鏈接到)圖像的三個(gè)知識圖譜的集合,以及對知識圖譜之間的實(shí)體對齊。因此,多關(guān)系鏈接預(yù)測和實(shí)體匹配社區(qū)可以從該資源中受益。MMKG有潛力促進(jìn)知識圖譜的新型多模態(tài)學(xué)習(xí)方法的發(fā)展,作者通過大量的實(shí)驗(yàn)驗(yàn)證了MMKG在同一鏈路預(yù)測任務(wù)中的有效性。

MMKG選擇在知識圖譜補(bǔ)全文獻(xiàn)中廣泛使用的數(shù)據(jù)集FREEBASE-15K (FB15K)作為創(chuàng)建多模態(tài)知識圖譜的起點(diǎn)。知識圖譜三元組是基于N-Triples格式的,這是一種用于編碼RDF圖的基于行的純文本格式。MMKG同時(shí)也創(chuàng)建了基于DBpedia和YAGO的版本,稱為DBpedia-15K(DB15K)和YAGO15K,通過將FB15K中的實(shí)體與其他知識圖譜中的實(shí)體對齊。其中對于基于DBpedia的版本,主要構(gòu)建了sameAs關(guān)系,為了創(chuàng)建DB15K,提取了FB15K和DBpedia實(shí)體之間的對齊,通過sameAs關(guān)系鏈接FB15K和DBpedia中的對齊實(shí)體;構(gòu)建關(guān)系圖譜,來自FB15K的很大比例的實(shí)體可以與DBpedia中的實(shí)體對齊。但是,為了使這兩個(gè)知識圖譜擁有大致相同數(shù)量的實(shí)體,并且擁有不能跨知識圖譜對齊的實(shí)體,在DB15K中包括了額外的實(shí)體;構(gòu)建圖像關(guān)系,MMKG從三大搜索引擎中獲取相應(yīng)文本實(shí)體的圖像實(shí)體,生成對應(yīng)的文本-圖像關(guān)系。但是,它是專門為文本知識圖譜的完成而構(gòu)建的,主要針對小數(shù)據(jù)集(FB15K, DBPEDIA15K, YAGO15K)。MMKG在將圖像分發(fā)給相關(guān)文本實(shí)體時(shí)也沒有考慮圖像的多樣性。

二、基于百科多模態(tài)知識圖譜Richpedia

雖說之前的一些工作如IMGpedia和MMKG融合了多模態(tài)的知識,構(gòu)建了多模態(tài)知識圖譜,但其中也存在一些問題,例如在IMGpedia中關(guān)系類型稀疏,關(guān)系數(shù)量少,圖像分類不清晰等,在MMKG中圖像并沒有作為單獨(dú)的圖像實(shí)體存在,而是依賴于相應(yīng)的傳統(tǒng)文本實(shí)體。這些問題對于多模態(tài)任務(wù)的發(fā)展有著較大制約,東南大學(xué)認(rèn)知智能研究所基于解決如上存在的問題的動機(jī),提出了多模態(tài)知識圖譜Richpedia[5]。

Richpedia多模態(tài)知識圖譜的定義如下:實(shí)體集合E包括文本知識圖譜實(shí)體EKG和圖像實(shí)體EIM,R表示一系列關(guān)系的集合,其中E和R利用統(tǒng)一資源標(biāo)識符(IRIs)表示。L是文字的集合(例如:“倫敦”,“750px”),B表示為一系列的空白節(jié)點(diǎn)。Richpedia三元組t表示格式為<subject, predicate, object>,是(E∪B)×R×(E∪L∪B),Richpedia多模態(tài)知識圖譜是Richpedia三元組的集合。

在構(gòu)建多模態(tài)知識圖譜中,總體模型如圖3所示。接下來我們會逐步介紹構(gòu)建Richpedia的流程。

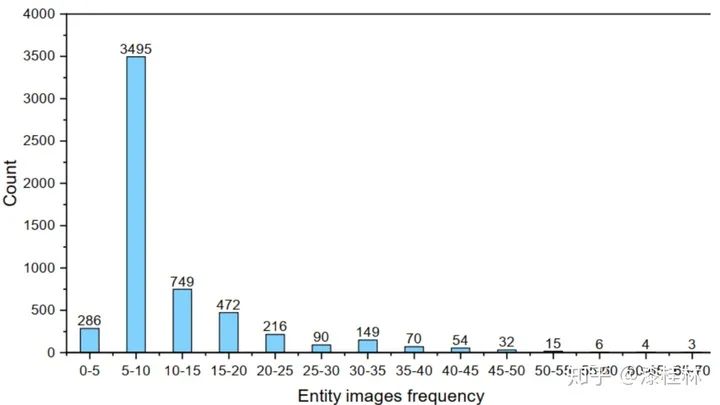

與一般的文本知識圖譜不同,Richpedia的出發(fā)點(diǎn)是構(gòu)造一個(gè)多模態(tài)知識圖譜,其中包含了全面的圖像實(shí)體及其之間的關(guān)系。但是,如圖4所示,文本知識圖譜實(shí)體的圖像資源有很大一部分是長尾分布。換句話說,平均每一個(gè)文本知識圖譜實(shí)體在Wikipedia中只有很少的視覺信息。因此,我們考慮借助外部來源來填充Richpedia,首先我們基于現(xiàn)有的傳統(tǒng)文本實(shí)體,從維基百科,谷歌,必應(yīng)和雅虎四大圖像搜索引擎中獲取相應(yīng)的圖像實(shí)體,每一個(gè)圖像作為知識圖譜中的一個(gè)實(shí)體存儲于Richpedia中。Wikidata已經(jīng)為每個(gè)文本知識圖譜實(shí)體定義了唯一的統(tǒng)一資源標(biāo)識符,我們將這些統(tǒng)一資源標(biāo)識符添加到Richpedia作為文本知識圖譜實(shí)體。在目前的版本中,我們主要收集了30,638個(gè)關(guān)于城市、景點(diǎn)和名人的實(shí)體。對于圖像實(shí)體,我們可以直觀地從Wikipedia上收集圖像,然后在Richpedia中創(chuàng)建相應(yīng)的統(tǒng)一資源標(biāo)識符。

在收集完圖像實(shí)體之后,我們需要對圖像實(shí)體進(jìn)行預(yù)處理和篩選。因?yàn)槲覀兊臄?shù)據(jù)來自于開放資源,它們會被搜索引擎基于與查詢字段的相關(guān)性評分進(jìn)行排名。從多模態(tài)知識圖譜的角度而言,文本知識圖譜實(shí)體所包含的圖像實(shí)體不僅要相關(guān)性高而且還要具有多樣性,如圖5所示,對于中間的圖像實(shí)體,右側(cè)的圖像實(shí)體因?yàn)檩^高的相似性從而被系統(tǒng)過濾掉,保留左側(cè)相似性較低的圖像實(shí)體。因?yàn)閺乃阉饕嬷蝎@取的圖像實(shí)體難免存在重復(fù)問題,接下來我們通過一系列的預(yù)處理操作,使得每個(gè)圖像實(shí)體都與相應(yīng)的傳統(tǒng)文本實(shí)體具有較高的相關(guān)度。其中預(yù)處理操作包括去噪操作和多樣性檢測,去噪操作的目的是去除不相關(guān)的圖像實(shí)體,多樣性檢測的目的是使得圖像實(shí)體具有盡可能高的多樣性。

因?yàn)楹茈y基于不同圖像的像素特征直接檢測出這些語義關(guān)系,所以我們利用基于規(guī)則的關(guān)系抽取模板,借助Wikipedia圖像描述中的超鏈接信息,生成圖像實(shí)體間的多模態(tài)語義關(guān)系。在圖6中,我們以rpo:contain和rpo:nearBy為例說明如何發(fā)現(xiàn)協(xié)和廣場,盧克索方尖碑和航運(yùn)噴泉圖像實(shí)體間的語義關(guān)系。如圖6所示,我們在中文維基百科中協(xié)和廣場詞條中獲取到包含盧克索方尖碑和航運(yùn)噴泉的圖像實(shí)體,從語義視覺關(guān)系的角度上看,協(xié)和廣場包括了盧克索方尖碑和航運(yùn)噴泉,盧克索方尖碑就在航運(yùn)噴泉的旁邊。為了發(fā)現(xiàn)這些關(guān)系,我們收集這些圖像的文本描述,并提出三個(gè)有效的規(guī)則來提取多模態(tài)語義關(guān)系:

規(guī)則1. 如果在描述中有一個(gè)超鏈接,其指向的對應(yīng)Wikipedia實(shí)體的概率很高。我們利用Stanford CoreNLP檢測描述中的關(guān)鍵字。然后,通過字符串映射算法發(fā)現(xiàn)預(yù)定義關(guān)系。例如,如果我們在兩個(gè)實(shí)體之間的文本描述中得到單詞‘left’,我們將得到‘nearBy’關(guān)系。

規(guī)則2. 如果描述中有多個(gè)超鏈接,我們基于語法分析器和語法樹檢測核心知識圖譜實(shí)體(即描述的主體)。然后,我們以核心知識圖譜實(shí)體作為輸入,將這種情況簡化為規(guī)則1。

規(guī)則3. 如果在描述中沒有指向其他詞條的超鏈接,我們使用Stanford CoreNLP來查找描述中包含的Wikipedia知識圖譜實(shí)體,并將這種情況簡化為規(guī)則1和規(guī)則2。因?yàn)橐?guī)則3依賴于NER結(jié)果,準(zhǔn)確率低于相應(yīng)的預(yù)標(biāo)注超鏈接信息,所以它的優(yōu)先級低于前兩個(gè)規(guī)則。

三、基于Richpedia的多模態(tài)知識服務(wù)網(wǎng)站

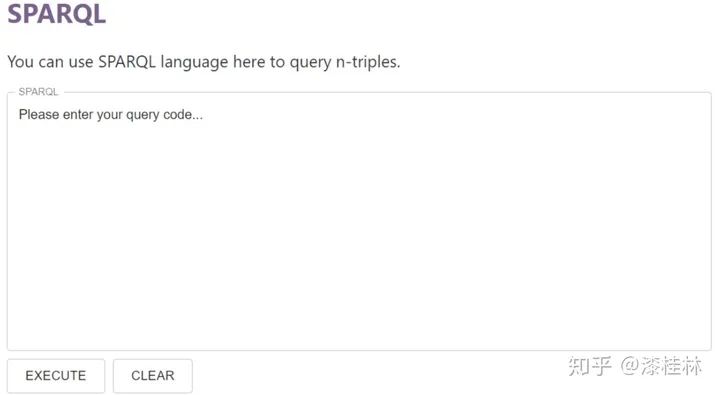

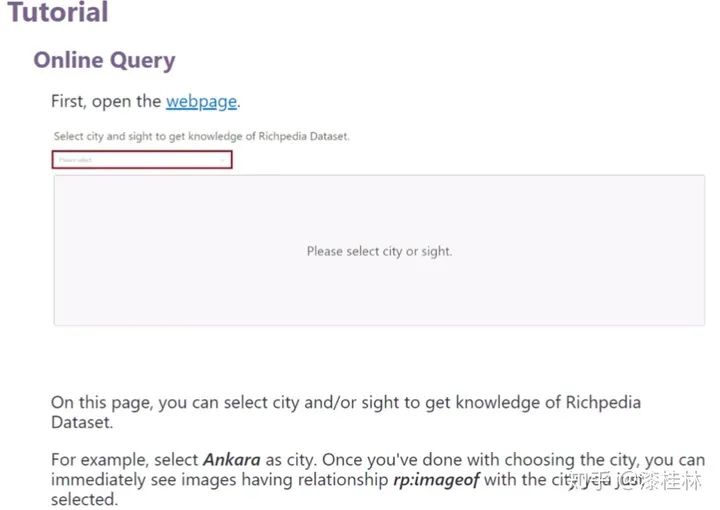

Richpedia網(wǎng)站(http://rich.wangmengsd.com/)是為Richpedia多模態(tài)知識圖譜開發(fā)的一個(gè)網(wǎng)站,其提供了對Richpedia數(shù)據(jù)庫的介紹,查詢,資源檢索,使用教程以及數(shù)據(jù)下載服務(wù)。其中包括:

a) Homepage:主要對Richpedia數(shù)據(jù)庫進(jìn)行了概述。

b) Download:提供了image文件和三元組關(guān)系N-Triples文件的下載鏈接。

c) SPARQL:實(shí)現(xiàn)了對Richpedia數(shù)據(jù)庫中的實(shí)體和視覺關(guān)系的SPARQL查詢。

d) Query:提供了對地名和人物的直接查詢相關(guān)圖片功能。

e) Tutorial:提供了網(wǎng)站的使用教程。

首先,我們可以在Richpedia中查詢實(shí)體信息,包括圖像實(shí)體實(shí)體和文本知識圖譜實(shí)體。第一步是選擇查詢的實(shí)體類別,然后選擇要具體查詢的實(shí)體。例如,如果我們要查詢安卡拉城市實(shí)體的文本知識圖譜實(shí)體和圖像實(shí)體,可以在下拉選擇器中選擇對應(yīng)的安卡拉城市標(biāo)簽。之后出現(xiàn)的頁面中上半部分是安卡拉的文本知識圖譜實(shí)體,下半部分是安卡拉的圖像實(shí)體。

其次,我們可以通過Richpedia的在線訪問平臺查詢圖像實(shí)體之間的視覺語義關(guān)系。選擇查詢文本知識圖譜實(shí)體后,點(diǎn)擊對應(yīng)的圖像實(shí)體,可以查看圖像實(shí)體的視覺語義關(guān)系。例如,當(dāng)我們想查詢一個(gè)與北京動物園圖像實(shí)體具有rpo:sameAs關(guān)系的圖像實(shí)體時(shí),我們可以點(diǎn)擊相應(yīng)的北京動物園圖像實(shí)體,得到相應(yīng)的結(jié)果。

f) Ontology:提供了Ontology的相關(guān)信息。

g) Resource:提供了對所有圖片資源的訪問地址。

h) Github鏈接以及頁面底端:提供了friendly link,聯(lián)系人郵箱,Github主頁以及分享協(xié)議。

四、多模態(tài)知識圖譜應(yīng)用

多模態(tài)知識圖譜的應(yīng)用場景十分廣泛,首先一個(gè)完備的多模態(tài)知識圖譜會極大地幫助現(xiàn)有自然語言處理和計(jì)算機(jī)視覺等領(lǐng)域的發(fā)展,同時(shí)對于跨領(lǐng)域的融合研究也會有極大的幫助,多模態(tài)結(jié)構(gòu)數(shù)據(jù)雖然在底層表征上是異構(gòu)的,但是相同實(shí)體的不同模態(tài)數(shù)據(jù)在高層語義上是統(tǒng)一的,所以多種模態(tài)數(shù)據(jù)的融合有利于推進(jìn)語言表示等模型的發(fā)展,對于在語義層級構(gòu)建多種模態(tài)下統(tǒng)一的語言表示模型提出數(shù)據(jù)支持。其次多模態(tài)知識圖譜技術(shù)可以服務(wù)于各種下游領(lǐng)域,例如多模態(tài)實(shí)體鏈接技術(shù)可以融合多種模態(tài)下的相同實(shí)體,可以廣泛應(yīng)用于新聞閱讀,時(shí)事推薦,明星同款等場景中如圖14,多模態(tài)知識圖譜補(bǔ)全技術(shù)可以通過遠(yuǎn)程監(jiān)督補(bǔ)全多模態(tài)知識圖譜,完善現(xiàn)有的多模態(tài)知識圖譜,利用動態(tài)更新技術(shù)使其更加的完備,多模態(tài)對話系統(tǒng)的應(yīng)用就更加的廣泛,現(xiàn)階段電商領(lǐng)域中集成圖像和文本的多模態(tài)對話系統(tǒng)的研究蒸蒸日上,多模態(tài)對話系統(tǒng)對于電商推薦,商品問答領(lǐng)域的進(jìn)步有著重大的推進(jìn)作用。

多模態(tài)知識圖譜是一個(gè)新興領(lǐng)域,受益于近些年通訊技術(shù)的發(fā)展,多模態(tài)數(shù)據(jù)越來越成為人們生活中觸手可及的信息,種種多模態(tài)技術(shù)也成為當(dāng)下研究的熱門方向。

參考文獻(xiàn)

推薦閱讀