淺談Python兩大爬蟲庫——urllib庫和requests庫區(qū)別

一、前言

在使用Python爬蟲時,需要模擬發(fā)起網(wǎng)絡(luò)請求,主要用到的庫有requests庫和python內(nèi)置的urllib庫,一般建議使用requests,它是對urllib的再次封裝。

那它們兩者有什么區(qū)別 ?

下面通過案例詳細(xì)的講解 ,了解他們使用的主要區(qū)別。

二、urllib庫

簡介:

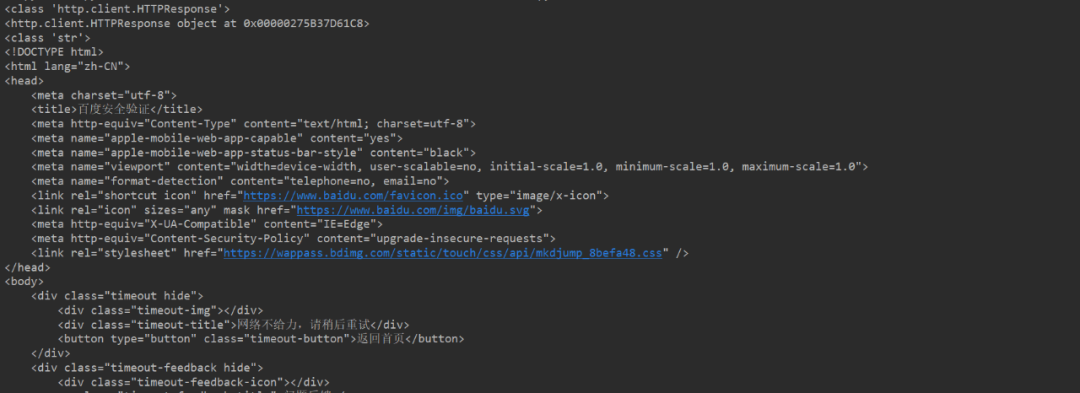

urllib庫的response對象是先創(chuàng)建http,request對象,裝載到reques.urlopen里完成http請求。

返回的是http,response對象,實際上是html屬性。使用.read().decode()解碼后轉(zhuǎn)化成了str字符串類型,decode解碼后中文字符能夠顯示出來。

例

from urllib import request#請求頭headers = {"User-Agent": 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.186 Safari/537.36'}wd = {"wd": "中國"}url = "http://www.baidu.com/s?"req = request.Request(url, headers=headers)response = request.urlopen(req)print(type(response))print(response)res = response.read().decode()print(type(res))print(res)

運行結(jié)果:

注意:

通常爬取網(wǎng)頁,在構(gòu)造http請求的時候,都需要加上一些額外信息,什么Useragent,cookie等之類的信息,或者添加代理服務(wù)器。往往這些都是一些必要的反爬機制。

三、requests庫

簡介:

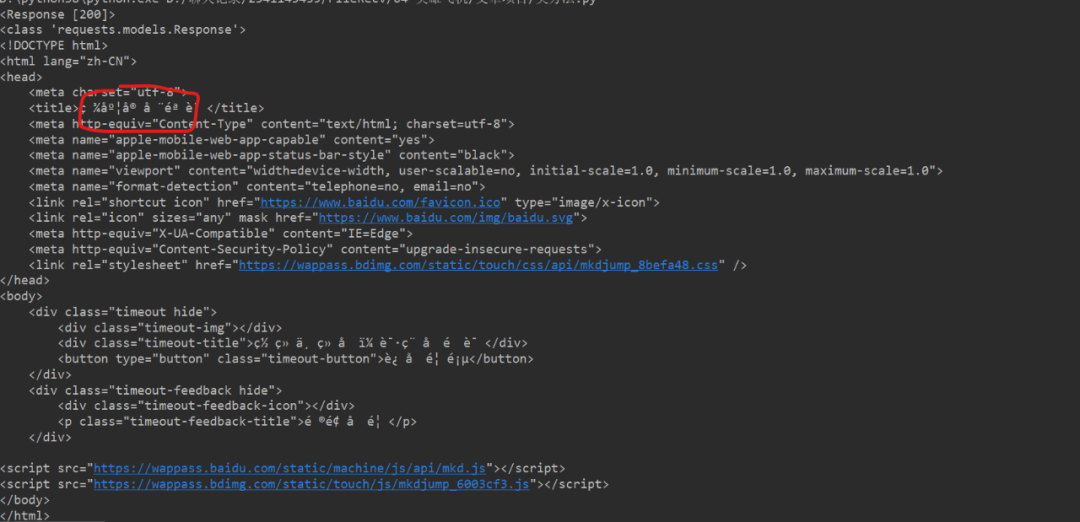

requests庫調(diào)用是requests.get方法傳入url和參數(shù),返回的對象是Response對象,打印出來是顯示響應(yīng)狀態(tài)碼。

通過.text 方法可以返回是unicode 型的數(shù)據(jù),一般是在網(wǎng)頁的header中定義的編碼形式,而content返回的是bytes,二級制型的數(shù)據(jù),還有 .json方法也可以返回json字符串。

如果想要提取文本就用text,但是如果你想要提取圖片、文件等二進制文件,就要用content,當(dāng)然decode之后,中文字符也會正常顯示。

requests的優(yōu)勢:

Python爬蟲時,更建議用requests庫。因為requests比urllib更為便捷,requests可以直接構(gòu)造get,post請求并發(fā)起,而urllib.request只能先構(gòu)造get,post請求,再發(fā)起。

例:

import requestsheaders = {"User-Agent": "Mozilla/5.0 (Linux; U; Android 8.1.0; zh-cn; BLA-AL00 Build/HUAWEIBLA-AL00) AppleWebKit/537.36 (KHTML, like Gecko) Version/4.0 Chrome/57.0.2987.132 MQQBrowser/8.9 Mobile Safari/537.36"}wd = {"wd": "中國"}url = "http://www.baidu.com/s?"response = requests.get(url, params=wd, headers=headers)data = response.textdata2 = response.contentprint(response)print(type(response))print(data)print(type(data))print(data2)print(type(data2))print(data2.decode())print(type(data2.decode()))

運行結(jié)果 (可以直接獲取整網(wǎng)頁的信息,打印控制臺):

四、總結(jié)

本文基于Python基礎(chǔ),主要介紹了urllib庫和requests庫的區(qū)別。

在使用urllib內(nèi)的request模塊時,返回體獲取有效信息和請求體的拼接需要decode和encode后再進行裝載。進行http請求時需先構(gòu)造get或者post請求再進行調(diào)用,header等頭文件也需先進行構(gòu)造。

requests是對urllib的進一步封裝,因此在使用上顯得更加的便捷,建議在實際應(yīng)用當(dāng)中盡量使用requests。

希望能給一些對爬蟲感興趣,有一個具體的概念。方法只是一種工具,試著去爬一爬會更容易上手,網(wǎng)絡(luò)也會有很多的坑,做爬蟲更需要大量的經(jīng)驗來應(yīng)付復(fù)雜的網(wǎng)絡(luò)情況。

希望大家一起探討學(xué)習(xí), 一起進步。

推薦閱讀:

入門: 最全的零基礎(chǔ)學(xué)Python的問題 | 零基礎(chǔ)學(xué)了8個月的Python | 實戰(zhàn)項目 |學(xué)Python就是這條捷徑

干貨:爬取豆瓣短評,電影《后來的我們》 | 38年NBA最佳球員分析 | 從萬眾期待到口碑撲街!唐探3令人失望 | 笑看新倚天屠龍記 | 燈謎答題王 |用Python做個海量小姐姐素描圖 |碟中諜這么火,我用機器學(xué)習(xí)做個迷你推薦系統(tǒng)電影

趣味:彈球游戲 | 九宮格 | 漂亮的花 | 兩百行Python《天天酷跑》游戲!

AI: 會做詩的機器人 | 給圖片上色 | 預(yù)測收入 | 碟中諜這么火,我用機器學(xué)習(xí)做個迷你推薦系統(tǒng)電影

小工具: Pdf轉(zhuǎn)Word,輕松搞定表格和水印! | 一鍵把html網(wǎng)頁保存為pdf!| 再見PDF提取收費! | 用90行代碼打造最強PDF轉(zhuǎn)換器,word、PPT、excel、markdown、html一鍵轉(zhuǎn)換 | 制作一款釘釘?shù)蛢r機票提示器! |60行代碼做了一個語音壁紙切換器天天看小姐姐!|

年度爆款文案

點閱讀原文,領(lǐng)AI全套資料!