2021年9月底,科大訊飛CV崗位面試題分享!

文 | 七月在線

編 | 小七

目錄

FIGHTING

問題1:常見的attention機制,說明channel attention 和 self attention 的原理。

問題2:triplet loss的訓(xùn)練要注意什么?

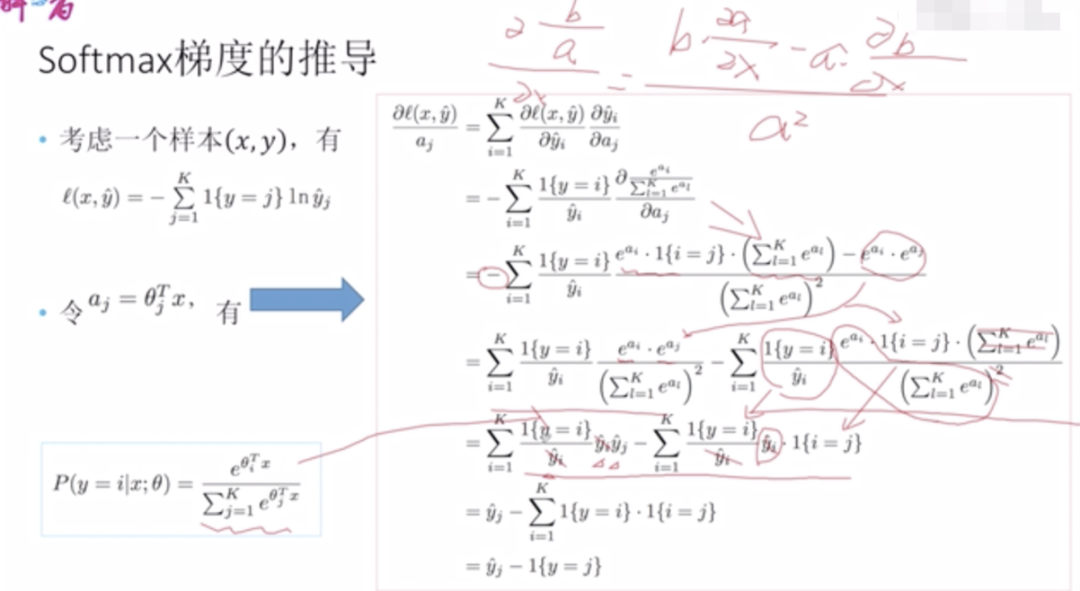

問題3:softmax求導(dǎo)過程?

問題4:KL散度的理解。

問題5:檢測模型里為啥用smoothL1去回歸bbox

問題6:前沿的檢測范式DETR,transformer等等

問題1:常見的attention機制,說明channel attention 和 self attention 的原理。

self-attention、channel attention、spatial attention、multi-head attention、transformer

自注意力機制是注意力機制的變體,其減少了對外部信息的依賴,更擅長捕捉數(shù)據(jù)或特征的內(nèi)部相關(guān)性。

問題2:triplet loss的訓(xùn)練要注意什么?

答:構(gòu)造類內(nèi)差異大、類間差異小的數(shù)據(jù)集

問題3:softmax求導(dǎo)過程?

問題4:KL散度的理解。

KL散度可以用來衡量兩個概率分布之間的相似性,兩個概率分布越相近,KL散度越小

問題5:檢測模型里為啥用smoothL1去回歸bbox

從上面的導(dǎo)數(shù)可以看出,L2 Loss的梯度包含 (f(x) - Y),當(dāng)預(yù)測值 f(x) 與目標(biāo)值 Y 相差很大時,容易產(chǎn)生梯度爆炸,而L1 Loss的梯度為常數(shù),通過使用Smooth L1 Loss,在預(yù)測值與目標(biāo)值相差較大時,由L2 Loss轉(zhuǎn)為L1 Loss可以防止梯度爆炸。

問題6:前沿的檢測范式DETR,transformer等等

與傳統(tǒng)的計算機視覺技術(shù)不同,DETR將目標(biāo)檢測作為一個直接的集合預(yù)測問題來處理。它由一個基于集合的全局損失和一個Transformer encoder-decoder 結(jié)構(gòu)組成,該全局損失通過二分匹配強制進行唯一預(yù)測。給定固定的學(xué)習(xí)對象查詢集,則DETR會考慮對象與全局圖像上下文之間的關(guān)系,以直接并行并行輸出最終的預(yù)測集。由于這種并行性,DETR非常快速和高效。

— 推薦閱讀 —

NLP ( 自然語言處理 )

CV(計算機視覺)

推薦

最新大廠面試題

AI開源項目論文