MMEditing:多任務(wù)圖像視頻編輯工具箱

點(diǎn)擊藍(lán)字

?關(guān)注我們

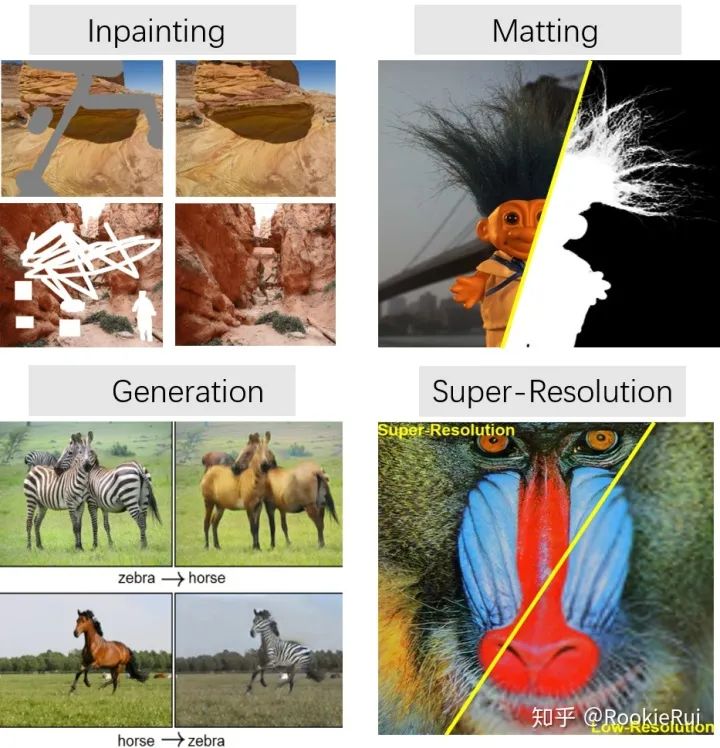

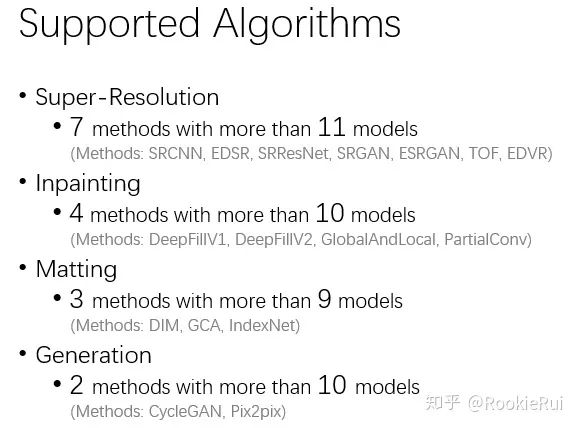

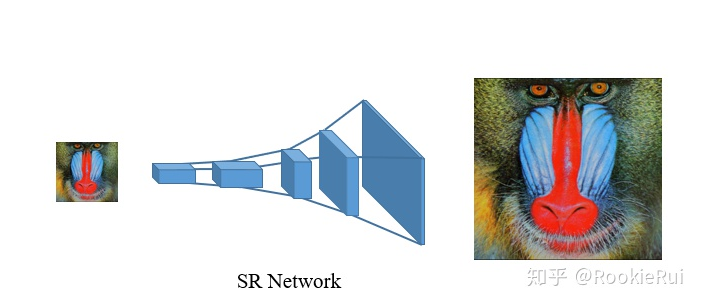

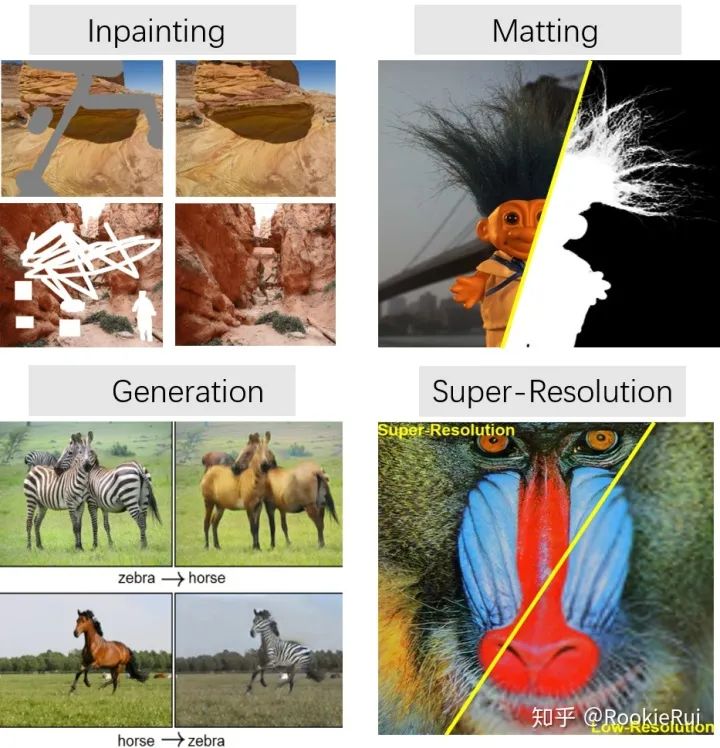

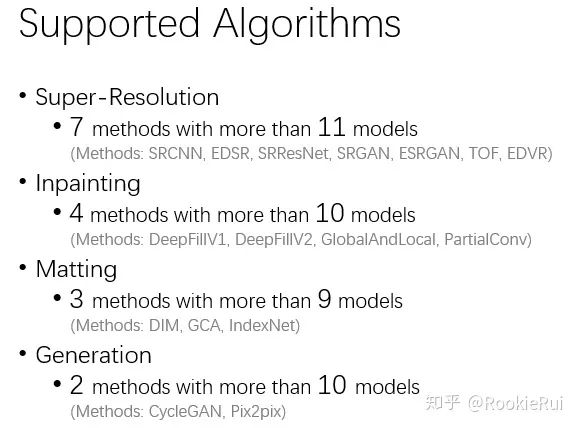

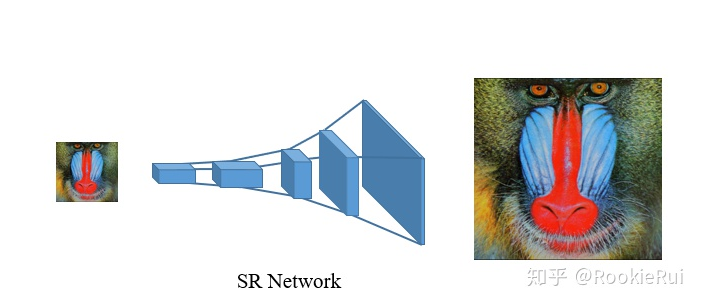

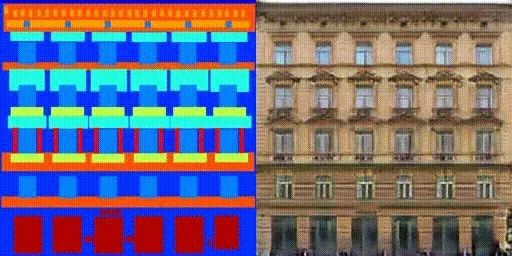

Super-Resolution 超分辨率

Inpainting修復(fù)

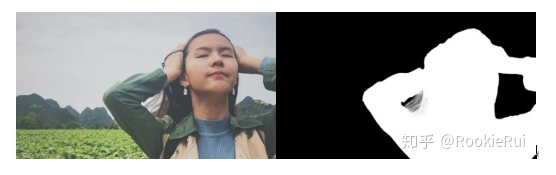

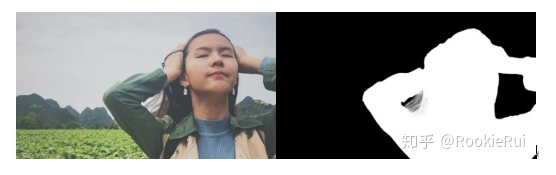

Matting摳像

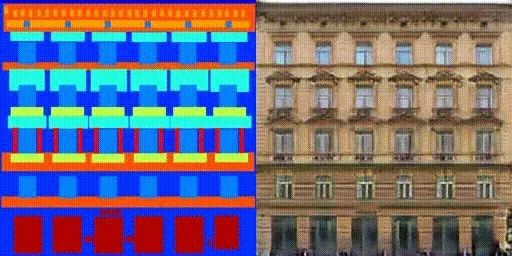

Generation生成模型

結(jié)語

推薦閱讀

評(píng)論

圖片

表情

<b id="afajh"><abbr id="afajh"></abbr></b>

下載APP

下載APP點(diǎn)擊藍(lán)字

?關(guān)注我們

推薦閱讀

<b id="afajh"><abbr id="afajh"></abbr></b>