用超分辨率扛把子算法 ESRGAN,訓(xùn)練圖像增強(qiáng)模型

來源:HyperAI超神經(jīng) 本文約3500字,建議閱讀9分鐘

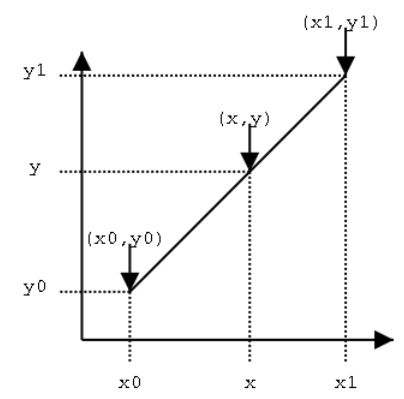

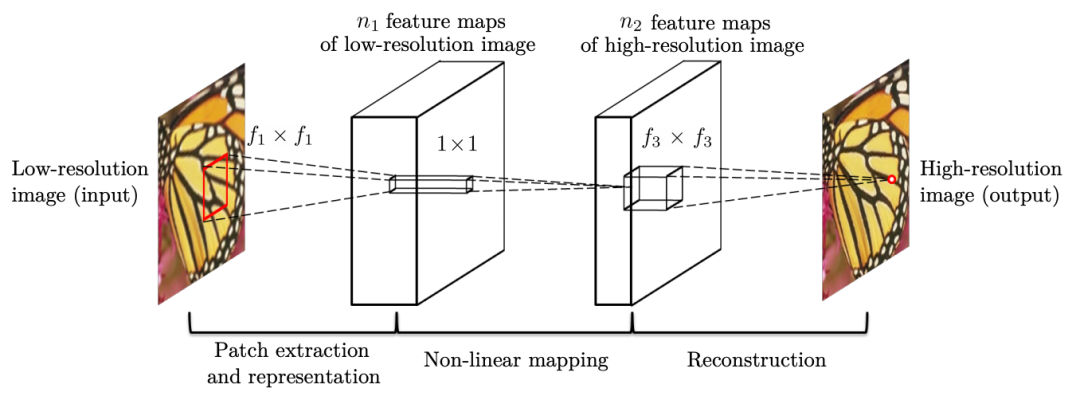

本文為你介紹基于插值、重建、學(xué)習(xí)的三大 SR 研究方法。

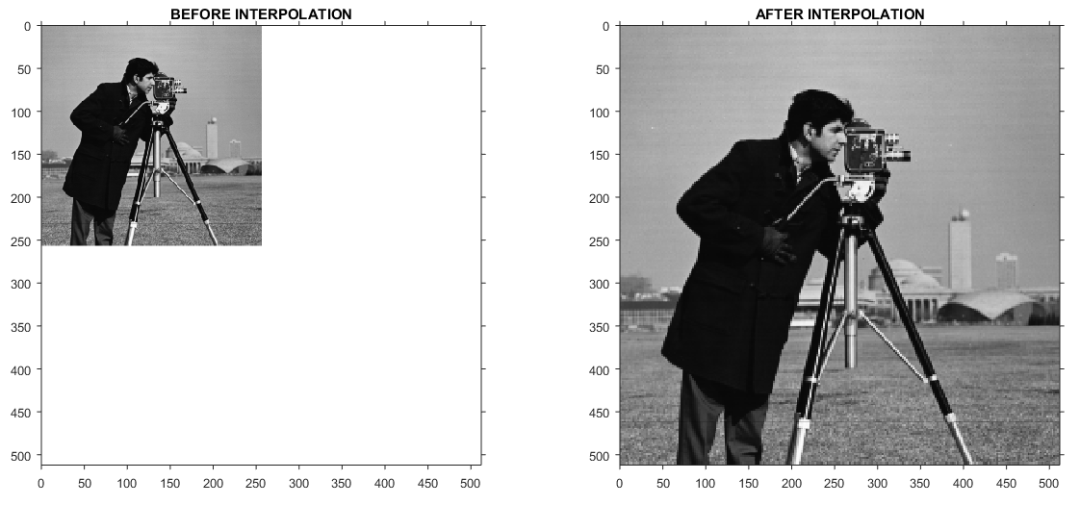

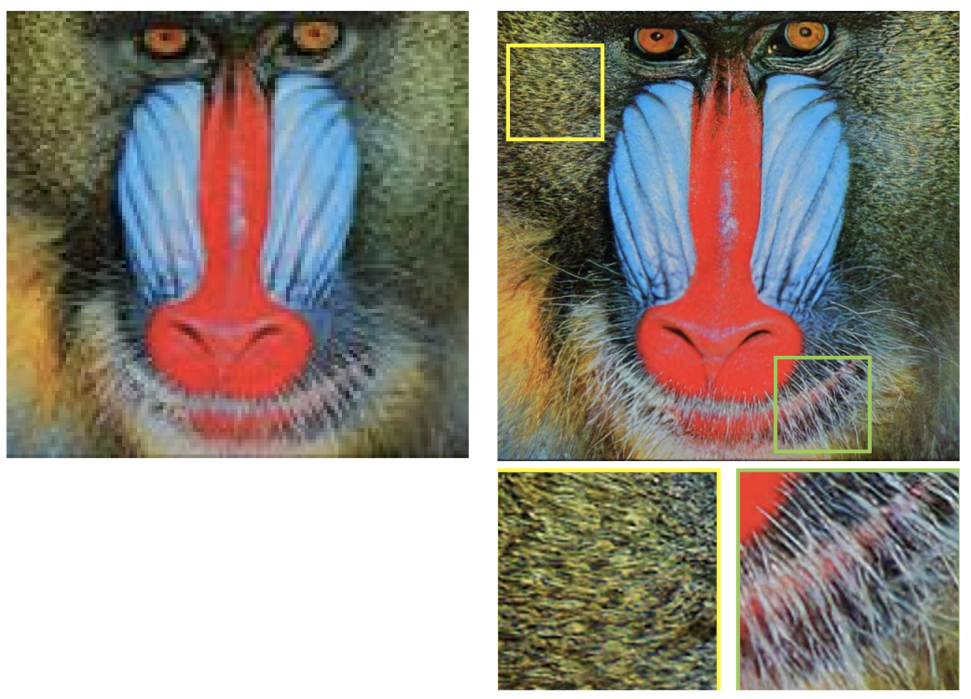

內(nèi)容一覽:通過硬件或軟件方法,提高原有圖像的分辨率,讓模糊圖像秒變清晰,就是超分辨率。隨著深度學(xué)習(xí)技術(shù)的發(fā)展,圖像超分辨率技術(shù)在游戲、電影、醫(yī)療影像等領(lǐng)域的應(yīng)用,也愈發(fā)廣泛。

將圖像或影片從低分辨率轉(zhuǎn)化為高分辨率,恢復(fù)或補(bǔ)足丟失的細(xì)節(jié)(即高頻信息),往往需要用到超分辨率技術(shù)。

根據(jù)所用低分辨率圖像的數(shù)量,超分辨率技術(shù)可分為單幅圖像的超分辨率 (SISR) 和多幅圖像的超分辨率 (MISR)。

SISR 利用一張低分辨率圖像,達(dá)到圖像尺寸增大或像素的增加的效果,從而獲得一張高分辨率圖像。

MISR 則是借助同一場景中的多張低分辨率圖像,獲取不同細(xì)節(jié)信息,合成一張或多張高分辨率圖像。MISR 的輸出既可以是單幅圖像,也可以是一個(gè)圖像系列(即視頻)。

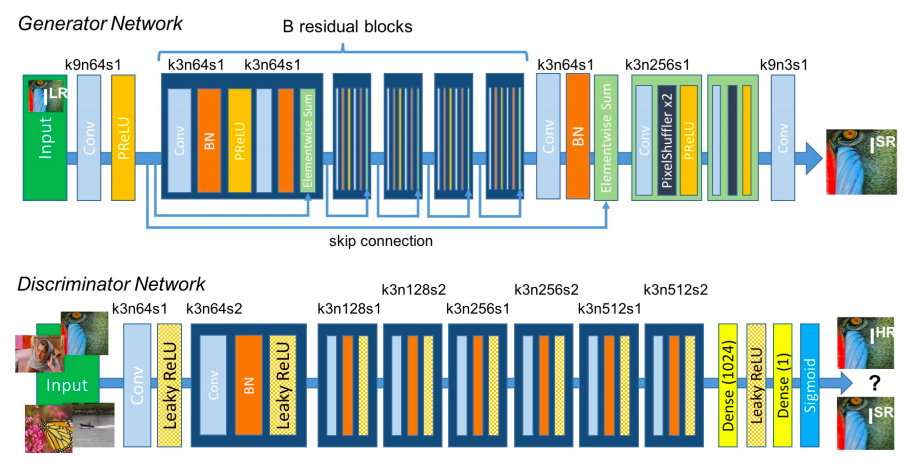

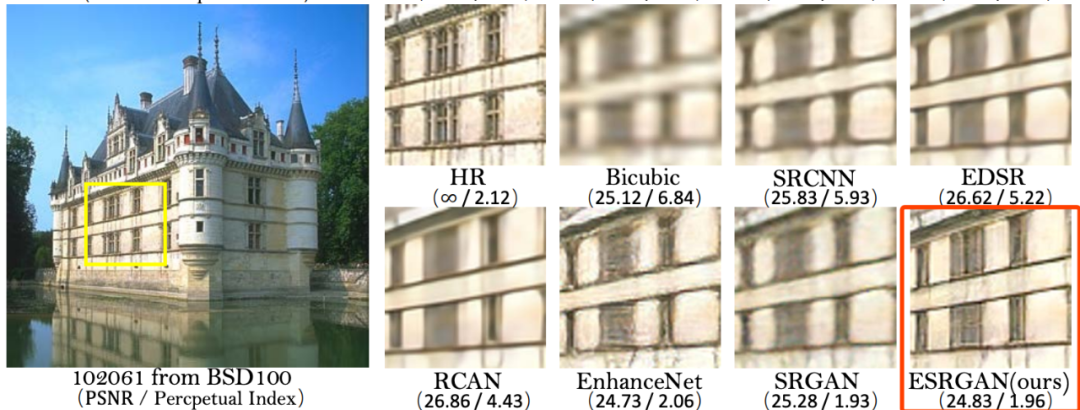

引入容量更大、更易于訓(xùn)練的 Residual-in- Residual Dense Block (RRDB) 來改善網(wǎng)絡(luò)結(jié)構(gòu),刪除 BN (Batch Normalization) 層,用 residual scaling 和 smaller initialization 來改善深度網(wǎng)絡(luò)的訓(xùn)練;

用 RaGAN 改進(jìn)判別器,預(yù)測高分辨率圖像跟原始圖像之間的相對真實(shí)性而不是絕對值,從而使得生成器恢復(fù)原始圖像更真實(shí)的紋理細(xì)節(jié);

改進(jìn)感知損失,把先前 SRGAN 中激活后的 VGG features 改為激活前執(zhí)行,提高輸出圖像的邊緣清晰度和紋理真實(shí)性。

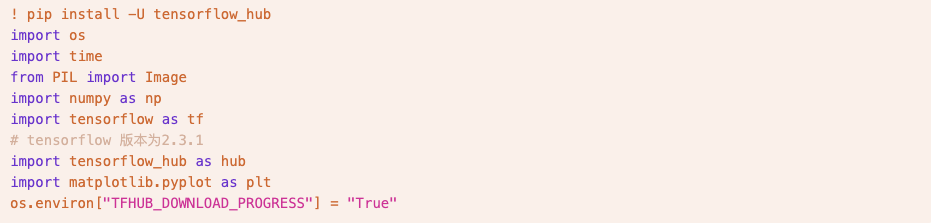

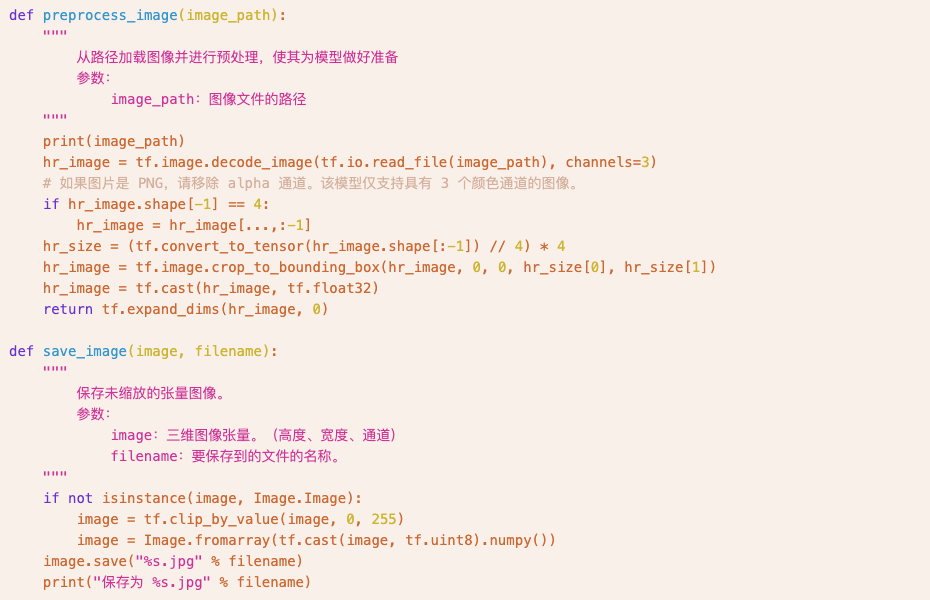

快速上手 ESRGAN

開源協(xié)議:Apache License 2.0

安裝環(huán)境:Python 3.6,TensorFlow 2.3.1

使用說明:該模型使用 DIV2K 數(shù)據(jù)集(雙三次降采樣的圖像)中,大小為 128 x 128 的圖像快進(jìn)行訓(xùn)練

注意事項(xiàng):運(yùn)行教程請使用「使用ESRGAN進(jìn)行圖像超分辨率重建.ipynb」,按順序運(yùn)行 cell 即可;目錄中 model 文件夾下為模型文件,esrgan-tf2_1.tar.gz 文件為模型壓縮包(本教程運(yùn)行中未使用壓縮包)

現(xiàn)在訪問 openbayes.com 并注冊

即可享用

600 分鐘/周的 vGPU

以及 300 分鐘/周 的 CPU 免費(fèi)計(jì)算時(shí)