文末送書|可能是最全的反爬蟲及應(yīng)對方案

點擊上方“一行數(shù)據(jù)”,選擇“置頂星標(biāo)”公眾號

干貨福利,第一時間送達

爬蟲是 Python 的一個常見應(yīng)用場景,很多練習(xí)項目就是讓大家去爬某某網(wǎng)站。爬取網(wǎng)頁的時候,你大概率會碰到一些反爬措施。這種情況下,你該如何應(yīng)對呢?本文梳理了常見的反爬措施和應(yīng)對方案。

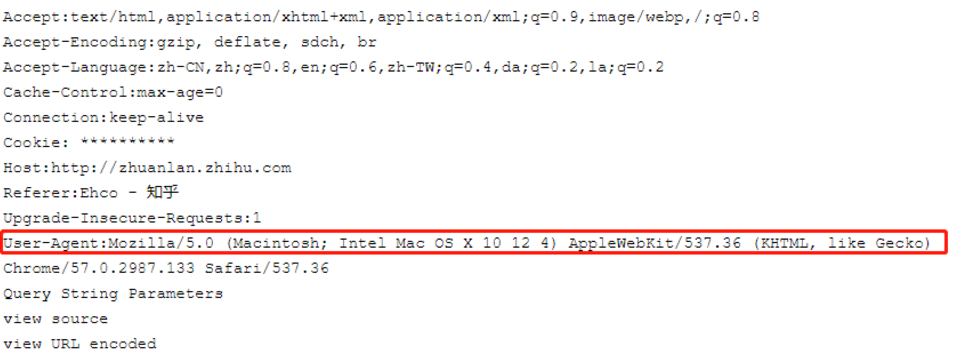

一、通過User-Agent來控制訪問

無論是瀏覽器還是爬蟲程序,在向服務(wù)器發(fā)起網(wǎng)絡(luò)請求的時候,都會發(fā)過去一個頭文件:headers,比如知乎的requests headers

這里面的大多數(shù)的字段都是瀏覽器向服務(wù)表明身份用的

對于爬蟲程序來說,最需要注意的字段就是:User-Agent

很多網(wǎng)站都會建立user-agent白名單,只有屬于正常范圍的user-agent才能夠正常訪問。

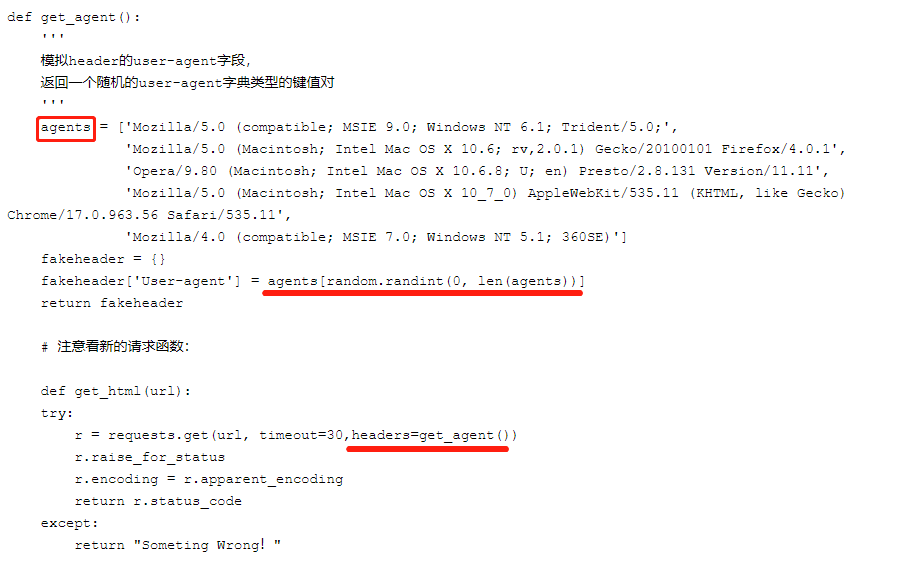

解決方法:

可以自己設(shè)置一下user-agent,或者更好的是,可以從一系列的user-agent里隨機挑出一個符合標(biāo)準的使用。

實現(xiàn)難度:★

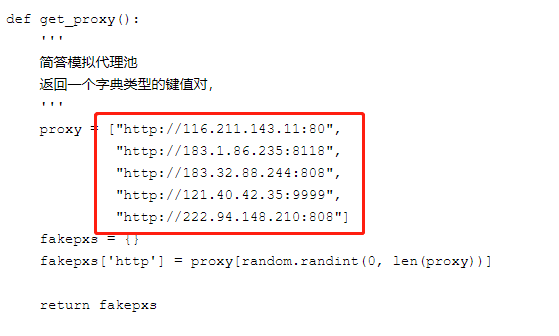

二、IP限制

如果一個固定的ip在短暫的時間內(nèi),快速大量的訪問一個網(wǎng)站,后臺管理員可以編寫IP限制,不讓該IP繼續(xù)訪問。

解決方法:

比較成熟的方式是:IP代理池

簡單的說,就是通過ip代理,從不同的ip進行訪問,這樣就不會被封掉ip了。

可是ip代理的獲取本身就是一個很麻煩的事情,網(wǎng)上有免費和付費的,但是質(zhì)量都層次不齊。如果是企業(yè)里需要的話,可以通過自己購買集群云服務(wù)來自建代理池。

實現(xiàn)難度:★

三、SESSION訪問限制

后臺統(tǒng)計登錄用戶的操作,比如短時間的點擊事件,請求數(shù)據(jù)事件,與正常值比對,用于區(qū)分用戶是否處理異常狀態(tài),如果是,則限制登錄用戶操作權(quán)限。

缺點:

需要增加數(shù)據(jù)埋點功能,閾值設(shè)置不好,容易造成誤操作。

解決方法:

注冊多個賬號、模擬正常操作。

實現(xiàn)難度:★★★

四、Spider Trap

蜘蛛陷阱導(dǎo)致網(wǎng)絡(luò)爬蟲進入無限循環(huán)之類的東西,這會浪費蜘蛛的資源,降低其生產(chǎn)力,并且在編寫得不好的爬蟲的情況下,可能導(dǎo)致程序崩潰。禮貌蜘蛛在不同主機之間交替請求,并且不會每隔幾秒鐘從同一服務(wù)器請求多次文檔,這意味著“禮貌”網(wǎng)絡(luò)爬蟲比“不禮貌”爬蟲的影響程度要小得多。

反爬方式:

創(chuàng)建無限深度的目錄結(jié)構(gòu) ? ? ? ? ? ?HTTP://example.com/bar/foo/bar/foo/bar/foo/bar / 動態(tài)頁面,為網(wǎng)絡(luò)爬蟲生成無限數(shù)量的文檔。如由算法生成雜亂的文章頁面。 文檔中填充了大量字符,使解析文檔的詞法分析器崩潰。

此外,帶蜘蛛陷阱的網(wǎng)站通常都有robots.txt告訴機器人不要進入陷阱,因此合法的“禮貌”機器人不會陷入陷阱,而忽視robots.txt設(shè)置的“不禮貌”機器人會受到陷阱的影響。

解決方法:

把網(wǎng)頁按照所引用的css文件進行聚類,通過控制類里最大能包含的網(wǎng)頁數(shù)量防止爬蟲進入trap后出不來,對不含css的網(wǎng)頁會給一個penalty,限制它能產(chǎn)生的鏈接數(shù)量。這個辦法理論上不保證能避免爬蟲陷入死循環(huán),但是實際上這個方案工作得挺好,因為絕大多數(shù)網(wǎng)頁都使用了css,動態(tài)網(wǎng)頁更是如此。

缺點:

反爬方式1,2會增加很多無用目錄或文件,造成資源浪費,也對正常的SEO十分不友好,可能會被懲罰。

實現(xiàn)難度:★★★

五、驗證碼

驗證碼是一種區(qū)分用戶是計算機還是人的公共全自動程序。可以防止:惡意破解密碼、刷票、論壇灌水,有效防止某個黑客對某一個特定注冊用戶用特定程序暴力破解方式進行不斷的登陸嘗試,實際上用驗證碼是現(xiàn)在很多網(wǎng)站通行的方式.

1. 圖片驗證碼

復(fù)雜型

打碼平臺雇傭了人力,專門幫人識別驗證碼。識別完把結(jié)果傳回去。總共的過程用不了幾秒時間。這樣的打碼平臺還有記憶功能。圖片被識別為“鍋鏟”之后,那么下次這張圖片再出現(xiàn)的時候,系統(tǒng)就直接判斷它是“鍋鏟”。時間一長,圖片驗證碼服務(wù)器里的圖片就被標(biāo)記完了,機器就能自動識別了。

簡單型

上面兩個不用處理直接可以用OCR識別技術(shù)(利用python第三方庫--esserocr)來識別。

背景比較糊

清晰可見

經(jīng)過灰度變換和二值化后,由模糊的驗證碼背景變成清晰可見的驗證碼。

容易迷惑人的圖片驗證碼

對于在這種驗證碼,語言一般自帶圖形庫,添加上扭曲就成了這個樣子,我們可以利用9萬張圖片進行訓(xùn)練,完成類似人的精準度,到達識別驗證碼的效果

2. 短信驗證碼

用ebbrowser術(shù),模擬用戶打開短信的行為,最終獲取短信驗證碼。

3. 計算題圖片驗證碼

把所有可能出現(xiàn)的漢字都人工取出來,保存為黑白圖片,把驗證碼按照字體顏色二值化,去除噪點,然后將所有圖片依次與之進行像素對比,計算出相似值,找到最像的那張圖片

4. 滑動驗證碼

對于滑動驗證碼

我們可以利用圖片的像素作為線索,確定好基本屬性值,查看位置的差值,對于差值超過基本屬性值,我們就可以確定圖片的大概位置。

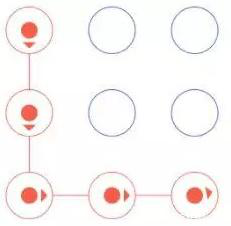

5. 圖案驗證碼

對于這種每次拖動的順序不一樣,結(jié)果就不一樣,我們怎么做來識別呢?

利用機器學(xué)習(xí)所有的拖動順序,利用1萬張圖片進行訓(xùn)練,完成類似人的操作,最終將其識別 利用selenium技術(shù)來模擬人的拖動順序,窮盡所有拖動方式,這樣達到是別的效果

6. 標(biāo)記倒立文字驗證碼

我們不妨分析下:對于漢字而言,有中華五千年龐大的文字庫,加上文字的不同字體、文字的扭曲和噪點,難度更大了。

方法:首先點擊前兩個倒立的文字,可確定7個文字的坐標(biāo), 驗證碼中7個漢字的位置是確定的,只需要提前確認每個字所在的坐標(biāo)并將其放入列表中,然后人工確定倒立文字的文字序號,將列表中序號對應(yīng)的坐標(biāo)即可實現(xiàn)成功登錄。

解決方法:

接入第三方驗證碼平臺,實時破解網(wǎng)站的驗證碼。

缺點:

影響正常的用戶體驗操作,驗證碼越復(fù)雜,網(wǎng)站體驗感越差。

實現(xiàn)難度:★★

七、通過robots.txt來限制爬蟲

robots.txt(統(tǒng)一小寫)是一種存放于網(wǎng)站根目錄下的ASCII編碼的文本文件,它通常告訴網(wǎng)絡(luò)搜索引擎的漫游器(又稱網(wǎng)絡(luò)蜘蛛),此網(wǎng)站中的哪些內(nèi)容是不應(yīng)被搜索引擎的漫游器獲取的,哪些是可以被漫游器獲取的。

robots.txt協(xié)議并不是一個規(guī)范,而只是約定俗成的,所以并不能保證網(wǎng)站的隱私。注意robots.txt是用字符串比較來確定是否獲取URL,所以目錄末尾有與沒有斜杠“/”表示的是不同的URL。

缺點:

只是一個君子協(xié)議,對于良好的爬蟲比如搜索引擎有效果,對于有目的性的爬蟲不起作用

解決方法:

如果使用scrapy框架,只需將settings文件里的ROBOTSTXT_OBEY設(shè)置值為 False

實現(xiàn)難度:★

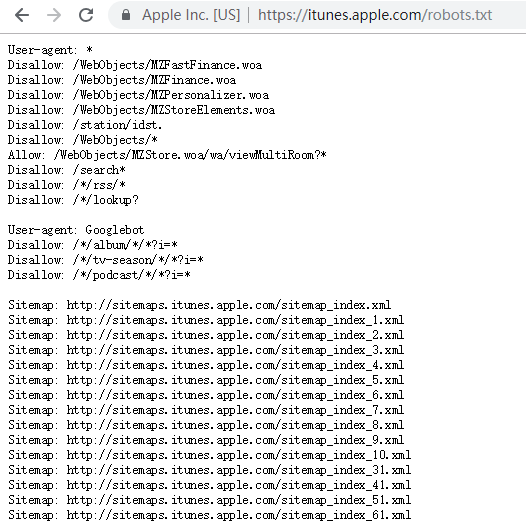

八、數(shù)據(jù)動態(tài)加載

python的requests庫只能爬取靜態(tài)頁面,爬取不了動態(tài)加載的頁面。使用JS加載數(shù)據(jù)方式,能提高爬蟲門檻。

解決方法:

抓包獲取數(shù)據(jù)url

通過抓包方式可以獲取數(shù)據(jù)的請求url,再通過分析和更改url參數(shù)來進行數(shù)據(jù)的抓取。

示例:

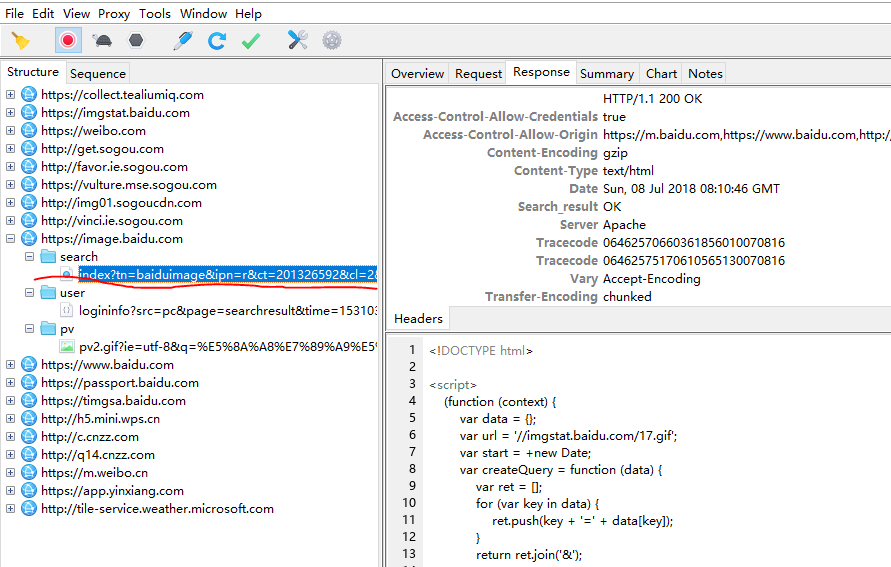

看 https://image.baidu.com這部分的包。可以看到,這部分包里面,search下面的那個 url和我們訪問的地址完全是一樣的,但是它的response卻包含了js代碼。

當(dāng)在動物圖片首頁往下滑動頁面,想看到更多的時候,更多的包出現(xiàn)了。從圖片可以看到,下滑頁面后得到的是一連串 json數(shù)據(jù)。在data里面,可以看到thumbURL等字樣。它的值是一個url。這個就是圖片的鏈接。

打開一個瀏覽器頁面,訪問

thumbURL="https://ss1.bdstatic.com/70cFvXSh_Q1YnxGkpoWK1HF6hhy/it/u=1968180540,4118301545&fm=27&gp=0.jpg"發(fā)現(xiàn)搜索結(jié)果里的圖片。根據(jù)前面的分析,就可以知道,請求

URL="https://image.baidu.com/search/acjsontn=resultjson_com&ipn=rj&ct=201326592&is=&fp=result&queryWord=%E5%8A%A8%E7%89%A9%E5%9B%BE%E7%89%87&cl=2&lm=-1&ie=utf8&oe=utf8&adpicid=&st=-1&z=&ic=0&word=%E5%8A%A8%E7%89%A9%E5%9B%BE%E7%89%87&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&pn=30&rn=30&gsm=1e&1531038037275="

用瀏覽器訪問這個鏈接確定他是公開的。

最后就可以尋找URL的規(guī)律,對URL進行構(gòu)造便可獲取所有照片。

使用selenium

通過使用selenium來實現(xiàn)模擬用戶操作瀏覽器,然后結(jié)合BeautifulSoup等包來解析網(wǎng)頁通過這種方法獲取數(shù)據(jù),簡單,也比較直觀,缺點是速度比較慢。

缺點:

如果數(shù)據(jù)API沒做加密處理,容易曝光接口,讓爬蟲用戶更容易獲取數(shù)據(jù)。

實現(xiàn)難度:★

九、數(shù)據(jù)加密-使用加密算法

前端加密

通過對查詢參數(shù)、user-agent、驗證碼、cookie等前端數(shù)據(jù)進行加密生成一串加密指令,將加密指令作為參數(shù),再進行服務(wù)器數(shù)據(jù)請求。該加密參數(shù)為空或者錯誤,服務(wù)器都不對請求進行響應(yīng)。

服務(wù)器端加密

在服務(wù)器端同樣有一段加密邏輯,生成一串編碼,與請求的編碼進行匹配,匹配通過則會返回數(shù)據(jù)。

解決方法:

JS加密破解方式,就是要找到JS的加密代碼,然后使用第三方庫js2py在Python中運行JS代碼,從而得到相應(yīng)的編碼。

案例參考:

https://blog.csdn.net/lsh19950928/article/details/81585881

缺點:

加密算法明文寫在JS里,爬蟲用戶還是可以分析出來。

實現(xiàn)難度:★★★

十、數(shù)據(jù)加密-使用字體文件映射

服務(wù)器端根據(jù)字體映射文件先將客戶端查詢的數(shù)據(jù)進行變換再傳回前端,前端根據(jù)字體文件進行逆向解密。

映射方式可以是數(shù)字亂序顯示,這樣爬蟲可以爬取數(shù)據(jù),但是數(shù)據(jù)是錯誤的。

破解方式:

其實,如果能看懂JS代碼,這樣的方式還是很容易破解的,所以需要做以下幾個操作來加大破解難度。

對JS加密 使用多個不同的字體文件,然后約定使用指定字體文件方式,比如時間戳取模,這樣每次爬取到的數(shù)據(jù)映射方式都不一樣,映射結(jié)果就不一樣,極大提高了破解的難度。

該種方式相比使用加密算法方式難度更高,因為加密算法是固定的幾種,對方很容易獲取并破解,而字體文件映射可以按任意規(guī)則映射,正常的數(shù)據(jù)使之錯誤顯示,爬蟲不容易察覺。

參考案例:https://www.jianshu.com/p/f79d8e674768

缺點:

需要生成字體文件,增加網(wǎng)站加載資源的體量。

實現(xiàn)難度:★★★★

非可視區(qū)域遮擋

此方式主要針對使用senlium進行的爬蟲,如果模擬界面未進入可視區(qū)域,則對未見數(shù)據(jù)進行遮擋,防止senlium的click()操作。這種方式只能稍稍降低爬蟲的爬取速度,并不能阻止繼續(xù)進行數(shù)據(jù)爬取。

實現(xiàn)難度:★

來源:編程派

安利一本?:《Python 3.x網(wǎng)絡(luò)爬蟲從零基礎(chǔ)到項目實戰(zhàn)》此書包含10大核心技術(shù)+1個高級框架+32個經(jīng)典實例,還原爬蟲開發(fā)中的每一步細節(jié),教你輕松學(xué)會Python爬蟲開發(fā)及高級技術(shù)。點擊下圖可看詳情/購買!?

周六發(fā)文前,留言積攢前兩名送這本書!對,就這么簡單

推薦閱讀

(點擊標(biāo)題可跳轉(zhuǎn)閱讀)

周六發(fā)文前,留言積攢前兩名送這本書!對,就這么簡單

周六發(fā)文前,留言積攢前兩名送這本書!對,就這么簡單

周六發(fā)文前,留言積攢前兩名送這本書!對,就這么簡單

不過得先加上一行好友(微信:data_ecology)哦