使用有限的數(shù)據(jù)來訓練GANs

點擊上方“程序員大白”,選擇“星標”公眾號

重磅干貨,第一時間送達

作者:Mayank Agarwal

編譯:ronghuaiyang

使用自適應增強判別器(ADA)來訓練StyleGAN2。

生成對抗網(wǎng)絡(GANs)的長期挑戰(zhàn)之一是在很少數(shù)據(jù)的情況下訓練它。小數(shù)據(jù)集的關鍵問題是識別器對訓練樣本的快速過擬合。鑒別器的工作是將其輸入分類為假的或真的,但由于過擬合,它把除了訓練數(shù)據(jù)集以外的所有東西都作為是假的。結果,生成器收到的反饋很少,無法改進它的生成,訓練失敗。在本文中,我們討論了Karras等人的最近的工作,通過自適應鑒別器增強來解決這個問題。

在深度學習的幾乎所有領域,數(shù)據(jù)增強是防止過擬合的標準解決方案。例如,在旋轉、噪聲、模糊等條件下訓練圖像分類器,會導致在失真情況下這些語義保持不變性增加 —— 這是分類器非常需要的品質。然而,這并不能直接用于訓練GANs,因為生成器將學習如何生成增強后的分布。這種對生成的樣本的增強的“泄漏”是非常不可取的。

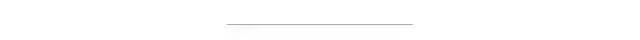

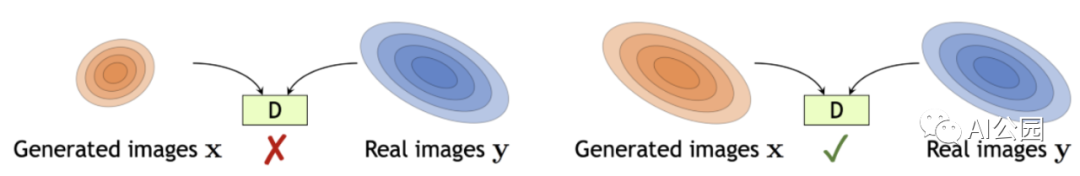

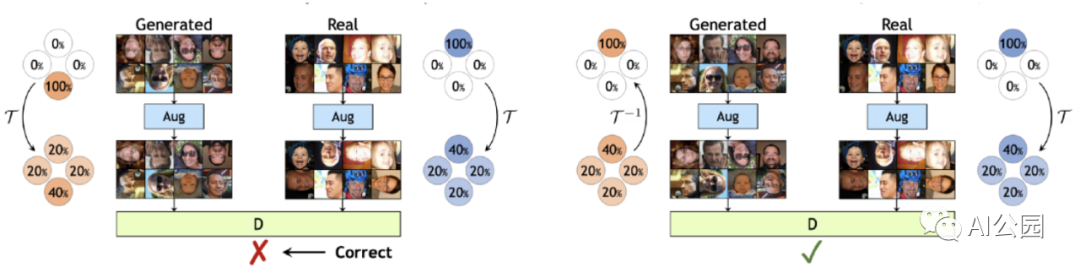

為了克服這種“泄漏”問題,作者提出了一種稱為隨機鑒別器增強的增強技術。他們只使用增強圖像來評估鑒別器,并且在訓練生成器時也這樣做。鑒別器增強相當于在鑒別器上戴上失真鏡,并要求生成器生成的圖在通過失真鏡觀察時無法與訓練集樣本區(qū)分。

然而,這種方法只有在這種扭曲可以用數(shù)據(jù)空間上的概率分布的“可逆”變換來表示時才有效。重要的是要理解,這并不意味著在單個圖像上執(zhí)行的增強就必須是可逆的。例如,從概率分布的意義上講,將輸入圖像的90%置為零這樣極端的增強是可逆的,即使對人類來說,通過忽略黑色圖像直到只剩下10%的圖像,來推斷原始分布是很容易的。

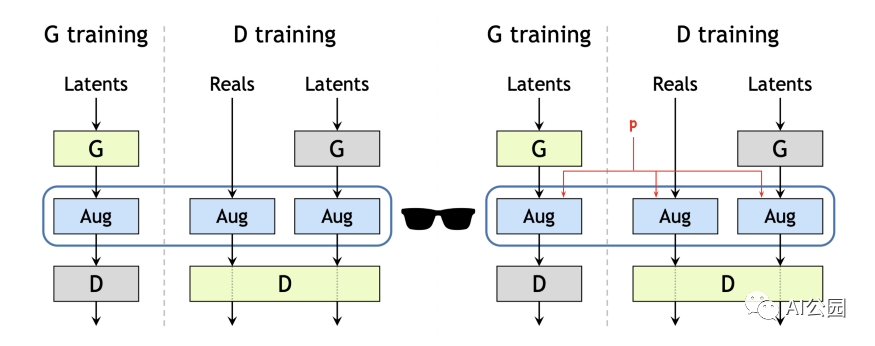

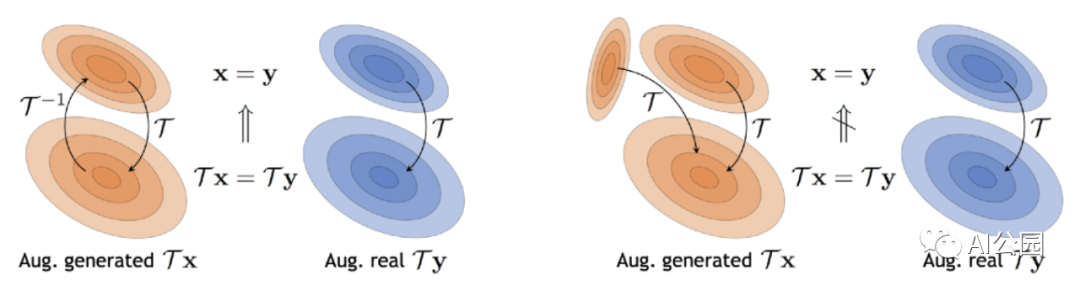

讓我們借用文中的另一個例子來直觀地理解可逆變換。從{0,90,180,270}度均勻選擇的隨機旋轉是不可逆的(圖4):增強后無法辨別方向的差異。這里,生成器可以自由地生成上下顛倒的圖像,因為在增強分布中,{0,90,180,270}度的相對位置是相同的。因此,盡管生成器學會了匹配增強的分布Tx和Ty,但匹配虛假和真實數(shù)據(jù)分布x和y的潛在目標仍然沒有得到解決。

如果這個旋轉僅以概率p<1進行(圖2,右):這增加了0度的出現(xiàn)率,現(xiàn)在只有生成的圖像有正確的方向時,增強分布才能匹配(圖5)。現(xiàn)在,當生成器試圖生成顛倒的圖像時,增強分布不再一致。因此,為了匹配轉換后的分布Tx和Ty,生成器被迫匹配假分布x和真實分布y。

更一般地說,如果我們對生成的分布x和真實的分布y應用一個可逆變換T,那么為了匹配原始分布x和y,匹配增強分布Tx和Ty就足夠了(圖6)。

理論上,如果增強操作T是可逆的,存在一個且只有一個增強分布Tx, 而且x不應該有“泄漏”。然而,在實踐中,由于有限的樣本的局限性,有限的網(wǎng)絡表示能力,歸納偏差和訓練動態(tài),很高的p值導致了生成圖像的增強的泄漏。作者還表明,p的最優(yōu)值對數(shù)據(jù)集大小非常敏感。他們通過使過程自適應來解決對p進行昂貴的網(wǎng)格搜索的問題。在深入細節(jié)之前,讓我們先了解如何在GANs中度量過擬合。

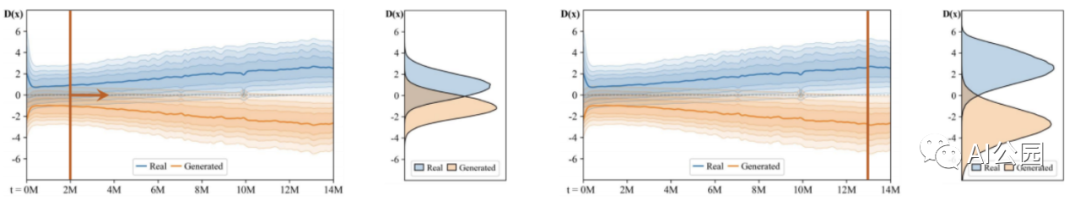

不同大小的數(shù)據(jù)集,在每種情況下訓練開始以同樣的方式,但最終優(yōu)化停止了,并且FID開始上升(圖8)。同時,開始的時候,鑒別器輸出分布的和生成的圖像重疊,但隨著鑒別器(圖7)變得越來越自信,這兩個分布變得漸行漸遠,并且,從FID開始惡化的點開始,隨著分布的充分重疊,loss開始變得恒定。

量化過擬合的標準方法是使用一個單獨的驗證集,并觀察其相對于訓練集的行為。當過擬合開始時,驗證集的行為開始越來越像生成的圖像,而真實樣本和生成樣本的鑒別器輸出開始發(fā)散。從圖8可以看出,對于較小的數(shù)據(jù)集,這種情況發(fā)生得更早。

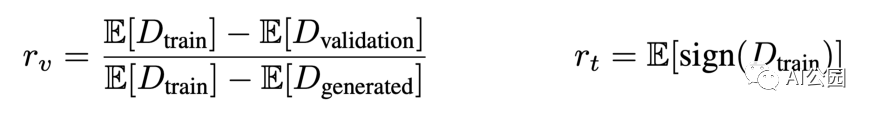

作者提出了兩種似是而非的過擬合啟發(fā)式方法來度量過擬合(圖9)。第一個是啟發(fā)式的r*v,*表示了驗證集相對于訓練集和生成的圖像的輸出。當訓練集和驗證集表現(xiàn)完全相同時,分子為0,因此r=0表示沒有過擬合。當生成的和驗證集行為完全相同時,分子和分母是相同的,因此r=1表示完全過擬合。

因為它假設在一個已經(jīng)很小的數(shù)據(jù)集中存在一個單獨的驗證集,所以不可能計算rv啟發(fā)式。因此,作者轉向rt,它使用訓練集的鑒別器預測為正的部分來識別過擬合,并隨著訓練的進展動態(tài)調整增強概率p:

rt太高→增加更多(增加p) rt過低→增加更少(減少p)

總之,作者提出了一種即插即用技術,通過引入一個應用增強的概率p來將不可逆轉的圖像增強轉換為可逆變換。它們還提供了一種機制來自適應地調整這些增強,以改善GAN訓練過程到最優(yōu)狀態(tài)。想要了解更多細節(jié),我強烈推薦閱讀原文。

英文原文:https://medium.com/swlh/training-gans-with-limited-data-22a7c8ffce78

推薦閱讀

國產(chǎn)小眾瀏覽器因屏蔽視頻廣告,被索賠100萬(后續(xù))

年輕人“不講武德”:因看黃片上癮,把網(wǎng)站和786名女主播起訴了

關于程序員大白

程序員大白是一群哈工大,東北大學,西湖大學和上海交通大學的碩士博士運營維護的號,大家樂于分享高質量文章,喜歡總結知識,歡迎關注[程序員大白],大家一起學習進步!