一文"看透"多任務(wù)學(xué)習(xí)

極市導(dǎo)讀

如何判定是不是多任務(wù)學(xué)習(xí)?為什么多任務(wù)學(xué)習(xí)會有效?本文圍繞多任務(wù)學(xué)習(xí)這一主題進(jìn)行了詳細(xì)的闡述。 >>加入極市CV技術(shù)交流群,走在計算機視覺的最前沿

大家在做模型的時候,往往關(guān)注一個特定指標(biāo)的優(yōu)化,如做點擊率模型,就優(yōu)化AUC,做二分類模型,就優(yōu)化f-score。然而,這樣忽視了模型通過學(xué)習(xí)其他任務(wù)所能帶來的信息增益和效果上的提升。通過在不同的任務(wù)中共享向量表達(dá),我們能夠讓模型在各個任務(wù)上的泛化效果大大提升。這個方法就是我們今天要談?wù)摰闹黝}-多任務(wù)學(xué)習(xí)(MTL)。

所以如何判定是不是多任務(wù)學(xué)習(xí)呢?不需要看模型結(jié)構(gòu)全貌,只需要看下loss函數(shù)即可,如果loss包含很多項,每一項都是不同目標(biāo),這個模型就是在多任務(wù)學(xué)習(xí)了。有時,雖然你的模型僅僅是優(yōu)化一個目標(biāo),同樣可以通過多任務(wù)學(xué)習(xí),提升該模型的泛化效果。比如點擊率模型,我們可以通過添加轉(zhuǎn)化樣本,構(gòu)建輔助loss(預(yù)估轉(zhuǎn)化率),從而提升點擊率模型的泛化性。

為什么多任務(wù)學(xué)習(xí)會有效?舉個例子,一個模型已經(jīng)學(xué)會了區(qū)分顏色,如果直接把這個模型用于蔬菜和肉類的分類任務(wù)呢?模型很容易學(xué)到綠色的是蔬菜,其他更大概率是肉。正則化算不算多任務(wù)?正則化的優(yōu)化的loss不僅有本身的回歸/分類產(chǎn)生的loss,還有l(wèi)1/l2產(chǎn)生的loss,因為我們認(rèn)為"正確且不過擬合"的模型的參數(shù)應(yīng)該稀疏,且不易過大,要把這種假設(shè)注入到模型中去學(xué)習(xí),就產(chǎn)生了正則化項,本質(zhì)也是一個額外的任務(wù)。

MTL兩個方法

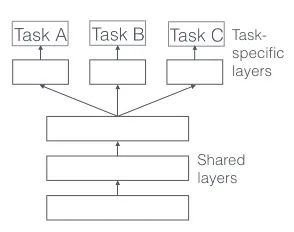

第一種是hard parameter sharing,如下圖所示:

比較簡單,前幾層dnn為各個任務(wù)共享,后面分離出不同任務(wù)的layers。這種方法有效降低了過擬合的風(fēng)險: 模型同時學(xué)習(xí)的任務(wù)數(shù)越多,模型在共享層就要學(xué)到一個通用的嵌入式表達(dá)使得每個任務(wù)都表現(xiàn)較好,從而降低過擬合的風(fēng)險。

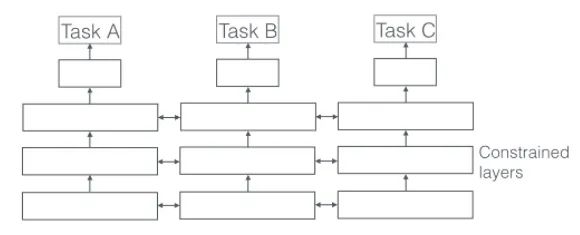

第二種是soft parameter sharing,如下圖所示:

在這種方法下,每個任務(wù)都有自己的模型,有自己的參數(shù),但是對不同模型之間的參數(shù)是有限制的,不同模型的參數(shù)之間必須相似,由此會有個distance描述參數(shù)之間的相似度,會作為額外的任務(wù)加入到模型的學(xué)習(xí)中,類似正則化項。

多任務(wù)學(xué)習(xí)能提效,主要是由于以下幾點原因:

隱式數(shù)據(jù)增強:

每個任務(wù)都有自己的樣本,使用多任務(wù)學(xué)習(xí)的話,模型的樣本量會提升很多。而且數(shù)據(jù)都會有噪聲,如果單學(xué)A任務(wù),模型會把A數(shù)據(jù)的噪聲也學(xué)進(jìn)去,如果是多任務(wù)學(xué)習(xí),模型因為要求B任務(wù)也要學(xué)習(xí)好,就會忽視掉A任務(wù)的噪聲,同理,模型學(xué)A的時候也會忽視掉B任務(wù)的噪聲,因此多任務(wù)學(xué)習(xí)可以學(xué)到一個更精確的嵌入表達(dá)。

注意力聚焦:

如果任務(wù)的數(shù)據(jù)噪聲非常多,數(shù)據(jù)很少且非常高維,模型對相關(guān)特征和非相關(guān)特征就無法區(qū)分。多任務(wù)學(xué)習(xí)可以幫助模型聚焦到有用的特征上,因為不同任務(wù)都會反應(yīng)特征與任務(wù)的相關(guān)性。

特征信息竊取:

有些特征在任務(wù)B中容易學(xué)習(xí),在任務(wù)A中較難學(xué)習(xí),主要原因是任務(wù)A與這些特征的交互更為復(fù)雜,且對于任務(wù)A來說其他特征可能會阻礙部分特征的學(xué)習(xí),因此通過多任務(wù)學(xué)習(xí),模型可以高效的學(xué)習(xí)每一個重要的特征。

表達(dá)偏差:

MTL使模型學(xué)到所有任務(wù)都偏好的向量表示。這也將有助于該模型推廣到未來的新任務(wù),因為假設(shè)空間對于足夠多的訓(xùn)練任務(wù)表現(xiàn)良好,對于學(xué)習(xí)新任務(wù)也表現(xiàn)良好。

正則化:

對于一個任務(wù)而言,其他任務(wù)的學(xué)習(xí)都會對該任務(wù)有正則化效果。

多任務(wù)深度學(xué)習(xí)模型

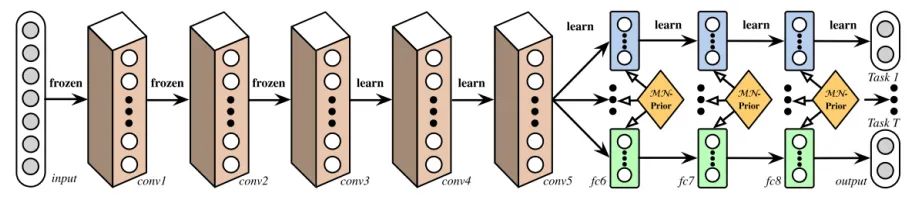

Deep Relationship Networks:從下圖,我們可以看到卷積層前幾層是預(yù)訓(xùn)練好的,后幾層是共享參數(shù)的,用于學(xué)習(xí)不同任務(wù)之間的聯(lián)系,最后獨立的dnn模塊用于學(xué)習(xí)各個任務(wù)。

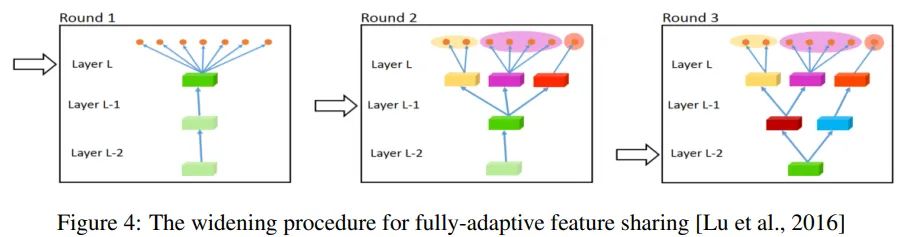

Fully-Adaptive Feature Sharing:從另一個極端開始,下圖是一種自底向上的方法,從一個簡單的網(wǎng)絡(luò)開始,并在訓(xùn)練過程中利用相似任務(wù)的分組準(zhǔn)則貪婪地動態(tài)擴展網(wǎng)絡(luò)。貪婪方法可能無法發(fā)現(xiàn)一個全局最優(yōu)的模型,而且只將每個分支分配給一個任務(wù)使得模型無法學(xué)習(xí)任務(wù)之間復(fù)雜的交互。

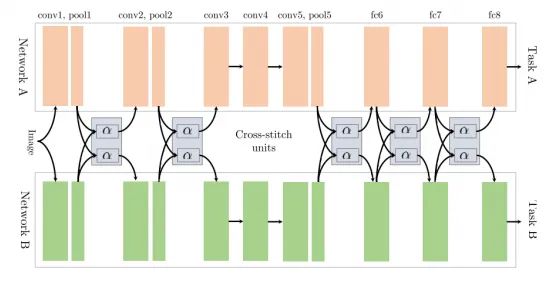

cross-stitch Networks:如上文中所談到的soft parameter sharing,該模型是兩個完全分離的模型結(jié)構(gòu),該結(jié)構(gòu)用了cross-stitch單元去讓分離的模型學(xué)到不同任務(wù)之間的關(guān)系,如下圖所示,通過在pooling層和全連接層后分別增加cross-stitch對前面學(xué)到的特征表達(dá)進(jìn)行線性融合,再輸出到后面的卷積/全連接模塊。

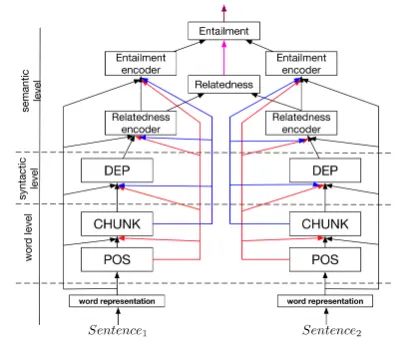

A Joint Many-Task Model:如下圖所示,預(yù)定義的層級結(jié)構(gòu)由各個NLP任務(wù)組成,低層級的結(jié)構(gòu)通過詞級別的任務(wù)學(xué)習(xí),如此行分析,組塊標(biāo)注等。中間層級的結(jié)構(gòu)通過句法分析級別的任務(wù)學(xué)習(xí),如句法依存。高層級的結(jié)構(gòu)通過語義級別的任務(wù)學(xué)習(xí)。

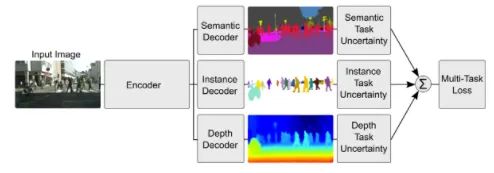

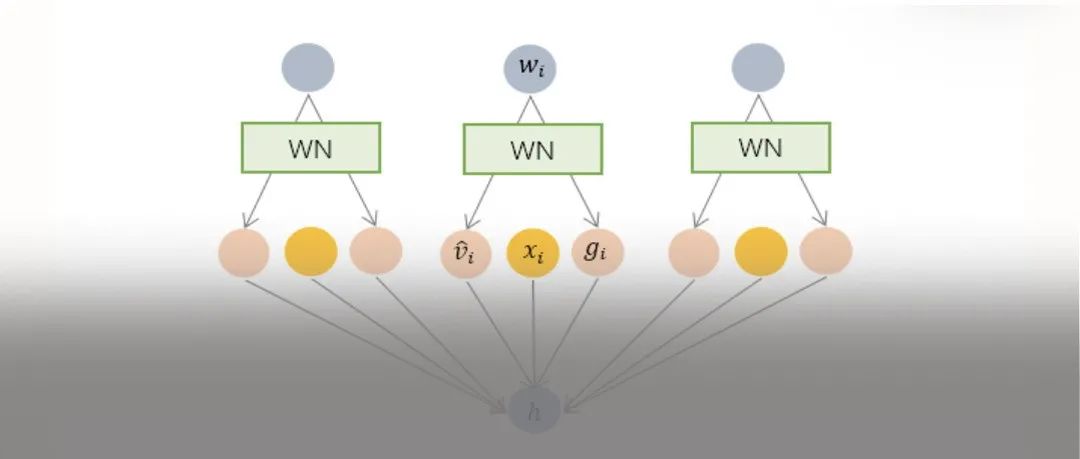

weighting losses with uncertainty:考慮到不同任務(wù)之間相關(guān)度的不確定性,基于高斯似然最大化的多任務(wù)損失函數(shù),調(diào)整每個任務(wù)在成本函數(shù)中的相對權(quán)重。結(jié)構(gòu)如下圖所示,對像素深度回歸、語義和實例分割。

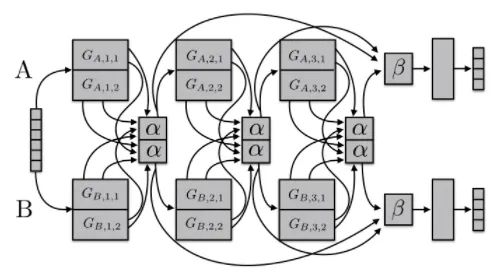

sluice networks:下圖模型概括了基于深度學(xué)習(xí)的MTL方法,如硬參數(shù)共享和cross-stitch網(wǎng)絡(luò)、塊稀疏正則化方法,以及最近創(chuàng)建任務(wù)層次結(jié)構(gòu)的NLP方法。該模型能夠?qū)W習(xí)到哪些層和子空間應(yīng)該被共享,以及網(wǎng)絡(luò)在哪些層學(xué)習(xí)了輸入序列的最佳表示。

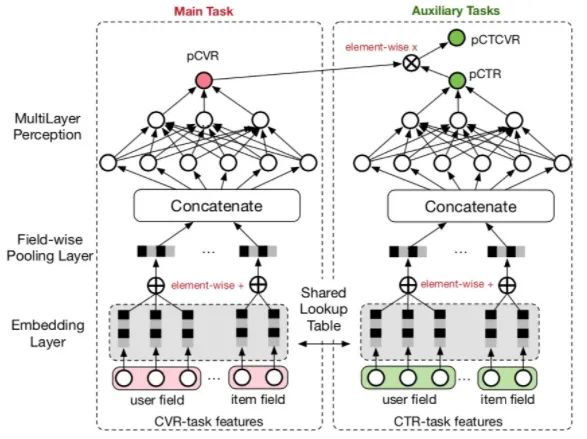

ESSM:在電商場景下,轉(zhuǎn)化是指從點擊到購買。在CVR預(yù)估時候,我們往往會遇到兩個問題:樣本偏差和數(shù)據(jù)系數(shù)問題。樣本偏差是指訓(xùn)練和測試集樣本不同,拿電商舉例,模型用點擊的數(shù)據(jù)來訓(xùn)練,而預(yù)估的卻是整個樣本空間。數(shù)據(jù)稀疏問題就更嚴(yán)重了,本身點擊樣本就很少,轉(zhuǎn)化就更少了,所以可以借鑒多任務(wù)學(xué)習(xí)的思路,引入輔助學(xué)習(xí)任務(wù),擬合pCTR和pCTCVR(pCTCVR = pCTR * pCVR),如下圖所示:

對于pCTR來說,可將有點擊行為的曝光事件作為正樣本,沒有點擊行為的曝光事件作為負(fù)樣本

對于pCTCVR來說,可將同時有點擊行為和購買行為的曝光事件作為正樣本,其他作為負(fù)樣本

對于pCVR來說,只有曝光沒有點擊的樣本中的梯度也能回傳到main task的網(wǎng)絡(luò)中

另外這兩個子網(wǎng)絡(luò)的embedding層是共享的,由于CTR任務(wù)的訓(xùn)練樣本量要遠(yuǎn)超過CVR任務(wù)的訓(xùn)練樣本量,從而能夠緩解訓(xùn)練數(shù)據(jù)稀疏性問題。

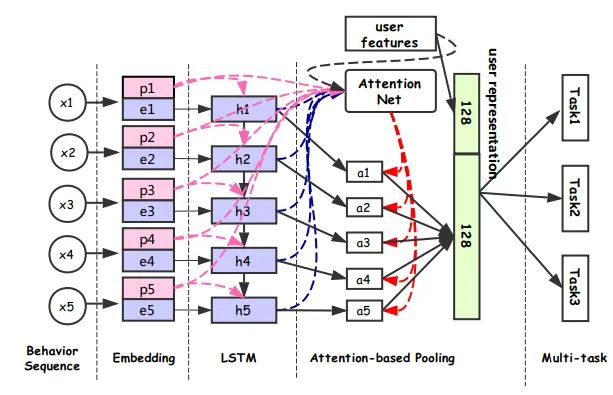

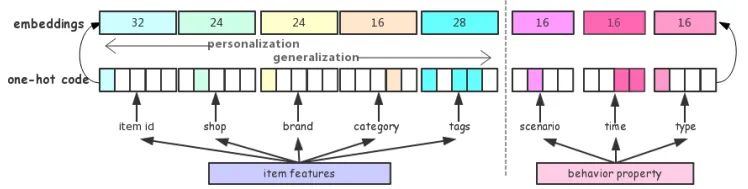

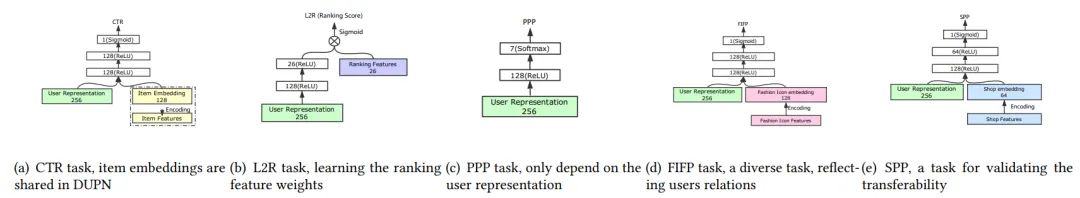

DUPN:模型分為行為序列層、Embedding層、LSTM層、Attention層、下游多任務(wù)層(CTR、LTR、時尚達(dá)人關(guān)注預(yù)估、用戶購買力度量)。如下圖所示

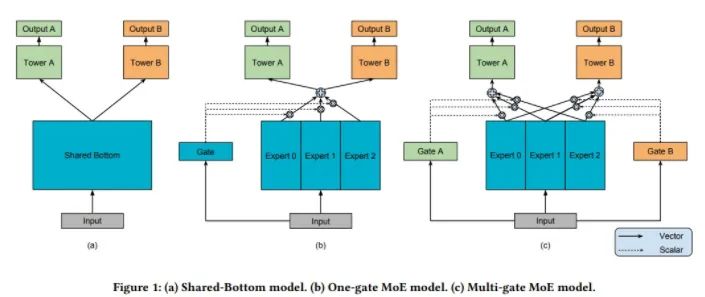

MMOE:如下圖所示,模型(a)最常見,共享了底層網(wǎng)絡(luò),上面分別接不同任務(wù)的全連接層。模型(b)認(rèn)為不同的專家可以從相同的輸入中提取出不同的特征,由一個Gate(類似) attention結(jié)構(gòu),把專家提取出的特征篩選出各個task最相關(guān)的特征,最后分別接不同任務(wù)的全連接層。MMOE的思想就是對于不同任務(wù),需要不同專家提取出的信息,因此每個任務(wù)都需要一個獨立的gate。

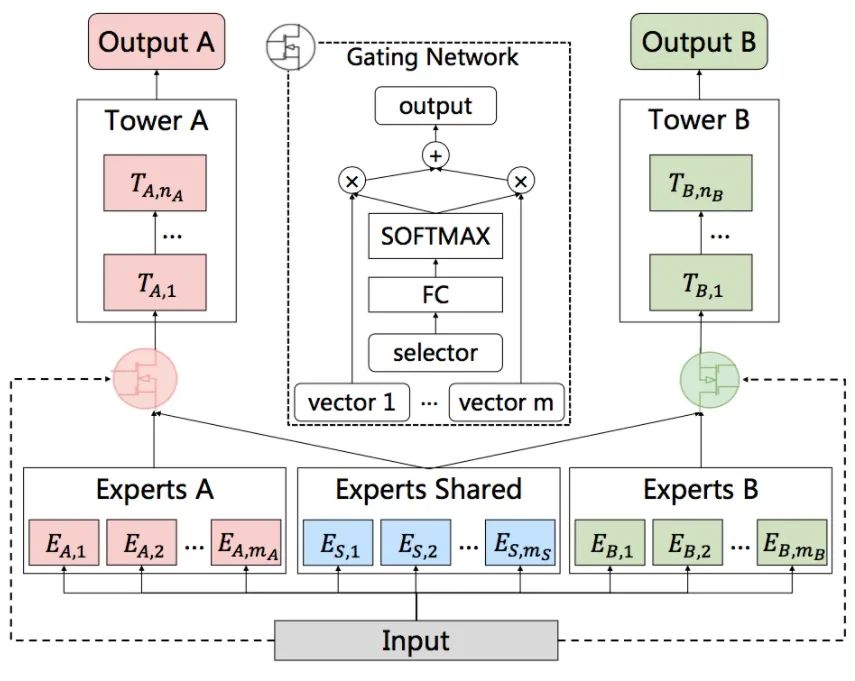

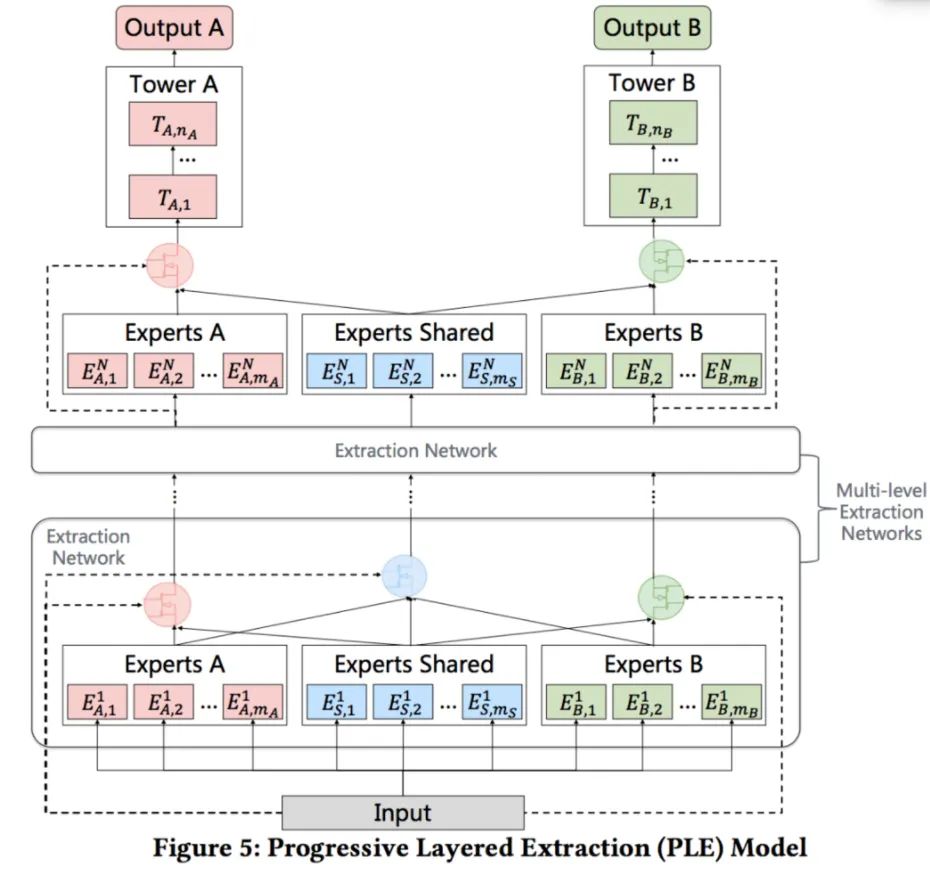

PLE:即使通過MMoE這種方式減輕負(fù)遷移現(xiàn)象,蹺蹺板現(xiàn)象仍然是廣泛存在的(蹺蹺板現(xiàn)象指多任務(wù)之間相關(guān)性不強時,信息共享就會影響模型效果,會出現(xiàn)一個任務(wù)泛化性變強,另一個變?nèi)醯默F(xiàn)象)。PLE的本質(zhì)是MMOE的改進(jìn)版本,有些expert是任務(wù)專屬,有些expert是共享的,如下圖CGC架構(gòu),對于任務(wù)A而言,通過A的gate把A的expert和共享的expert進(jìn)行融合,去學(xué)習(xí)A。

最終PLE結(jié)構(gòu)如下,融合了定制的expert和MMOE,堆疊多層CGC架構(gòu),如下所示:

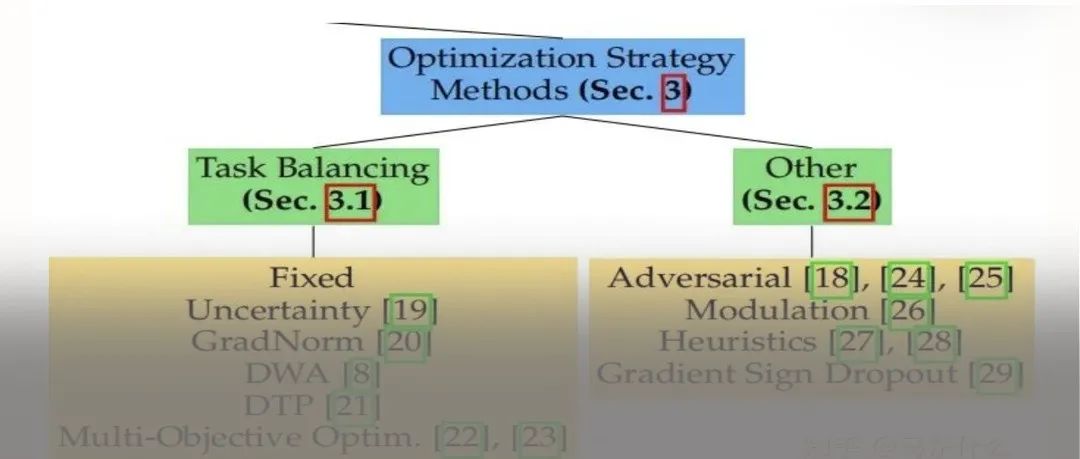

參考文獻(xiàn)

[1] An overview of multi-task learning in deep neural networks. Retireved from https://arxiv.org/pdf/1706.05098.pdf

[2] Long, M., & Wang, J. (2015). Learning Multiple Tasks with Deep Relationship Networks. arXiv Preprint arXiv:1506.02117. Retrieved from http://arxiv.org/abs/1506.02117

[3] Lu, Y., Kumar, A., Zhai, S., Cheng, Y., Javidi, T., & Feris, R. (2016). Fully-adaptive Feature Sharing in Multi-Task Networks with Applications in Person Attribute Classification. Retrieved from http://arxiv.org/abs/1611.05377

[4] Misra, I., Shrivastava, A., Gupta, A., & Hebert, M. (2016). Cross-stitch Networks for Multi-task Learning. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. https://doi.org/10.1109/CVPR.2016.433

[5] Hashimoto, K., Xiong, C., Tsuruoka, Y., & Socher, R. (2016). A Joint Many-Task Model: Growing a Neural Network for Multiple NLP Tasks. arXiv Preprint arXiv:1611.01587. Retrieved from http://arxiv.org/abs/1611.01587

[6] Yang, Y., & Hospedales, T. (2017). Deep Multi-task Representation Learning: A Tensor Factorisation Approach. In ICLR 2017. https://doi.org/10.1002/joe.20070

[7] Ruder, S., Bingel, J., Augenstein, I., & S?gaard, A. (2017). Sluice networks: Learning what to share between loosely related tasks. Retrieved from http://arxiv.org/abs/1705.08142

[8] Entire Space Multi-Task Model: An Effective Approach for Estimating Post-Click Conversion Rate. Retrieved from: https://arxiv.org/pdf/1804.07931.pdf

[9] Perceive Your Users in Depth: Learning Universal User Representations from Multiple E-commerce Tasks. Retrieved from: https://arxiv.org/pdf/1805.10727.pdf

推薦閱讀

2021-04-09

2021-04-07

2021-04-02

# CV技術(shù)社群邀請函 #

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測-深圳)

即可申請加入極市目標(biāo)檢測/圖像分割/工業(yè)檢測/人臉/醫(yī)學(xué)影像/3D/SLAM/自動駕駛/超分辨率/姿態(tài)估計/ReID/GAN/圖像增強/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實項目需求對接、求職內(nèi)推、算法競賽、干貨資訊匯總、與 10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動交流~