專攻芯片設計,英偉達推出定制版大語言模型ChipNeMo!

新智元報道

新智元報道

【新智元導讀】英偉達:大語言模型或?qū)⑷婕映中酒O計全流程!

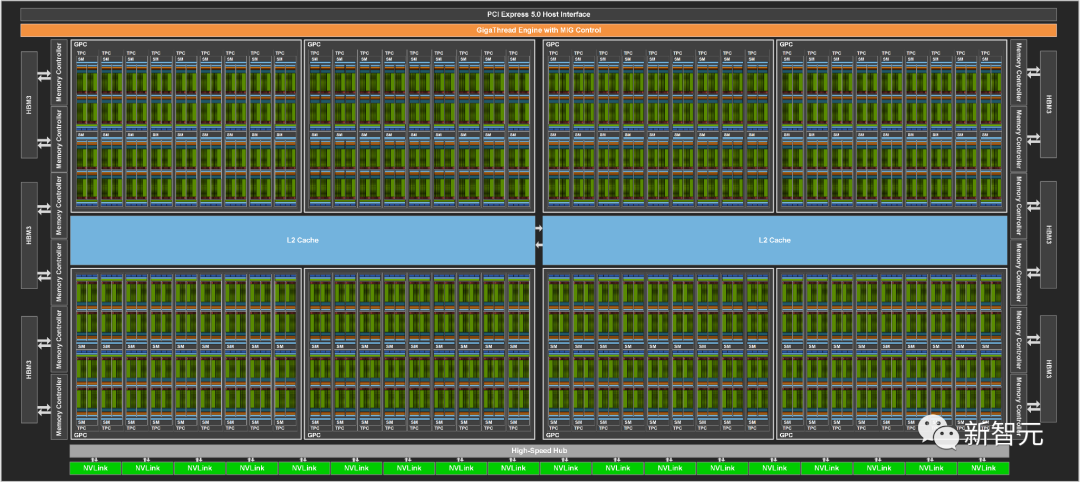

在剛剛開幕的ICCAD 2023大會上,英偉達團隊展示了用AI模型測試芯片,引發(fā)了業(yè)界關(guān)注。

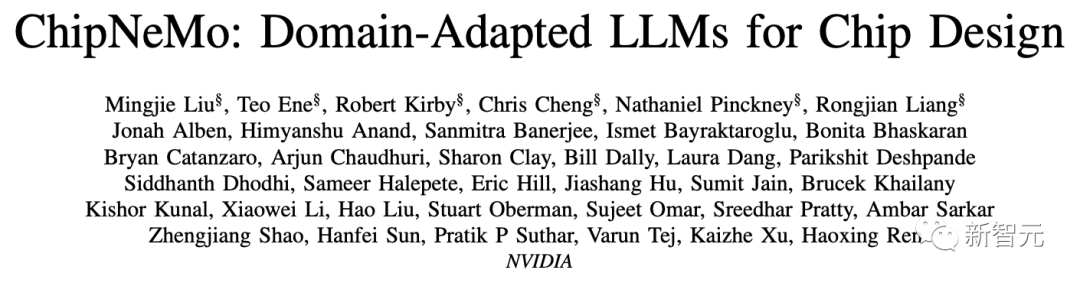

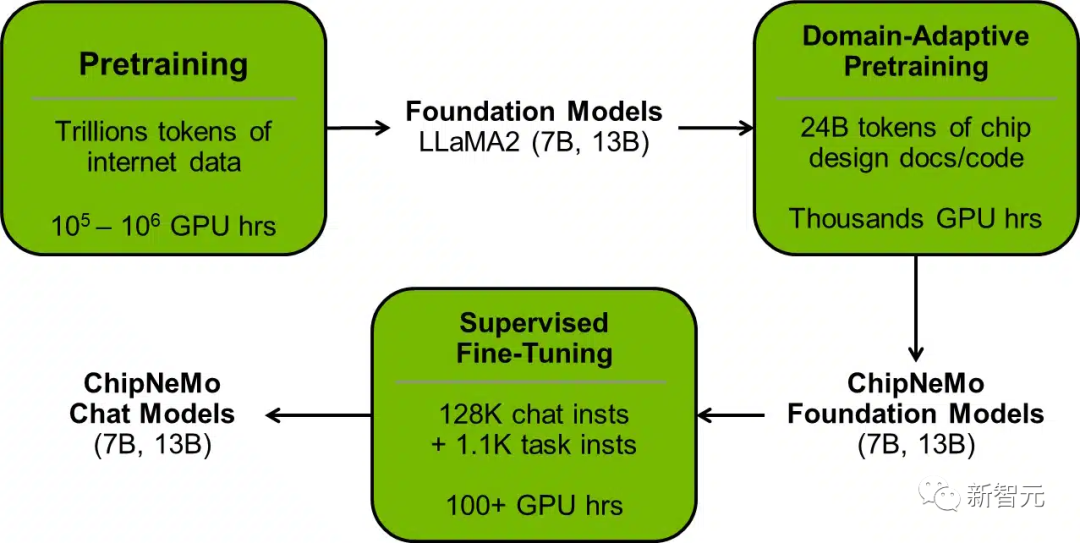

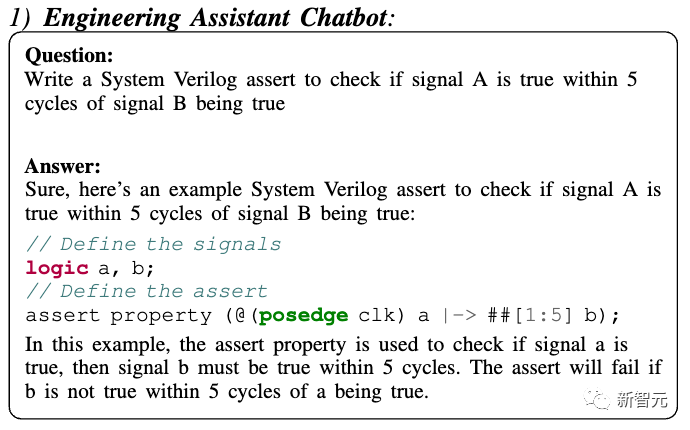

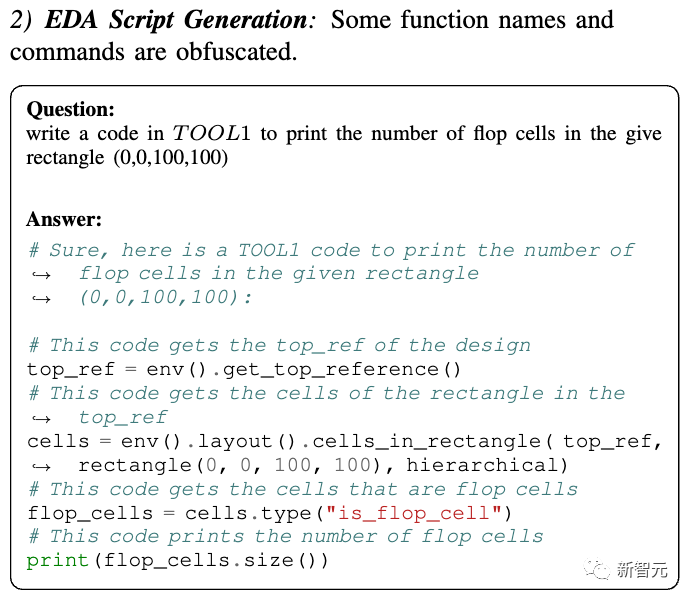

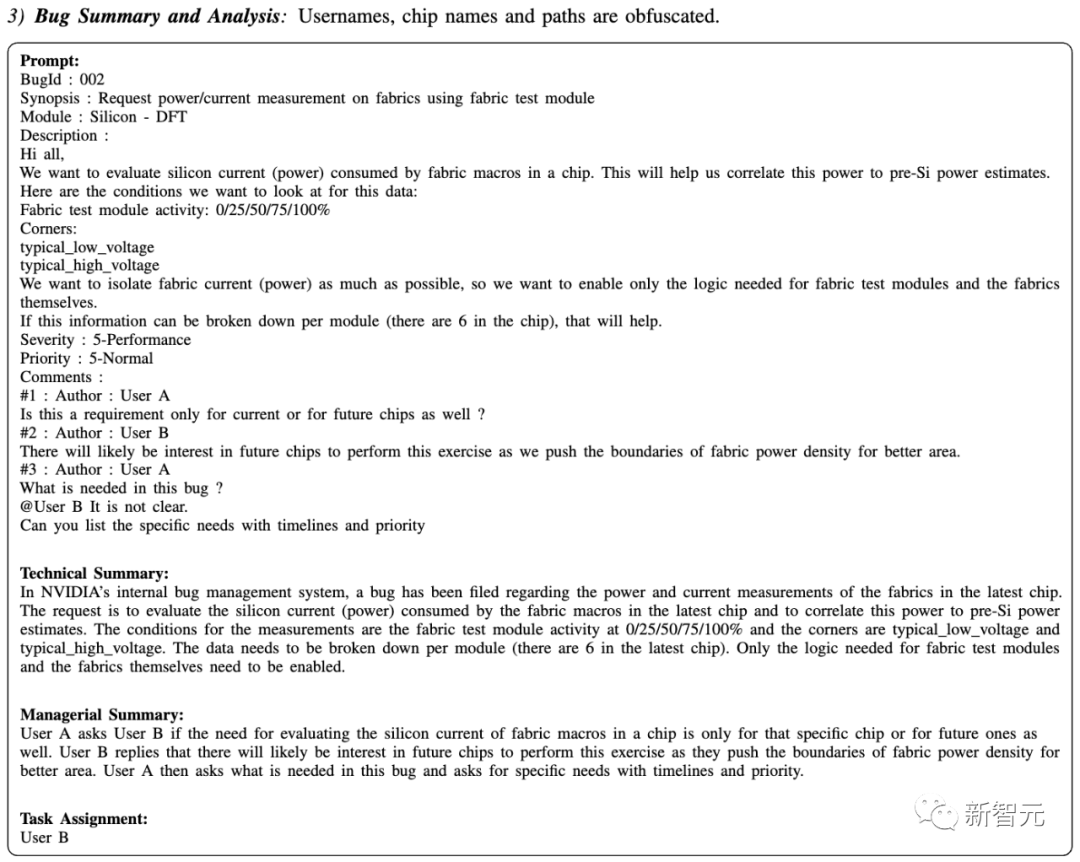

ChipNeMo:英偉達版「芯片設計」大模型

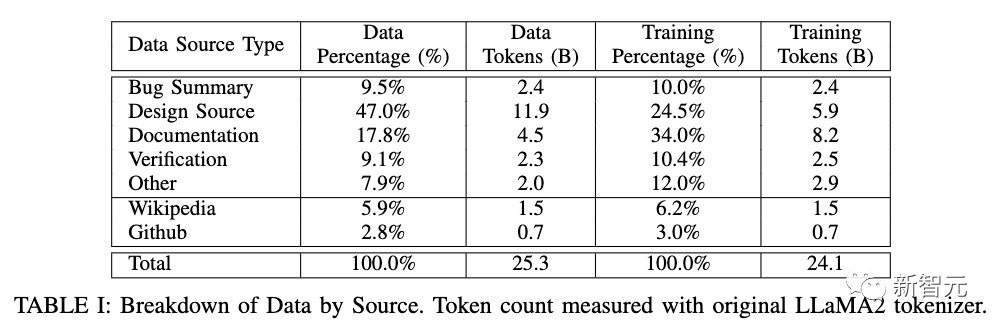

數(shù)據(jù)

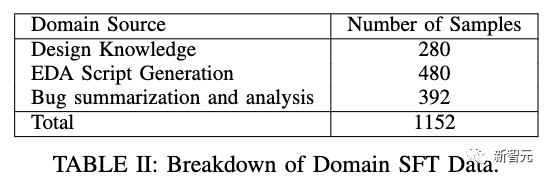

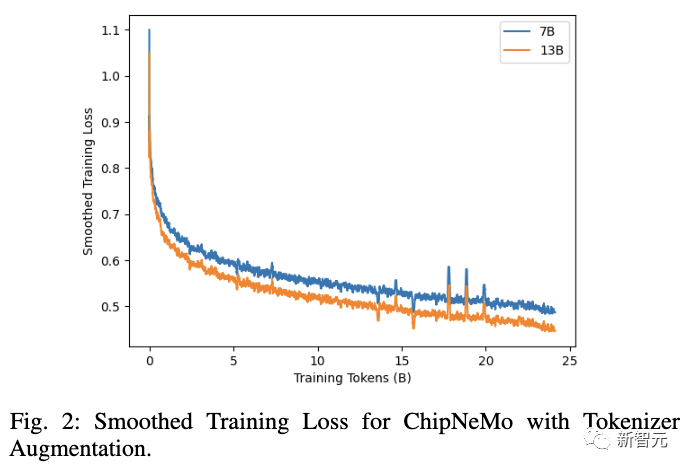

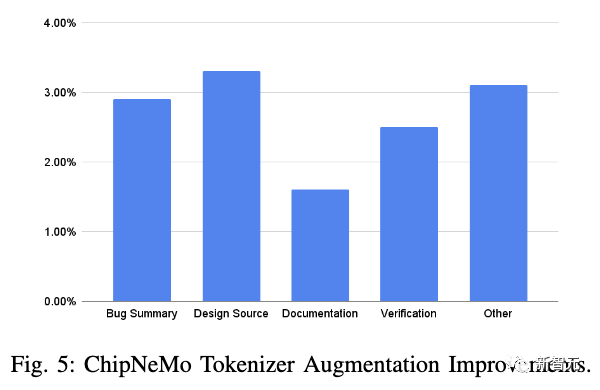

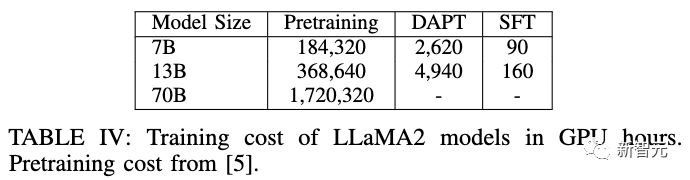

訓練

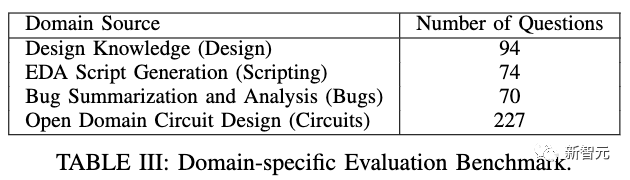

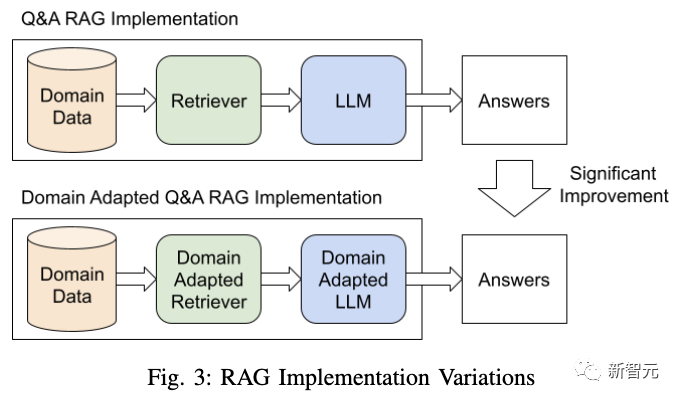

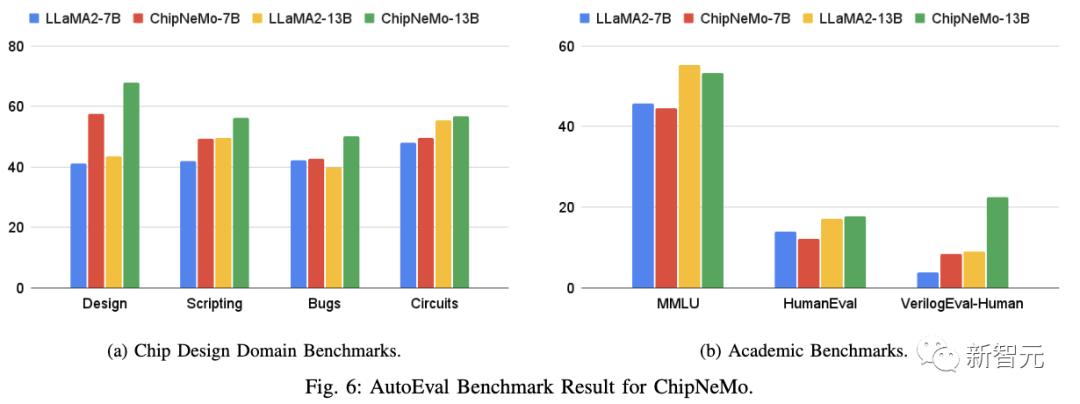

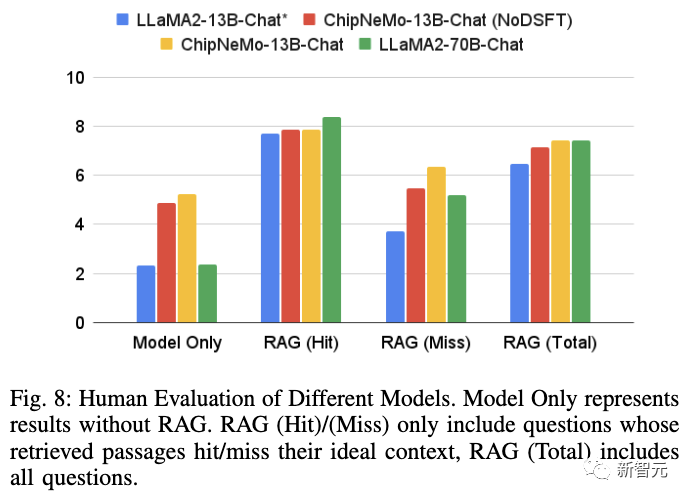

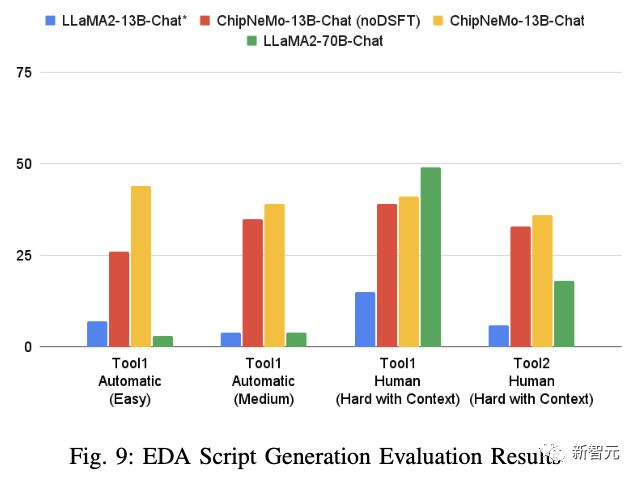

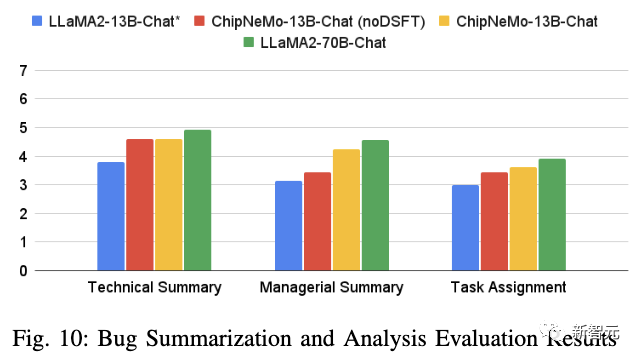

結(jié)果

討論

評論

圖片

表情