細(xì)粒度圖像分割 (FGIS)

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

如今,照片逼真的編輯需要仔細(xì)處理自然場(chǎng)景中經(jīng)常出現(xiàn)的顏色混合,這些顏色混合通常通過場(chǎng)景或?qū)ο箢伾能涍x擇來(lái)建模。因此,為了實(shí)現(xiàn)高質(zhì)量的圖像編輯和背景合成,精確表示圖像區(qū)域之間的這些軟過渡至關(guān)重要。工業(yè)中用于生成此類表示的大多數(shù)現(xiàn)有技術(shù)嚴(yán)重依賴于熟練視覺藝術(shù)家的某種用戶交互。因此,創(chuàng)建如此準(zhǔn)確的顯著性選擇成為一項(xiàng)昂貴且繁瑣的任務(wù). 為了填補(bǔ)熟練視覺藝術(shù)家的空白,我們利用計(jì)算機(jī)視覺來(lái)模擬人類視覺系統(tǒng),該系統(tǒng)具有有效的注意力機(jī)制,可以從視覺場(chǎng)景中確定最顯著的信息。這類問題也可以解釋為前景提取問題,其中顯著對(duì)象被視為前景類,其余場(chǎng)景為背景類。計(jì)算機(jī)視覺和深度學(xué)習(xí)旨在通過一些選擇性研究分支對(duì)這種機(jī)制進(jìn)行建模,即圖像摳圖、顯著目標(biāo)檢測(cè)、注視檢測(cè)和軟分割。值得注意的是,與計(jì)算機(jī)視覺不同,深度學(xué)習(xí)主要是一種數(shù)據(jù)密集型研究方法。

隨著近年來(lái)使用全卷積網(wǎng)絡(luò) (FCN) 進(jìn)行圖像分割的興起,深度學(xué)習(xí)顯著改善了前景提取和顯著性檢測(cè)基線。盡管有這些改進(jìn),但大多數(shù)建議的架構(gòu)使用最初為圖像屬性分類任務(wù)設(shè)計(jì)的網(wǎng)絡(luò)主干,它提取具有語(yǔ)義意義的代表性特征,而不是全局對(duì)比度和局部細(xì)節(jié)信息。

是的,如果我們從輸出格式的角度來(lái)看,這是一個(gè)分割問題。近年來(lái),語(yǔ)義分割已成為計(jì)算機(jī)視覺和深度學(xué)習(xí)領(lǐng)域的一個(gè)關(guān)鍵問題。因此,從更大的場(chǎng)景來(lái)看,我們可以說(shuō)語(yǔ)義分割是該領(lǐng)域的關(guān)鍵任務(wù)之一,它為更好地理解場(chǎng)景鋪平了道路。從圖像和視頻中推斷認(rèn)知事實(shí)的應(yīng)用越來(lái)越多,這也突出了場(chǎng)景理解的重要性。

細(xì)粒度語(yǔ)義分割的三種方法:

圖像摳圖

顯著目標(biāo)檢測(cè) (SOD)

軟分割

圖像摳圖可以理解為綠屏摳像的廣義版本,用于在無(wú)約束設(shè)置中精確估計(jì)前景不透明度。圖像摳圖是計(jì)算機(jī)圖形學(xué)和視覺應(yīng)用中一個(gè)非常重要的課題。早期的圖像摳圖方法涉及大型稀疏矩陣,例如大型核摳圖拉普拉斯算子及其優(yōu)化。然而,這些解決此類線性系統(tǒng)的方法通常非常耗時(shí)且不受用戶歡迎。許多研究試圖通過使用自適應(yīng)內(nèi)核大小和 KD 樹來(lái)提高這種線性系統(tǒng)的求解速度,但在野生圖像的質(zhì)量和推理速度方面沒有觀察到顯著的改進(jìn)。由于問題是高度不適定的,用戶通常會(huì)給出一個(gè)trimap(或筆劃)來(lái)表示明確的前景、明確的背景和未知區(qū)域,作為支持性輸入。

讓我們首先制定一個(gè)基本的圖像摳圖公式。將圖像像素的背景顏色、前景色和前景不透明度分別表示為 B、F 和 α,像素的顏色 C 可以寫為 B 和 F 的組合:

C = F (α)+ B(1 ? α)。

圖像摳圖方法可以分為三種主要類型,基于傳播的、基于采樣的和基于學(xué)習(xí)的。在某些方法中,還使用了基于采樣和基于傳播的摳圖的混合組合。

基于采樣的圖像摳圖基于以下假設(shè):未知像素的真實(shí)背景和前景顏色可以從位于該未知像素附近的已知背景和前景像素導(dǎo)出。一些基于采樣的方法:

共享采樣摳圖

迭代摳圖

貝葉斯摳圖

稀疏編碼

基于傳播的圖像摳圖技術(shù)通過將已知局部背景和前景像素的 alpha 值傳播到未知區(qū)域來(lái)計(jì)算未知像素的 alpha 值。然而,在野生背景圖像的情況下,對(duì)顏色知識(shí)的過度依賴導(dǎo)致圖像中背景和前景色的分布重疊的偽影。一些基于傳播的方法:

Geodesic?摳圖

Close-form?摳圖

Poisson?摳圖

Spectral 摳圖

盡管如此,采樣和基于傳播的技術(shù)都無(wú)法提供令人滿意和完全自動(dòng)化的結(jié)果。因此,一些深度學(xué)習(xí)研究者提出了一些方法,可以通過將trimap 和 RGB 圖像串聯(lián)輸入到 FCN 中來(lái)解決上述線性系統(tǒng),或者僅通過 RGB 圖像本身來(lái)預(yù)測(cè)最終的 alpha 蒙版。

根據(jù)經(jīng)驗(yàn),基于深度學(xué)習(xí)的方法能夠比其他兩種方法更好地捕獲全局語(yǔ)義信息和局部細(xì)節(jié),而且它們不偏向于任何已知和未知區(qū)域像素之間存在相關(guān)性的粗略假設(shè)。

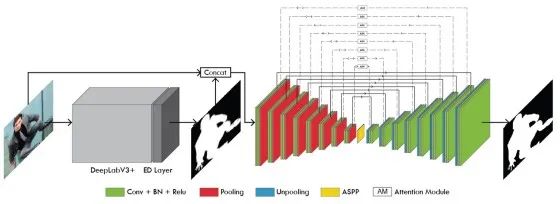

SOD 的主要目標(biāo)是分割圖片中最顯著(重要)和視覺上有吸引力的對(duì)象。許多領(lǐng)域,如圖像分割和視覺跟蹤,在各種應(yīng)用中應(yīng)用 SOD。與圖像摳圖類似,在用于顯著性檢測(cè)的全卷積網(wǎng)絡(luò) (FCN) 興起之后,SOD的最新技術(shù)水平顯著提高。

與自然摳圖不同,顯著目標(biāo)檢測(cè)并不像看起來(lái)那么復(fù)雜,實(shí)現(xiàn)精確顯著目標(biāo)檢測(cè)的主要挑戰(zhàn)是:

(1)顯著性定位。特定視覺資源的顯著性通常定義為整個(gè)圖像的全局對(duì)比度,而不是任何像素或局部特征。因此,為了獲得精確的 SOD,顯著性檢測(cè)算法不僅要捕獲整個(gè)圖像的全局對(duì)比度,還要建立對(duì)前景對(duì)象詳細(xì)結(jié)構(gòu)的精確表示。為了解決這個(gè)問題,使用了多級(jí)深度特征聚合網(wǎng)絡(luò)。

(2)沒有邊界細(xì)化損失。用于訓(xùn)練顯著性目標(biāo)檢測(cè)模型的最常見的損失是聯(lián)合交集 (IoU) 損失或交叉熵 (CE)。但這兩種方法都會(huì)導(dǎo)致邊界細(xì)節(jié)模糊,因?yàn)樗鼈兌寄苡行^(qū)分邊界像素。許多研究也使用 Dice-score 損失,但其主要目的是處理有偏差的訓(xùn)練集,而不是專門加強(qiáng)精細(xì)結(jié)構(gòu)的建模。

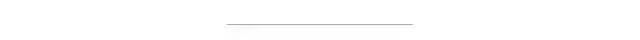

用于顯著目標(biāo)檢測(cè)的深度學(xué)習(xí)文獻(xiàn)有著豐富的現(xiàn)代歷史。一些研究強(qiáng)調(diào)使用具有注意機(jī)制的深度遞歸網(wǎng)絡(luò)對(duì)某些選擇性圖像子區(qū)域進(jìn)行迭代細(xì)化。另一方面,一些研究強(qiáng)調(diào)了通過深度多徑循環(huán)連接從網(wǎng)絡(luò)深層到淺端的全局信息傳輸?shù)挠行浴TS多作者像胡等人[1]?和王等人[2]?提出了使用循環(huán)全連接網(wǎng)絡(luò)或循環(huán)連接多層深層特征進(jìn)行顯著目標(biāo)檢測(cè)方法,這些研究也表明了預(yù)測(cè)誤差迭代修正的有效性。與前面提到的研究工作相比,一些研究還展示了在U-Net 架構(gòu)中使用上下文注意網(wǎng)絡(luò)來(lái)預(yù)測(cè)像素級(jí)注意力圖的架構(gòu)。從評(píng)價(jià)指標(biāo)來(lái)看,這些提取的像素級(jí)注意圖對(duì)于顯著性檢測(cè)是非常有效的。提出的方法很少有強(qiáng)調(diào)從粗到細(xì)的預(yù)測(cè)轉(zhuǎn)換,這些方法提出了通過捕獲更精細(xì)的結(jié)構(gòu)來(lái)實(shí)現(xiàn)更準(zhǔn)確的邊界細(xì)節(jié)的細(xì)化策略。例如,盧等人提出了一種架構(gòu),該架構(gòu)捕獲深度層次顯著性表示,用于對(duì)顯著圖的各種全局結(jié)構(gòu)化顯著性線索以及后細(xì)化階段進(jìn)行建模。顯著目標(biāo)檢測(cè)領(lǐng)域的最新進(jìn)展是Qin 等人提出的,他們提出了一個(gè)強(qiáng)大的深度網(wǎng)絡(luò)架構(gòu)(U^2-Net),具有兩層嵌套的 U 結(jié)構(gòu)。

根據(jù)經(jīng)驗(yàn),SOD 也實(shí)現(xiàn)了更高質(zhì)量的顯著圖作為自然圖像摳圖,但在透明度建模和精細(xì)結(jié)構(gòu)提取方面的質(zhì)量較差。

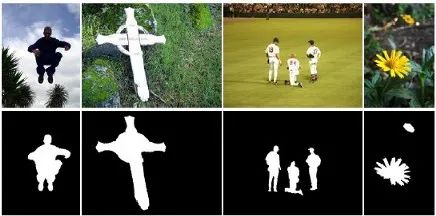

軟分割被定義為將圖像分解為兩個(gè)或更多部分,其中每個(gè)成員像素可能擁有分為兩個(gè)或更多部分的成員資格。

語(yǔ)義軟段,通過為每個(gè)段分配純色來(lái)可視化

大多數(shù)早期的軟分割方法強(qiáng)調(diào)使用逐像素顏色分離或全局優(yōu)化來(lái)提取各種同質(zhì)顏色的軟顯著性圖。雖然觀察到這些提取的軟彩色地圖對(duì)許多關(guān)鍵的圖像編輯應(yīng)用程序(例如圖像重新著色)很有用,但與 SOD 類似,它們并沒有特別考慮對(duì)象邊界和過渡區(qū)域粒度。有趣的是,圖像摳圖與軟分割的分支有著非常密切的關(guān)系。事實(shí)上,一些圖像摳圖文獻(xiàn)(例如 Matting Laplacian)完全符合軟分割的關(guān)鍵思想,即捕捉圖像中局部軟過渡區(qū)域的強(qiáng)大表示。給定一組用戶定義的區(qū)域,這些方法主要基于迭代求解兩層軟分割問題以生成多層的思想。Levin等人在光譜摳圖方面的工作也達(dá)到了同樣的目的,通過光譜分解自動(dòng)估計(jì)一組空間連接的軟段。Aksoy等人最近的軟分割研究也遵循了光譜摳圖與光譜分解和消光拉普拉斯算子相結(jié)合的思想。然而,與光譜摳圖不同的是,他們的工作通過將局部紋理信息與訓(xùn)練用于場(chǎng)景分析的深度卷積神經(jīng)網(wǎng)絡(luò)的高級(jí)特征融合,從光譜分解角度解決問題。他們的主要貢獻(xiàn)之一是使用類似圖的結(jié)構(gòu),通過語(yǔ)義對(duì)象以及它們之間的軟轉(zhuǎn)換來(lái)豐富相應(yīng)拉普拉斯矩陣的特征向量。

根據(jù)經(jīng)驗(yàn),軟分割是自然圖像摳圖的一個(gè)派生分支,它結(jié)合了豐富的歷史圖像摳圖實(shí)踐和深度學(xué)習(xí)的力量。同樣與普通圖像摳圖不同的是,軟分割提供了更多層的輸出來(lái)表示語(yǔ)義上有意義的區(qū)域。但是,盡管有很大的改進(jìn),仍有巨大的改進(jìn)空間需要解決。

我們已經(jīng)從解決顯著前景提取問題的角度解釋了這些方法,但這些方法所要解決的實(shí)際問題在各自的研究分支中非常豐富和多樣化,并以自己的方式為深度計(jì)算機(jī)視覺領(lǐng)域做出了貢獻(xiàn)。

[1] 胡小偉、朱磊、秦靜、傅志榮、彭安恒。反復(fù)聚合深度特征以進(jìn)行顯著目標(biāo)檢測(cè)。在 AAAI-18 會(huì)議記錄中,美國(guó)路易斯安那州新奧爾良,第 6943-6950 頁(yè),2018 年。

[2] 王林昭、王立軍、盧虎川、張萍萍、向阮。使用循環(huán)全卷積網(wǎng)絡(luò)進(jìn)行顯著目標(biāo)檢測(cè)。IEEE 模式分析和機(jī)器智能匯刊,2018 年。

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺SLAM“。請(qǐng)按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~