多模態(tài)3D目標(biāo)檢測發(fā)展路線方法匯總!(決策級/特征級/點/體素融合)

什么是多模態(tài)3D目標(biāo)檢測?

多模態(tài)3D目標(biāo)檢測是當(dāng)前3D目標(biāo)檢測研究熱點之一,主要是指利用跨模態(tài)數(shù)據(jù)提升模型的檢測精度。一般而言,多模態(tài)數(shù)據(jù)包含:圖像數(shù)據(jù)、激光雷達(dá)數(shù)據(jù)、毫米波雷達(dá)數(shù)據(jù)、雙目深度數(shù)據(jù)等,本文主要關(guān)注于當(dāng)前研究較多的RGB+LiDAR融合3D目標(biāo)檢測模型進(jìn)行匯總和總結(jié),希望可以給大家?guī)硪欢ǖ膯l(fā)。

多模態(tài)3D目標(biāo)檢測主要方法

(一) 決策級融合 (Decision-level)

所謂的決策級融合,一般而言是指直接利用2D/3D基礎(chǔ)網(wǎng)絡(luò)的檢測結(jié)果,為后續(xù)bounding box的優(yōu)化提供初始位置。決策級融合的優(yōu)點是:僅對不同模態(tài)的輸出進(jìn)行多模態(tài)融合,避免了中間特征或輸入點云上復(fù)雜的交互,因此往往更加高效。但是,也面臨一定的缺陷:由于不依賴于相機(jī)和激光雷達(dá)傳感器的深度特征,這些方法無法整合不同模式的豐富語義信息,限制了這類方法的潛力。

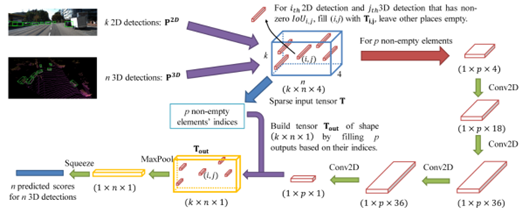

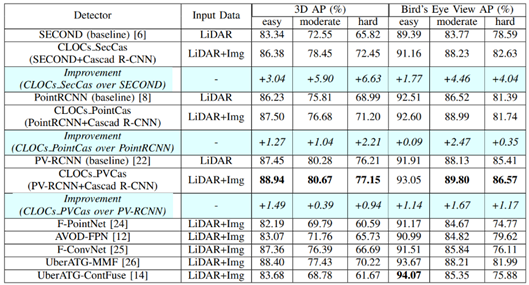

論文標(biāo)題:CLOCs: Camera-LiDAR Object Candidates Fusion for 3D Object Detection

論文地址:https://arxiv.org/pdf/2009.00784.pdf

作者單位:Su Pang等,Michigan State University

核心思想:作者認(rèn)為,對于決策級的融合而言,多模態(tài)數(shù)據(jù)不需要與其他模態(tài)進(jìn)行同步或?qū)R,且利用二者的檢測結(jié)果排除了大部分冗余背景區(qū)域,因此更有助于網(wǎng)絡(luò)學(xué)習(xí)。

方法簡述:

如上圖所示,CLOCs整體流程可分為3步:

步驟1:分別輸入圖像和點云,分別預(yù)測2D detections和3D detections; 步驟2:去除部分IoU=0的候選框,對保留的候選框進(jìn)行特征提取; 步驟3:得到最終的檢測結(jié)果。

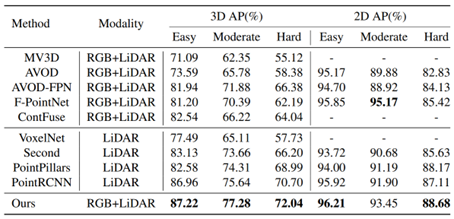

方法相對而言比較簡單,從步驟1也能清晰看出,CLOCs是利用檢測結(jié)果進(jìn)行的跨模態(tài)融合,因此屬于決策級融合的范疇。在KITTI testset的檢測結(jié)果如下圖所示,在多模態(tài)方法中還是比較具有競爭力的。

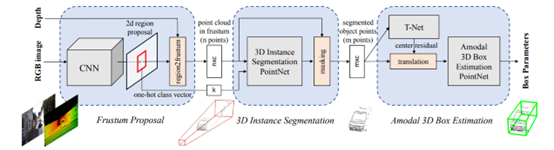

論文標(biāo)題:Frustum Pointnets for 3D Object Detection from RGB-D Data

論文地址:https://arxiv.org/pdf/1711.08488.pdf

作者單位:Charles R. Qi等,Stanford University

核心思想:作者認(rèn)為,使用2D目標(biāo)檢測結(jié)果生成3D錐形建議區(qū)域,省略直接在大范圍的空間中檢索,同時提升了目標(biāo)的識別準(zhǔn)確度。

方法簡述:

如上圖所示,F(xiàn)rustum PointNet整體流程可分為3步:

步驟1:通過2D網(wǎng)絡(luò)預(yù)測2D Proposal; 步驟2:將2D Proposal映射為3D錐體,作為后續(xù)3D檢測的建議區(qū)域; 步驟3:在步驟2提取出的建議區(qū)域中,進(jìn)行通用3D檢測流程;

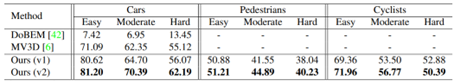

同樣,整體思路也比較簡單清晰,從步驟1也能看出,F(xiàn)rustum PointNet是利用2D檢測結(jié)果,為3D檢測提供initial region,因此,大大減少了3D搜索空間。從網(wǎng)絡(luò)流程上看,更為簡潔高效。同時,由于擁有2D proposal提供的初始位置,3D網(wǎng)絡(luò)的搜索位置也更為準(zhǔn)確,整體檢測性能也略有提高,在KITTI testset的檢測結(jié)果如下圖所示,

(二) 特征級融合 (Feature-level)

所謂的特征級融合,就是在基于LiDAR的3D目標(biāo)檢測器的中間階段,例如在骨干網(wǎng)絡(luò)中,或在proposal生成階段,或在RoI細(xì)化階段,融合圖像和激光雷達(dá)特征。

1. 感興趣區(qū)域融合 (RoI-level)

感興趣區(qū)域融合,通常是指:通過LiDAR檢測器生成3D目標(biāo)的proposals,這些3D的proposals被映射到多種視圖中,例如鳥瞰圖或者RGB圖中。再分別從Image和LiDAR的主干網(wǎng)絡(luò)中裁剪出特征,得到RoI Features,最后將Image RoI Features 和 LiDAR RoI Features 融合,并輸入到RoI 頭,輸出每個3D目標(biāo)的參數(shù)。

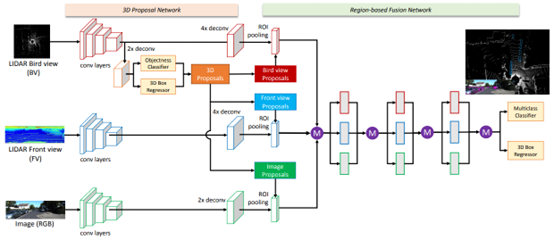

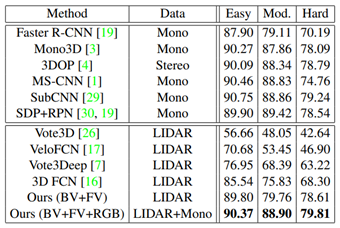

論文標(biāo)題:Multi-View 3D Object Detection Network for Autonomous Driving

論文地址:https://arxiv.org/pdf/1611.07759.pdf

作者單位:Xiaozhi Chen等,Tsinghua University

核心思想:利用點云俯視圖、點云前視圖、圖像數(shù)據(jù)進(jìn)行融合,這樣既能減少計算量,又不至于喪失過多的信息。

方法簡述:

如上圖所示,MV3D整體流程可分為4步:

步驟1:利用卷積網(wǎng)絡(luò)分別在點云前視圖、點云俯視圖和圖像數(shù)據(jù)上提取特征; 步驟2:在點云俯視圖上進(jìn)行proposal生成; 步驟3:將生成的3D proposal分別在不同模態(tài)數(shù)據(jù)中進(jìn)行特征提取; 步驟4:將多模態(tài)proposal特征進(jìn)行融合檢測;

從步驟3也能看出,MV3D是利用點云俯視圖生成的3D檢測結(jié)果,在不同模態(tài)數(shù)據(jù)上進(jìn)行特征提取,因此屬于RoI-level的融合方式。在KITTI testset中,這種多模態(tài)融合方式也具有顯著的優(yōu)勢。尤其是當(dāng)增添了圖像數(shù)據(jù)后,整體網(wǎng)絡(luò)在Moderate子集上有了明顯的性能提升,具體實驗結(jié)果如下圖所示:

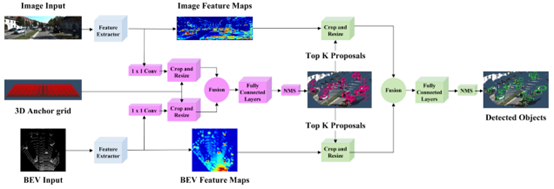

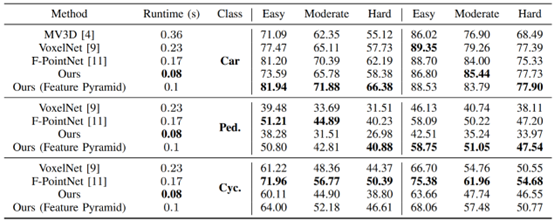

論文標(biāo)題:Joint 3D Proposal Generation and Object Detection from View Aggregation

論文地址:https://arxiv.org/pdf/1712.02294.pdf

作者單位:Jason Ku等,University of Waterloo

核心思想:借鑒了FPN思想,通過高分辨率特征提升檢測性能。

方法簡述:

如上圖所示,AVOD整體流程可以分為4步:

步驟1:分別提取圖像和俯視圖特征; 步驟2:利用融合后的特征提取3D Proposals; 步驟3:將生成的3D proposal分別在不同模態(tài)數(shù)據(jù)中進(jìn)行特征提取; 步驟4:將多模態(tài)proposal特征進(jìn)行融合檢測;

從上述步驟也能看出,整體檢測流程與MV3D并無明顯區(qū)別。主要區(qū)分點在于:其一,AVOD借鑒了FPN的特征提取方法,提取出的特征更加高效;其二,設(shè)計了10維bounding box編碼策略,通過ground plane和top bottom corner center進(jìn)行編碼,更加簡介高效。整體網(wǎng)絡(luò)性能在KITTI上表現(xiàn)較好,尤其是對于Pedestrian和Cyclist兩類,如下圖所示:

論文標(biāo)題:Cross-Modality 3D Object Detection

論文地址:https://arxiv.org/pdf/2008.10436.pdf

作者單位:Ming Zhu等,Shanghai Jiao Tong University

核心思想:提出了一種2D-3D耦合損耗,以充分利用圖像信息,約束3D Bounding box與2D Bounding box一致。

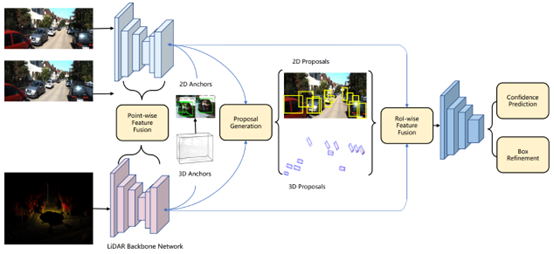

方法簡述:

如上圖所示,整體方法可分為4步:

步驟1:利用卷積網(wǎng)絡(luò)分別在點云和圖像數(shù)據(jù)上提取特征; 步驟2:利用提取出的特征提取2D Proposal和3D Proposal; 步驟3:對生成的2D和3D Proposal進(jìn)行一致性約束; 步驟4:對約束后的proposal特征進(jìn)行融合檢測;

從步驟2也能看出,此方法是利用生成的2D和3D檢測結(jié)果,在不同模態(tài)數(shù)據(jù)上進(jìn)行特征提取,因此屬于RoI-level的融合方式。方法的不同之處在于,作者提出了一種2D-3D的耦合損耗,用于約束3D和2D場景下Proposal的一致性。此方法在KITTI上有明顯的提升,具體結(jié)果如下圖所示:

論文標(biāo)題:Sparse Fuse Dense: Towards High Quality 3D Detection with Depth Completion

論文地址:https://arxiv.org/pdf/2203.09780.pdf

作者單位:Xiaopei Wu等,Zhejiang University

核心思想:多模態(tài)特征加權(quán)融合,以及跨模態(tài)對齊問題。

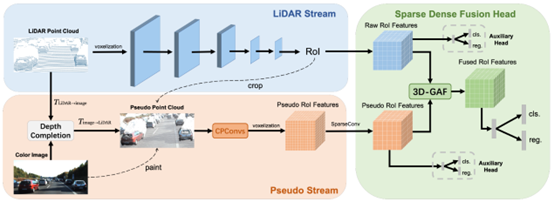

方法簡述:

如上圖所示,整體方法可以分為4步:

步驟1:利用深度補(bǔ)全網(wǎng)絡(luò),將原始RGB圖像映射到3D場景中,生成偽點Pseudo Points; 步驟2:提取原始3D點云特征,并生成候選框; 步驟3:對每一個候選框,分別提取點云特征和偽點云特征; 步驟4:對點云特征和偽點云特征進(jìn)行重新加權(quán),并輸出最后的檢測結(jié)果;

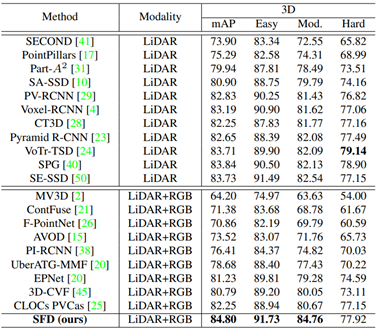

從步驟2可以看出,SFD利用的是3D場景預(yù)測出的候選框,并在不同模態(tài)數(shù)據(jù)上進(jìn)行特征提取,因此屬于RoI-level的融合范疇。此方法不同之處在于:其一,在網(wǎng)絡(luò)預(yù)處理階段,將跨模態(tài)數(shù)據(jù)增廣進(jìn)行了對齊,因此特征更加一致,其二,對候選框的多模態(tài)特征進(jìn)行了加權(quán),輸出更魯棒的fusion feature。此方法在KITTI testset具有非常優(yōu)越的性能,具體實驗結(jié)果如下圖所示:

2. 點/體素融合 (Point/Voxel-level)

點/體素融合通常是指,對于點云場景中的每一個點或每一個體素框,利用其余模態(tài)特征對齊進(jìn)行補(bǔ)全。這種補(bǔ)全往往是更精細(xì)化的,更全面的,但是也因此導(dǎo)致效率往往不是很高。

論文標(biāo)題:Multi-task Multi-Sensor Fusion for 3D Object Detection

論文地址:https://arxiv.org/pdf/2012.12397.pdf

作者單位:Ming Liang等,Uber Advanced Technologies Group

核心思想:pixel-point層面的融合方式,同時增加了深度估計模塊。

方法簡述:

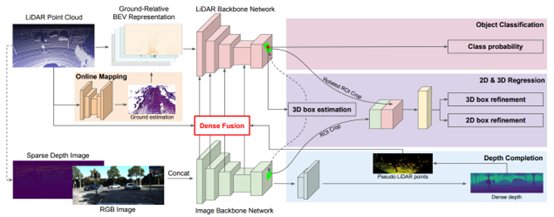

如上圖所示,整體方法可分為4步:

步驟1:分別對點云和圖像提取特征; 步驟2:利用Dense Fusion模塊,在網(wǎng)絡(luò)不同層級上進(jìn)行特征融合; 步驟3:利用融合后的特征計算initial proposal; 步驟4:預(yù)測bounding box和深度圖;

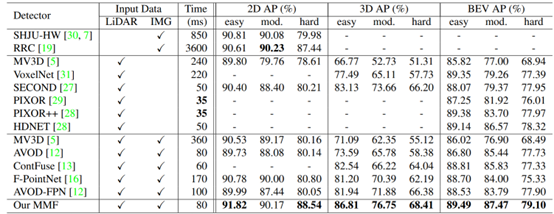

從步驟2可以看出,MMF是在基礎(chǔ)網(wǎng)絡(luò)的不同階段進(jìn)行的特征融合,屬于全場景融合,因此可劃分為Point/Voxel-level。后續(xù)的檢測流程與通用的3D檢測沒有明顯區(qū)域,只是額外添加了深度預(yù)測支路,用于圖像到點云的映射校準(zhǔn)。作者同樣給出了KITTI testset的檢測結(jié)果,如下圖所示:

論文標(biāo)題:MVX-Net: Multimodal VoxelNet for 3D Object Detection

論文地址:https://arxiv.org/pdf/1904.01649.pdf

作者單位:Vishwanath A. Sindagi等,Johns Hopkins University

核心思想:網(wǎng)絡(luò)初期融合,以提取更豐富魯棒的特征。

方法簡述:

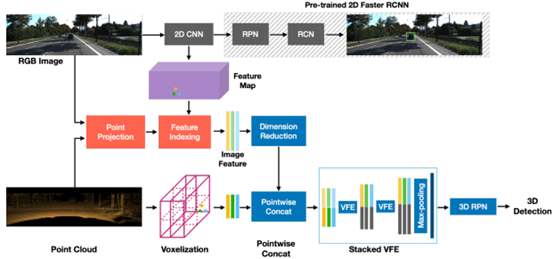

如上圖所示,整體方法可分為3步:

步驟1:分別對點云和圖像提取特征; 步驟2:找到3D體素和2D圖像的對應(yīng)關(guān)系,進(jìn)行對應(yīng)的特征融合; 步驟3:利用融合后的特征預(yù)測3D檢測結(jié)果;

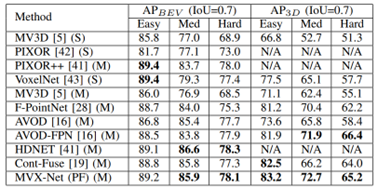

從步驟2可以看出,作者同樣做的場景層面的融合,而非proposal/bbox的融合,因此屬于Point/Voxel-level。整體網(wǎng)絡(luò)框架也比較簡單,在KITTI testset上有一定的性能提升,如下圖所示:

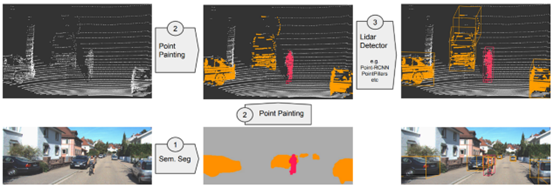

論文標(biāo)題:Pointpainting: Sequential Fusion for 3D Object Detection

論文地址:https://arxiv.org/pdf/1911.10150.pdf

作者單位:Sourabh Vora等,nuTonomy

核心思想:利用細(xì)粒度圖像分割信息對3D點云進(jìn)行補(bǔ)全;

方法簡述:

如上圖所示,整體方法可分為3步:

步驟1:對2D圖像進(jìn)行分割預(yù)測; 步驟2:將2D中預(yù)測出的分割結(jié)果投影到對應(yīng)的3D point中,對原始3D信息進(jìn)行補(bǔ)全; 步驟3:利用補(bǔ)全后的3D點云進(jìn)行預(yù)測;

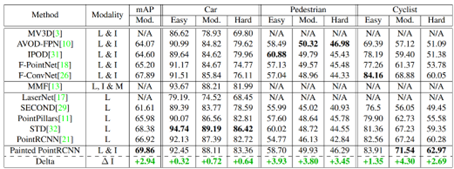

從步驟2可以看出,作者嘗試對3D場景中每一個點進(jìn)行信息補(bǔ)全,因此屬于point-level的融合方式。PointPainting是比較經(jīng)典的方法,其思想也被廣泛應(yīng)用在當(dāng)前的3D檢測網(wǎng)絡(luò)中。雖然方法比較簡單,但是性能提升顯著,在KITTI testset的實驗結(jié)果如下圖所示:

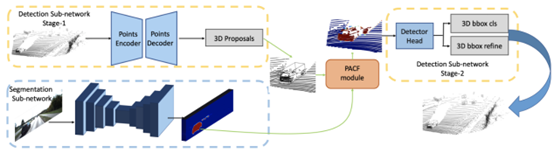

論文標(biāo)題:PI-RCNN: An Efficient Multi-Sensor 3D Object Detector with Point-based Attentive Cont-Conv Fusion Module

論文地址:https://arxiv.org/pdf/1911.06084.pdf

作者單位:Liang Xie等,Zhejiang University

核心思想:點云和圖像融合過程中的對齊問題(量化誤差)。

方法簡述:

如上圖所示,整體方法可分為4步:

步驟1:利用原始點云數(shù)據(jù)預(yù)測3D候選框; 步驟2:利用分割網(wǎng)絡(luò)預(yù)測2D分割結(jié)果; 步驟3:利用PACF模塊將2D和3D特征進(jìn)行對齊,減小其量化誤差; 步驟4:利用對齊后的特征進(jìn)行3D bbox預(yù)測;

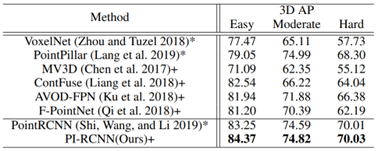

此方法歸為Point/Voxel-level類別的主要原因是:作者在PACF模塊中,對于點云上的每一個點,都會搜索K個近鄰點,并將其投影到分割特征圖上。之后,再利用緊鄰點的語義信息和點云信息進(jìn)行特征關(guān)聯(lián),輸出最終的檢測結(jié)果。所以,本質(zhì)上講,PI-RCNN網(wǎng)絡(luò)屬于Point-level的融合方式,在KITTI testset上性能顯著,如下圖所示:

論文標(biāo)題:EPNet: Enhancing Point Features with Image Semantics for 3D Object Detection

論文地址:https://arxiv.org/pdf/2007.08856.pdf

作者單位:Tengteng Huang等,Huazhong University of Science and Technology

核心思想:逐層融合,自適應(yīng)加權(quán)多模態(tài)特征。

方法簡述:

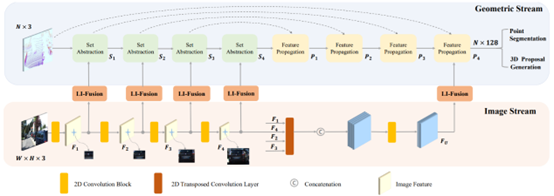

如上圖所示,整體方法可分為4步:

步驟1:分別提取圖像特征和點云特征; 步驟2:利用LI-Fusion模塊對多模態(tài)特征進(jìn)行逐層融合; 步驟3:利用Feature Propagation模塊對多模態(tài)特征自適應(yīng)加權(quán); 步驟4:利用加權(quán)后的特征進(jìn)行3D bbox的預(yù)測;

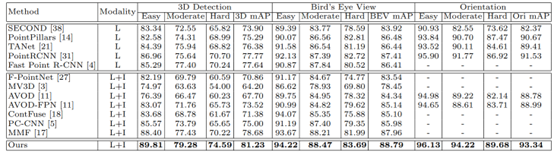

從步驟2和步驟3可以看出,作者提出的LIDAR-guided Image Fusion (LI-fusion)模塊通過point-wise的方式,建立原始點云和圖像間的對應(yīng)關(guān)系,自適應(yīng)地估計圖像語義特征的重要性,用有用的圖像特征來增強(qiáng)點云特征,同時抑制有干擾的圖像特征。EPNet在KITTI testset上性能具有明顯提升,如下圖所示: