點(diǎn)擊下方“AI算法與圖像處理”,關(guān)注一下

重磅干貨,第一時(shí)間送達(dá)

來(lái)源:機(jī)器之心

昨晚,CVPR 2021 公布了最佳論文、最佳學(xué)生論文等獎(jiǎng)項(xiàng)。德國(guó)馬普所和蒂賓根大學(xué)的研究者獲得了最佳論文獎(jiǎng),加州理工和西北大學(xué)的研究者獲得最佳學(xué)生論文獎(jiǎng)。此外,F(xiàn)AIR 包括何愷明在內(nèi)的兩位華人學(xué)者獲得最佳論文提名,而另一位華人學(xué)者、華盛頓大學(xué)計(jì)算機(jī)系碩士研究生林山川(Shanchuan Lin)獲得了最佳學(xué)生論文提名。

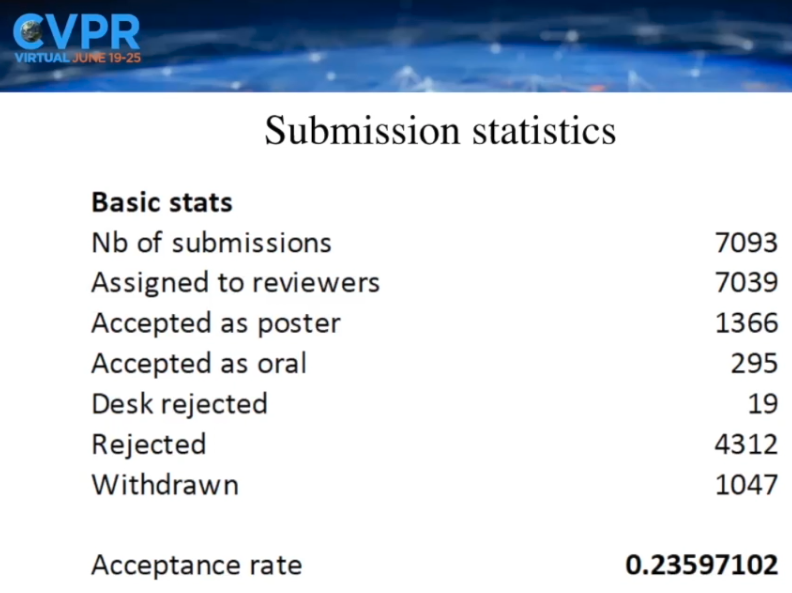

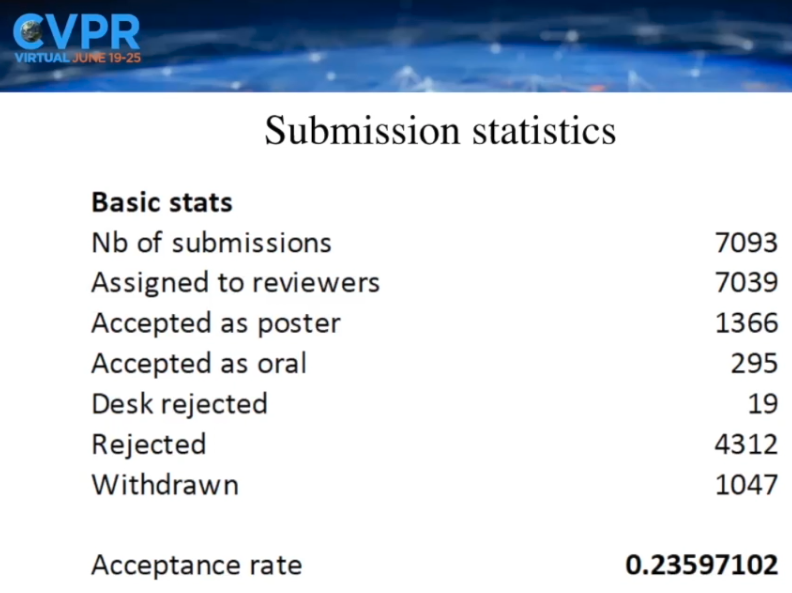

6 月 19 日,CVPR 2021 在線上拉開(kāi)帷幕。今年,大會(huì)一共接收了 7039 篇有效投稿,其中進(jìn)入 Decision Making 階段的共有約 5900 篇,最終有 1366 篇被接收為 poster,295 篇被接收為 oral,其中錄用率大致為 23.6%,略高于去年的 22.1%。

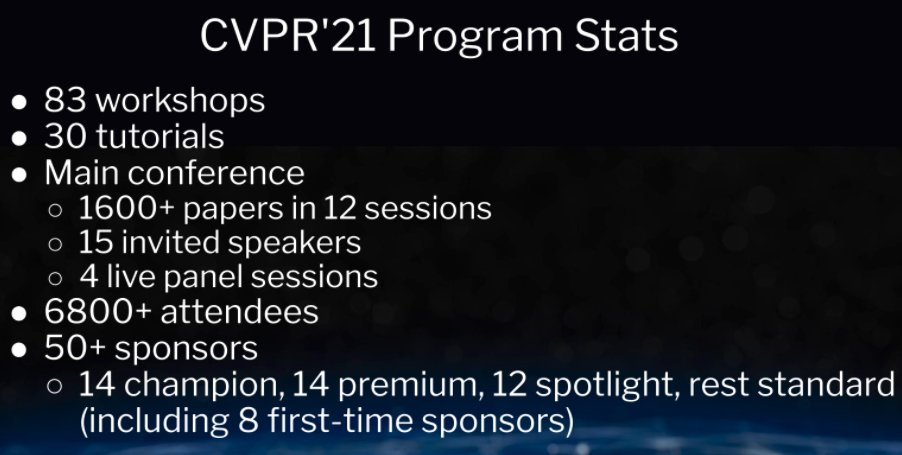

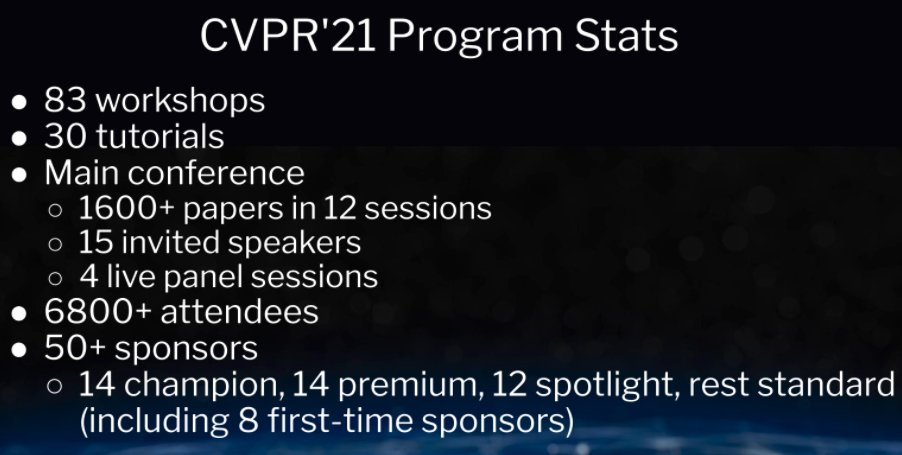

此外,大會(huì)還公布了參會(huì)人數(shù)等具體的統(tǒng)計(jì)數(shù)據(jù)。據(jù)悉,CVPR 2021 共有 83 個(gè) workshop、30 個(gè) tutorial、6800 多位參與者、12 個(gè) session 的 1600 多篇論文、15 位受邀演講者和 4 個(gè) live 專題討論會(huì),以及 50 多位贊助商。

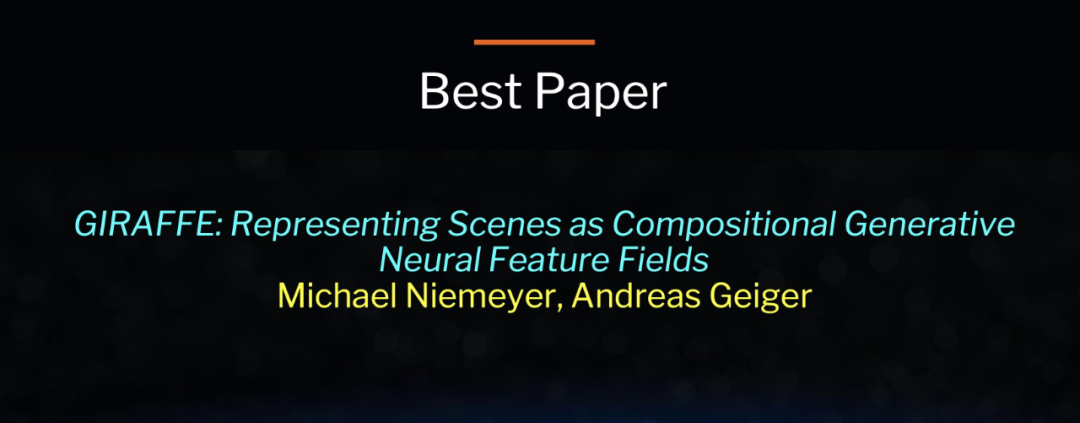

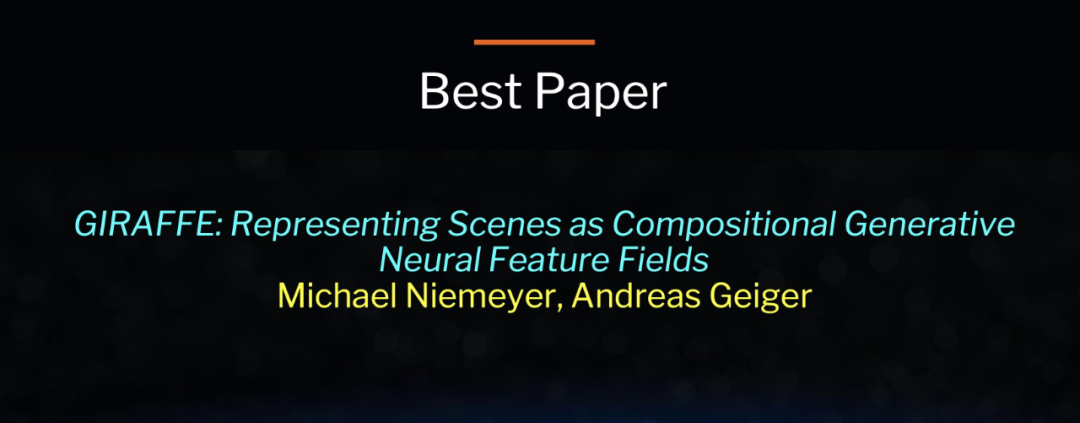

企業(yè)方面,國(guó)內(nèi)的 AI 公司在本屆 CVPR 上依然取得了良好的成績(jī),比如商湯有 66 篇論文入選,還拿到了 CVPR 2021 ActivityNet 時(shí)序動(dòng)作檢測(cè)任務(wù)弱監(jiān)督學(xué)習(xí)賽道冠軍以及 CVPR 2021 NTIRE 視頻理解挑戰(zhàn)賽的三項(xiàng)冠軍;快手也有 14 篇論文被接收,涵蓋三維視覺(jué)、目標(biāo)檢測(cè)、視頻目標(biāo)分割、人臉偽造技術(shù)檢測(cè)等熱門(mén)研究領(lǐng)域。昨晚,本屆大會(huì)的最佳論文、最佳學(xué)生論文等獎(jiǎng)項(xiàng)悉數(shù)公布,其中,最佳論文由德國(guó)馬普所和蒂賓根大學(xué)的兩位研究者摘得,最佳學(xué)生論文由加州理工學(xué)院、西北大學(xué)的多位研究者獲得。以下是關(guān)于本屆大會(huì)的詳細(xì)報(bào)道。今年的最佳論文是由德國(guó)馬普所和蒂賓根大學(xué)的兩位研究者摘得,獲獎(jiǎng)?wù)撐氖恰禛IRAFFE: Representing Scenes As Compositional Generative Neural Feature Fields》。

論文地址:https://arxiv.org/pdf/2011.12100.pdf深度生成模型允許以高分辨率進(jìn)行高真實(shí)感圖像合成。但對(duì)于許多應(yīng)用程序來(lái)說(shuō),這還不夠:內(nèi)容創(chuàng)建還需要可控。雖然近來(lái)一些工作研究了如何解開(kāi)數(shù)據(jù)中變化的潛在因素,但其中大多數(shù)是在 2D 場(chǎng)景下運(yùn)行的,而忽略了現(xiàn)實(shí)世界是 3D 的。此外,只有少數(shù)研究考慮了場(chǎng)景的構(gòu)圖性質(zhì)。而該研究的關(guān)鍵假設(shè)是將組合 3D 場(chǎng)景表征結(jié)合到生成模型中,以生成更加可控的圖像合成。通過(guò)將場(chǎng)景表征為組合的生成神經(jīng)特征場(chǎng),該研究能夠從背景中分離出一個(gè)或多個(gè)目標(biāo)以及單個(gè)目標(biāo)的形狀和外觀,同時(shí)從非結(jié)構(gòu)化和未定位的圖像集合中學(xué)習(xí),而無(wú)需任何額外的監(jiān)督。該研究通過(guò)將場(chǎng)景表征與神經(jīng)渲染 pipeline 相結(jié)合,得到了快速且逼真的圖像合成模型。實(shí)驗(yàn)表明,該模型能夠分離出單個(gè)目標(biāo),并允許在場(chǎng)景中平移和旋轉(zhuǎn)它們以及改變相機(jī)位姿。

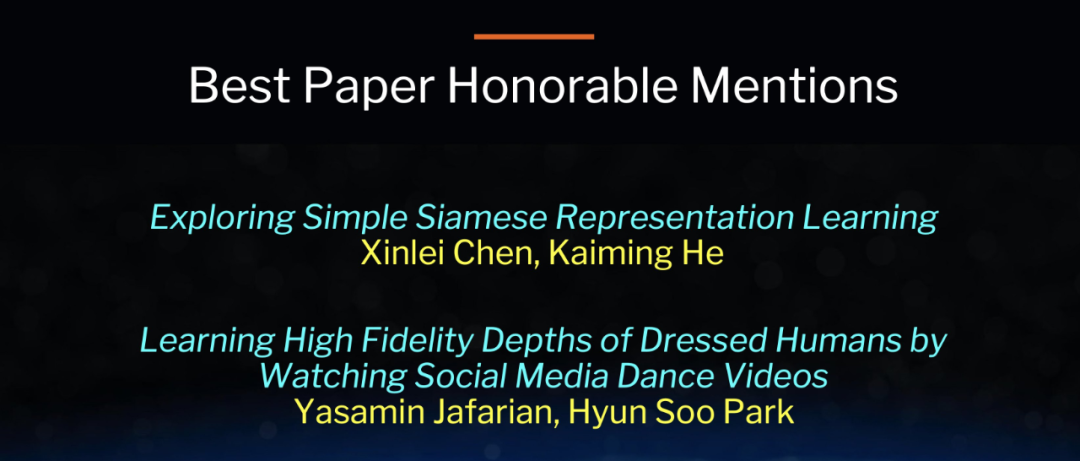

Michael Niemeyer 馬克斯·普朗克智能系統(tǒng)研究所 AVG 組計(jì)算機(jī)視覺(jué) / 機(jī)器學(xué)習(xí)方向的博士生,導(dǎo)師是 Andreas Geiger。他的研究重點(diǎn)是 3D 視覺(jué),并對(duì)機(jī)器從稀疏觀察中推斷出 3D 表征感興趣。此外,Niemeyer 重點(diǎn)關(guān)注神經(jīng)場(chǎng)景表征領(lǐng)域的研究。Niemeyer 本科畢業(yè)于德國(guó)科隆大學(xué),之后在圣安德魯斯大學(xué)獲得高級(jí)計(jì)算機(jī)科學(xué)碩士學(xué)位。今年獲得最佳論文提名的論文有兩篇,分別由 FAIR 和明尼蘇達(dá)大學(xué)的研究者摘得。

論文 1:《Exploring Simple Siamese Representation Learning》摘要:Siamese 網(wǎng)絡(luò)已成為各種無(wú)監(jiān)督視覺(jué)表征學(xué)習(xí)模型中的常見(jiàn)結(jié)構(gòu)。這些模型最大限度地提高了一個(gè)圖像的兩個(gè)增強(qiáng)之間的相似性,但需要滿足一定的條件,以避免模型崩潰。該論文給出了令人驚訝的實(shí)證結(jié)果,即使不使用以下任何一種形式,簡(jiǎn)單的 Siamese 網(wǎng)絡(luò)也可以學(xué)習(xí)有意義的表征:(i) 負(fù)樣本對(duì)、(ii)大 batch 和(iii)momentum 編碼器。實(shí)驗(yàn)證明,對(duì)于損失和結(jié)構(gòu)確實(shí)存在崩潰解 (collapsing solutions),但停止梯度操作在防止崩潰方面起著至關(guān)重要的作用。該論文提供了一個(gè)關(guān)于 stop-gradient 含義的假設(shè),并通過(guò)概念驗(yàn)證實(shí)驗(yàn)進(jìn)一步驗(yàn)證了這一假設(shè)。該研究提出的 SimSiam 方法在 ImageNet 和下游任務(wù)上獲得了具有競(jìng)爭(zhēng)力的結(jié)果。該研究希望這個(gè)簡(jiǎn)單的基線將激勵(lì)研究者重新思考 Siamese 體系架構(gòu)在無(wú)監(jiān)督表征學(xué)習(xí)中的作用。論文 2:《Learning High Fidelity Depths of Dressed Humans by Watching Social Media Dance Videos》論文作者:Yasamin Jafarian、Hyun Soo Park

作者機(jī)構(gòu):明尼蘇達(dá)大學(xué)

論文地址:https://arxiv.org/pdf/2103.03319.pdf

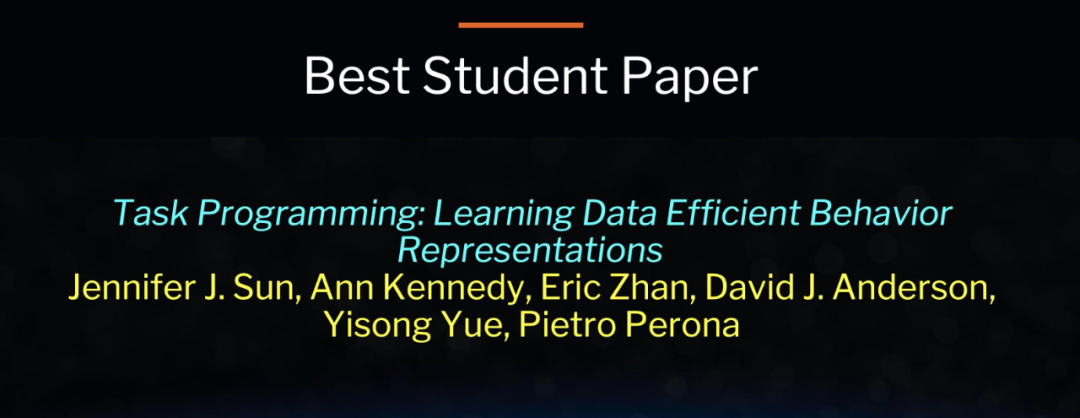

摘要:學(xué)習(xí)穿戴人體幾何的一個(gè)關(guān)鍵挑戰(zhàn)在于真值數(shù)據(jù)(如三維掃描模型)的有限可用性,這導(dǎo)致三維人體重建在應(yīng)用于真實(shí)世界圖像時(shí)性能下降。該研究通過(guò)利用一種新的數(shù)據(jù)資源來(lái)應(yīng)對(duì)這一挑戰(zhàn):大量的社交媒體舞蹈視頻,涵蓋了不同的外觀、服裝風(fēng)格、表演和身份。每個(gè)視頻描述了一個(gè)人的身體和衣服的動(dòng)態(tài)運(yùn)動(dòng),然而缺乏 3D 真值幾何。為了利用這些視頻,該研究提出了一種新的方法來(lái)使用局部變換,即將預(yù)測(cè)的局部幾何體從一幅圖像在不同的時(shí)刻扭曲到另一幅圖像。通過(guò)變換,預(yù)測(cè)的幾何可以通過(guò)來(lái)自其他圖像的扭曲幾何進(jìn)行自監(jiān)督。此外,該研究還通過(guò)最大化局部紋理、褶皺和陰影的幾何一致性,聯(lián)合學(xué)習(xí)深度以及對(duì)局部紋理、褶皺和陰影高度敏感的曲面法線。該研究的方法是端到端可訓(xùn)練的,可以產(chǎn)生高保真深度估計(jì)來(lái)預(yù)測(cè)精細(xì)幾何貼近輸入真實(shí)圖像。該論文表明所提方法在真實(shí)圖像和渲染圖像上都優(yōu)于 SOTA 人體深度估計(jì)和人體形狀恢復(fù)方法。今年的最佳學(xué)生論文由加州理工學(xué)院、西北大學(xué)的多位研究者獲得,獲獎(jiǎng)?wù)撐氖恰禩ask Programming: Learning Data Efficient Behavior Representations》。

論文地址:https://arxiv.org/pdf/2011.13917.pdf專業(yè)領(lǐng)域知識(shí)對(duì)于準(zhǔn)確注釋訓(xùn)練集以進(jìn)行深入分析通常是必需的,但從領(lǐng)域?qū)<夷抢铽@取這些知識(shí)可能既繁瑣又耗時(shí)。這個(gè)問(wèn)題在自動(dòng)化行為分析中尤為突出,該領(lǐng)域通常從視頻跟蹤數(shù)據(jù)中檢測(cè)出智能體運(yùn)動(dòng)或其他感興趣的動(dòng)作。為了減少注釋工作,該研究提出了 TREBA:一種基于多任務(wù)自監(jiān)督學(xué)習(xí),用于行為分析的學(xué)習(xí)注釋樣本有效軌跡嵌入的方法。該方法中的任務(wù)可以由領(lǐng)域?qū)<彝ㄟ^(guò)一種稱為「任務(wù)編程」的過(guò)程進(jìn)行有效設(shè)計(jì),該過(guò)程使用程序明確編碼來(lái)自領(lǐng)域?qū)<业慕Y(jié)構(gòu)化知識(shí)。通過(guò)構(gòu)建少量編程任務(wù)來(lái)?yè)Q取數(shù)據(jù)注釋時(shí)間,可以減少領(lǐng)域?qū)<业墓ぷ髁俊T撗芯渴褂脕?lái)自行為神經(jīng)科學(xué)的數(shù)據(jù)來(lái)評(píng)估這種權(quán)衡,其中使用專門(mén)的領(lǐng)域知識(shí)來(lái)識(shí)別行為。該研究在兩個(gè)領(lǐng)域(小鼠和果蠅)的三個(gè)數(shù)據(jù)集中展示了實(shí)驗(yàn)結(jié)果。與 SOTA 特征相比,使用來(lái)自 TREBA 的嵌入可以在不影響準(zhǔn)確率的情況下將注釋負(fù)擔(dān)減少 10 倍。該研究的結(jié)果表明,任務(wù)編程和自監(jiān)督可以成為減少領(lǐng)域?qū)<易⑨尮ぷ鞯挠行Х椒ā?/span>今年獲得最佳學(xué)生論文提名的論文有三篇,分別由北卡羅來(lái)納大學(xué)教堂山分校 & 微軟 Dynamics 365 AI Research、英偉達(dá) & 加州大學(xué)圣芭芭拉分校以及華盛頓大學(xué)的研究者摘得。

論文 1:《Less Is More: ClipBERT for Video-and-Language Learning via Sparse Sampling》論文作者:Jie Lei、Linjie Li、Luowei Zhou、Zhe Gan、Tamara L. Berg、Mohit Bansal、Jingjing Liu

作者機(jī)構(gòu):北卡羅來(lái)納大學(xué)教堂山分校、微軟 Dynamics 365 AI Research

論文地址:https://arxiv.org/pdf/2102.06183.pdf

摘要:視頻和語(yǔ)言學(xué)習(xí)的規(guī)范方法(例如,視頻問(wèn)答)要求神經(jīng)模型從視覺(jué)模型中離線提取的密集視頻特征和語(yǔ)言模型中的文本特征中學(xué)習(xí)。通常,這些特征提取器是獨(dú)立訓(xùn)練的,以用于與目標(biāo)域不同的任務(wù),但這些固定特征對(duì)于下游任務(wù)來(lái)說(shuō)不是最佳的。此外,由于密集視頻特征的計(jì)算量很大,通常很難(或不可行)將特征提取器直接插入現(xiàn)有方法中以方便微調(diào)。為了解決這個(gè)難題,該研究提出了一個(gè)通用框架 CLIPBERT,它通過(guò)采用稀疏采樣來(lái)實(shí)現(xiàn)視頻和語(yǔ)言任務(wù)的端到端學(xué)習(xí),而且在每個(gè)訓(xùn)練步驟中只需要使用一個(gè)或幾個(gè)稀疏采樣的視頻短片。在 6 個(gè)數(shù)據(jù)集上進(jìn)行的文本 - 視頻檢索和視頻問(wèn)答的實(shí)驗(yàn)表明,CLIPBERT 優(yōu)于(或與之媲美)利用全長(zhǎng)視頻(full-length videos)的現(xiàn)有方法,這表明僅使用幾個(gè)稀疏采樣的剪輯即可進(jìn)行端到端學(xué)習(xí)通常比使用從全長(zhǎng)視頻中密集提取的離線特征更準(zhǔn)確,證明了眾所周知的「少即是多」原則。數(shù)據(jù)集中的視頻來(lái)自不同的域和長(zhǎng)度,從 3 秒的通用域 GIF 視頻到 180 秒的 YouTube 人類活動(dòng)視頻,這顯示了該方法的泛化能力。此外,該研究還提供了全面的消融研究和徹底的分析,以剖析導(dǎo)致這種成功的因素。論文 2:《Binary TTC: A Temporal Geofence for Autonomous Navigation》論文作者:Abhishek Badki、Orazio Gallo、Jan Kautz、Pradeep Sen

作者機(jī)構(gòu):英偉達(dá)、加州大學(xué)圣芭芭拉分校

論文地址:https://arxiv.org/pdf/2101.04777.pdf

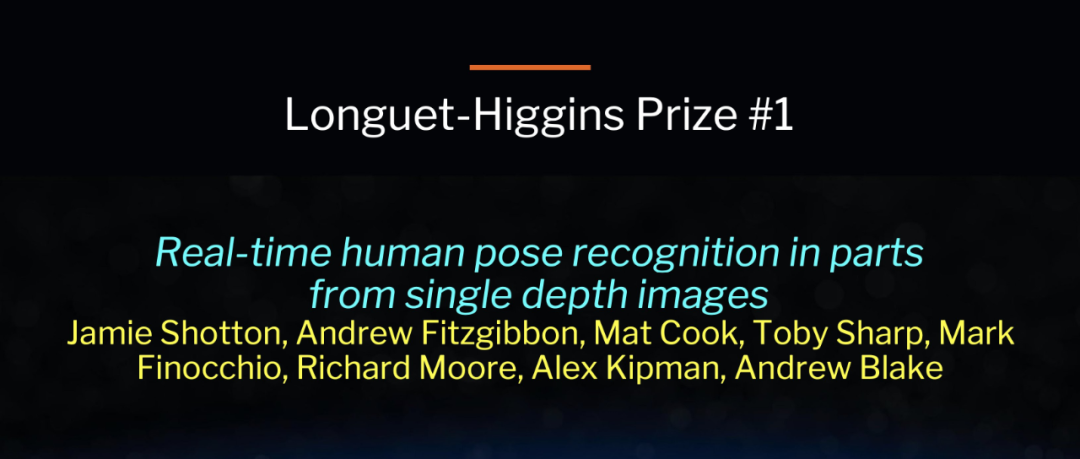

摘要:Time-to-contact (TTC) 是物體與觀測(cè)者水平碰撞的時(shí)間,是路徑規(guī)劃的有力工具:擁有比場(chǎng)景中物體的深度、速度和加速度更豐富的信息。TTC 有幾個(gè)優(yōu)點(diǎn),其中一個(gè)優(yōu)點(diǎn)是只需要一個(gè)單目、未經(jīng)校準(zhǔn)的攝像機(jī)。然而,回歸每個(gè)像素的 TTC 并不簡(jiǎn)單,現(xiàn)有的大多數(shù)方法對(duì)場(chǎng)景的假設(shè)都過(guò)于簡(jiǎn)化。該研究通過(guò)一系列簡(jiǎn)單的二元分類(binary classifications)來(lái)估計(jì) TTC 以解決這個(gè)問(wèn)題,并以低延遲預(yù)測(cè)觀測(cè)者是否會(huì)在特定時(shí)間內(nèi)與障礙物發(fā)生碰撞,這通常比精確每個(gè)像素的 TTC 更為關(guān)鍵。對(duì)于這種情況,該研究的方法在 6.4 毫秒內(nèi)提供了一個(gè)臨時(shí)地理圍欄(temporal geofence),比現(xiàn)有方法快 25 倍多。在計(jì)算預(yù)算允許的條件下,該方法也可以用任意精細(xì)量化(包括連續(xù)值)估計(jì)每像素(per-pixel)的 TTC。據(jù)了解,該方法是第一個(gè)以足夠高的幀率提供 TTC 信息(二進(jìn)制或粗量化)以供實(shí)際使用。論文 3:《Real-Time High-Resolution Background Matting》摘要:該論文提出了一種實(shí)時(shí)、高分辨率的背景替換技術(shù),該技術(shù)可以在 GPU 上以 30fps 速度運(yùn)行 4K 分辨率和以 60fps 的速度運(yùn)行高清分辨率。該技術(shù)是基于背景摳圖(background matting),其中一個(gè)額外的背景幀被捕獲,并用于通知 alpha 蒙版和前景層。該研究的主要挑戰(zhàn)是計(jì)算一個(gè)高質(zhì)量的 alpha 蒙版,在實(shí)時(shí)處理高分辨率圖像的同時(shí)保留頭發(fā)的細(xì)節(jié)。為了實(shí)現(xiàn)這個(gè)目標(biāo),該研究使用了兩個(gè)神經(jīng)網(wǎng)絡(luò);基礎(chǔ)網(wǎng)絡(luò)計(jì)算低分辨率結(jié)果,該結(jié)果由第二個(gè)網(wǎng)絡(luò)在選擇性 patch 上以高分辨率運(yùn)行。此外,還介紹了兩個(gè)大規(guī)模的視頻和圖像摳圖數(shù)據(jù)集:VideoMatte240K 和 PhotoMatte13K/85。與 SOTA 背景摳圖技術(shù)相比,該研究產(chǎn)生了更高質(zhì)量的結(jié)果相比,同時(shí)顯著提高了運(yùn)行速率和分辨率。除了論文獎(jiǎng)之外,大會(huì)還頒布了 PAMITC 獎(jiǎng),其中包括三個(gè)重要獎(jiǎng)項(xiàng),即往年設(shè)立的 Longuet-Higgins 獎(jiǎng)、青年研究者獎(jiǎng),以及在 CVPR 2020 設(shè)立、今年開(kāi)始頒發(fā)的 Thomas S. Huang 紀(jì)念獎(jiǎng)。Longuet-Higgins 獎(jiǎng)是 IEEE 計(jì)算機(jī)協(xié)會(huì)模式分析與機(jī)器智能(PAMI)技術(shù)委員會(huì)在每年的 CVPR 頒發(fā)的「計(jì)算機(jī)視覺(jué)基礎(chǔ)貢獻(xiàn)獎(jiǎng)」,表彰十年前對(duì)計(jì)算機(jī)視覺(jué)研究產(chǎn)生了重大影響的 CVPR 論文。該獎(jiǎng)項(xiàng)以理論化學(xué)家和認(rèn)知科學(xué)家 H. Christopher Longuet-Higgins 命名。今年獲得 Longuet-Higgins 獎(jiǎng)的論文有兩篇,分別是微軟研究者的《Real-Time Human Pose Recognition in Parts from Single Depth Images》和石溪大學(xué)研究者的《Baby Talk: Understanding and Generating Simple Image Descriptions》。論文 1:《Real-Time Human Pose Recognition in Parts from Single Depth Images》發(fā)表于 2011 年,作者來(lái)自于微軟劍橋研究院,目前被引用次數(shù)為 4110。論文主要介紹了基于單張深度圖像的實(shí)時(shí)人體姿態(tài)識(shí)別。

論文地址:https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/BodyPartRecognition.pdf論文 2:《Baby Talk: Understanding and Generating Simple Image Descriptions》也發(fā)表于 2011 年,研究者來(lái)自于石溪大學(xué),目前被引用次數(shù)為 1159。論文主要提出了一個(gè)從圖像自動(dòng)生成自然語(yǔ)言描述的系統(tǒng)。

論文地址:https://ieeexplore.ieee.org/document/5995466青年研究者獎(jiǎng)(Young Researcher Awards)旨在表彰年輕的科學(xué)家,鼓勵(lì)ta們繼續(xù)做出開(kāi)創(chuàng)性的工作。評(píng)選標(biāo)準(zhǔn)是獲獎(jiǎng)?wù)攉@得博士學(xué)位的年限少于 7 年。今年獲得該獎(jiǎng)項(xiàng)的研究者分別是 FAIR 的 Georgia Gkioxari 和 MIT 的 Phillip Isola。

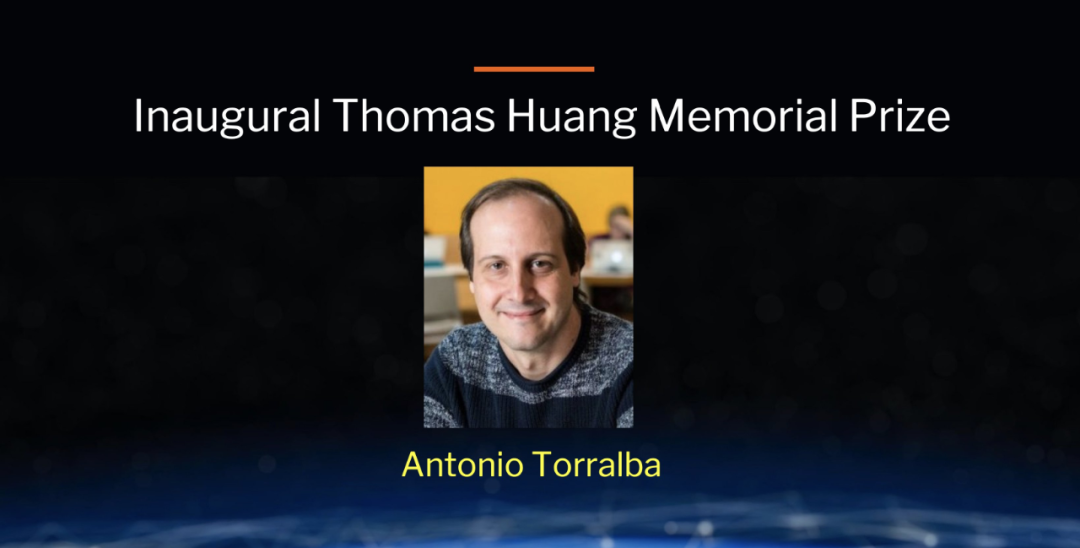

Georgia Gkioxari 現(xiàn)為 FAIR 的研究科學(xué)家。2010 年,她取得了雅典國(guó)家技術(shù)大學(xué)的學(xué)士學(xué)位。2016 年,她取得了加州大學(xué)伯克利分校的博士學(xué)位,導(dǎo)師為 Jitendra Malik。2016 年至今,她進(jìn)入 FAIR 擔(dān)任博士后研究員,并從 2018 年起擔(dān)任 FAIR 的研究科學(xué)家。Georgia Gkioxari 的主要研究領(lǐng)域是計(jì)算機(jī)視覺(jué),還是 PyTorch 3D 的開(kāi)發(fā)者之一以及 Mask R-CNN 的作者之一。個(gè)人主頁(yè):https://gkioxari.github.io/Phillip Isolas 是 MIT 電氣工程與計(jì)算機(jī)科學(xué)系的助理教授,主要研究方向?yàn)橛?jì)算機(jī)視覺(jué)、機(jī)器學(xué)習(xí)與 AI。2008 年,他取得了耶魯大學(xué)的計(jì)算機(jī)科學(xué)學(xué)士學(xué)位,2015 年獲得了 MIT 的認(rèn)知科學(xué)博士學(xué)位,2015-2017 年成為 UC 伯克利的博士后研究員,2017-2018 年擔(dān)任 OpenAI 的訪問(wèn)研究科學(xué)家,2018 年至今任職 MIT 助理教授。他在 Google Scholar 上的論文被引量達(dá)到 28056,h 指數(shù)為 33。個(gè)人主頁(yè):http://web.mit.edu/phillipi/Thomas S. Huang 紀(jì)念獎(jiǎng)為了紀(jì)念去年四月底去世的 Thomas S. Huang(黃煦濤)教授,PAMITC 獎(jiǎng)勵(lì)委員會(huì)去年批準(zhǔn)設(shè)立 Thomas S. Huang 紀(jì)念獎(jiǎng),以表彰在 CV 研究、教育和服務(wù)方面被公認(rèn)為楷模的研究人員。該獎(jiǎng)項(xiàng)從 2021 年開(kāi)始頒發(fā)。獲獎(jiǎng)?wù)咝枰玫讲┦繉W(xué)位至少 7 年,最好處于職業(yè)發(fā)展中期(不超過(guò) 25 年)。

黃教授是中國(guó)工程院外籍院士,中國(guó)科學(xué)院外籍院士,美國(guó)國(guó)家工程院院士,美籍華裔信息學(xué)家,美國(guó)伊利諾依大學(xué)(香檳分校)Beckman 研究院圖像實(shí)驗(yàn)室主任,于 2020 年 4 月 25 日夜(美國(guó)東部時(shí)間)在美國(guó)印第安納州逝世,享年 84 歲。黃煦濤教授在圖像處理、模式識(shí)別、計(jì)算機(jī)視覺(jué)等方面有不少原創(chuàng)性的研究成果,開(kāi)拓了新的研究領(lǐng)域。此獎(jiǎng)項(xiàng)的設(shè)立正是為了緬懷黃教授對(duì)計(jì)算機(jī)視覺(jué)領(lǐng)域的突出貢獻(xiàn)。

首屆 Thomas S. Huang 紀(jì)念獎(jiǎng)的獲獎(jiǎng)?wù)呤?MIT 電氣工程與計(jì)算機(jī)科學(xué)教授 Antonio Torralba。他的研究領(lǐng)域涉及計(jì)算機(jī)視覺(jué)、機(jī)器學(xué)習(xí)和人類視覺(jué)感知,并熱衷于構(gòu)建像人類一樣感知世界的系統(tǒng)。此外,他還對(duì)神經(jīng)網(wǎng)絡(luò)、常識(shí)推理、計(jì)算攝影、構(gòu)建圖像數(shù)據(jù)庫(kù)以及視覺(jué)藝術(shù)與計(jì)算之間的交互等其他領(lǐng)域頗有興趣。目前,Antonio Torralba 在 Google Schlor 上的論文總引用量高達(dá) 78736,h 指數(shù)為 111。

個(gè)人主頁(yè):https://groups.csail.mit.edu/vision/torralbalab/努力分享優(yōu)質(zhì)的計(jì)算機(jī)視覺(jué)相關(guān)內(nèi)容,歡迎關(guān)注:

個(gè)人微信(如果沒(méi)有備注不拉群!)請(qǐng)注明:地區(qū)+學(xué)校/企業(yè)+研究方向+昵稱

下載1:何愷明頂會(huì)分享

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):何愷明,即可下載。總共有6份PDF,涉及 ResNet、Mask RCNN等經(jīng)典工作的總結(jié)分析

下載2:終身受益的編程指南:Google編程風(fēng)格指南

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):c++,即可下載。歷經(jīng)十年考驗(yàn),最權(quán)威的編程規(guī)范!

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):CVPR,即可下載1467篇CVPR 2020論文 和 CVPR 2021 最新論文

點(diǎn)亮  ,告訴大家你也在看

,告訴大家你也在看

,告訴大家你也在看

,告訴大家你也在看