【論文解讀】當前最強長時序預(yù)測模型--Autoformer詳解

Autoformer: Decomposition Transformers with Auto-Correlation for Long-Term Series Forecasting

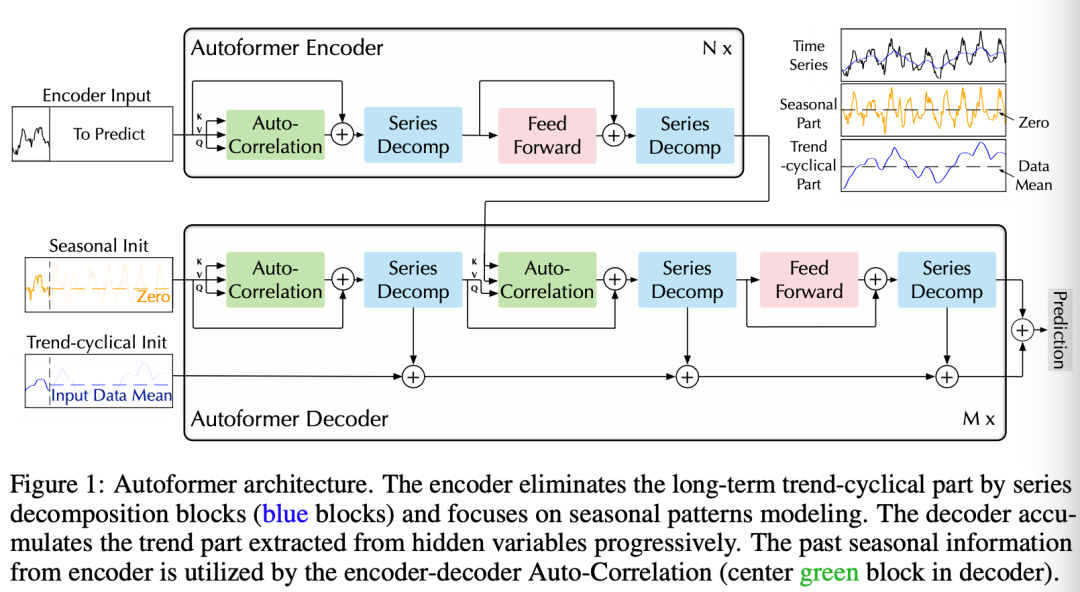

AutoFormer旨在研究長時間序列的預(yù)測問題。先前的基于Transformer的模型采用各種self-attention來挖掘長期依賴。長期復(fù)雜的時間模式阻礙了模型找到可靠的依賴關(guān)系。此外,Transformer必須采用稀疏版的point-wise self-attentions來捕捉較長時間的關(guān)聯(lián),這也造成了信息利用的瓶頸。AutoFormer基于Auto-Correlation機制的新型分解架構(gòu)。

我們將series的分解更新為模型的一個內(nèi)部模塊。這種設(shè)計使Autoformer具有復(fù)雜時間序列的漸進分解能力。另外,受隨機過程理論的啟發(fā),我們設(shè)計了基于序列周期性的自相關(guān)機制,在子序列級進行依賴項發(fā)現(xiàn)和表示聚合。

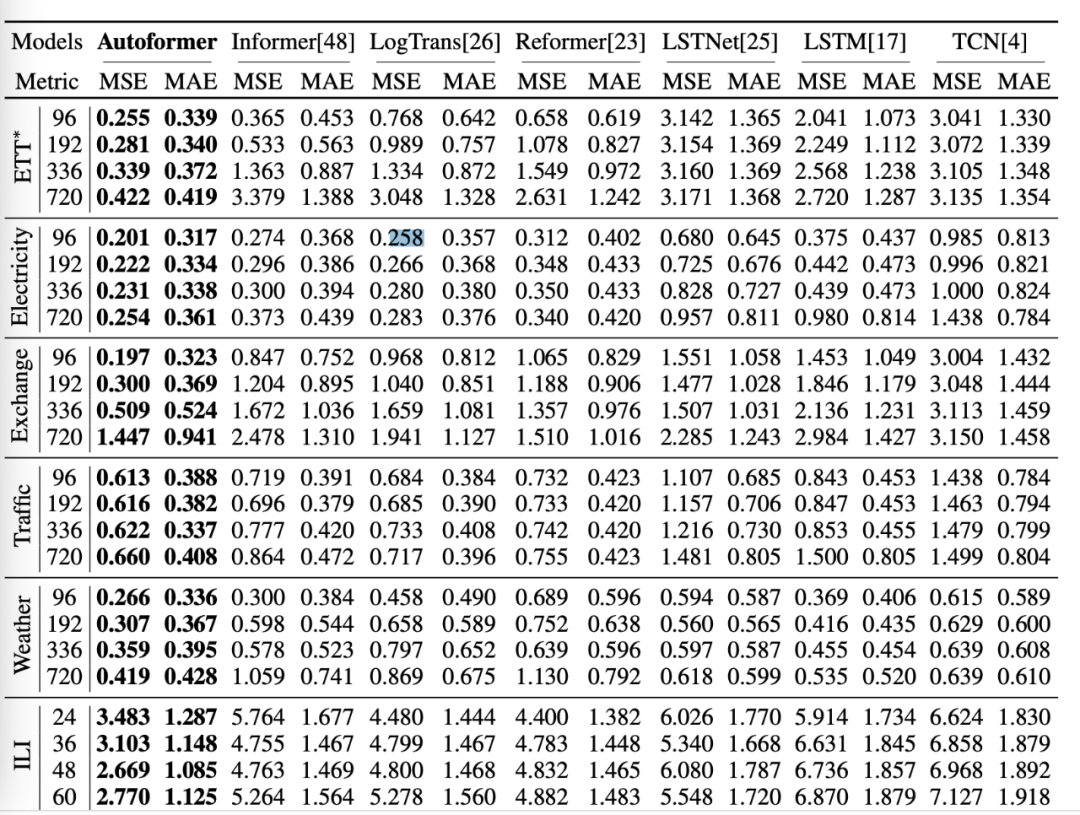

Auto-Correlation在效率和準確性上都優(yōu)于self-attention。在長期預(yù)測中,Autoformer具有最好的精度,在六個基準上相對提高了38%。

時間序列預(yù)測問題是根據(jù)過去的長度序列預(yù)測未來最可能的長度的序列,表示為。長期預(yù)測設(shè)置是預(yù)測長期未來,即更大的。

長期序列預(yù)測的困難:處理復(fù)雜的時間模式,打破計算效率和信息利用的瓶頸。

為了解決這兩個難題,我們將分解作為一個內(nèi)置模塊引入深度預(yù)測模型,并提出Autoformer作為一種分解架構(gòu)。此外,我們還設(shè)計了自相關(guān)機制來發(fā)現(xiàn)基于周期的依賴關(guān)系,并聚合來自底層周期的相似子序列。

Series decomposition block

我們將序列分解為trend-cyslical和周期的模塊,這兩個模塊可以反映序列的長期的progression和周期性。于是我們提出下面的框架:

對于長度為的序列,處理方式為:

其中,表示周期的和抽取的trend-cyclical部分。我們用表示moving average,使用。

Model inputs

encoder部分是過去個時間段, ,輸入到Autoformer decoder的部分包含周期性部分以及trend-cyclical部分,

其中:

表示周期的和trend-cyclical部分; 表示填充了0的placeholders和的均值;

Encoder

Encoder側(cè)重于季節(jié)性建模。Encoder的輸出包含過去的季節(jié)性信息,并將用作交叉信息,以幫助Decoder優(yōu)化預(yù)測結(jié)果。

假設(shè)我們有N個編碼器層。第l個編碼器層的總體方程如下:

具體地:

其中,

”_“表示刪除的trend部分;

Decoder

decoder包含兩部分,trend-cyclical成份的累積結(jié)構(gòu)和周期性分量的疊加自相關(guān)機制。每個decoder層包含內(nèi)在的Auto-Correlation和encoder-decoder Auto-Correlation部分。這樣就可以微調(diào)預(yù)測并且利用過去的周期性信息。

其中,表示第層的decoder。

是從編碼過來的用于深度轉(zhuǎn)化,并且用于累積。表示周期性的成份以及trend-cyclical部分。

表示第個抽取的trend 的映射。

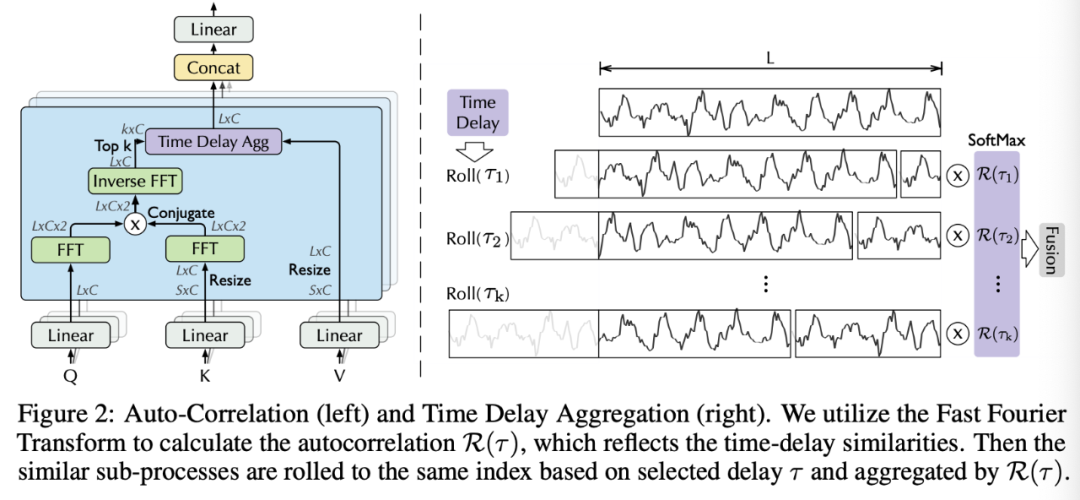

Auto-Correlation Mechanism

Period-based dependencies

可以觀察到:

周期之間相同的相位位置會提供類似的sub-process.

受到隨機過程理論的影響,對于一個真實的離散時間過程,我們可以得到自相關(guān)性,

表示以及它的延遲序列 ?的時延相似性,此處我們使用自相關(guān)表示估計周期長度的unnormalized的置信度。我們選擇最有可能的個周期長度,,

Time delay aggregation

基于周期的依賴關(guān)系將子序列連接到估計的周期中。因此,我們提出了時延聚合塊,

其中,用來獲取TopK相關(guān)性的論據(jù),我們令, 其中c是超參,是兩個序列和的自相關(guān),表示帶有時間延遲的操作,在此期間,移動到第一個位置之外的元素將在最后一個位置重新引入。

對于encoder-decoder的Auto-Correlation, 來自于encoder。

對于在Autoformer中的multi-head版本, channel的隱藏變量,有個頭,對于Q,K,V, ,

Efficient computation

對于基于周期的依賴關(guān)系,這些依賴關(guān)系指向處于基礎(chǔ)周期相同階段位置的子流程,并且本質(zhì)上是稀疏的。在這里,我們選擇最可能的延遲,以避免選擇相反的階段。

其中:

, 表示FFT, 是它的inverse, 表示conjugate操作, 表示頻域,所有在{1,2,...,L}的延遲序列的自相關(guān)性可以通過FFT一次計算得到,因此, Auto-Correlation可以獲得的復(fù)雜度。

Auto-Correlation and self-attention

與point-wise的self-attention家族不同, Auto-Correlation呈現(xiàn)出一系列的聯(lián)系。具體地,

對于時間依賴,我們基于周期性找到子序列之間的依賴關(guān)系。相比之下,自我關(guān)注家庭只計算分散點之間的關(guān)系。

盡管一些自我關(guān)注考慮了local的信息,但它們只利用這些信息來幫助發(fā)現(xiàn)點相關(guān)性。對于信息聚合,我們采用time delay塊來聚合來自底層周期的相似子序列。

由于固有的稀疏性和子序列級表示聚合,Auto-Correlation可以同時提高計算效率和信息利用率。

AutoFormer可以說是當前非常強的長時間序列模型,無論是效果還是速度上都存在較大的優(yōu)勢,建議大家自己實踐一下。

https://arxiv.org/pdf/2106.13008.pdf

往期精彩回顧