GPT-4強到離譜,OpenAI拒絕Open!首席科學家:開源并不明智,我...

?? 新智元報道??

編輯:Britta 好困【新智元導讀】OpenAI的聯(lián)合創(chuàng)始人Greg Brockman和首席科學家Ilya Sutskever評價GPT-4的性能,并對安全問題和開源的爭議進行解釋。

毫無疑問,GPT-4一經發(fā)布,就引爆了整個業(yè)界和學界。 憑借著自己強大的推理和多模態(tài)能力,引發(fā)了一眾熱議。 然鵝,GPT-4不是一個open的模型。

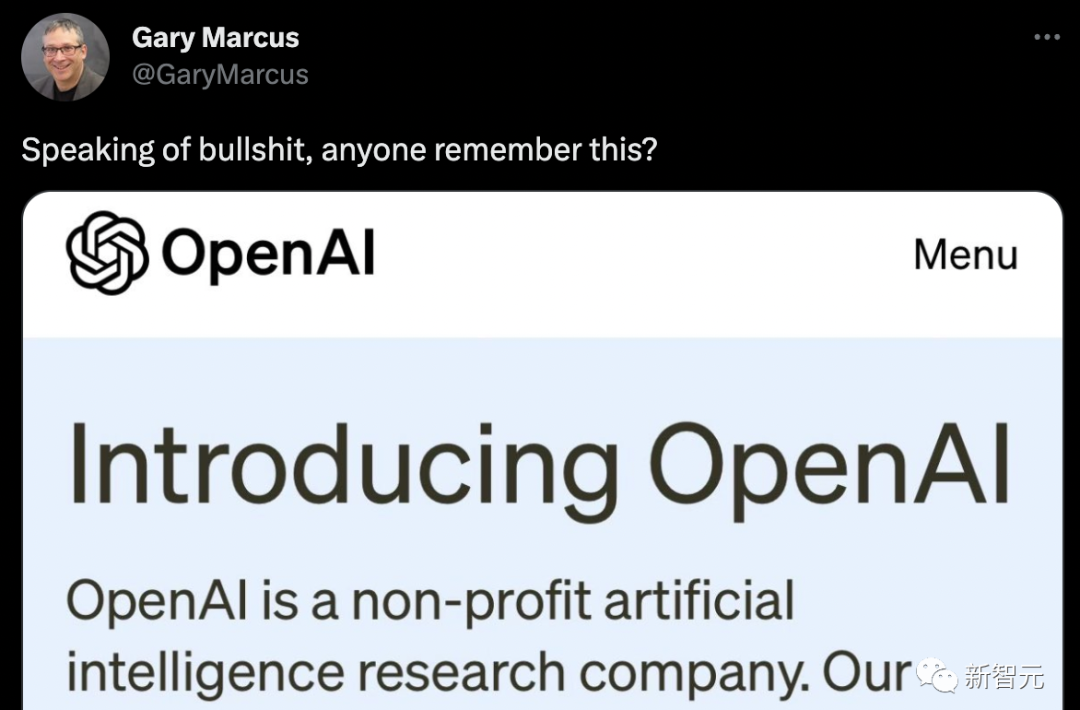

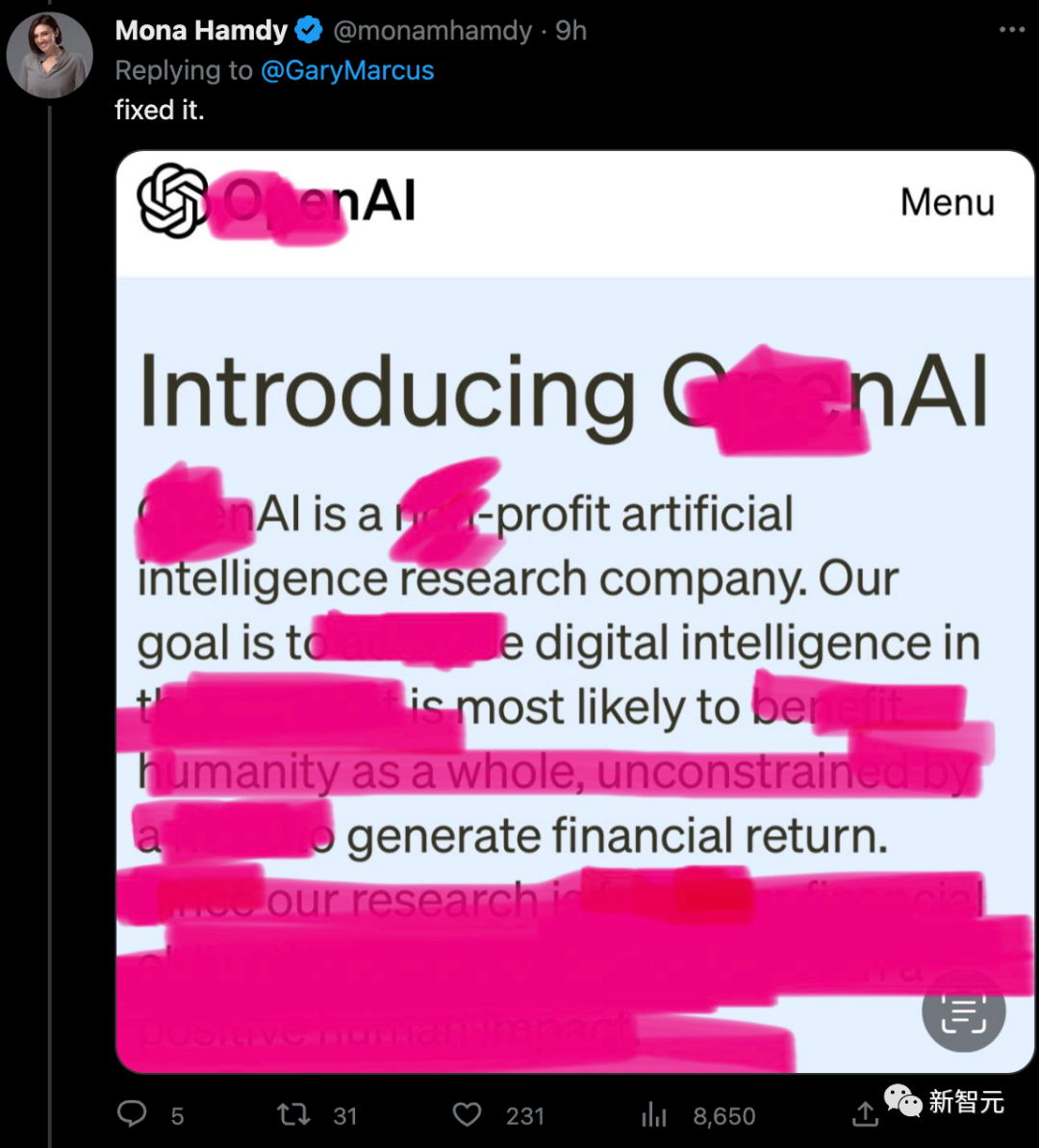

馬庫斯直接拿出當初OpenAI的初衷,發(fā)文嘲諷了一波。

網(wǎng)友改進了一個版本。

網(wǎng)友改進了一個版本。

人無完人,GPT-4也是

當OpenAI的總裁、聯(lián)合創(chuàng)始人之一Greg Brockman將GPT-4和GPT-3進行比較時,他說了一個詞——不同。 「它只是不同而已,模型仍然有很多問題和錯誤......但你真的可以看到它在微積分或法律等方面的技能提升。在某些領域,它從表現(xiàn)非常糟糕進化到現(xiàn)在足以匹敵人類。」

GPT-4的測試結果很不錯:在AP微積分BC考試中,GPT-4得了4分,而GPT-3得了1分。在模擬的律師考試中,GPT-4以大約前10%考生的分數(shù)通過;GPT-3.5的分數(shù)徘徊在后10%。

在上下文能力,也就是說在生成文本之前可以記憶的文本方面,GPT-4大約能夠記住50頁左右的內容,是GPT-3的8倍。

在提示方面,GPT-3和GPT-3.5只能接受文字提示:「寫一篇關于長頸鹿的文章」,而多模態(tài)的GPT-4可以接受圖片和文字的提示:給出一張長頸鹿的圖片,提示問「這里有多少只長頸鹿?」 這些GPT-4都能答對,而且它的讀梗能力也很強!

GPT-4的測試結果很不錯:在AP微積分BC考試中,GPT-4得了4分,而GPT-3得了1分。在模擬的律師考試中,GPT-4以大約前10%考生的分數(shù)通過;GPT-3.5的分數(shù)徘徊在后10%。

在上下文能力,也就是說在生成文本之前可以記憶的文本方面,GPT-4大約能夠記住50頁左右的內容,是GPT-3的8倍。

在提示方面,GPT-3和GPT-3.5只能接受文字提示:「寫一篇關于長頸鹿的文章」,而多模態(tài)的GPT-4可以接受圖片和文字的提示:給出一張長頸鹿的圖片,提示問「這里有多少只長頸鹿?」 這些GPT-4都能答對,而且它的讀梗能力也很強!

我們之前錯了,開源并不明智

而強到離譜的GPT-4一發(fā)布,便引起了大量研究人員和專家的興趣。但令人失望的是,OpenAI發(fā)布的GPT-4,不是「Open的AI模型。」 盡管OpenAI分享了大量GPT-4的基準、測試結果和有趣的演示,但基本上沒有提供用于訓練該系統(tǒng)的數(shù)據(jù)、能源成本或用于創(chuàng)建它的具體硬件或方法的相關信息。 之前Meta的LLaMa模型泄露的時候,就引發(fā)過一波關于開源的討論。不過,這次大家對于GPT-4封閉模型的最初反應是大部分都是負面的。

人工智能社區(qū)普遍認為,這不僅破壞了OpenAI作為研究機構的創(chuàng)始精神,而且讓其他人難以制定保障措施來應對威脅。

Nomic AI的信息設計副總裁Ben Schmidt表示,由于無法看到GPT-4是在什么數(shù)據(jù)上訓練的,大家很難知道該系統(tǒng)在什么地方是安全使用的,并提出修復方案。

「為了讓人們知道這個模型什么地方不起作用,OpenAI需要更好地了解GPT-4所做的事情以及其中的假設。我可不會在下雪的時候,相信一個沒有在雪地氣候情況下訓練出來的自動駕駛汽車。因為很可能,漏洞和問題只在真實使用的時候才會浮現(xiàn)。」

對此,OpenAI的首席科學家兼聯(lián)合創(chuàng)始人Ilya Sutskever解釋稱:OpenAI不分享更多關于GPT-4的信息是因為害怕競爭,也是因為對安全的擔憂,這一點是毋庸置疑的。

「外面的競爭很激烈,GPT-4的開發(fā)并不容易。幾乎所有的OpenAI的員工在一起工作了很長時間才生產出這個東西。從競爭的角度來看,有很多很多公司都想做同樣的事情,而GPT-4像是一個成熟的果實。」

人工智能社區(qū)普遍認為,這不僅破壞了OpenAI作為研究機構的創(chuàng)始精神,而且讓其他人難以制定保障措施來應對威脅。

Nomic AI的信息設計副總裁Ben Schmidt表示,由于無法看到GPT-4是在什么數(shù)據(jù)上訓練的,大家很難知道該系統(tǒng)在什么地方是安全使用的,并提出修復方案。

「為了讓人們知道這個模型什么地方不起作用,OpenAI需要更好地了解GPT-4所做的事情以及其中的假設。我可不會在下雪的時候,相信一個沒有在雪地氣候情況下訓練出來的自動駕駛汽車。因為很可能,漏洞和問題只在真實使用的時候才會浮現(xiàn)。」

對此,OpenAI的首席科學家兼聯(lián)合創(chuàng)始人Ilya Sutskever解釋稱:OpenAI不分享更多關于GPT-4的信息是因為害怕競爭,也是因為對安全的擔憂,這一點是毋庸置疑的。

「外面的競爭很激烈,GPT-4的開發(fā)并不容易。幾乎所有的OpenAI的員工在一起工作了很長時間才生產出這個東西。從競爭的角度來看,有很多很多公司都想做同樣的事情,而GPT-4像是一個成熟的果實。」

眾所周知,OpenAI在2015年成立之初是一個非營利組織。其創(chuàng)始人包括Sutskever、現(xiàn)任首席執(zhí)行官Sam Altman、總裁Greg Brockman以及現(xiàn)已離開OpenAI的馬斯克。

Sutskever等人曾表示,該組織的目標是為每個人創(chuàng)造價值,而不是單單為股東創(chuàng)造價值,并表示將與該領域的各方進行「自由合作」。

然而,為了獲得數(shù)十億美元的投資(主要來自微軟),OpenAI還是被加蓋了一層商業(yè)屬性。

不過,當被問及為什么OpenAI改變了分享其研究的方法時,Sutskever簡單地回答道:

眾所周知,OpenAI在2015年成立之初是一個非營利組織。其創(chuàng)始人包括Sutskever、現(xiàn)任首席執(zhí)行官Sam Altman、總裁Greg Brockman以及現(xiàn)已離開OpenAI的馬斯克。

Sutskever等人曾表示,該組織的目標是為每個人創(chuàng)造價值,而不是單單為股東創(chuàng)造價值,并表示將與該領域的各方進行「自由合作」。

然而,為了獲得數(shù)十億美元的投資(主要來自微軟),OpenAI還是被加蓋了一層商業(yè)屬性。

不過,當被問及為什么OpenAI改變了分享其研究的方法時,Sutskever簡單地回答道:

「我們錯了。在某個時候,AI/AGI將變得極其強大,那時,開源就是沒有意義的。可以預料的是,在幾年內,每個人都會完全明白,開源人工智能是不明智的。因為這個模型是非常有力的。如果有人想,用它就能夠造成巨大的傷害,這將是相當容易的。所以隨著模型的能力越來越高,不想披露它們是有道理的。」 Lightning AI的首席執(zhí)行官和開源工具PyTorch Lightning的創(chuàng)建者William Falcon從商業(yè)角度解讀稱:「作為一家公司,你完全有權利這樣做。」

安全風險

針對這一點,Brockman強調,他們花了很多時間試圖了解GPT-4的能力,而該模型已經經歷了六個月的安全培訓。在內部測試中,對于OpenAI的使用政策所不允許的內容,GPT-4作出反應的可能性比GPT-3.5低82%,產生「事實性」反應的可能性高40%。

不過,Brockman并不否認GPT-4在這方面的不足。但他強調了該模型的新的緩和導向工具,稱為「系統(tǒng)信息」的API級能力。

系統(tǒng)信息本質上是為GPT-4的互動設定基調,并建立界限的指令。這樣,以系統(tǒng)信息作為護欄,就可以防止GPT-4偏離方向。

例如,一條系統(tǒng)信息的人設可能是這樣的:「你是一個總是以蘇格拉底方式回答問題的導師。你從不給學生答案,而是總是試圖提出正確的問題,幫助他們學會自己思考。」

針對這一點,Brockman強調,他們花了很多時間試圖了解GPT-4的能力,而該模型已經經歷了六個月的安全培訓。在內部測試中,對于OpenAI的使用政策所不允許的內容,GPT-4作出反應的可能性比GPT-3.5低82%,產生「事實性」反應的可能性高40%。

不過,Brockman并不否認GPT-4在這方面的不足。但他強調了該模型的新的緩和導向工具,稱為「系統(tǒng)信息」的API級能力。

系統(tǒng)信息本質上是為GPT-4的互動設定基調,并建立界限的指令。這樣,以系統(tǒng)信息作為護欄,就可以防止GPT-4偏離方向。

例如,一條系統(tǒng)信息的人設可能是這樣的:「你是一個總是以蘇格拉底方式回答問題的導師。你從不給學生答案,而是總是試圖提出正確的問題,幫助他們學會自己思考。」

新的道路

英國人工智能政策負責人 Jess Whittlestone 說,平衡這些不同的壓力帶來了嚴重的治理挑戰(zhàn),這意味著我們可能需要第三方監(jiān)管機構參與。 「OpenAI 不分享關于 GPT-4 的更多細節(jié)的出發(fā)點是好的,但也可能導致人工智能世界的權力集中化。這些決定不應該由個別公司來做。」 Whittlestone 說:「理想的情況是,我們需要把這里的做法編纂成冊,然后讓獨立的第三方去審查與某些模型相關的風險。」 參考資料: https://techcrunch.com/2023/03/15/interview-with-openais-greg-brockman-gpt-4-isnt-perfect-but-neither-are-you/ https://www.theverge.com/2023/3/15/23640180/openai-gpt-4-launch-closed-research-ilya-sutskever-interview

評論

圖片

表情