這就是深度學(xué)習(xí)如此強(qiáng)大的原因

深度學(xué)習(xí):神經(jīng)網(wǎng)絡(luò)和函數(shù)

層的效果

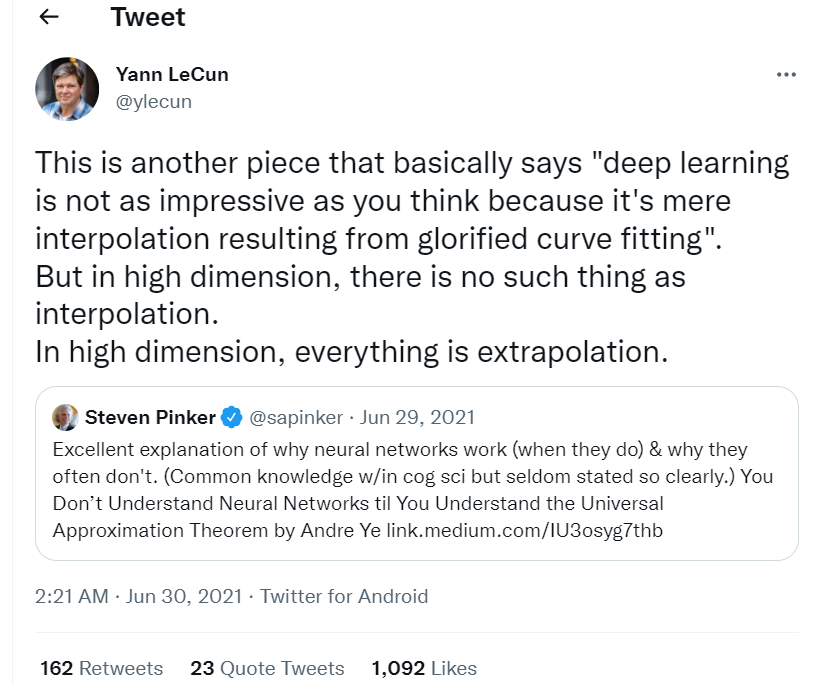

深度學(xué)習(xí)作為插值

學(xué)習(xí)方面

確保模型學(xué)習(xí)通用函數(shù),而不僅僅適合訓(xùn)練數(shù)據(jù);這是通過(guò)使用正則化處理的;

根據(jù)手頭的問(wèn)題,選擇損失函數(shù);松散地說(shuō),損失函數(shù)是我們想要的(真實(shí)值)和我們當(dāng)前擁有的(當(dāng)前預(yù)測(cè))之間的誤差函數(shù);

梯度下降是用于收斂到最優(yōu)函數(shù)的算法;決定學(xué)習(xí)率變得具有挑戰(zhàn)性,因?yàn)楫?dāng)我們遠(yuǎn)離最優(yōu)時(shí),我們想要更快地走向最優(yōu),而當(dāng)我們接近最優(yōu)時(shí),我們想要慢一些,以確保我們收斂到最優(yōu)和全局最小值;

大量隱藏層需要處理梯度消失問(wèn)題;跳過(guò)連接和適當(dāng)?shù)姆蔷€性激活函數(shù)等架構(gòu)變化,有助于解決這個(gè)問(wèn)題。

計(jì)算挑戰(zhàn)

要學(xué)習(xí)一個(gè)復(fù)雜的函數(shù),我們需要大量的數(shù)據(jù); 為了處理大數(shù)據(jù),我們需要快速的計(jì)算環(huán)境; 我們需要一個(gè)支持這種環(huán)境的基礎(chǔ)設(shè)施。

——The ?End——

分享

收藏

點(diǎn)贊

在看

評(píng)論

圖片

表情