超級芯片GH200發(fā)布,AI算力是H100兩倍

英偉達(dá)在計算機圖形學(xué)頂會 SIGGRAPH 2023 上發(fā)布了專為生成式 AI 打造的下一代 GH200 Grace Hopper 平臺,并推出了 OVX 服務(wù)器、AI Workbench 等一系列重磅更新。

五年前,也是在 SIGGRAPH 大會的演講中,英偉達(dá)宣布將 AI 和實時光線追蹤引入 GPU ,可以說,當(dāng)時的這個決定重塑了計算圖形學(xué)。

「我們意識到光柵化已經(jīng)達(dá)到了極限,」黃仁勛表示:「這要求我們重塑硬件、軟件和算法。在我們用 AI 重塑 CG 的同時,也在為 AI 重塑 GPU。」

預(yù)言應(yīng)驗了:幾年來,計算系統(tǒng)變得越來越強大,例如 NVIDIA HGX H100,它利用 8 個 GPU 和總共 1 萬億個晶體管,與基于 CPU 的系統(tǒng)相比,提供了顯著的加速。

「這就是世界數(shù)據(jù)中心迅速轉(zhuǎn)向加速計算的原因,」在今年的 SIGGRAPH 大會,黃仁勛重申:「The more you buy, the more you save.」

如今,訓(xùn)練越來越大的生成式 AI 模型所需的計算未必由具有一定 GPU 能力的傳統(tǒng)數(shù)據(jù)中心來完成,而是要依靠像 H100 這樣從一開始就為大規(guī)模運算而設(shè)計的系統(tǒng)。可以說,AI 的發(fā)展在某種程度上只受限于這些計算資源的可用性。

但黃仁勛斷言,這僅僅是個開始。新模型不僅需要訓(xùn)練時的計算能力,還需要實現(xiàn)由數(shù)百萬甚至數(shù)十億用戶實時運行的計算能力。

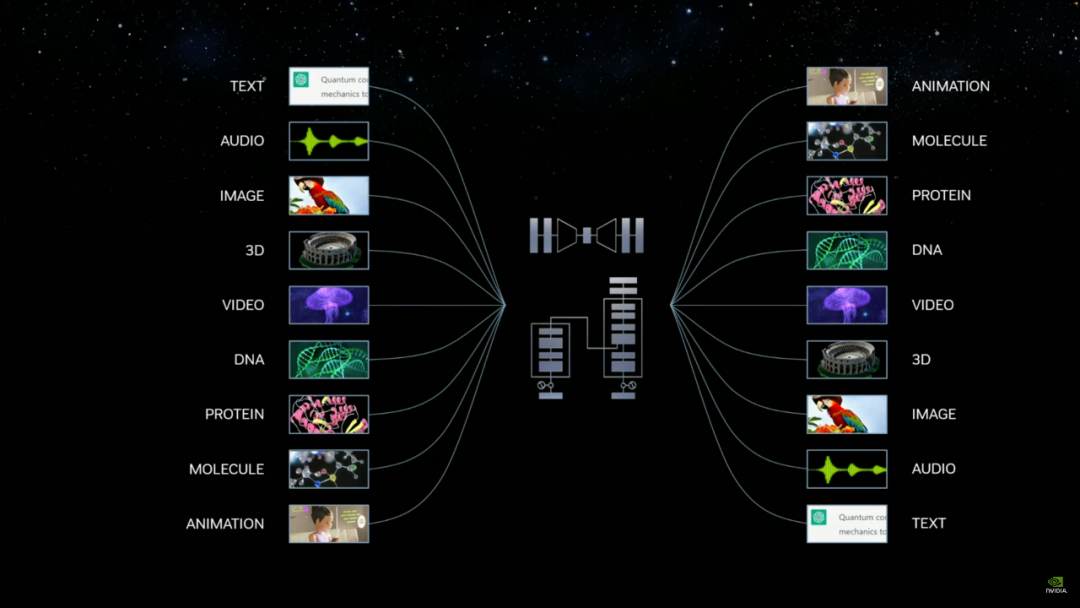

「未來,LLM 將出現(xiàn)在幾乎所有事物的前端:人類就是新的編程語言。從視覺效果到快速數(shù)字化的制造市場、工廠設(shè)計和重工業(yè),一切都將采用自然語言界面。」黃仁勛表示。

在這場一個多小時的演講中,黃仁勛帶來了一系列新發(fā)布,全部面向「生成式 AI」。

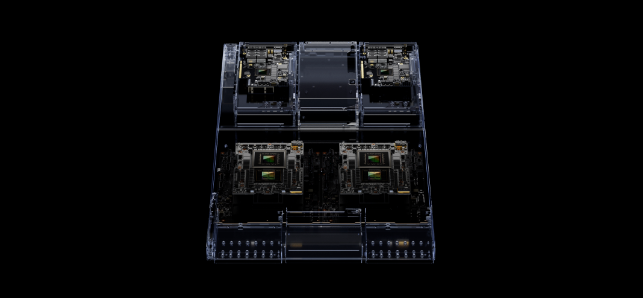

更強的 GH200 Grace Hopper 超級芯片平臺

英偉達(dá)的 Grace Hopper 超級芯片 NVIDIA GH200 結(jié)合了 72 核 Grace CPU 和 Hopper GPU,并已在 5 月全面投入生產(chǎn)。

現(xiàn)在,黃任勛又宣布 Grace Hopper 超級芯片將配備 HBM3e 高帶寬內(nèi)存(HBM3e 比當(dāng)前的 HBM3 快 50%),下一代 GH200 Grace Hopper 平臺將大幅提升生成式 AI 的計算速度。

全新的 GH200 內(nèi)存容量將增加至原有的 3.5 倍,帶寬增加至 3 倍,包含一臺具有 144 個 Arm Neoverse 核心、282GB HBM3e 內(nèi)存的服務(wù)器,提供 8 petaflops 的 AI 算力。

為了提升大模型的實際應(yīng)用效率,生成式 AI 模型的工作負(fù)載通常涵蓋大型語言模型、推薦系統(tǒng)和向量數(shù)據(jù)庫。GH200 平臺旨在全面處理這些工作負(fù)載,并提供多種配置。

英偉達(dá)表示,這款名為 GH200 的超級芯片將于 2024 年第二季度投產(chǎn)。

Nvidia AI Workbench,模型即服務(wù)

此外,為了加快全球企業(yè)定制化采用生成式 AI,老黃宣布英偉達(dá)即將推出 Nvidia AI Workbench。

盡管很多預(yù)訓(xùn)練模型都是開源的,但使其定制化服務(wù)自身業(yè)務(wù)仍然具有挑戰(zhàn)性。AI Workbench 減輕了企業(yè) AI 項目入門的復(fù)雜程度,將所有必要的企業(yè)級模型、框架、軟件開發(fā)套件和庫整合到統(tǒng)一的 workspace 之中。

只需要在本地系統(tǒng)上運行的簡化界面進行點擊,AI Workbench 就能讓開發(fā)者使用自定義數(shù)據(jù)微調(diào) Hugging Face、GitHub 和 NGC 等流行存儲庫中的模型,然后將其擴展到數(shù)據(jù)中心、公有云或 Nvidia DGX 云。

黃仁勛還宣布英偉達(dá)將與 Hugging Face 合作,開發(fā)人員將能夠訪問 Hugging Face 平臺中的 NVIDIA DGX Cloud AI 超級計算來訓(xùn)練和調(diào)整 AI 模型。這將使數(shù)百萬構(gòu)建大型語言模型和其他高級 AI 應(yīng)用程序的開發(fā)人員能夠輕松實現(xiàn)生成式 AI 超級計算。

「這將是一項全新的服務(wù),將世界上最大的人工智能社區(qū)與世界上最好的訓(xùn)練和基礎(chǔ)設(shè)施連接起來,」黃仁勛表示。

全新的 RTX 工作站和 Omniverse

老黃還宣布,英偉達(dá)與 BOXX、戴爾科技、惠普和聯(lián)想等工作站制造商合作,打造了一系列全新的高性能 RTX 工作站。

最新發(fā)布的 RTX 工作站提供多達(dá)四個英偉達(dá) RTX 6000 Ada GPU,每個 GPU 配備 48GB 內(nèi)存。單個桌面工作站可提供高達(dá) 5828 TFLOPS 的性能和 192GB 的 GPU 內(nèi)存。

根據(jù)用戶需求,這些系統(tǒng)可配置 Nvidia AI Enterprise 或 Omniverse Enterprise 軟件,為各種要求苛刻的生成式 AI 和圖形密集型工作負(fù)載提供必要的動力。這些新發(fā)布預(yù)計將于秋季推出。

新發(fā)布的 Nvidia AI Enterprise 4.0 引入了 Nvidia NeMo,這是一個用于構(gòu)建和定制生成式 AI 基礎(chǔ)模型的端到端框架。它還包括用于數(shù)據(jù)科學(xué)的 Nvidia Rapids 庫,并為常見企業(yè) AI 用例(例如推薦器、虛擬助理和網(wǎng)絡(luò)安全解決方案)提供框架、預(yù)訓(xùn)練模型和工具。

工業(yè)數(shù)字化平臺 Omniverse Enterprise 是 Nvidia 生態(tài)系統(tǒng)的另一個組成部分,讓團隊能夠開發(fā)可互操作的 3D 工作流程和 OpenUSD 應(yīng)用程序。Omniverse 利用其 OpenUSD 原生平臺,使全球分布的團隊能夠協(xié)作處理來自數(shù)百個 3D 應(yīng)用程序的完整設(shè)計保真度數(shù)據(jù)集。

此次英偉達(dá)主要升級了 Omniverse Kit(用于開發(fā)原生 OpenUSD 應(yīng)用和擴展程序的引擎),以及 NVIDIA Omniverse Audio2Face 基礎(chǔ)應(yīng)用和空間計算功能。開發(fā)者可以輕松地利用英偉達(dá)提供的 600 多個核心 Omniverse 擴展程序來構(gòu)建自定義應(yīng)用。

作為發(fā)布的一部分,英偉達(dá)還推出了三款全新的桌面工作站 Ada Generation GPU:Nvidia RTX 5000、RTX 4500 和 RTX 4000。

全新 NVIDIA RTX 5000、RTX 4500 和 RTX 4000 桌面 GPU 采用最新的 NVIDIA Ada Lovelace 架構(gòu)技術(shù)。其中包括增強的 NVIDIA CUDA 核心(用于增強單精度浮點吞吐量)、第三代 RT 核心(用于改進光線追蹤功能)以及第四代 Tensor 核心(用于更快的 AI 訓(xùn)練性能)。

Nvidia RTX 5000 Ada 一代 GPU。

這幾款 GPU 還支持 DLSS 3,為實時圖形提供更高水平的真實感和交互性,以及更大的 GPU 內(nèi)存選項,用于大型 3D 模型、渲染圖像、模擬和 AI 數(shù)據(jù)集的無差錯計算。此外,它們還提供擴展現(xiàn)實功能,以滿足創(chuàng)建高性能 AR、VR 和混合現(xiàn)實內(nèi)容的需求。

因為配備了第三代 RT Core,這幾款 GPU 的吞吐量高達(dá)上一代的 2 倍,使用戶能夠?qū)崟r處理更大、保真度更高的圖像,將應(yīng)用于藝術(shù)創(chuàng)作和設(shè)計生產(chǎn)。

RTX 5000 GPU 已經(jīng)上市,并由 HP 和分銷合作伙伴發(fā)貨,而 RTX 4500 和 RTX 4000 GPU 將于秋季從 BOXX、Dell Technologies、HP、Lenovo 及其各自的分銷合作伙伴上市。

Nvidia OVX 服務(wù)器

英偉達(dá)還推出了配備 Nvidia L40S GPU 的 Nvidia OVX 服務(wù)器,用于生成式 AI 和數(shù)字化時代的開發(fā)和內(nèi)容創(chuàng)作。

每臺 Nvidia OVX 服務(wù)器將支持多達(dá) 8 個 Nvidia L40S GPU,每個 GPU 配備 48GB 內(nèi)存。L40S GPU 由 Nvidia Ada Lovelace GPU 架構(gòu)提供支持,擁有第四代張量核心和 FP8 Transformer 引擎,可實現(xiàn)超過 1.45 petaflops 的張量處理能力。

Nvidia L40S GPU。

在具有數(shù)十億參數(shù)和多種數(shù)據(jù)模式的生成式 AI 工作負(fù)載領(lǐng)域,與 Nvidia A100 Tensor Core GPU 相比,L40S GPU 的生成式 AI 推理性能提高了 1.2 倍,訓(xùn)練性能提高了 1.7 倍。這將更好地滿足 AI 訓(xùn)練和推理、3D 設(shè)計和可視化、視頻處理和工業(yè)數(shù)字化等計算密集型應(yīng)用的需求,加速多個行業(yè)的工作流程和服務(wù)。

參考鏈接:

https://blogs.nvidia.com/blog/2023/08/08/siggraph-2023-special-address/

https://venturebeat.com/ai/nvidia-launches-rtx-workstations-chips-for-content-creation-in-the-generative-ai-era/

來源:機器之心

本號資料全部上傳至知識星球,更多內(nèi)容請登錄智能計算芯知識(知識星球)星球下載全部資料。

免責(zé)申明:本號聚焦相關(guān)技術(shù)分享,內(nèi)容觀點不代表本號立場,可追溯內(nèi)容均注明來源,發(fā)布文章若存在版權(quán)等問題,請留言聯(lián)系刪除,謝謝。

溫馨提示:

請搜索“AI_Architect”或“掃碼”關(guān)注公眾號實時掌握深度技術(shù)分享,點擊“閱讀原文”獲取更多原創(chuàng)技術(shù)干貨。