基于立體R-CNN的3D對象檢測

點擊上方“小白學視覺”,選擇加"星標"或“置頂”

重磅干貨,第一時間送達

雙目立體視覺是機器視覺的一種重要形式,其原理是基于視差圖像形成設備,使用從兩個不同位置獲取的物體圖像,通過計算圖像之間的對應點的位置偏差來獲得三個對象的三維幾何信息。

YOLO最初是由約瑟夫·雷德蒙(Joseph Redmon)創(chuàng)作的,用于檢測物體。物體檢測是一種計算機視覺技術,它通過在對象周圍繪制邊框并標識給定框也屬于的類標簽來對對象進行定位和標記。與大型NLP不同,YOLO設計得很小,可以為設備上的部署提供實時推理速度。

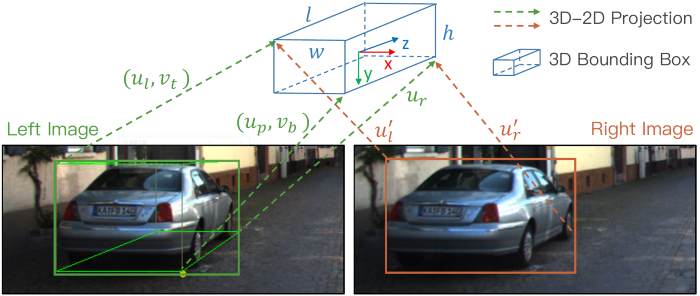

文獻[1]提出了一種在立體圖像方法中充分利用稀疏,密集,語義和幾何信息的三維物體檢測方法,稱為立體R-CNN,用于自動駕駛。

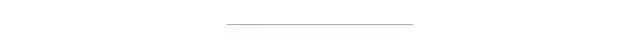

Stereo R-CNN的網(wǎng)絡體系結(jié)構(gòu)將輸出立體框,關鍵點,尺寸和視點角,然后輸出3D框估計和密集3D框?qū)R模塊。

Faster R-CNN擴展為立體信號輸入,以同時檢測和關聯(lián)左右圖像中的對象。稀疏的關鍵點,視點和對象尺寸是通過在三維區(qū)域提議網(wǎng)絡之后添加其他分支來預測的,該分支網(wǎng)絡與2D左右框組合以計算3D粗略對象邊界框。然后,通過使用左RoI和右RoI的基于區(qū)域的光度對齊來恢復準確的3D邊界框。

該方法不需要輸入深度和3D位置,但是效果比所有現(xiàn)有的基于完全監(jiān)督的圖像方法都要好。在具有挑戰(zhàn)性的KITTI數(shù)據(jù)集上進行的實驗表明,該方法在3D檢測和3D定位任務上的性能要比最先進的基于立體的方法好30%左右。

網(wǎng)絡架構(gòu)

立體RPN

該模型基于傳統(tǒng)的RPN網(wǎng)絡,首先從左右圖像中提取對位特征,然后將不同比例的特征連接在一起。特征提取后,利用3×3卷積層減少通道,然后是兩個同級完全連接的圖層,用于對每個輸入位置的對象性和回歸框偏移進行分類,并使用預定義的多尺度框進行錨定。對于客觀性分類,真值框定義為左右圖像的聯(lián)合GT框。

當與真值框的交集大于0.7時,錨點被標記為正樣本;如果小于0.3,則將錨點標記為正樣本。分類任務的候選幀包含左右真實值幀區(qū)域的信息。

RPN分類和回歸的不同目標分配。來源[1]

對于立體框回歸,他們計算重新定位到目標獲取聯(lián)合GT框中包含的左GT框和右GT框的正錨的偏移,然后分別為左回歸和右回歸指定偏移。

要返回的參數(shù)定義為[u,w,u',w',v,h],它們是左對象的水平位置和寬度,右對象的水平位置和寬度以及垂直位置和高度。因為輸入是校正后的左右圖像,所以可以認為左右對象在垂直方向上對齊。

每個左、右目的建議都是通過相同的錨生成的,并且自然而然地,左、右目的建議是相關的。通過NMS之后,保留左,右眼仍然存在的提案關聯(lián)對,進行前2000個培訓,并使用前300個進行測試。

立體R-CNN

在立體聲RPN之后,將ROI對齊操作應用于左右特征圖。對應于concat的左右ROI功能輸入到兩個連續(xù)的完全連接的層中。

使用四個分支分別預測:

對象類

與立體聲rpn一致的立體聲包圍盒,左右對象的高度已對齊;

尺寸,首先計算平均尺寸,然后預測相對數(shù)量;

視點角

這里的回歸部分與立體RPN一致,重點在于視點角度。

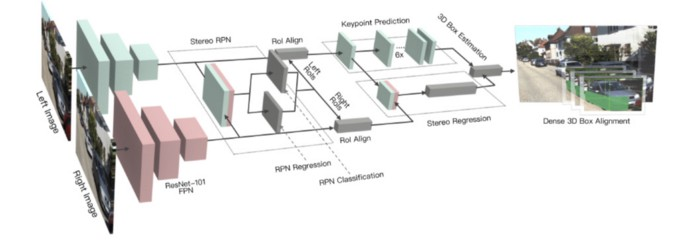

假設物體的方向為θ,并且汽車中心與相機中心之間的方位角為β,則視點的角度為α=θ+β。來源[1]

使用θ表示圖像每一幀中車輛的運動方向。β表示目標相對于相機中心的方位角。圖片中的三輛汽車具有不同的方向,但它們在ROI圖像上的投影完全相同。

定義回歸的視角α=θ+β以避免中斷,將訓練目標設置為[sinα,cosα]而不是角度值。

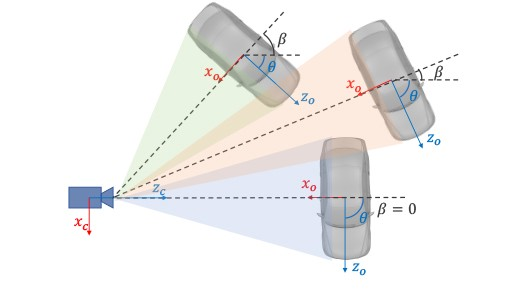

除了立體框和視點角之外,他們還注意到投影到邊界框的3D邊界框的角可以提供更嚴格的約束。

3D語義關鍵點,2D透視關鍵點和邊界關鍵點的說明。來源[1]

與Mask RCN?N?類似的結(jié)構(gòu)用于預測關鍵點。定義了四個3D語義關鍵點,即,車輛底部的3D角點。同時,將這四個點投影到圖像上以獲得四個透視關鍵點。這一點在3D bbox回歸中起作用,我們將在下一部分中介紹它。在關鍵點檢測任務中,使用Roi Align獲得的14 x 14特征圖。卷積和解卷積后,最終獲得6 x 28 x 28的特征圖。

為了簡化計算,它們將高度通道求和并將6×28×28轉(zhuǎn)換為6×28,其中前4個通道代表將4個關鍵點投影到相應的u坐標的概率,后兩個通道代表概率左右邊界上的關鍵點的集合。

3D Box估計

使用稀疏關鍵點信息和2D邊界框信息,可以估算出粗糙的3D邊界框。

3D包圍盒的狀態(tài)被定義為x = {x,y,z,θ},其分別表示3D中心的點坐標和水平方向上的偏轉(zhuǎn)角。

給定左右2D邊界框,透視關鍵點和回歸尺寸,可以通過最小化二維反投影的誤差來獲得3D邊界框。

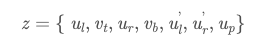

從立體邊界框和透視關鍵點中提取了七個測量參數(shù):

它們表示左2D邊界框的左,上,右和下邊界,右2D邊界框的左和右半徑以及透視關鍵點坐標u。每個參數(shù)都需要通過相機內(nèi)部參數(shù)進行歸一化。給定透視關鍵點,可以推斷出3D邊界框的角和2D邊界框的邊緣之間的對應關系。

密集3D框?qū)R

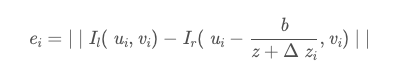

對于左圖像中有效ROI區(qū)域的每個歸一化像素坐標值,圖像誤差定義為:

I l,Ir代表左右圖像透視圖的三通道RGB矢量。和,

是像素i和3D邊界框中心的深度偏差值,b是基線的長度,只有z是我們需要求解Objective變量的值。

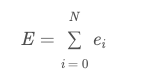

他們使用雙線性插值來獲取正確圖像中的子像素值。當前的匹配成本定義為覆蓋有效ROI區(qū)域中所有像素的平方差之和:

中心點深度值z可以通過最小化當前匹配成本E來計算。我們可以通過枚舉深度值來加快最小化成本的過程。我們枚舉初始值周圍每0.5米總共有50個深度值,以得到一個粗略的深度值,然后枚舉每0.05米周圍就總共有20個深度值,以得到一個精確的深度值。

該方法避免了在全局深度估計過程中由一些無效像素引起的中斷問題,并且整個方法更加健壯。

參考文獻

Li, Peiliang, Xiaozhi Chen, and Shaojie Shen. “Stereo R-CNN based 3D Object Detection for Autonomous Driving.” arXiv preprint arXiv:1902.09738 (2019).

Chabot, M. Chaouch, J. Rabarisoa, C. Teuli`ere, and T. Chateau. Deep manta: A coarse-to-fine many-task net-work for joint 2d and 3d vehicle analysis from monocularimage. InProc. IEEE Conf. Comput. Vis. Pattern Recog-nit.(CVPR), pages 2040–2049, 2017.

J.-R. Chang and Y.-S. Chen. Pyramid stereo matching net-work. InProceedings of the IEEE Conference on ComputerVision and Pattern Recognition, pages 5410–5418, 2018.

X. Chen, K. Kundu, Z. Zhang, H. Ma, S. Fidler, and R. Urta-sun. Monocular 3d object detection for autonomous driving.InEuropean Conference on Computer Vision, pages 2147–2156, 2016.

X. Chen, K. Kundu, Y. Zhu, H. Ma, S. Fidler, and R. Urtasun.3d object proposals using stereo imagery for accurate objectclass detection. InTPAMI, 2017.

X. Chen, H. Ma, J. Wan, B. Li, and T. Xia. Multi-view 3dobject detection network for autonomous driving. InIEEECVPR, volume 1, page 3, 2017.

M. Engelcke, D. Rao, D. Z. Wang, C. H. Tong, and I. Posner.Vote3deep: Fast object detection in 3d point clouds usingefficient convolutional neural networks. InRobotics and Au-tomation (ICRA), 2017 IEEE International Conference on,pages 1355–1361. IEEE, 2017.

A. Geiger, P. Lenz, and R. Urtasun. Are we ready for au-tonomous driving? the kitti vision benchmark suite. InCom-puter Vision and Pattern Recognition (CVPR), 2012 IEEEConference on, pages 3354–3361. IEEE, 2012

交流群

歡迎加入公眾號讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動駕駛、計算攝影、檢測、分割、識別、醫(yī)學影像、GAN、算法競賽等微信群(以后會逐漸細分),請掃描下面微信號加群,備注:”昵稱+學校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺SLAM“。請按照格式備注,否則不予通過。添加成功后會根據(jù)研究方向邀請進入相關微信群。請勿在群內(nèi)發(fā)送廣告,否則會請出群,謝謝理解~