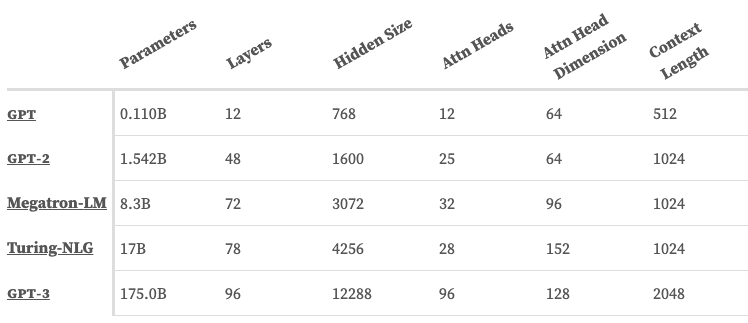

1750億參數(shù),GPT-3卻并不「智能」

??新智元報(bào)道??

??新智元報(bào)道??

來(lái)源:leogao.dev

編輯:白峰

【新智元導(dǎo)讀】擁有1750億參數(shù)的GPT-3取得了驚人的進(jìn)步,但它并不是通用人工智能。GPT-3讓我們看到了語(yǔ)言模型的能力,能否利用這種能力構(gòu)建出一個(gè)模型,更好地理解周?chē)氖澜纾?/span>

? ? ??

? ? ???

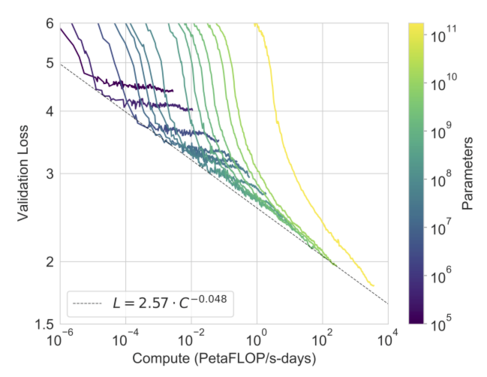

GPT-3解決的問(wèn)題變多了,但只是堆了更多參數(shù)

? ? ? ?

? ? ? ? 馬爾科夫鏈

馬爾科夫鏈 ? ? ? ?

? ? ? ? ? ? ?

? ? ??

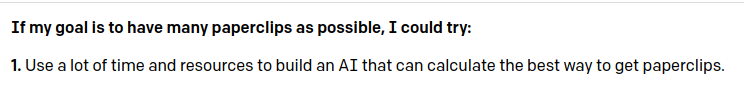

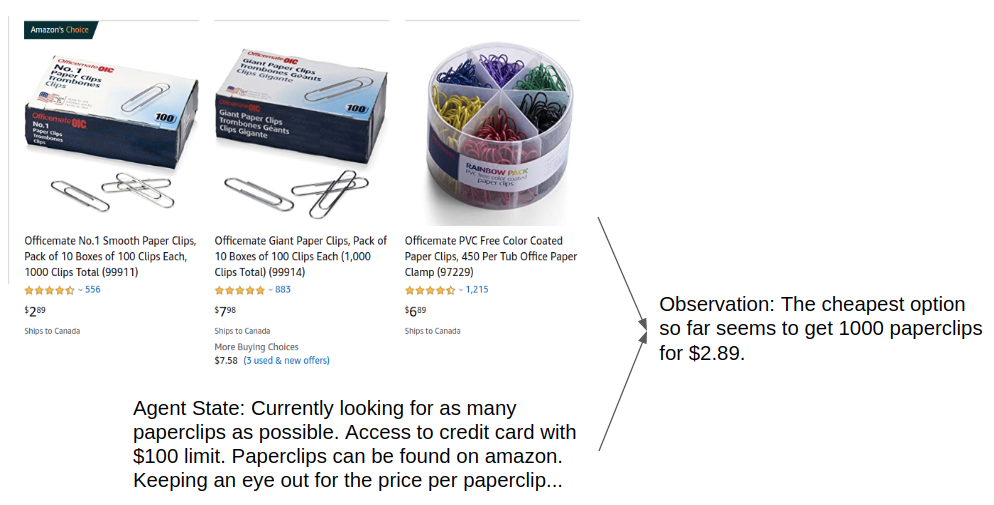

語(yǔ)言模型如何找到「亞馬遜上最便宜的曲別針」

? ? ? ?GPT-3告訴你獲取更多曲別針的方法(來(lái)源: OpenAI API)

? ? ? ?GPT-3告訴你獲取更多曲別針的方法(來(lái)源: OpenAI API)?? ? ? ? ? ? ? ?

? ? ? ?

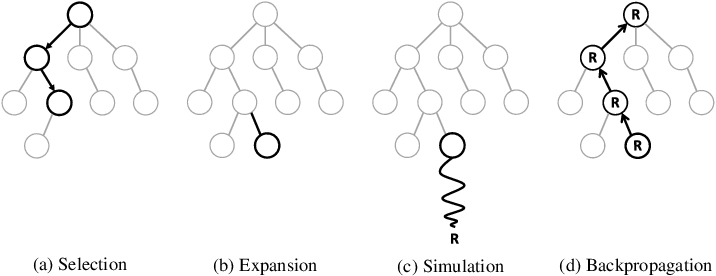

蒙特卡洛樹(shù)搜索

?

每一個(gè)動(dòng)作都可能是非常高級(jí)的,比如「找出買(mǎi)曲別針最便宜的方式」 ,但得益于語(yǔ)言的靈活性,我們可以用簡(jiǎn)短的token序列來(lái)描述非常復(fù)雜的想法。

?

一旦智能體決定了一個(gè)行動(dòng),為了實(shí)際執(zhí)行這些抽象行動(dòng),這個(gè)行動(dòng)可以使用語(yǔ)言模型分解成更小的子目標(biāo),比如「找出亞馬遜上最便宜的曲別針」 ,類(lèi)似于層次強(qiáng)化學(xué)習(xí)。

根據(jù)模型的能力和動(dòng)作的抽象程度,甚至可以將動(dòng)作分解成一個(gè)詳細(xì)的指令列表。我們也可以將智能體的狀態(tài)表示為自然語(yǔ)言。

?

由于智能體狀態(tài)只是觀測(cè)值的壓縮表示,因此我們可以讓語(yǔ)言模型對(duì)任何觀測(cè)值的重要信息進(jìn)行匯總,以表示其自身的內(nèi)部世界狀態(tài)。語(yǔ)言模型也可以用來(lái)周期性地刪除(即忘記)狀態(tài)中的信息,以便為更多的觀測(cè)留出空間。

?

這樣我們就能得到一個(gè)系統(tǒng),它可以從外部世界傳遞觀測(cè)信息,花一些時(shí)間思考該做什么,并用自然語(yǔ)言輸出一個(gè)動(dòng)作。

?

打頭的是一個(gè)輸入模塊,可以將各種觀測(cè)轉(zhuǎn)換為與當(dāng)前智能體狀態(tài)相關(guān)的摘要文本。例如,網(wǎng)頁(yè)、聲音、圖像都可以想辦法轉(zhuǎn)換為文本并映射到智能體的狀態(tài)。

?

最后,為了讓模型在現(xiàn)實(shí)世界真正發(fā)揮作用,可以再次使用語(yǔ)言模型將自然語(yǔ)言翻譯成代碼、 shell 命令、按鍵序列等許多可能的方式。

?

像輸入一樣,有無(wú)數(shù)種不同的方法來(lái)解決輸出問(wèn)題,哪一種方法是最好要看你的具體使用場(chǎng)景了,最重要的是,可以從純文本智能體中獲得各種形式的輸入和輸出。

? ? ? ?

一個(gè)輸入模塊的示例,該模塊采用截圖輸入與當(dāng)前智能體狀態(tài)相結(jié)合的方式,將圖片信息轉(zhuǎn)換為智能體的觀測(cè)。

?

當(dāng)然,這更像一個(gè)思想實(shí)驗(yàn)

當(dāng)然,這更像一個(gè)思想實(shí)驗(yàn)

上文所描述的,更像是一個(gè)思想實(shí)驗(yàn),而不是明天將要發(fā)生的事情。

?

這種方法在很大程度上依賴(lài)于一個(gè)主要假設(shè)——更大的未來(lái)模型將具有更好的世界建模能力。然而,這可能是我們有史以來(lái)最接近AGI的機(jī)會(huì):現(xiàn)在有了一條通往 AGI 的具體路徑。

?

這個(gè)路徑聽(tīng)上去不那么「扯淡」,未來(lái)能否實(shí)現(xiàn)讓我們拭目以待。

參考:

https://leogao.dev/2019/10/27/The-Difficulties-of-Text-Generation-with-Autoregressive-Language-Models/