點擊上方 “視學(xué)算法 ”,選擇加" 星標(biāo) "或“ 置頂 ”

重磅干貨,第一時間送達(dá)

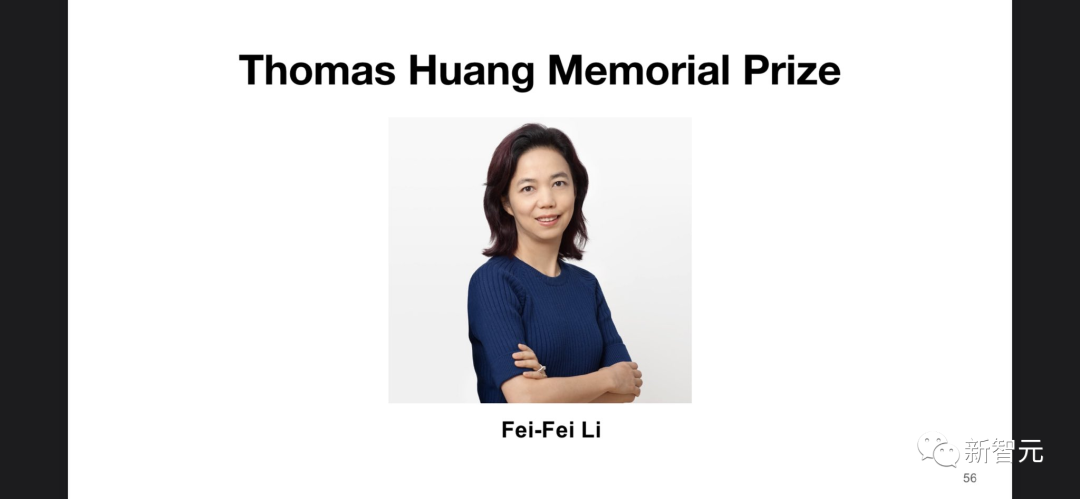

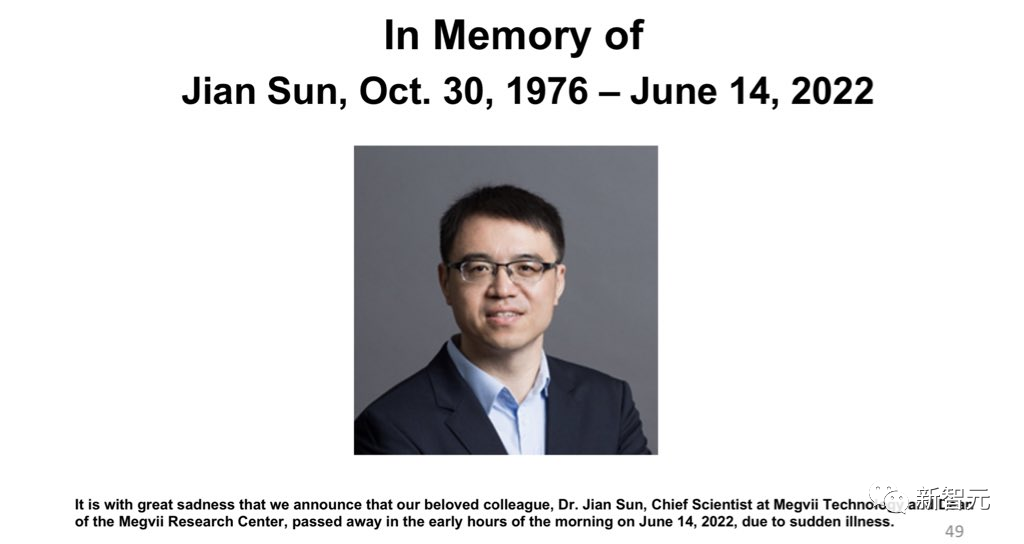

2 年沒見,CVPR 2022終于來線下了,6000人參會火爆。最佳論文花落蘇黎世理工,同濟(jì)、阿里摘最佳學(xué)生論文桂冠。斯坦福大學(xué)教授李飛飛榮獲「黃煦濤紀(jì)念獎」。此外,大會現(xiàn)場還播放了一段視頻,緬懷孫劍博士。

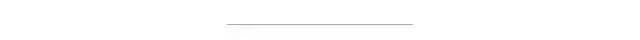

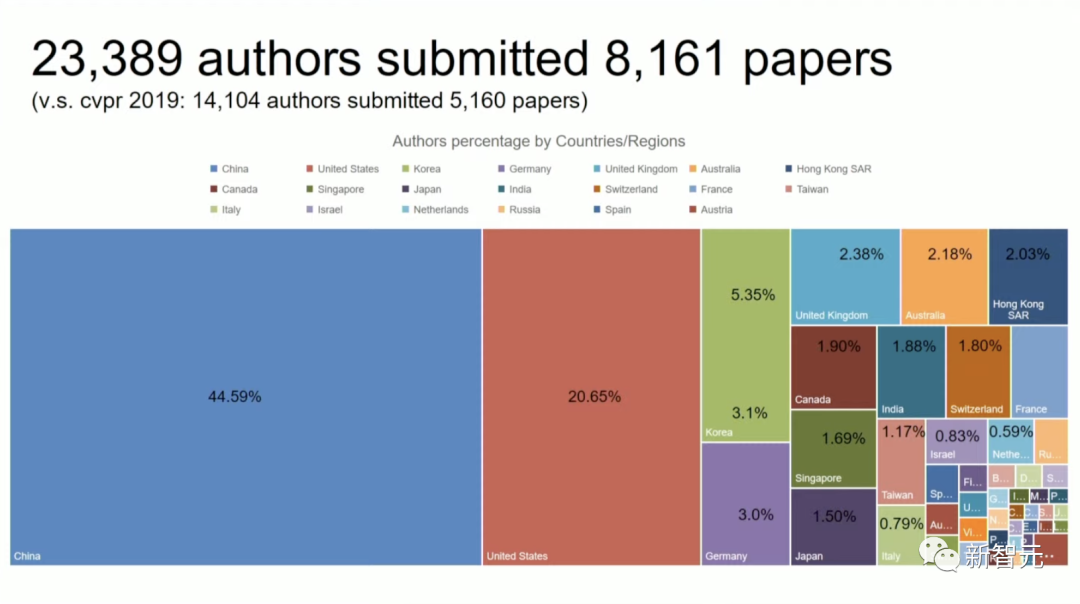

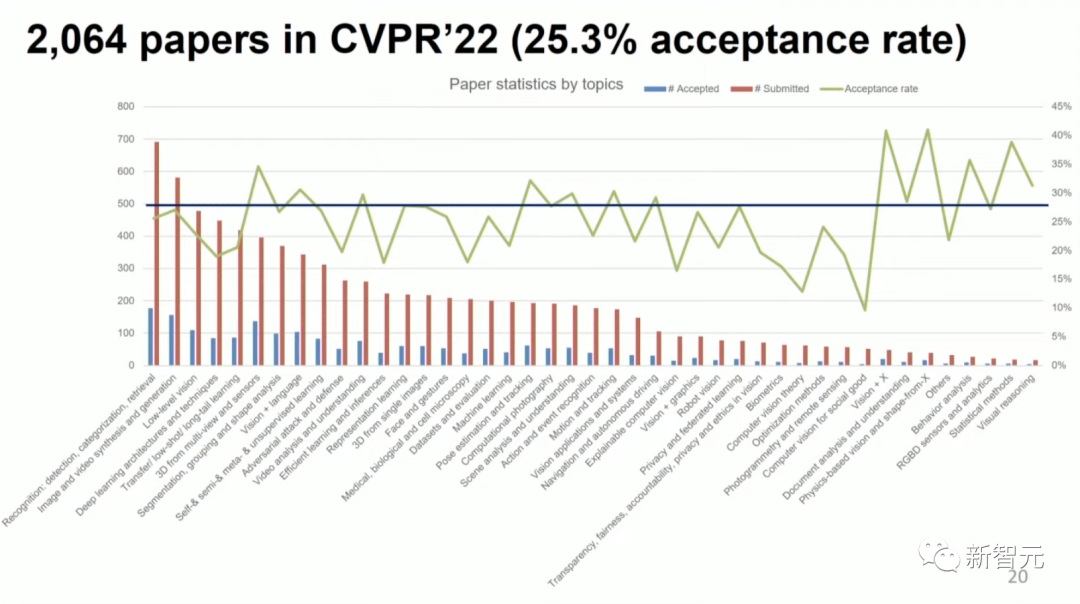

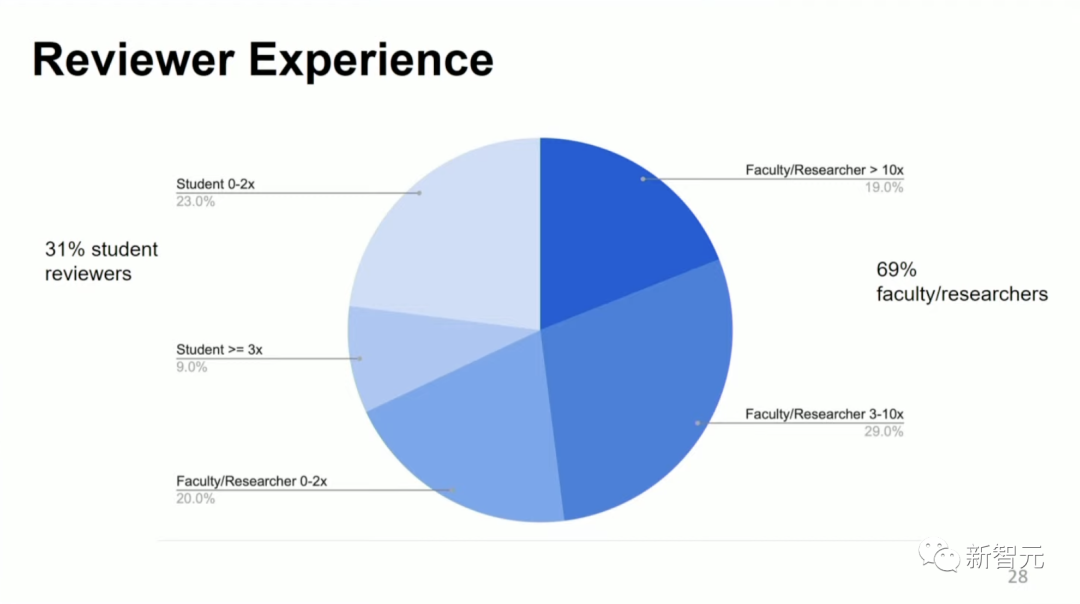

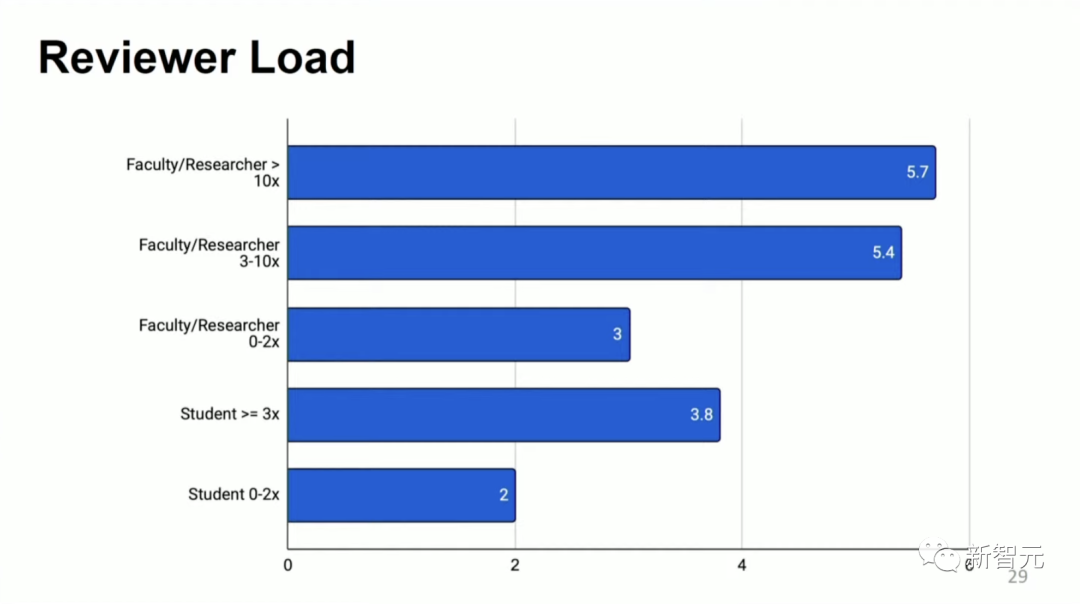

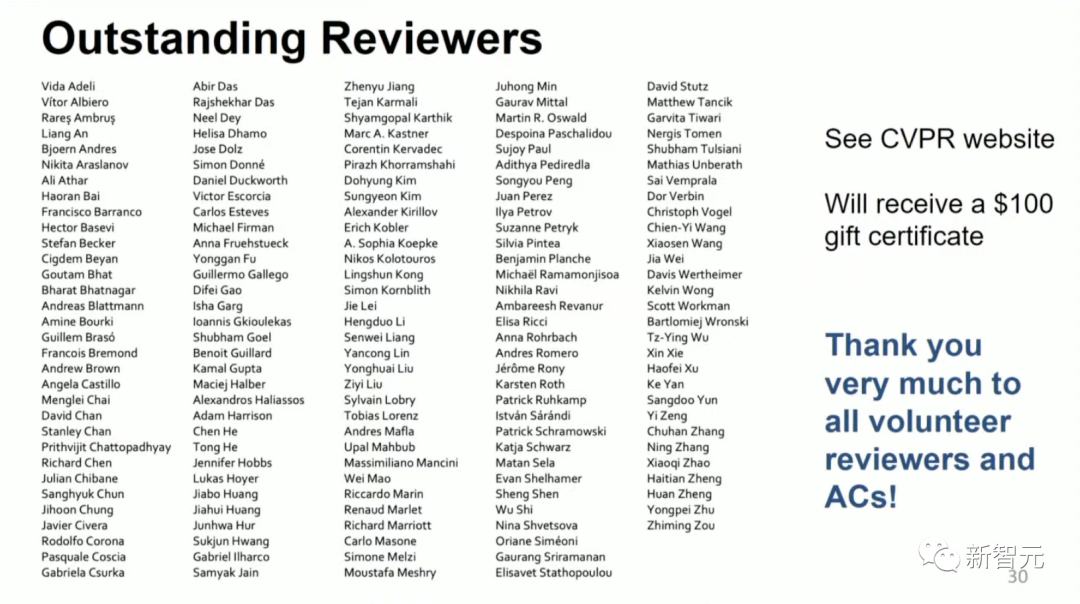

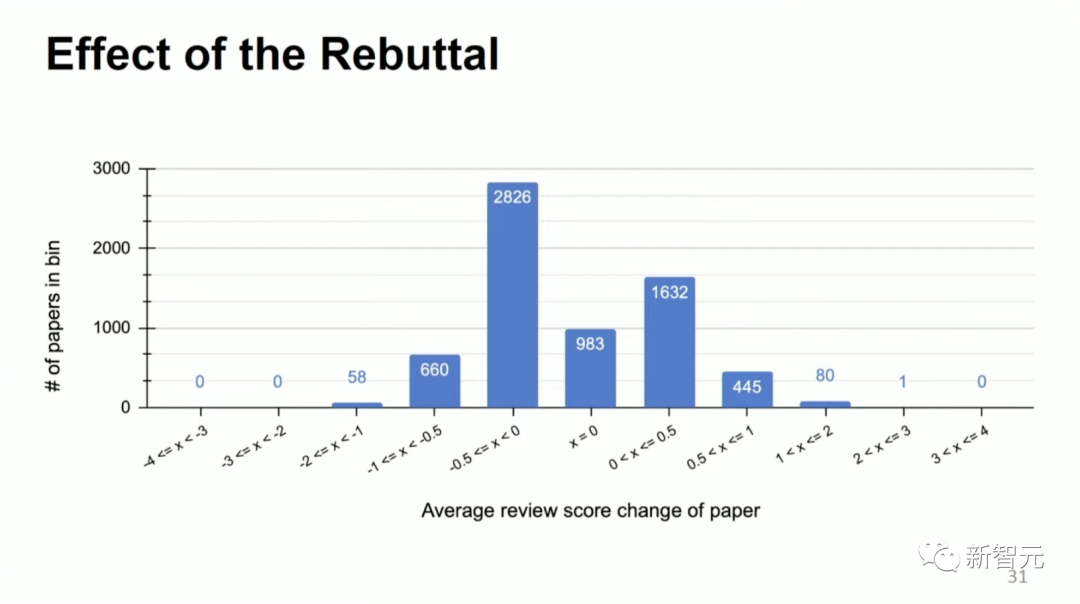

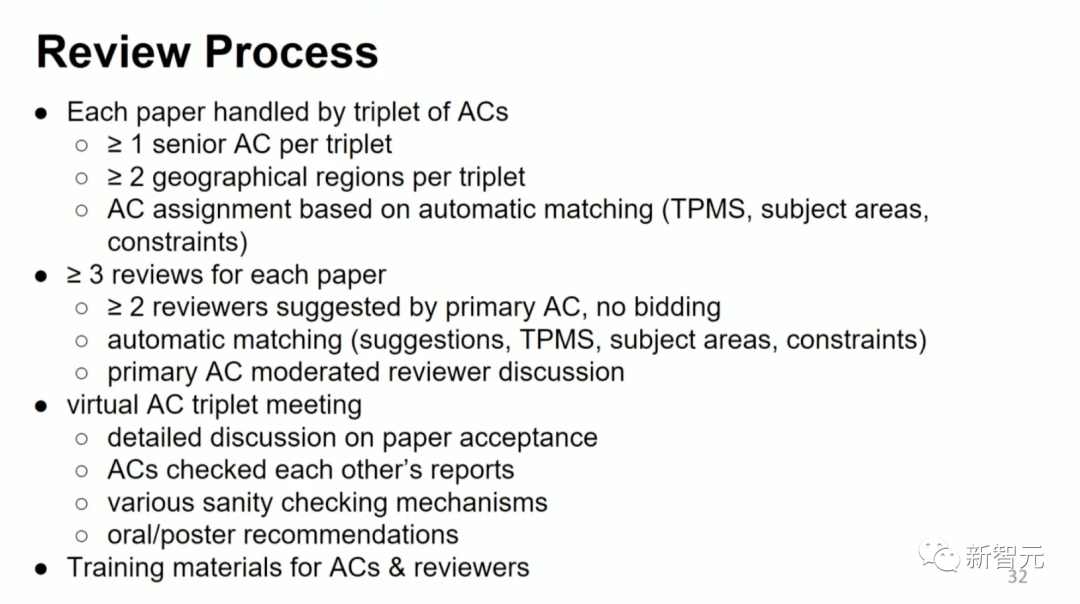

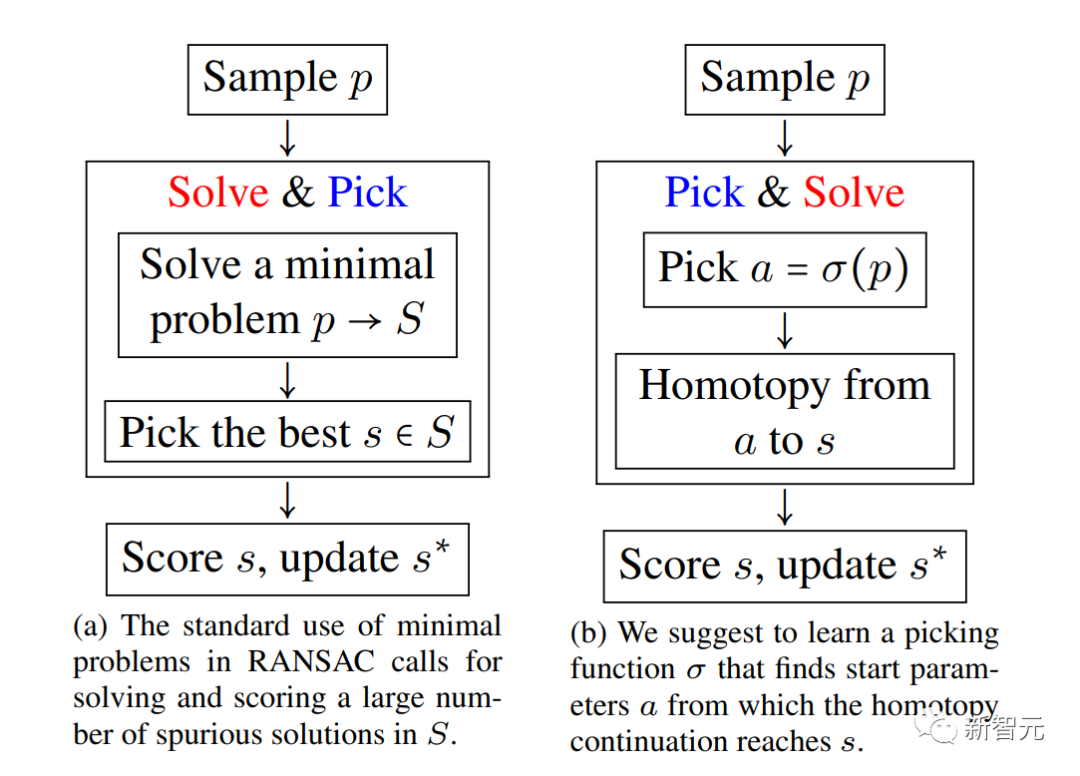

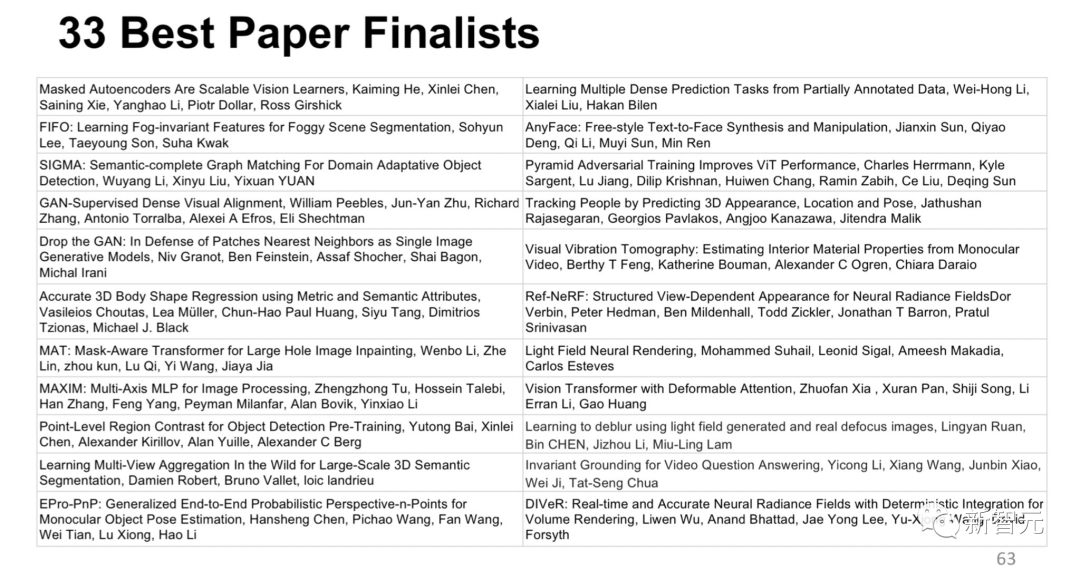

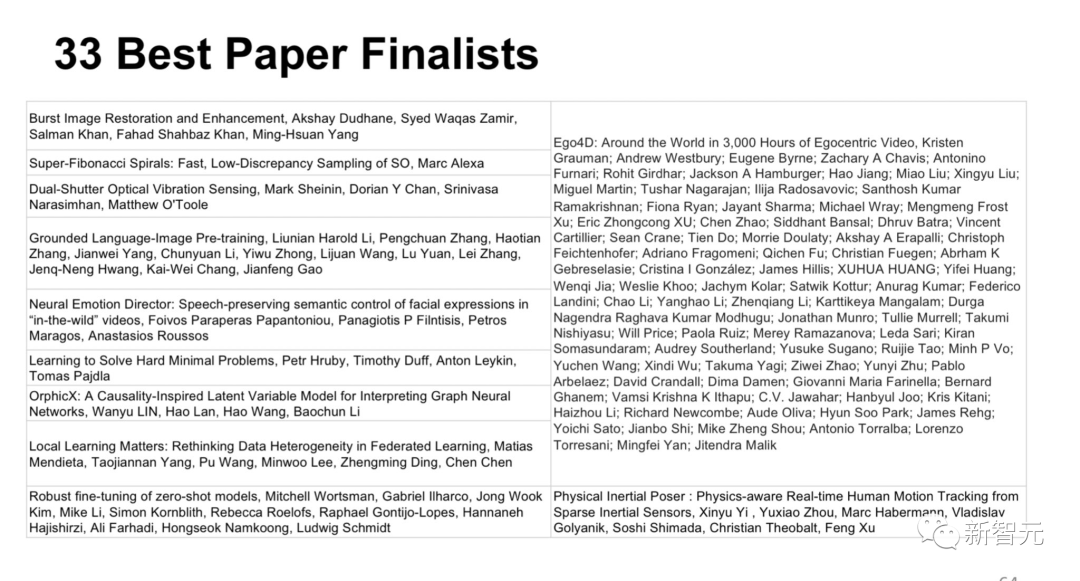

受疫情影響開了兩年的虛擬會議之后,本屆大會終于恢復(fù)了線下出席的方式。 于是,線下注冊參會的人數(shù)一下子就達(dá)到了5641人,比2017年還多。 從現(xiàn)場發(fā)來的圖片看,真可謂是人山人海。 CVPR 2022收到了來自23389名作者共8161篇投稿,相比2021年的7093篇增長15%。 其中,投稿數(shù)最多的是來自中國大陸的作者,占到了44.59%;美國則以20.65%的比例位列第二。 經(jīng)過組委會3個多月細(xì)致的評審工作,大會最終接收了2064篇論文,接收率約為25.3%,高于去年的23.6%。 其中,有342篇論文被選為Oral論文,1721篇被選為Poster論文。 說到這,就不得不提一下審稿質(zhì)量了。最近幾年,但凡學(xué)術(shù)會議放榜,各路吐槽便會如潮水一般接踵而至。 比如,前段時間被推上風(fēng)口浪尖的ICML 2022,就是LeCun投了三篇然后被拒了3篇的那個,大會的一通操作之后氣得馬毅教授都表示自己不會再投稿了。 對此,CVPR著重地講解了自己的審稿機(jī)制和成果。 在審稿人的經(jīng)驗分布上,本屆CVPR學(xué)生審稿人占比31%,教職/研究人員審稿人占比為69%。 其中,23%的審稿人參加審稿經(jīng)歷少于兩次。參與審稿大于10次的資深審稿人占比為19%。 在審稿人的任務(wù)分配上,基本上年資越深的審稿人,審稿數(shù)量越多,任務(wù)越重,審稿經(jīng)驗大于10次的資深研究人員平均要審5.7篇,審稿經(jīng)驗不足兩次的學(xué)生審稿人,平均只要審2篇。 學(xué)術(shù)會議的審稿人是無報酬的,為了感謝他們的無私奉獻(xiàn),本屆CVPR評出了100多位杰出審稿人,并為他們頒發(fā)了價值100美元的禮券。 此外,大會特別對「Rebuttal有多大用」做了統(tǒng)計。 數(shù)據(jù)顯示,有將近3000篇的論文在Rebuttal之后,評分最高降低了0.5分,有660篇最多降低了1分。 由于分?jǐn)?shù)越低,評價越高,所以總體上看,Rebuttal對于論文被接受還是起到了正面作用的,當(dāng)然凡事有風(fēng)險,Rebuttal之后評價變得更差的也有2000多篇。 每篇論文會由3位AC一起處理,包括至少一位資深A(yù)C和至少兩位領(lǐng)域內(nèi)專家,AC的分配由自動匹配產(chǎn)生。 每篇論文至少分配3位審稿人,其中至少兩位為主AC推薦,主AC負(fù)責(zé)主持審稿人會議討論。 AC之間召開線上會議詳細(xì)討論審稿人的意見,并相互審核報告,核查錯誤,向作者發(fā)出通知。 另外,會議還為所有AC和審稿人準(zhǔn)備了關(guān)于審稿的培訓(xùn)材料。 「Learning to Solve Hard Minimal Problems」 論文地址:https://openaccess.thecvf.com/content/CVPR2022/papers/Hruby_Learning_To_Solve_Hard_Minimal_Problems_CVPR_2022_paper.pdf 機(jī)構(gòu):蘇黎世聯(lián)邦理工學(xué)院、華盛頓大學(xué)、佐治亞理工學(xué)院、捷克理工大學(xué) 本文提出了一種在RANSAC框架內(nèi)解決困難幾何優(yōu)化問題的方法。這類問題涉及將原始的幾何優(yōu)化問題放寬為具有許多假解的最小問題。本文提出的方法避免了計算大量的假解。本文提出了一個學(xué)習(xí)策略,用于選擇可以在數(shù)值上延續(xù)原始問題,以及感興趣的解決方案的起始問題-解決方案對。 本文通過RANSAC求解器來證明了這一方法,該求解器用于計算三個經(jīng)過校準(zhǔn)的相機(jī)的相對位置,通過每個視圖中的四個點進(jìn)行最小松弛化。平均可在70微秒內(nèi)解決一個問題。

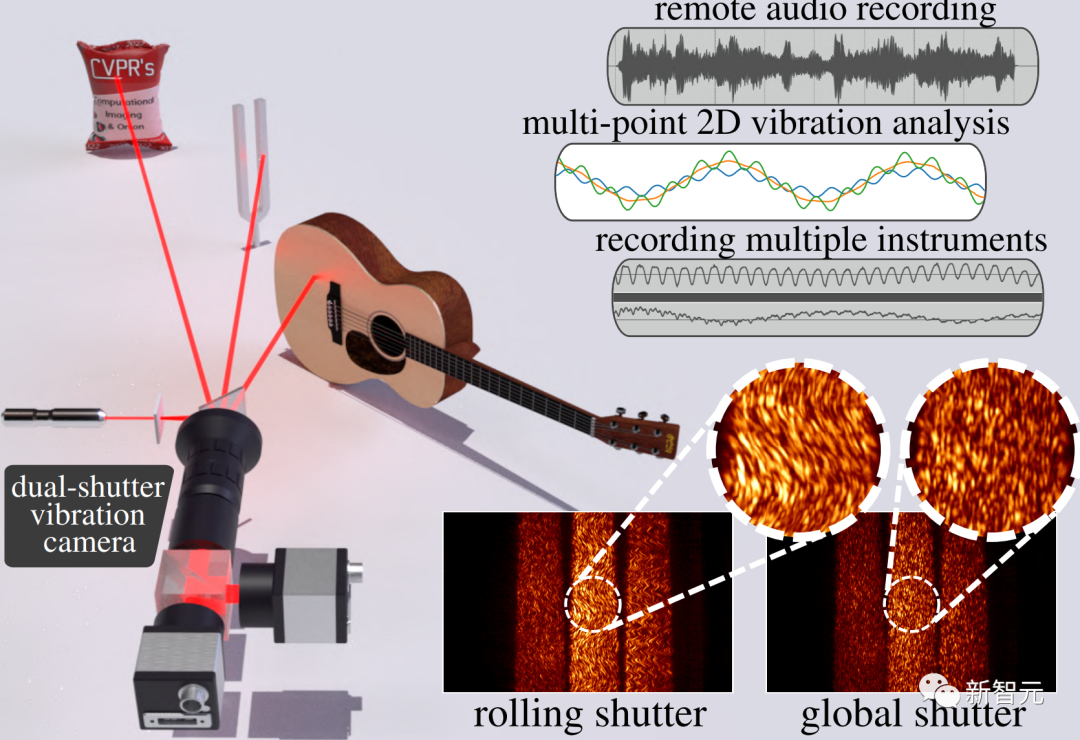

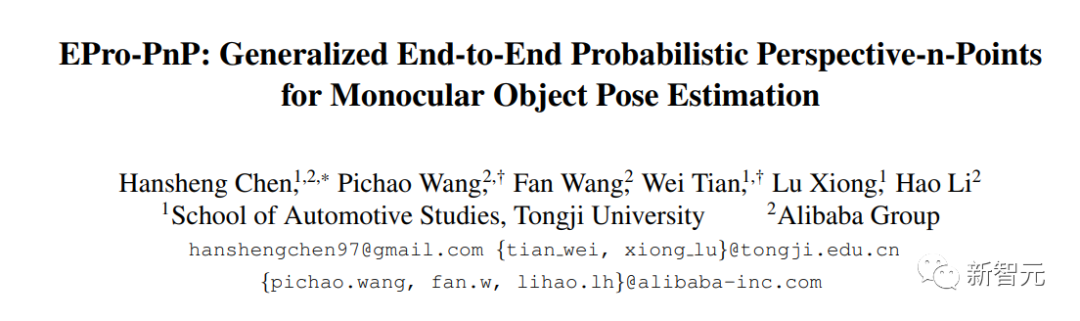

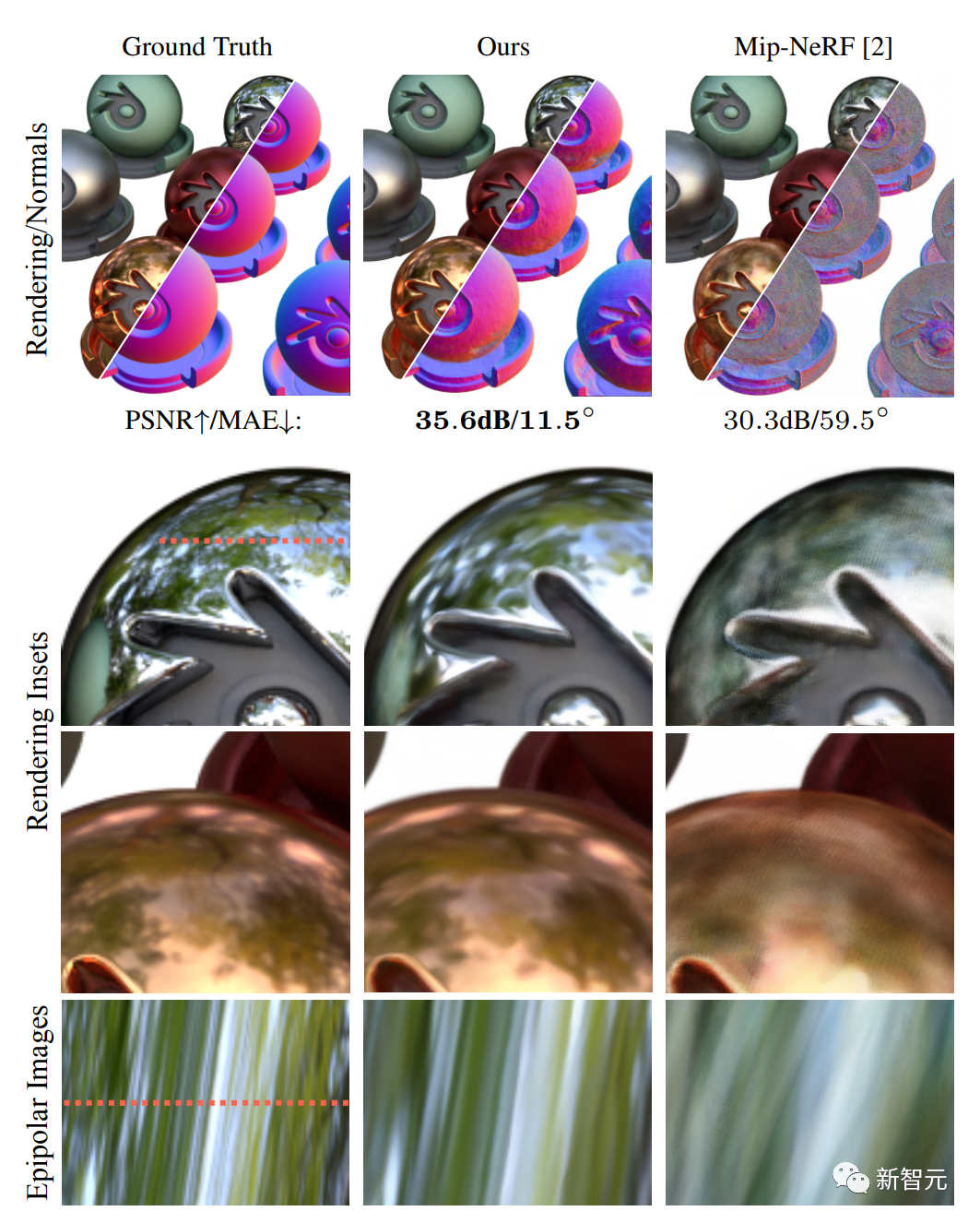

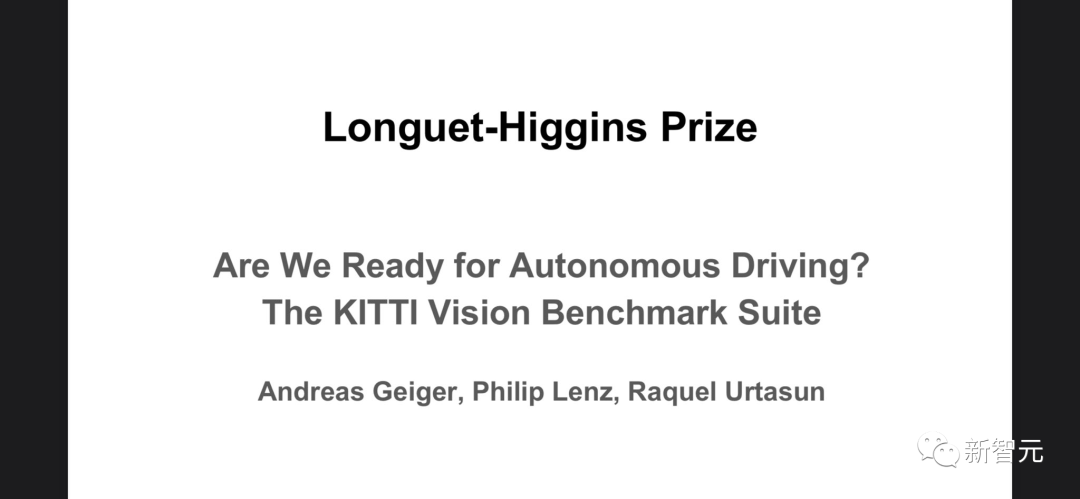

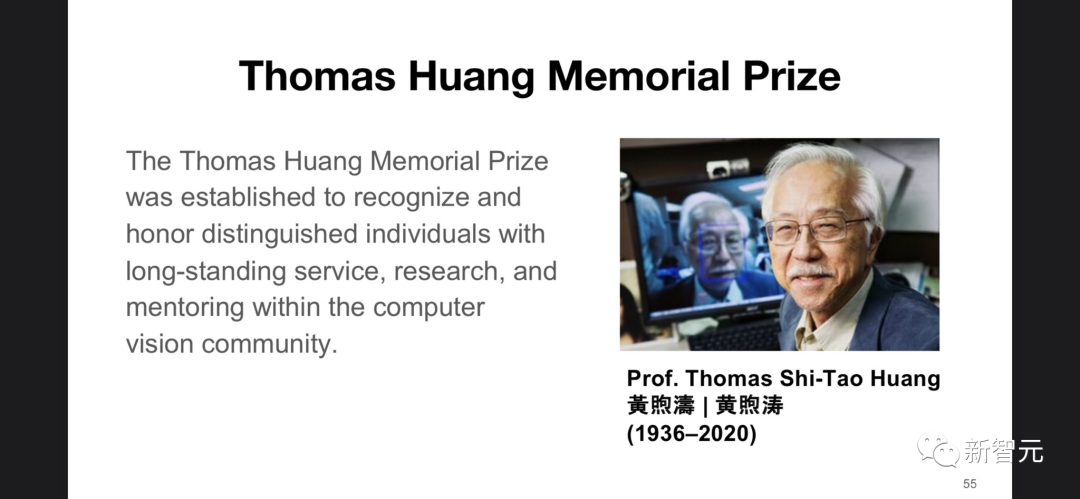

「Dual-Shutter Optical Vibration Sensing」 https://openaccess.thecvf.com/content/CVPR2022/papers/Sheinin_Dual-Shutter_Optical_Vibration_Sensing_CVPR_2022_paper.pdf 機(jī)構(gòu):卡內(nèi)基梅隆大學(xué) 視覺振動測量是一種非常有用的工具,可用于遠(yuǎn)程捕捉音頻、材料物理屬性、人體心率等。雖然視覺上可觀察的振動可以通過高速相機(jī)直接捕捉,但通過將激光束照射振動表面所產(chǎn)生的散斑圖案的位移成像,可以從光學(xué)上放大微小且不易察覺的物體振動。 本文提出了一種新的方法,用于感知高速(高達(dá)63kHz)的振動,可以同時感知多個場景源,使用的傳感器額定工作頻率僅為130Hz。 該方法依賴于同時用兩個分別裝有滾動和全局快門傳感器的相機(jī)來捕捉場景。滾動快門相機(jī)捕捉扭曲的斑點圖像,對高速物體的振動進(jìn)行編碼。全局快門相機(jī)捕捉斑點圖案的未扭曲圖像作為參考。研究人員通過捕捉由音源(如揚(yáng)聲器、人聲和樂器)引起的振動,分析音叉的振動模式,展示了這種新方法。 「EPro-PnP: Generalized End-to-End Probabilistic Perspective-n-Points for Monocular Object Pose Estimation」 https://openaccess.thecvf.com/content/CVPR2022/papers/Chen_EPro-PnP_Generalized_End-to-End_Probabilistic_Perspective-N-Points_for_Monocular_Object_Pose_Estimation_CVPR_2022_paper.pdf 機(jī)構(gòu):同濟(jì)大學(xué)、阿里巴巴集團(tuán) 通過Perspective-n-Points(PnP)從單一的RGB圖像中定位3D物體是計算機(jī)視覺中一個長期存在的問題。在端到端深度學(xué)習(xí)的驅(qū)動下,最近的研究建議將PnP解釋為一個可微分層,可以通過反向傳播物體姿勢的梯度,來部分學(xué)習(xí)2D圖像和3D空間點的對應(yīng)關(guān)系。然而,如果從頭開始學(xué)習(xí)整個無限制的2D-3D點集,在現(xiàn)行方法中無法收斂,因為確定的姿勢本身就是不可微的。 本文提出了Pro-PnP,一個用于一般端到端姿勢估計的概率PnP層,它可以輸出SE(3)流形上的姿勢分布,實際上將分類Softmax帶入連續(xù)域。2D-3D坐標(biāo)和相應(yīng)的權(quán)重被視為中間變量,通過最小化預(yù)測和目標(biāo)姿勢分布之間的KL散度來學(xué)習(xí)。其基本原理統(tǒng)一了現(xiàn)有的方法,類似于注意力機(jī)制。 EPro-PnP的效果明顯優(yōu)于現(xiàn)有基準(zhǔn),在LineMOD 6DoF姿勢估計和nuScenes三維物體檢測基準(zhǔn)上,縮小了基于PnP的方法與特定任務(wù)最佳性能之間的差距。 「Ref-NeRF: Structured View-Dependent Appearance for Neural Radiance Fields」 論文地址:https://arxiv.org/pdf/2112.03907.pdf 機(jī)構(gòu):哈佛大學(xué)、谷歌研究院 神經(jīng)輻射場(NeRF)是一種流行的視圖合成技術(shù),它將場景表示為一個連續(xù)的體積函數(shù),由多層感知器來提供每個位置的體積密度和隨視線變化的發(fā)射輻射的參數(shù)。雖然基于NeRF的技術(shù)擅長表現(xiàn)具有平滑變化的視線依賴性外觀的精細(xì)幾何結(jié)構(gòu),但往往不能準(zhǔn)確捕捉和再現(xiàn)有光澤表面的外觀。 本文通過引入Ref-NeRF來解決這個問題。Ref-NeRF用反射輻射的表示方法取代了NeRF的視線依賴性出射輻射的參數(shù)化,并使用一系列空間變化的場景屬性來構(gòu)造這一函數(shù)。 結(jié)果表明,與法線向量的正則器相結(jié)合,新模型大大提升了鏡面反射的真實性和準(zhǔn)確性。此外,本文的模型對出射光度的內(nèi)部表示是可解釋的,對場景編輯很有用。 入圍名單里的第一篇就是何愷明的MAE,但很遺憾,沒最后并沒有被評上。 早在2021年MAE橫空出世之時,何愷明就被大家寄予厚望。 全國物理、化學(xué)競賽一等獎,保送清華,高考滿分,微軟亞洲研究院實習(xí),CVPR最佳論文獎首位華人得主... 可以說,這些傲人的履歷隨便拿出來一個都能秒殺大部分同齡人。 雖然這次何愷明沒有拿下本屆CVPR最佳論文,但他在未來一定會取得更大的成績。 Longuet-Higgins獎由IEEE的PAMI(模式分析和機(jī)器智能,pattern analysis and machine intelligence)技術(shù)委員會,每年在CVPR論壇上發(fā)布,旨在表彰對CV(計算機(jī)視覺)領(lǐng)域的研究產(chǎn)生重大影響的CVPR論文。 該獎以理論化學(xué)家和認(rèn)知科學(xué)家H. Christopher Longuet-Higgins的名字來命名,獲獎?wù)哂蒚CPAMI獎項委員會指定的另一個委員會來決定。 今年,Longuet-Higgins獎由Andreas Geiger等三位作者寫的論文「我們準(zhǔn)備好迎接自動駕駛了嗎?——KITTI視覺基準(zhǔn)組件」獲得。三位作者中,Geiger和Lenz來自卡爾斯魯厄理工學(xué)院,而Urtasun則來自豐田工業(yè)大學(xué)芝加哥分校。 在這篇論文中,三位研究者使用自己開發(fā)的自動駕駛平臺為為立體、光流、視覺測程 / SLAM 和 3D 目標(biāo)檢測等任務(wù)開發(fā)了一個新基準(zhǔn)。 其中,研究人員的記錄平臺配備有四個高分辨率視頻相機(jī)、Velodyne激光掃描儀,以及SOTA級別的本地化系統(tǒng)。 青年研究者獎同樣由PAMI技術(shù)委員會頒發(fā),評選過程由PAMI-TC獎項委員會進(jìn)行管理。獲獎?wù)咭矔贑VPR會議上公布。 今年的獲獎?wù)哂袃晌唬謩e是Bharath Hariharan和Olga Russakovsky。 Hariharan是康奈爾大學(xué)計算機(jī)科學(xué)系的助理教授,主要從事CV和ML方面的工作,尤其是那些無視「大數(shù)據(jù)」標(biāo)簽的重要問題。 他喜歡解決將機(jī)器學(xué)習(xí)的進(jìn)步與計算機(jī)視覺、幾何和特定領(lǐng)域知識相結(jié)合的問題。 目前,Hariharan的團(tuán)隊正在構(gòu)建一個可以在很少或沒有監(jiān)督的情況下學(xué)習(xí)數(shù)以萬計的視覺概念的系統(tǒng),并產(chǎn)生詳盡的輸出,例如精確的3D形狀等等。 Russakovsky 是普林斯頓大學(xué)計算機(jī)科學(xué)系的助理教授,研究方向也聚焦在CV領(lǐng)域。 黃煦濤(Thomas S. Huang )紀(jì)念獎

黃煦濤紀(jì)念獎于2020年開始設(shè)立,從2021年開始,每年在CVPR大會上頒發(fā)一次,旨在表彰在研究、教學(xué)與指導(dǎo)和為CV社區(qū)服務(wù)方面公認(rèn)為典范的研究人員。 該獎項是為了紀(jì)念已故的黃煦濤教授而設(shè)立的,他是一位在CV和圖像處理等多個領(lǐng)域做出大量貢獻(xiàn)的先驅(qū)學(xué)者。同時,他也是為幾代人的成長做出貢獻(xiàn)的榜樣。 該獎項每年頒發(fā)給博士畢業(yè)后至少7年的研究人員,最好是職業(yè)生涯中期(博士畢業(yè)不能超過25年)。 該獎的候選人考慮CV領(lǐng)域的所有研究人員。最終獎勵包括3,000美元現(xiàn)金獎勵和一塊獎牌。 本次黃煦濤紀(jì)念獎的獲獎?wù)呤撬固垢4髮W(xué)計算機(jī)科學(xué)系首任紅杉教授李飛飛。 2013~2018年,她擔(dān)任了斯坦福大學(xué)人工智能實驗室主任。2017年1月至2018年9月這段時間,她還擔(dān)任了谷歌副總裁,在谷歌云擔(dān)任人工智能與機(jī)器學(xué)習(xí)的首席科學(xué)家。 李飛飛博士致力于研究啟發(fā)式AI、機(jī)器學(xué)習(xí)、深度學(xué)習(xí)、計算機(jī)視覺,以及AI+醫(yī)療保健。 此外,她還研究過認(rèn)知和計算神經(jīng)科學(xué)。 她曾在Nature、PNAS、CVPR、ICCV、ECCV、ICRA等大量頂刊和頂會上發(fā)表了200多篇論文。 她還是ImageNet和ImageNet Challenge的發(fā)明者,這是一種大規(guī)模數(shù)據(jù)集和基準(zhǔn)測試工作,為深度學(xué)習(xí)和人工智能的最新發(fā)展做出了巨大貢獻(xiàn)。 除了她在技術(shù)上的成就,她還是STEM的倡導(dǎo)者,AI多樣性的全國代言人。她致力于提高人工智能教育的包容性和多樣性。 2022年6月14日凌晨,曠視首席科學(xué)家孫劍離世。 CVPR 2022大會現(xiàn)場,在公布最佳論文之前,緬懷了孫劍博士。 現(xiàn)場一段視頻帶領(lǐng)大家一起回憶了孫劍博士科研成長之路。 最后,人工智能社區(qū)的大牛、以及孫劍的親朋好友紛紛寫下了對孫劍博士的悼念信。

00:58

參考資料:

https://twitter.com/CVPR