200個億參數(shù)!Cerebras憑借全球最大AI芯片打破在單個設(shè)備上訓練的最大AI模型的記錄

6月23日消息,2021年曾推出全球最大AI芯片的Wafer Scale Engine 2(WSE-2)的Cerebras Systems公司近日宣布,在基于單個WSE-2芯片的CS-2系統(tǒng)上訓練了世界上最大的擁有200億參數(shù)的NLP(自然語言處理)人工智能模型。這也使得它能夠適應,目前網(wǎng)絡(luò)上非常熱門的基于文本創(chuàng)建圖像的OpenAI的120億個參數(shù)的DALL-E的神經(jīng)網(wǎng)絡(luò)模型。

Cerebras Systems創(chuàng)始人兼首席執(zhí)行官Andrew Feldman表示,在單個AI芯片中保留多達200億個參數(shù)的 NLP 模型,顯著降低了原本需要數(shù)千個GPU 訓練的成本(以及相關(guān)的硬件和擴展要求),同時消除了在它們之間劃分不同版本模型的技術(shù)困難。Andrew Feldman稱這是“NLP 工作負載中最痛苦的方面之一”,有時“需要幾個月才能完成”。

這是一個定制的問題,不僅對每個正在處理的神經(jīng)網(wǎng)絡(luò)、每個 GPU 的規(guī)格以及將它們聯(lián)系在一起的網(wǎng)絡(luò)都是獨一無二的——這些元素必須在第一次訓練開始之前提前解決。而且它不能跨系統(tǒng)移植。

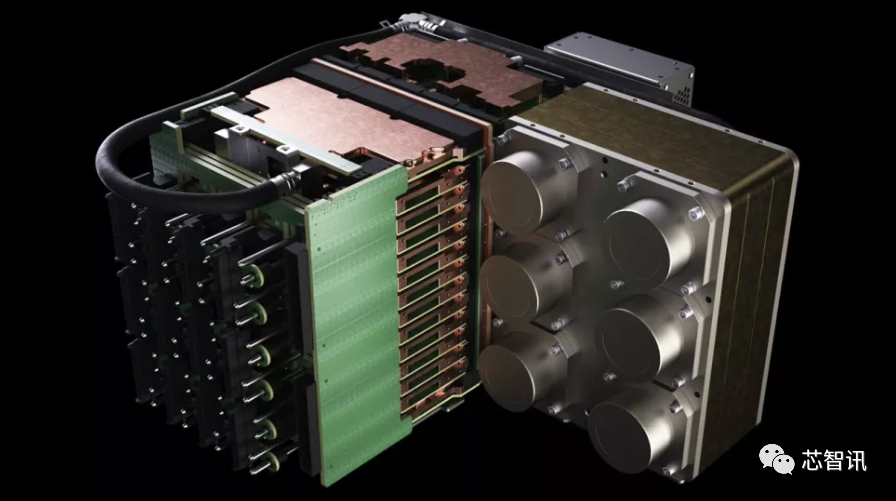

WSE-2與第一代一樣,依然是基于一整張12吋晶圓制造,面積依然是462.25平方厘米,但是制程工藝由臺積電16nm工藝提升到了7nm工藝,這也使得WSE-2的晶體管數(shù)量提高到了2.6萬億個,同時他的人工智能內(nèi)核數(shù)量也達到了85萬個,片上內(nèi)存也由原來的18GB提升到了40GB,內(nèi)存帶寬由9PB/s提高到了20PB/s,結(jié)構(gòu)帶寬高達220PB/s。各項指標均打破首代WSE 處理器創(chuàng)造的世界紀錄。

基于以WSE-2 處理器為核心的Cerebras CS-2 人工智能超級電腦系統(tǒng)(包括所有相關(guān)的電源、內(nèi)存和存儲子系統(tǒng)),是傳統(tǒng)超級電腦性能的數(shù)百或數(shù)千倍,而且采用Cerebras CS-2 人工智能超級電腦的功耗和容納空間卻只有一小部分。這是因為單個WSE-2 處理器取代了成百上千個傳統(tǒng)處理器的叢集架構(gòu),這些叢集架構(gòu)需要數(shù)十個機架,使用數(shù)百千瓦的電力,并且花費數(shù)月的時間進行安裝和準備。而CS-2的能耗僅需要15kW。

資料顯示,OpenAI 的 GPT-3 是一種 NLP 模型,可以編寫有時可能會欺騙人類讀者的整篇文章,具有驚人的 1750 億個參數(shù)。DeepMind 的 Gopher 于去年年底推出,將這個數(shù)字提高到 2800 億。Google Brain 的大腦甚至宣布訓練一個超過萬億參數(shù)的模型 Switch Transformer。

如果將CS-2所達成訓練200億參數(shù)的NLP人工智能模型的成就與上述更大規(guī)模的人工智能模型相比,CS-2的成就似乎平淡無奇。但是,事實上,CS-2極大降低了超大規(guī)模的人工智能模型訓練的門檻。

Cerebras 首席執(zhí)行官兼聯(lián)合創(chuàng)始人 Andrew Feldman表示,“在 NLP 中,更大的模型將會帶來更準確的結(jié)果。但傳統(tǒng)上,只有極少數(shù)公司擁有必要的資源和專業(yè)知識來完成分解這些大型模型,并將它們分散到數(shù)百或數(shù)千個圖形處理單元的能力。因此,只有極少數(shù)公司可以訓練超大規(guī)模的NLP模型——這對于行業(yè)的其他人來說太昂貴、太耗時且無法使用。今天,我們很自豪能夠普及 GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B 和 GPT-NeoX 20B,使整個 AI 生態(tài)系統(tǒng)能夠在幾分鐘內(nèi)建立大型模型并在單個 CS-2 上訓練它們。”

就像CPU的主頻一樣,AI模型的參數(shù)量只是一個指標。如何能夠使用更少的參數(shù)實現(xiàn)更好的結(jié)果也是至關(guān)重要。例如,Chinchilla通常僅用 700 億個參數(shù)就優(yōu)于 GPT-3 和 Gopher 。所以,AI模型訓練的目標是更聰明地工作,而不是更努力地工作。

此外,Cerebras公司也擁有能夠支持“數(shù)千億甚至數(shù)萬億”的模型。去年8月,Cerebras Systems就曾宣布推出了世界上第一個人類大腦規(guī)模的AI解決方案——CS-2 AI計算機,可支持超過120萬億參數(shù)規(guī)模的訓練。相比之下,人類大腦大約有100萬億個突觸。Cerebras實現(xiàn)了192臺CS-2 AI計算機近乎線性的擴展,從而打造出包含高達1.63億個核心的計算集群。

可用參數(shù)數(shù)量的爆炸式增長,還可利用Cerebras 的權(quán)重流技術(shù),該技術(shù)可以將計算和內(nèi)存占用量解耦,允許將內(nèi)存擴展到存儲 AI 工作負載中快速增加的參數(shù)數(shù)量所需的任何數(shù)量。這使得設(shè)置時間從幾個月減少到幾分鐘,并且可以輕松地在 GPT-J 和 GPT-Neo 等型號之間切換“只需幾次按鍵”。

“Cerebras 能夠以具有成本效益、易于訪問的方式將大型語言模型帶給大眾,這為人工智能開辟了一個激動人心的新時代。Intersect360 Research 首席研究官 Dan Olds 說:“看到 CS-2 客戶在海量數(shù)據(jù)集上訓練 GPT-3 和 GPT-J 類模型時所做的新應用和發(fā)現(xiàn)將會很有趣。”

編輯:芯智訊-浪客劍

編譯自:https://www.tomshardware.com/news/cerebras-slays-gpus-breaks-record-for-largest-ai-models-trained-on-a-single-device

打破AI內(nèi)存墻?PayPal聯(lián)手至強+傲騰,漏查欺詐交易量可降到原來1/30

2021年全球NOR Flash市場:兆易創(chuàng)新收入暴增100%,份額升至23.2%!

因未披露24項中國芯片專利,華裔大學教授被美國判處1年監(jiān)禁

2022中國大學專業(yè)排名公布:集成電路相關(guān)專業(yè)哪家強?

臺積電2nm細節(jié)曝光:功耗降低30%!成熟制程產(chǎn)能2025年將提升50%

晶合集成實現(xiàn)業(yè)績大逆轉(zhuǎn):從虧損12.6億到盈利17.3億!

傳長江存儲年底量產(chǎn)232層3D NAND,進度領(lǐng)先美光

行業(yè)交流、合作請加微信:icsmart01

芯智訊官方交流群:221807116