QCon 實時音視頻專場:實時互動的最佳實踐與未來展望

互動直播、線上會議、在線醫(yī)療和在線教育是實時音視頻技術(shù)應(yīng)用的重要場景,而這些場景對高可用、高可靠、低延時有著苛刻的要求,很多團隊在音視頻產(chǎn)品開發(fā)過程中會遇到各種各樣的問題。例如:流暢性,如果在視頻過程中頻繁卡頓,基本上就很難有良好的互動;回聲消除,經(jīng)過環(huán)境反射被麥克風(fēng)重新采集并傳輸,這也會影響互動效果;國內(nèi)外互通,越來越多的產(chǎn)品選擇出海,海內(nèi)外互通也是技術(shù)上需要解決的點;海量并發(fā),這對音視頻產(chǎn)品的抗壓能力而言是很大的挑戰(zhàn)。

5 月 29 日,在 「QCon 北京全球軟件開發(fā)大會」上,由聲網(wǎng)Agora 技術(shù) VP 馮越作為專題出品人發(fā)起的「實時音視頻專場」,邀請到了來自新東方、伴魚英語、聲網(wǎng)Agora 的技術(shù)專家,與大家分享了下一代視頻引擎架構(gòu)、大規(guī)模實施音視頻系統(tǒng)的難點與跳轉(zhuǎn)、語音測評及本地化實踐、前端音視頻播放器的研究與實踐等話題。

聲網(wǎng)下一代視頻引擎架構(gòu)探索

隨著音視頻技術(shù)快速發(fā)展,音視頻實時互動在多個領(lǐng)域(社交娛樂、在線直播、醫(yī)療等)中都得到了廣泛的應(yīng)用。同時伴隨著 AI 技術(shù)在圖象處理中的快速發(fā)展,融合了 AI 算法的高級視頻前處理功能也得到了越來越多的應(yīng)用。場景的豐富多變對下一代視頻靈活可擴展功能提出了很高的要求。

聲網(wǎng)Agora 負責(zé)下一代視頻引擎架構(gòu)設(shè)計的架構(gòu)師李雅琪首先為大家?guī)砹岁P(guān)于《聲網(wǎng)下一代視頻引擎架構(gòu)探索與實踐》的分享。

為了能更好地滿足對于視頻體驗的場景豐富性、用戶差異性以及對直播體驗的需求,聲網(wǎng)將下一代視頻處理引擎設(shè)計原則和目標總結(jié)為以下四個方面:

1、要滿足不同的用戶對集成的差異化需求;

2、要做到靈活可擴展,可以快速的支撐各種新業(yè)務(wù)和新技術(shù)場景落地;

3、要做到快速可靠,對于視頻處理引擎核心系統(tǒng)要提供豐富強大的可能,且能夠極大地降低開發(fā)人員心智負擔。

4、要做到性能優(yōu)越可監(jiān)控,要持續(xù)優(yōu)化視頻直播處理引擎性能,同時提高監(jiān)控手段,實現(xiàn)質(zhì)量數(shù)據(jù)透明。

針對上述四個設(shè)計目標,聲網(wǎng)具體采用了哪些軟件設(shè)計的方法呢?

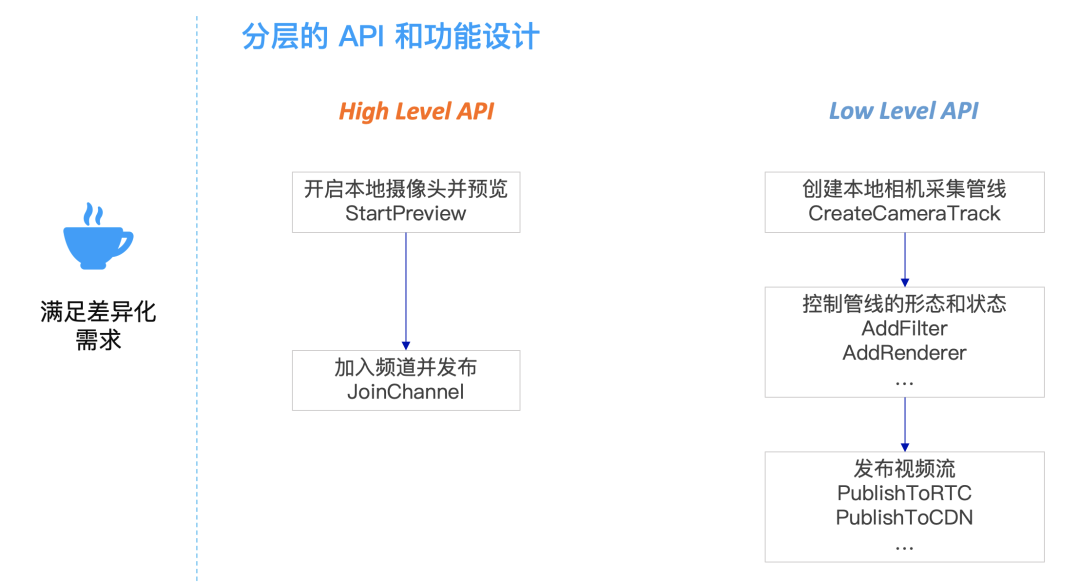

由于引擎的使用者是天然分層的,一部分使用者要求低代碼快速上線,需要引擎盡可能提供貼近他業(yè)務(wù)的功能的API;而另外一部分用戶,希望引擎可以為他們提供更多的核心視頻處理能力,在這之上可以按照自己的需求定制視頻處理業(yè)務(wù)。因此,根據(jù)這個用戶形態(tài)聲網(wǎng)也采取了業(yè)務(wù)組合加核心功能的分層業(yè)務(wù)設(shè)計,High Level API 面向業(yè)務(wù)提供易用性,Low Level API 提供核心功能和靈活性。為了把靈活編排能力作為視頻處理引擎的能力開放給開發(fā)者,讓開發(fā)者可以通過靈活自由的 API 組合,根據(jù)不同的業(yè)務(wù)需求進行靈活編排,聲網(wǎng)的視頻處理引擎核心架構(gòu)采用了 Microkernel Architecture 的架構(gòu)模式,分離了整個引擎的變量和不變量。通過微內(nèi)核的架構(gòu)模式實現(xiàn)靈活可擴展的目標: 各個模塊功能可以快速擴展,視頻處理管線也可以通過搭積木式的組合來實現(xiàn)業(yè)務(wù)的靈活編排。

如果我們沒有一個穩(wěn)定可靠的核心系統(tǒng),一個開發(fā)人員要從零開始在視頻處理管線上開發(fā)一個美顏插件,需要考慮其自身業(yè)務(wù)邏輯以外的很多問題: 模塊的位置、數(shù)據(jù)格式轉(zhuǎn)換、線程模型、內(nèi)存管理、屬性配置等問題,針對這一系列工程相關(guān)的集成問題聲網(wǎng)將解決方案固化到底層核心系統(tǒng)當中,為用戶提供了豐富強大的基礎(chǔ)功能。這套視頻引擎核心系統(tǒng)包括了基礎(chǔ)視頻處理單元、管線搭建和控制、視頻基礎(chǔ)格式算法支持以及系統(tǒng)基礎(chǔ)設(shè)施等功能。有了這個核心系統(tǒng),集成就會變得非常簡單,插件只要按照核心系統(tǒng)接口協(xié)議約定,實現(xiàn)相關(guān)的封裝接口就可以了。豐富強大的核心系統(tǒng)功能極大地降低了模塊開發(fā)者的心智負擔,從而幫助開發(fā)者提升整體的研發(fā)效能。

在性能優(yōu)越可監(jiān)控部分,聲網(wǎng)優(yōu)化了移動端數(shù)據(jù)處理鏈路,分離了控制面和數(shù)據(jù)面,提升了整體數(shù)據(jù)視頻的傳輸效率。另外還構(gòu)建了視頻處理特性相關(guān)的內(nèi)存池來降低系統(tǒng)資源消耗。最終實現(xiàn)了全鏈路視頻質(zhì)量監(jiān)控機制,使視頻優(yōu)化性能達到閉環(huán)反饋的效果。

自研大規(guī)模實時音視頻系統(tǒng)的難點與挑戰(zhàn)

來自聲網(wǎng)Agora 的行業(yè)架構(gòu)師董海冰作為 RTC 領(lǐng)域的長期深耕者在大會中為大家普及了 RTC 相關(guān)的基礎(chǔ)概念,同時也詳細分析了 RTC 的場景特點以及在自研過程中的架構(gòu)設(shè)計和難點。最后,對于 RTC 未來的發(fā)展方向也分享了他自己的看法。

相較于傳統(tǒng)互聯(lián)網(wǎng)應(yīng)對大規(guī)模、高并發(fā)已經(jīng)較為成熟的解決方案:緩存、異步、分布式,實時音視頻領(lǐng)域所面臨的挑戰(zhàn)其實會更為復(fù)雜。“實時”要控制在 1 秒以內(nèi)才能叫做“實時”。比如做緩存,其時間都是秒級別的,或者分鐘級別的,很少出現(xiàn)毫秒級別。實時音視頻(RTC)在應(yīng)對大規(guī)模、高并發(fā)場景時,需要考慮到音視頻質(zhì)量、流暢性、低時延、可伸縮以及可用性等問題,這是做實時音視頻和傳統(tǒng)互聯(lián)網(wǎng)很不一樣的地方,也意味著其解決方案也會更為復(fù)雜。

在開發(fā)過程中,用戶常見的挑戰(zhàn)有開發(fā)成本、網(wǎng)絡(luò)搭建、質(zhì)量監(jiān)控、音頻處理和最后測試等問題。在分享中,董海冰就舉了一個音頻自研的例子。首先,音頻傳輸最關(guān)鍵要解決的問題有 3 個:無聲/聲音小、回聲、噪聲/雜音。其次,弱網(wǎng)對抗能力也非常重要,在網(wǎng)絡(luò)發(fā)生變化的時候,怎么通過碼率和幀率調(diào)整能夠緩解變化,同時要解決在智能路由算法里面實現(xiàn)最優(yōu)路徑的選擇與傳輸?shù)葐栴}。另一個挑戰(zhàn)就是多維度的質(zhì)量評估,而且要做到實時化的評估,同時和動態(tài)調(diào)整形成一個閉環(huán),這樣才是最好的方式,能夠在弱網(wǎng)對抗里面起到比較好的作用。而對于使用開源服務(wù)端的難點,董海冰也對幾個常見的方案(Jitsi/Jitsi VideoBridge、Kurento、Licode/Erizo、Pion、Janus)進行了探討與分享。

除了服務(wù)端的開發(fā),實時音視頻的運維及質(zhì)量監(jiān)控也與傳統(tǒng)的互聯(lián)網(wǎng)方式有些不同。比如在運維方面,除了常見的容災(zāi)規(guī)劃、容器化部署、自動化運維、性能分析及日志系統(tǒng)外,實時音視頻中的運維還需要面對全球網(wǎng)絡(luò)(跨區(qū)域、跨運營商)、Lastmile 策略等挑戰(zhàn)。

如果用戶選擇了自研的方式,可能還會面對大規(guī)模連麥、RTC錄制/回放方案、運營成本的控制等問題。但即便我們需要面對和解決如此多的困難和挑戰(zhàn),不能忽略的是實時音視頻技術(shù)正在被應(yīng)用在越來越多的場景下,也擁有著越來越多的可能性。

MetaVerse 譯作元宇宙,是近期比較熱的一個概念。在現(xiàn)實生活中我們可以把它理解為是一種角色轉(zhuǎn)換,在虛擬世界中是另一種全新體驗,實現(xiàn)多種虛擬世界角色的切換。VRCHAT 也是類似的,通過 VR 來做社交或者娛樂,幫助大家進行更好的線上交互,這很可能是未來互聯(lián)網(wǎng)的發(fā)展和探索的方向。董海冰提到,作為自研團隊不能閉門造車,要緊跟時代脈搏和行業(yè)發(fā)展趨勢,盡可能把自己的力量投入在自己核心業(yè)務(wù)和擅長的方面,大家一起把實時音視頻這個領(lǐng)域做得更好。

03

新東方云教室 Web 端音視頻播放器實踐

線上教育應(yīng)該是近兩年大家最為熟悉的實時音視頻應(yīng)用場景之一,此次專場,我們邀請到了來自新東方云教室前端交互架構(gòu)師李便茹為大家分享新東方是如何實現(xiàn)線下到線上快速遷移的最佳實踐。

新東方在 18年底開始做自己的云教室,2020 年過年期間一個禮拜,做到了從支撐萬級的并發(fā)躍進到了支撐30萬并發(fā)。

新東方云教室是一套完整的在線上課解決方案,提供saas服務(wù),其顯著的一個特點就是更新迭代的節(jié)奏非常快。如果在端上做原生開發(fā),比如與PC、Windows、移動端與安卓和 iOS,那么更新迭代一定是趕不上節(jié)奏的,因此他們將策略定為客戶端內(nèi)嵌 H5 頁面,除實時音視頻外,交互功能基本由 H5 實現(xiàn)。Web 適配到各個端,這就是最快的開發(fā)模式。

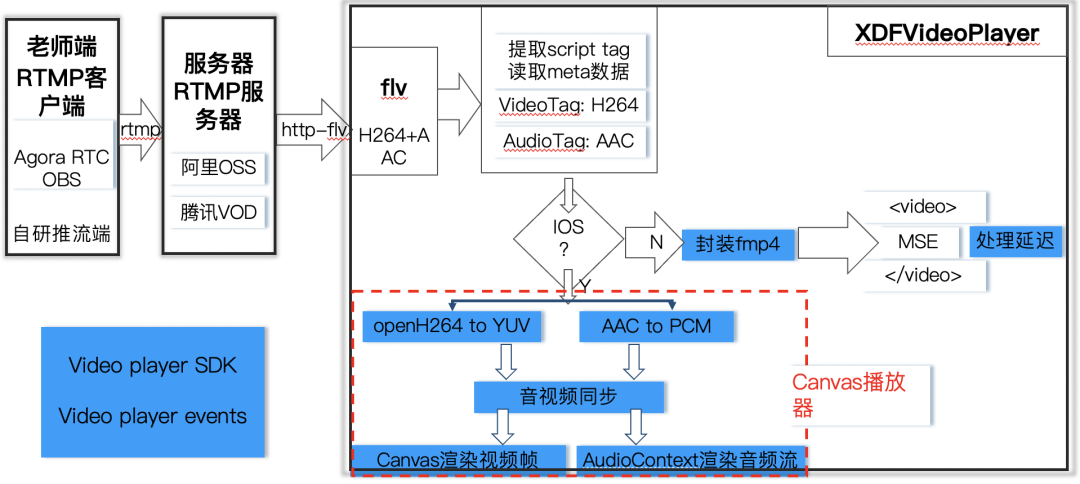

實時音視頻(RTC)延時是百毫秒級,最多不會超過 500 毫秒,人耳是基本感知不到的。在線上教育中會有小班課和大班課兩種不同的場景。小班課對于低延時的實時互動要求就會比較高,但對于一些大學(xué)的課程和講座,或是名師公開演講的大班課場景如果用 RTC 的話,成本其實相對就會較高一些了。針對大班課,新東方云課堂采用了 H5 超大班型的方法,支持百萬人同時上課,老師端用 RTMP 推流,學(xué)生端依然走 HTTP 拉流。

Web 直播播放器架構(gòu)圖

對于未來可擴展部分,如果云教室的視頻編碼采用 H.265 的標準,那么壓縮就會比 H.264 小一半,網(wǎng)絡(luò)壓力就減少了很多。H5 擁有應(yīng)用范圍廣泛且支持跨平臺的優(yōu)勢,能夠?qū)崿F(xiàn)同一套方案適配不同客戶端,快速開發(fā)一套產(chǎn)品,就能夠快速上線。自研通用播放器可以更改輸入源流,定制化或者快開發(fā)。

04

語音測評和本地化

為了可以更好地提供教育服務(wù),近兩年在線教育平臺也結(jié)合深度學(xué)習(xí)實現(xiàn)了許多新的功能,語音測評就是其中一項,尤其在英語教育中少兒口語的測評次數(shù)需求量巨大。如何降低測評時延,提升評測服務(wù)的體驗,同時降低服務(wù)器壓力和成本?來自伴魚技術(shù)中臺 AI 算法負責(zé)人黃智超分享了《語音測評和本地化》。

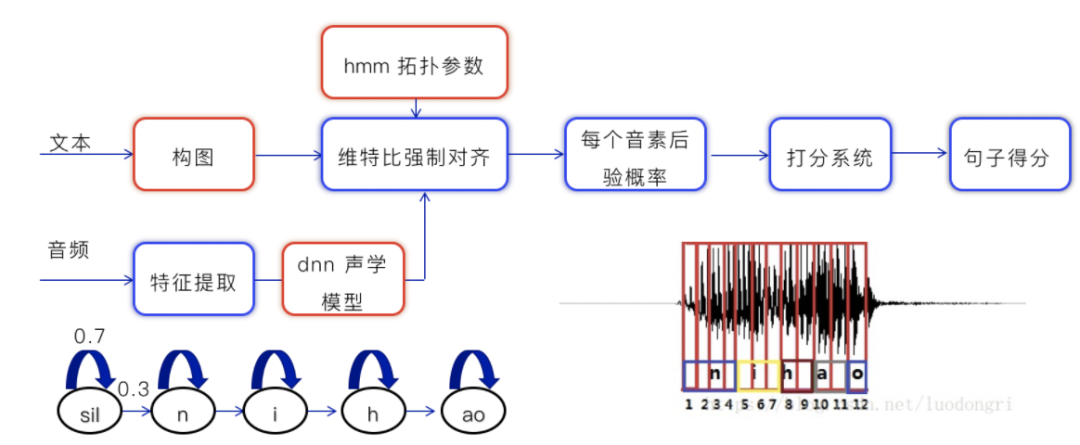

語音評測是通過機器替代人工,為少兒口語發(fā)音進行智能打分的一項功能。語音測評在伴魚的實踐,主要包括算法和框架選擇、聲學(xué)模型訓(xùn)練、效果和速度的優(yōu)化。算法方面,伴魚選擇的是用深度神經(jīng)網(wǎng)絡(luò)和隱馬兒可夫,主要原因是深度學(xué)習(xí)框架目前非常成熟。而框架選擇是kaldi,語音界使用人數(shù)最多,而且資料齊全。

深度神經(jīng)網(wǎng)絡(luò)和隱馬爾可夫算法 (dnn + hmm)的測評過程如上圖所示。首先要訓(xùn)練一個dnn聲學(xué)模型,訓(xùn)練hmm拓撲參數(shù),訓(xùn)練完之后,我們會對輸入的文本進行構(gòu)圖,對音頻進行特征提取,然后經(jīng)過聲學(xué)模型。經(jīng)過一個打分模型后,得出句子得分。

在這個過程中,數(shù)據(jù)篩選、聲學(xué)模型的訓(xùn)練、評測準確率的優(yōu)化都是關(guān)鍵。黃智超在之后的分享中還詳細分享了伴魚的語音評測在本地化的過程中模型體積優(yōu)化、測評服務(wù)魯棒性,以及如何解決異常 Case 分析困難等問題與經(jīng)驗。

為了讓大家能更便捷且深入地了解到實時音視頻開發(fā)的“臺前幕后”,我們后續(xù)將會對本次專場的所有內(nèi)容進行更為詳細的整理與解讀,詳情可點擊【閱讀原文】,關(guān)注社區(qū)最新動態(tài)!