川普跳「雞你太美」?這么專業(yè),一定是AI合成的!

來(lái)源:機(jī)器之心(almosthuman2014)

物聯(lián)網(wǎng)智庫(kù) 轉(zhuǎn)載

二次轉(zhuǎn)載請(qǐng)聯(lián)系原作者

導(dǎo)? 讀

讓人輕松「跳宅舞」的 Impersonator 更新了。

論文地址:https://arxiv.org/pdf/2011.09055.pdf

GitHub 地址:https://github.com/iPERDance/iPERCore

項(xiàng)目主頁(yè):https://www.impersonator.org/work/impersonator-plus-plus.html

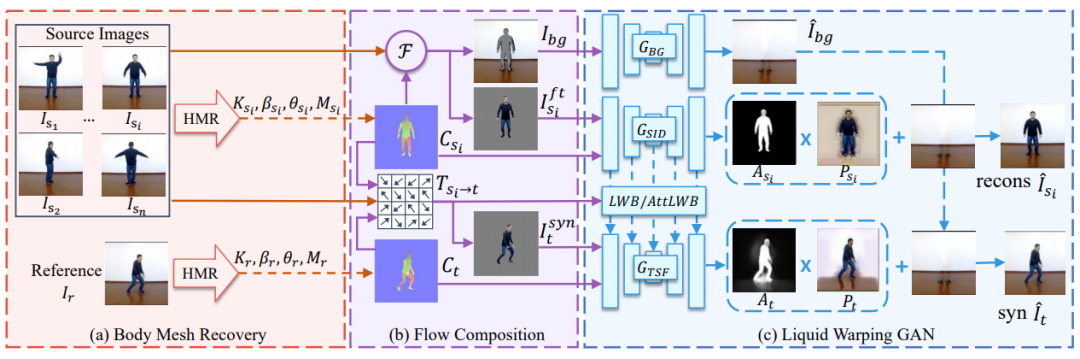

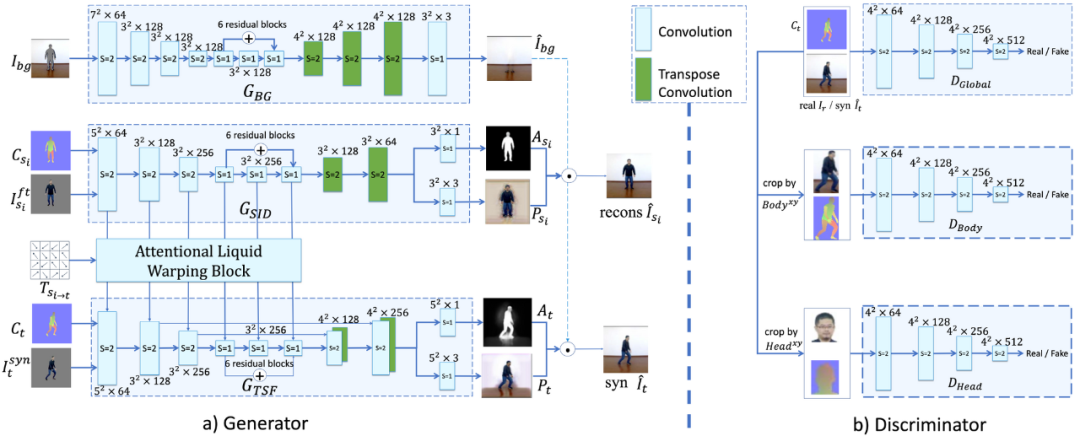

整體架構(gòu)

人體網(wǎng)格復(fù)原模塊估計(jì)每個(gè)圖像的 3D 網(wǎng)格,并渲染對(duì)應(yīng)圖 C_s 和 C_t。

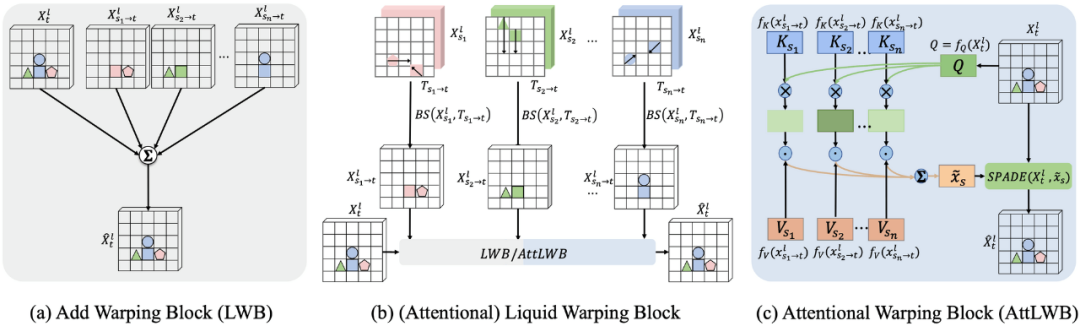

流組成模塊首先基于兩張對(duì)應(yīng)圖及其在圖像空間中的投影頂點(diǎn)來(lái)計(jì)算變換流 T。然后它將源圖像 I_s_i 分離成前景圖 I_s_i^ft 和背景蒙版 I_bg。最后該模塊基于變換流 T 對(duì)源圖像進(jìn)行處理,生成扭曲(warped)圖像 I_syn。

在 GAN 模塊,生成器由 3 個(gè)流組成:生成背景圖像的 G_BG、重建源圖像的 G_SID、在參考條件下合成目標(biāo)圖像的 G_TSF。

。

。 ,并以同樣的方法計(jì)算參考對(duì)應(yīng)圖的變換流。

,并以同樣的方法計(jì)算參考對(duì)應(yīng)圖的變換流。合成背景圖像;

根據(jù)可見(jiàn)部分預(yù)測(cè)不可見(jiàn)部分的顏色;

從 SMPL 的重建中生成衣服、頭發(fā)等像素。

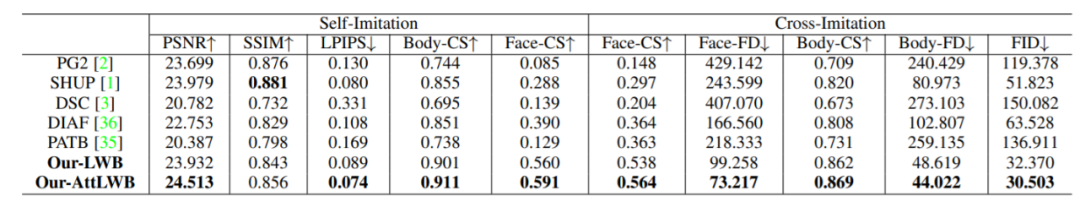

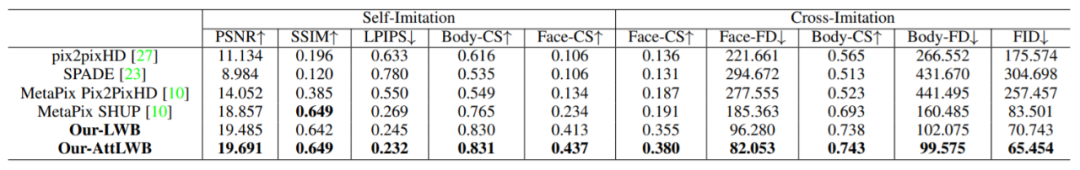

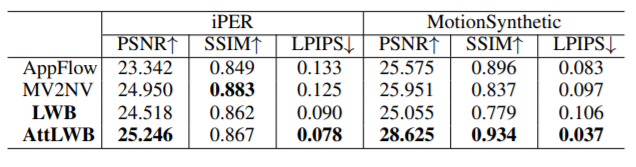

實(shí)驗(yàn)

版權(quán)聲明:“物聯(lián)網(wǎng)智庫(kù)”除發(fā)布原創(chuàng)干貨以外,致力于優(yōu)秀科技/研究/投資類文章精選、精讀。部分文章推送時(shí)未能與原作者取得聯(lián)系。若涉及版權(quán)問(wèn)題,或由于二次轉(zhuǎn)載標(biāo)錯(cuò)了轉(zhuǎn)載來(lái)源,敬請(qǐng)?jiān)髡呗?lián)系我們。聯(lián)系方式:微信My_lordmiss

往期精選