↑↑↑點擊上方藍字,回復(fù)資料,10個G的驚喜

新智元報道 來源:the gradient 編輯:Emil、Su

【導(dǎo)讀】LeCun的AI啟蒙竟是來自一本哲學(xué)書?他曾經(jīng)因為用法語寫論文阻礙了機器學(xué)習(xí)理論發(fā)展?SSL究竟能為世界帶來什么?在最近的采訪中,他向我們娓娓道來。

近日,深度學(xué)習(xí)先驅(qū)Yann LeCun接受了Gradient Podcast的采訪,暢談了他在80年代早期的AI研究以SSL的最新發(fā)展。LeCun現(xiàn)任Facebook副總裁兼首席AI科學(xué)家和紐約大學(xué)教授,2018年ACM圖靈獎得主。他在80年代率先使用卷積神經(jīng)網(wǎng)絡(luò)進行圖像處理,是AI深度學(xué)習(xí)革命的關(guān)鍵人物。

在采訪中,LeCun首先聊到了他的早期求學(xué)和科研歷程。出于對物理學(xué)的喜愛,LeCun最早選擇了工程學(xué)作為大學(xué)專業(yè),1983年,他從巴黎ESIEE大學(xué)畢業(yè)。

本科時,LeCun逐漸發(fā)現(xiàn)自己對科研的興趣勝過普通的工程學(xué),特別是人類以及其他動物智慧如何產(chǎn)生的問題。至于機器學(xué)習(xí)(當然當時還沒有這個學(xué)科),他的靈感則來自一本哲學(xué)書籍,書中介紹了一場上世紀70年代著名的辯論——語言學(xué)家和心理學(xué)家討論了語言究竟是先天還是后天習(xí)得的。辯論中提到了通過感知器,讓簡單的機器也能夠?qū)W習(xí)復(fù)雜的概念。這個話題啟發(fā)了LeCun。于是,他開始著手研究相關(guān)文獻,但是他發(fā)現(xiàn)大多數(shù)發(fā)表的內(nèi)容都集中在上世紀60年代。

阿瑟·塞繆爾在1959年發(fā)明了機器學(xué)習(xí)

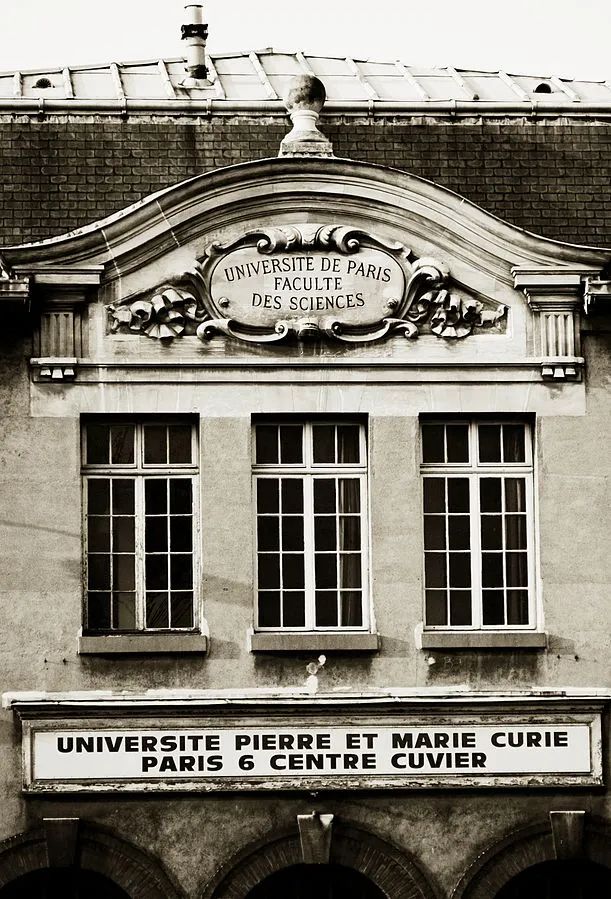

到了80年代初期,專家系統(tǒng)變得炙手可熱。但LeCun覺得這類系統(tǒng)不靠譜,那時關(guān)于機器學(xué)習(xí)的想法已經(jīng)成型。他自嘲到,「可能是因為我懶,或是發(fā)現(xiàn)了自己能力有限,所以當時覺得造一臺能夠進行自我決策的機器基本是不可能的」。LeCun還對自我組織系統(tǒng)和神經(jīng)網(wǎng)絡(luò)十分癡迷,但當時世界上進行相關(guān)研究的人并不多,且沒有一個統(tǒng)一的組織。于是,LeCun和巴黎的一個小型獨立實驗室聯(lián)系,開始展開自己的研究(注:當時的皮埃爾和馬居里大學(xué),今天的索邦大學(xué),LeCun 1987年在那里獲得了計算機專業(yè)博士學(xué)位)。

從那時起,一些新穎的觀點便從眾多簡單元素的相互碰撞中產(chǎn)生了。「這正如神經(jīng)網(wǎng)絡(luò)做的那樣」。

上世紀80年代,LeCun開始著手研究反向傳播算法。

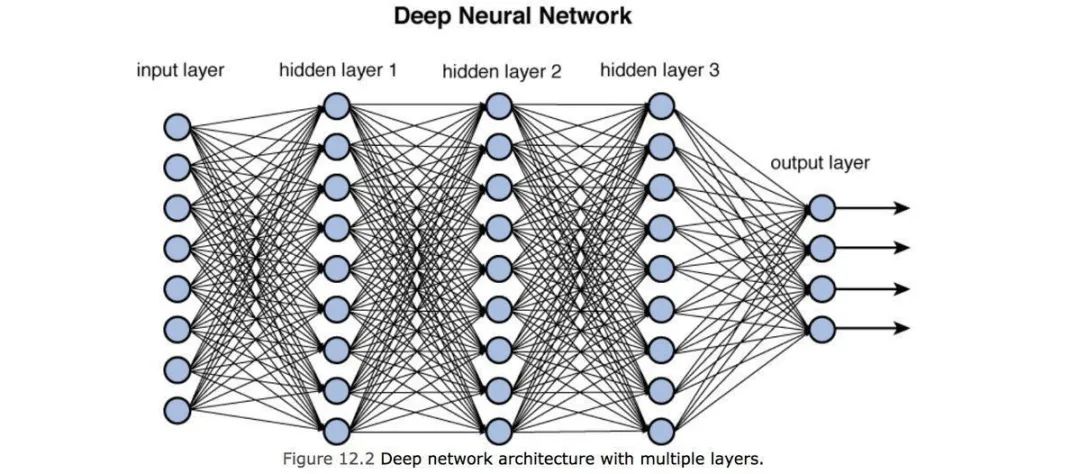

「在研究中,我意識到為什么60年代進行的神經(jīng)網(wǎng)絡(luò)早期嘗試都失敗了,因為研究它的人們都在試圖尋找網(wǎng)絡(luò)運行的規(guī)則」。

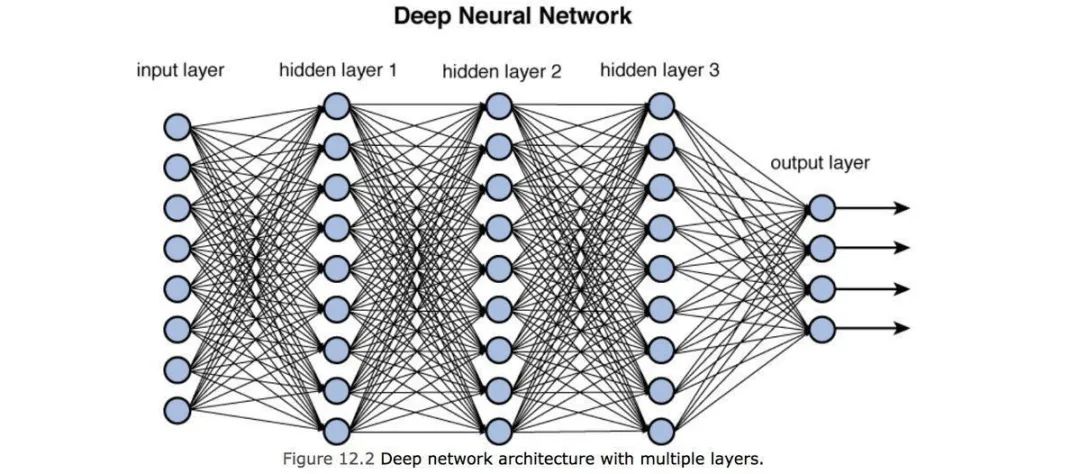

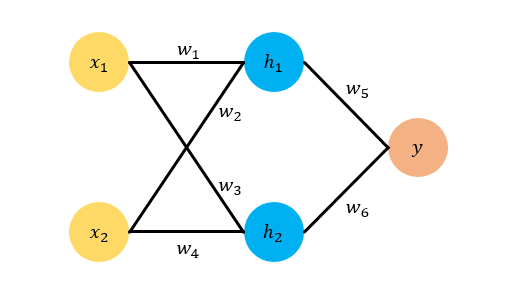

所以LeCun開始研究用多層網(wǎng)絡(luò)來覆蓋每個神經(jīng)元,無論目標輸出是什么,這樣的方法更容易計算出答案來。從60年代經(jīng)典的優(yōu)化控制算法中,LeCun得到了啟發(fā),建立了反向傳播梯度算法。

1986年,LeCun曾寫過一篇關(guān)于計算機深度學(xué)習(xí)的論文,不過是用他的母語法語寫的。而且,他后來的導(dǎo)師Geoffrey Hinton看到這篇論文時,覺得寫得「十分糟糕」。但不可否認的是,這篇論文中已經(jīng)有不少關(guān)于機器學(xué)習(xí)成熟的理論。

同之前的研究一樣,LeCun展開CNN研究的時候,靈感也來自于圖書館。從前人對于視覺系統(tǒng)的生物學(xué)研究中,LeCun發(fā)現(xiàn)了圖像的秘密。在博士即將畢業(yè)之前的6個月,LeCun開始與Leo一起開始編寫一個深度學(xué)習(xí)框架。最終他們在1989年發(fā)表論文,通過使用梯度下降方法訓(xùn)練的CNN進行圖像識別,這成為了日后計算機視覺研究的基礎(chǔ)理論。

「當時還沒有Python,所以我基本上使用的是自己的語言編寫的代碼」,那時由于多倫多有更好的研究條件,所以LeCun搬到了多倫多繼續(xù)自己的研究。在多倫多的前六個月進展并不理想,以至于Hinton多次在質(zhì)疑LeCun是不是在「摸魚」。

LeCun(右)與導(dǎo)師Hinton(中)、Bengio(左)合影「我當時在嘗試手機一些小數(shù)據(jù)集,簡而言之,就是用鼠標把一個個字符連起來」。然而當LeCun去貝爾實驗室時,他被實驗室的一個包含上千個樣本的數(shù)據(jù)集震驚到了。「當時我想這太瘋狂了。」在1988年,貝爾實驗室在2個月內(nèi)做出了最好的結(jié)果。LeCun搭建研究框架,張量引擎,以及一套前端語言,基本的機器學(xué)習(xí)流程就這樣搭建出來了。可以說,后來的TensorFlow、PyTorch等等都是基于這個概念打造的。

在視覺領(lǐng)域應(yīng)用自監(jiān)督學(xué)習(xí)可行嗎?

在談到自監(jiān)督學(xué)習(xí)時,LeCun說道在近些年的研究中,它在計算機視覺領(lǐng)域的確產(chǎn)生了許多令人興奮的成果。

當然,與基于全球巨大的圖像識別數(shù)據(jù)集的研究相比,自監(jiān)督學(xué)習(xí)仍然沒有勝算。但是在語音識別等其他領(lǐng)域,監(jiān)督學(xué)習(xí)的確帶來了許多成果。比如,它可以在10分鐘以內(nèi)訓(xùn)練一套語音識別系統(tǒng)。

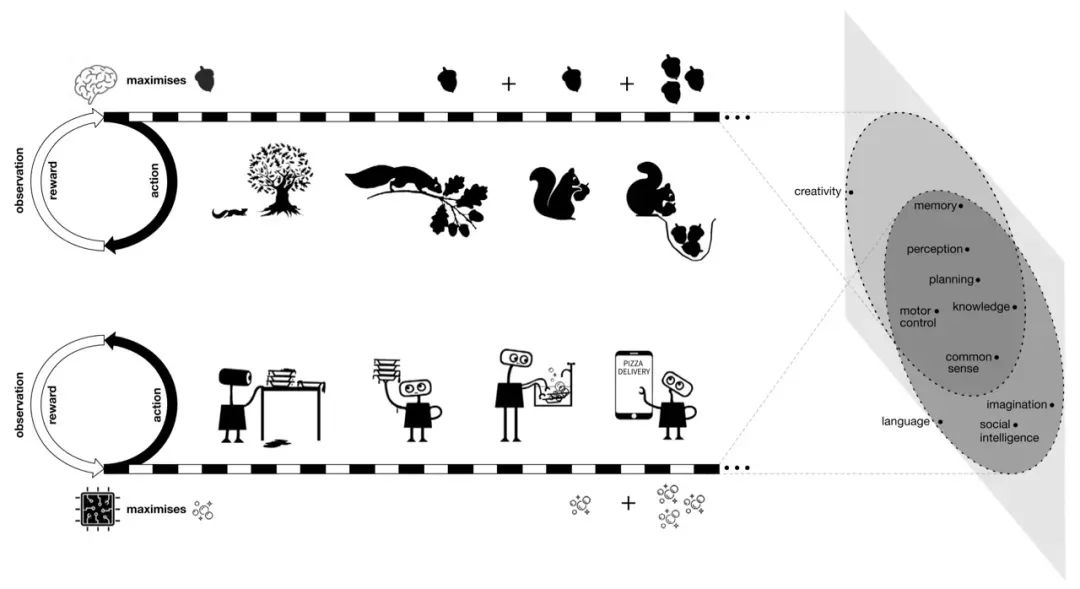

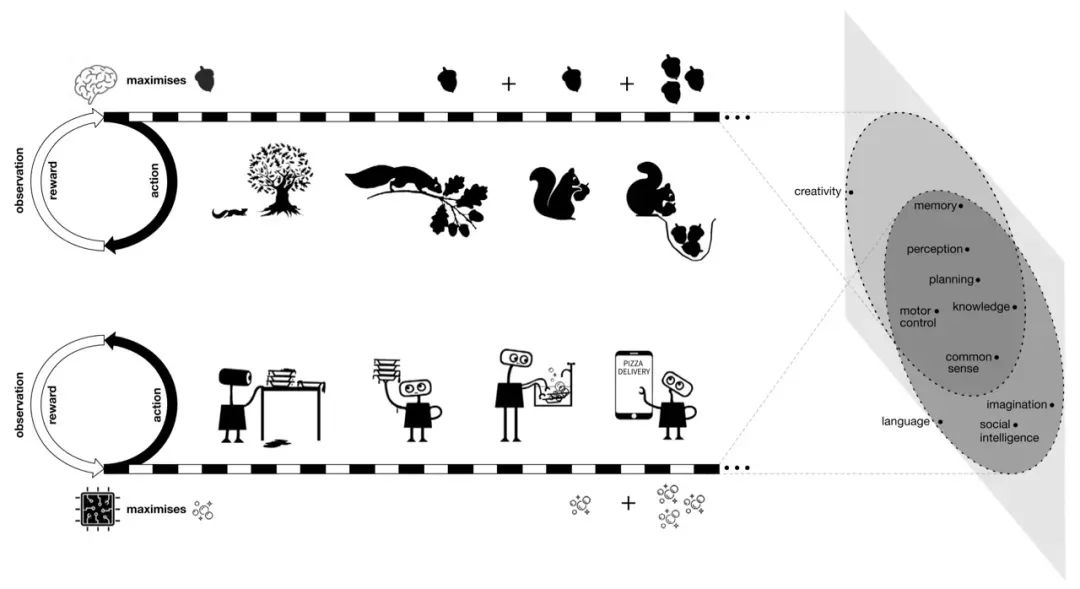

之前DeepMind兩位大神David Silver以及Richard Sutton不久前發(fā)表過驚人言論:通過獎勵最大化結(jié)合強化學(xué)習(xí)就能實現(xiàn)通用人工智能。

關(guān)于這個論調(diào)LeCun也在采訪中表明了自己的態(tài)度:「他們的觀點非常可笑,要在現(xiàn)實世界里進行數(shù)千年的訓(xùn)練。我完全不同意這種說法,我認為這完全是錯誤的。所以我們未來也不打算向那個方向前進」。目前的SSL系統(tǒng)關(guān)鍵問題在于現(xiàn)在有一個監(jiān)督系統(tǒng),你只提供很少的樣本,然后你使用監(jiān)督系統(tǒng)讓機器學(xué)會從一個輸入部分來對另一部分進行基本的預(yù)測。比如說, 提供一幅圖像的左邊和右邊,那系統(tǒng)能否判斷出兩個部分是來自于同一圖像呢?又「比如通過輸入兩段分割的視頻,AI能否自動判斷兩個視頻的邏輯關(guān)系?」所以這就需要機器了解兩者之間的依賴關(guān)系。「所以在計算機視覺方面,我認為最大的挑戰(zhàn)是讓機器通過看視頻來了解這個世界的運作方式」。

「SSL將對計算機視覺領(lǐng)域產(chǎn)生重大影響。」

談及上半年做了哪些工作,LeCun闡述了如何讓機器進行SSL?花一個小時讓機器「隨機」觀看Instagram上10億張公開照片。

也就是說,這些圖片并未做過通常用于算法訓(xùn)練的標簽和注釋處理。接下來,使用SwAV算法在這些圖像上進行預(yù)訓(xùn)練。也就是,利用數(shù)據(jù)集一邊學(xué)習(xí)一邊處理數(shù)據(jù),完成快速分組、物體檢測等任務(wù)。在這些任務(wù)中,SwAV表現(xiàn)都出奇地好,所以如果你有一個足夠大的未經(jīng)標注的數(shù)據(jù)集,這些技術(shù)將會給你帶來SOTA級的表現(xiàn)。所以SSL未來也會為計算機視覺領(lǐng)域帶來巨大的影響。

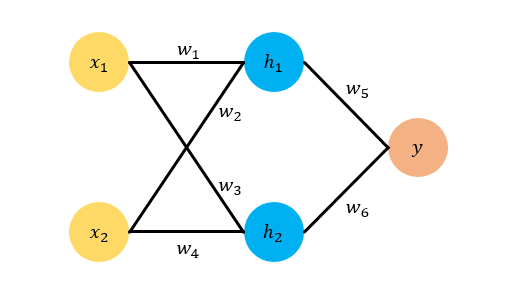

這意味著你只需要大量的數(shù)據(jù),而不進行人工標注,就能進行訓(xùn)練。在系統(tǒng)訓(xùn)練時,會產(chǎn)生平凡解,即不同輸入的圖像產(chǎn)生同樣輸入圖像的問題,我們稱之為崩潰(collapse)。LeCun的Facebook AI小組用了一個非對比的方法,通過最大化輸出的交互信息(mutual information )來避免崩潰。事實上這個方法是LeCun的導(dǎo)師Hinton在上世紀90年代發(fā)明的。例如,假設(shè)有兩個神經(jīng)網(wǎng)絡(luò)觀察圖像或視頻的兩不同部分,通過訓(xùn)練讓他們之間的交互信息量足夠大,那么崩潰就不會發(fā)生。但這個方法的難點在于如何測量兩個變量之間的交互信息。雖然交互信息有明確的定義,但是沒有明確的估計方法,它類似于一個概率分布。

所以你需要對于這個分布進行假設(shè),如果假設(shè)錯誤,那么系統(tǒng)肯定不會輸出理想的結(jié)果。這就是Hinton在90年代遇到的問題。

SSL未來潛力無限 但實現(xiàn)通用智能不太可能

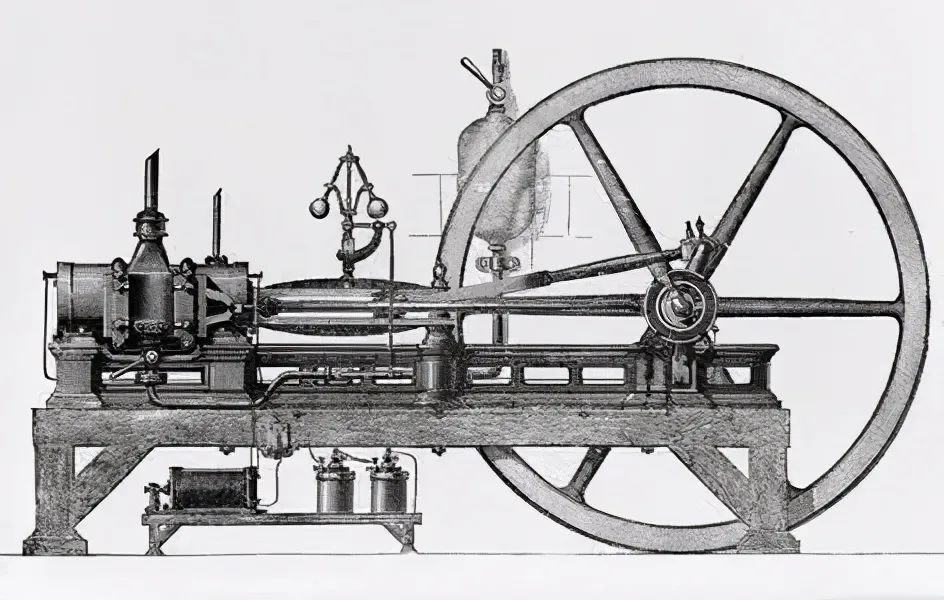

當然,目前深度學(xué)習(xí)技術(shù)仍然有許多未知理論有待于我們?nèi)ヌ剿鳌eCun給了一個有意思的比喻。

比如蒸汽機在17世紀就發(fā)明了出來,但是熱力動力學(xué)基本在100年之后才為我們解釋了蒸汽機的局限性。

又比如顯微鏡和望遠鏡同樣也是很早之前就被發(fā)明了出來,但是衍射定律也是在那之后才發(fā)現(xiàn)的。所以深度學(xué)習(xí)也一樣,做研究需要直觀地了解你究竟在做什么,如果你一味地將自己局限在模型中,你將失去接觸許多其他事物的機會,只是因為你不理解它們。深度學(xué)習(xí)技術(shù)如今已經(jīng)幾乎滲透進每一個大型互聯(lián)網(wǎng)公司的DNA中,LeCun介紹到,如果沒有深度學(xué)習(xí),那么Facebook可能立刻會垮臺。但與此同時,指望AI達到通用智能的水平,LeCun認為需要重新審視一下通用人工智能的概念。

「在我職業(yè)生涯結(jié)束前,如果AI能夠達到狗或者牛一樣的智商,那我已經(jīng)十分欣慰了」。「我不太相信通用智能的概念,所以我們必須降低期待。當然,不容否認的是通用智能是我們的努力方向,比如在自監(jiān)督領(lǐng)域取得突破性進展,讓系統(tǒng)來運行世界模型。」

智力的本質(zhì)是能夠基于你的行動來預(yù)測世界可能發(fā)生的結(jié)果,因為這樣才能夠讓你具備計劃的能力。參考資料:

https://thegradientpub.substack.com/p/yann-lecun-on-his-start-in-research

老鐵,三連支持一下,好嗎?↓↓↓