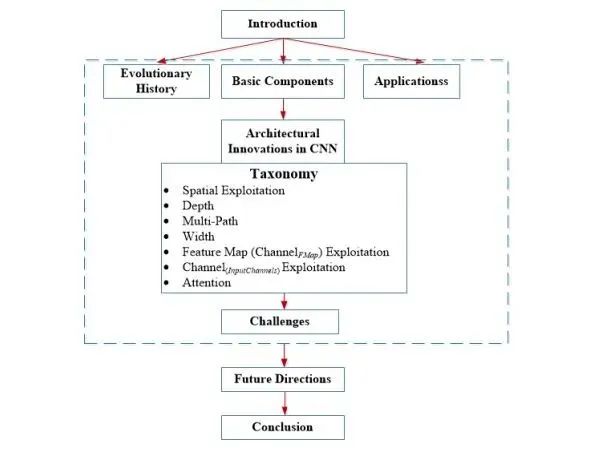

本綜述將最近的 CNN 架構(gòu)創(chuàng)新分為七個不同的類別,分別基于空間利用、深度、多路徑、寬度、特征圖利用、通道提升和注意力。

轉(zhuǎn)載自丨深度學(xué)習(xí)這件小事

深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一種特殊類型的神經(jīng)網(wǎng)絡(luò),在各種競賽基準(zhǔn)上表現(xiàn)出了當(dāng)前最優(yōu)結(jié)果。深度 CNN 架構(gòu)在挑戰(zhàn)性基準(zhǔn)任務(wù)比賽中實(shí)現(xiàn)的高性能表明,創(chuàng)新的架構(gòu)理念以及參數(shù)優(yōu)化可以提高 CNN 在各種視覺相關(guān)任務(wù)上的性能。

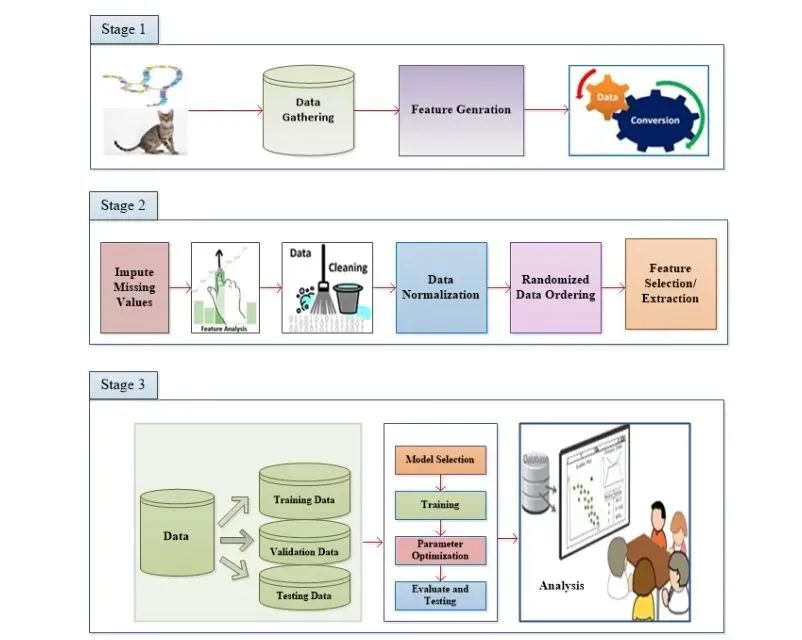

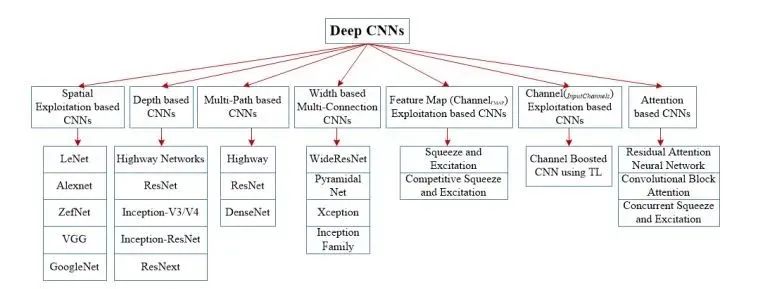

通過 1989 年 LeCun 處理網(wǎng)格狀拓?fù)鋽?shù)據(jù)(圖像和時間系列數(shù)據(jù))的研究,CNN 首次受到關(guān)注。CNN 被視為理解圖像內(nèi)容的最好技術(shù)之一,并且在圖像識別、分割、檢測和檢索相關(guān)任務(wù)上表現(xiàn)出了當(dāng)前最佳性能。CNN 的成功引起了學(xué)界外的注意。在產(chǎn)業(yè)界,如谷歌、微軟、AT&T、NEC 和 Facebook 這樣的公司都設(shè)立了研究團(tuán)隊(duì)來探索 CNN 的新架構(gòu)。目前,圖像處理競賽中的大多數(shù)領(lǐng)跑者都會采用基于深度 CNN 的模型。自 2012 年以來,關(guān)于 CNN 架構(gòu)的不同創(chuàng)新被提出來。這些創(chuàng)新可分為參數(shù)優(yōu)化、正則化、結(jié)構(gòu)重組等。但是據(jù)觀察,CNN 網(wǎng)絡(luò)的性能提升應(yīng)主要?dú)w功于處理單元的重構(gòu)和新模塊的設(shè)計(jì)。自 AlexNet 在 ImageNet 數(shù)據(jù)集上展現(xiàn)出了非凡的性能后,基于 CNN 的應(yīng)用變得越來越普及。類似地,Zeiler 和 Fergus 介紹了特征分層可視化的概念,這改變了用深度架構(gòu)(如 VGG)在簡單的低空間分辨率中提取特征的趨勢。如今,大多數(shù)新架構(gòu)都是基于 VGG 引入的簡單原則和同質(zhì)化拓?fù)錁?gòu)建的。另一方面,谷歌團(tuán)隊(duì)引入了一個非常著名的關(guān)于拆分、轉(zhuǎn)換和合并的概念,稱為 Inception 模塊。初始塊第一次使用了層內(nèi)分支的概念,允許在不同空間尺度上提取特征。2015 年,為了訓(xùn)練深度 CNN,Resnet 引入的殘差連接概念變得很有名,并且,后來的大多數(shù)網(wǎng)絡(luò)像 Inception-ResNet,WideResNet,ResNext 等都在使用它。與此類似,一些像 WideResnet、Pyramidal Nets、Xception 這樣的架構(gòu)都引入了多層轉(zhuǎn)換的概念,通過額外的基數(shù)和增加的寬度來實(shí)現(xiàn)。因此,研究的重點(diǎn)從參數(shù)優(yōu)化和連接再次調(diào)整,轉(zhuǎn)向了網(wǎng)絡(luò)架構(gòu)設(shè)計(jì)(層結(jié)構(gòu))。這引發(fā)了許多像通道提升、空間和通道利用、基于注意力的信息處理等新的架構(gòu)概念。圖 2:典型模式識別(OR)系統(tǒng)的基本布局。PR 系統(tǒng)分為三個階段:階段 1 和數(shù)據(jù)挖掘相關(guān),階段 2 執(zhí)行預(yù)處理和特征選擇,而階段 3 基于模型選擇、調(diào)參和分析。CNN 有良好的特征提取能力和強(qiáng)大的鑒別能力,因此在一個 PR 系統(tǒng)中,它可以用于特征提取/生成和模型選擇階段。 自 1989 年至今,CNN 架構(gòu)已經(jīng)有了很多不同的改進(jìn)。CNN 中的所有創(chuàng)新都是通過深度和空間相結(jié)合實(shí)現(xiàn)的。根據(jù)架構(gòu)修改的類型,CNN 可以大致分為 7 類:基于空間利用、深度、多路徑、寬度、通道提升、特征圖利用和注意力的 CNN。深度 CNN 架構(gòu)的分類如圖 3 所示。CNN 有大量參數(shù),如處理單元數(shù)量(神經(jīng)元)、層數(shù)、濾波器大小、步幅、學(xué)習(xí)率和激活函數(shù)等。由于 CNN 考慮輸入像素的鄰域(局部性),可以使用不同大小的濾波器來探索不同級別的相關(guān)性。因此,在 2000 年初,研究人員利用空間變換來提升性能,此外,還評估了不同大小的濾波器對網(wǎng)絡(luò)學(xué)習(xí)率的影響。不同大小的濾波器封裝不同級別的粒度;通常,較小的濾波器提取細(xì)粒度信息,而較大的濾波器提取粗粒度信息。這樣,通過調(diào)整濾波器大小,CNN 可以在粗粒度和細(xì)粒度的細(xì)節(jié)上都表現(xiàn)很好。深度 CNN 架構(gòu)基于這樣一種假設(shè):隨著深度的增加,網(wǎng)絡(luò)可以通過大量非線性映射和改進(jìn)的特征表示更好地逼近目標(biāo)函數(shù)。網(wǎng)絡(luò)深度在監(jiān)督學(xué)習(xí)的成功中起了重要作用。理論研究已表明,深度網(wǎng)絡(luò)能夠以指數(shù)方式比淺層網(wǎng)絡(luò)更有效地表示特定的 20 個函數(shù)類型。2001 年,Csáji 表示了通用近似定理,指出單個隱藏層足夠逼近任何函數(shù),但這需要指數(shù)級的神經(jīng)元,因而通常導(dǎo)致計(jì)算上行不通。在這方面,Bengio 和 elalleau 認(rèn)為更深的網(wǎng)絡(luò)有潛力在更少的成本下保持網(wǎng)絡(luò)的表現(xiàn)能力。2013 年,Bengio 等人通過 實(shí)證表明,對于復(fù)雜的任務(wù),深度網(wǎng)絡(luò)在計(jì)算和統(tǒng)計(jì)上都更有效。在 2014-ILSVR 競賽中表現(xiàn)最佳的 Inception 和 VGG 則進(jìn)一步說明,深度是調(diào)節(jié)網(wǎng)絡(luò)學(xué)習(xí)能力的重要維度。一旦特征被提取,只要其相對于其他位置的近似位置被保留,其提取位置就變得沒那么重要了。池化或下采樣(如卷積)是一種有趣的局部操作。它總結(jié)了感受野附近的類似信息,并輸出了該局部區(qū)域內(nèi)的主要反應(yīng)。作為卷積運(yùn)算的輸出結(jié)果,特征圖案可能會出現(xiàn)在圖像中的不同位置。

深度網(wǎng)絡(luò)的訓(xùn)練頗具挑戰(zhàn)性,這也是近來很多深度網(wǎng)絡(luò)研究的主題。深度 CNN 為復(fù)雜任務(wù)提供了高效的計(jì)算和統(tǒng)計(jì)。但是,更深的網(wǎng)絡(luò)可能會遭遇性能下降或梯度消失/爆炸的問題,而這通常是由增加深度而非過擬合造成的。梯度消失問題不僅會導(dǎo)致更高的測試誤差,還會導(dǎo)致更高的訓(xùn)練誤差。為了訓(xùn)練更深的網(wǎng)絡(luò),多路徑或跨層連接的概念被提出。多路徑或捷徑連接可以通過跳過一些中間層,系統(tǒng)地將一層連接到另一層,以使特定的信息流跨過層。跨層連接將網(wǎng)絡(luò)劃分為幾塊。這些路徑也嘗試通過使較低層訪問梯度來解決梯度消失問題。為此,使用了不同類型的捷徑連接,如零填充、基于投影、dropout 和 1x1 連接等。

激活函數(shù)是一種決策函數(shù),有助于學(xué)習(xí)復(fù)雜的模式。選擇適當(dāng)?shù)募せ詈瘮?shù)可以加速學(xué)習(xí)過程。卷積特征圖的激活函數(shù)定義為等式(3)。

2012 至 2015 年,網(wǎng)絡(luò)架構(gòu)的重點(diǎn)是深度的力量,以及多通道監(jiān)管連接在網(wǎng)絡(luò)正則化中的重要性。然而,網(wǎng)絡(luò)的寬度和深度一樣重要。通過在一層之內(nèi)并行使用多處理單元,多層感知機(jī)獲得了在感知機(jī)上映射復(fù)雜函數(shù)的優(yōu)勢。這表明寬度和深度一樣是定義學(xué)習(xí)原則的一個重要參數(shù)。Lu 等人和 Hanin & Sellke 最近表明,帶有線性整流激活函數(shù)的神經(jīng)網(wǎng)絡(luò)要足夠?qū)挷拍茈S著深度增加保持通用的近似特性。并且,如果網(wǎng)絡(luò)的最大寬度不大于輸入維度,緊致集上的連續(xù)函數(shù)類無法被任意深度的網(wǎng)絡(luò)很好地近似。因此,多層堆疊(增加層)可能不會增加神經(jīng)網(wǎng)絡(luò)的表征能力。與深度架構(gòu)相關(guān)的一個重要問題是,有些層或處理單元可能無法學(xué)習(xí)有用的特征。為了解決這一問題,研究的重點(diǎn)從深度和較窄的架構(gòu)轉(zhuǎn)移到了較淺和較寬的架構(gòu)上。CNN 因其分層學(xué)習(xí)和自動特征提取能力而聞名于 MV 任務(wù)中。特征選擇在決定分類、分割和檢測模塊的性能上起著重要作用。傳統(tǒng)特征提取技術(shù)中分類模塊的性能要受限于特征的單一性。相較于傳統(tǒng)技術(shù),CNN 使用多階段特征提取,根據(jù)分配的輸入來提取不同類型的特征(CNN 中稱之為特征圖)。但是,一些特征圖有很少或者幾乎沒有目標(biāo)鑒別作用。巨大的特征集有噪聲效應(yīng),會導(dǎo)致網(wǎng)絡(luò)過擬合。這表明,除了網(wǎng)絡(luò)工程外,特定類別特征圖的選取對改進(jìn)網(wǎng)絡(luò)的泛化性能至關(guān)重要。在這一部分,特征圖和通道會交替使用,因?yàn)楹芏嘌芯空咭呀?jīng)用通道這個詞代替了特征圖。圖像表征在決定圖像處理算法的性能方面起著重要作用。圖像的良好表征可以定義來自緊湊代碼的圖像的突出特征。在不同的研究中,不同類型的傳統(tǒng)濾波器被用來提取單一類型圖像的不同級別信息。這些不同的表征被用作模型的輸入,以提高性能。CNN 是一個很好的特征學(xué)習(xí)器,它能根據(jù)問題自動提取鑒別特征。但是,CNN 的學(xué)習(xí)依賴于輸入表征。如果輸入中缺乏多樣性和類別定義信息,CNN 作為鑒別器的性能就會受到影響。為此,輔助學(xué)習(xí)器的概念被引入到 CNN 中來提升網(wǎng)絡(luò)的輸入表征。不同的抽象級別在定義神經(jīng)網(wǎng)絡(luò)的鑒別能力方面有著重要的作用。除此之外,選擇與上下文相關(guān)的特征對于圖像定位和識別也很重要。在人類的視覺系統(tǒng)中,這種現(xiàn)象叫做注意力。人類在一次又一次的匆匆一瞥中觀察場景并注意與上下文相關(guān)的部分。在這個過程中,人類不僅注意選擇的區(qū)域,而且推理出關(guān)于那個位置的物體的不同解釋。因此,它有助于人類以更好的方式來抓取視覺結(jié)構(gòu)。類似的解釋能力被添加到像 RNN 和 LSTM 這樣的神經(jīng)網(wǎng)絡(luò)中。上述網(wǎng)絡(luò)利用注意力模塊來生成序列數(shù)據(jù),并且根據(jù)新樣本在先前迭代中的出現(xiàn)來對其加權(quán)。不同的研究者把注意力概念加入到 CNN 中來改進(jìn)表征和克服數(shù)據(jù)的計(jì)算限制問題。注意力概念有助于讓 CNN 變得更加智能,使其在雜亂的背景和復(fù)雜的場景中也能識別物體。論文:A Survey of the Recent Architectures of Deep Convolutional Neural Networks論文地址:https://arxiv.org/abs/1901.06032摘要:深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一種特殊類型的神經(jīng)網(wǎng)絡(luò),在各種競賽基準(zhǔn)上表現(xiàn)出了當(dāng)前最優(yōu)結(jié)果。深度 CNN 的超強(qiáng)學(xué)習(xí)能力主要是通過使用多個非線性特征提取階段實(shí)現(xiàn)的,這些階段能夠從數(shù)據(jù)中自動學(xué)習(xí)分層表征。大量數(shù)據(jù)的可用性和硬件處理單元的改進(jìn)加速了 CNN 的研究,最近也報道了非常有趣的深度 CNN 架構(gòu)。近來,深度 CNN 架構(gòu)在挑戰(zhàn)性基準(zhǔn)任務(wù)比賽中實(shí)現(xiàn)的高性能表明,創(chuàng)新的架構(gòu)理念以及參數(shù)優(yōu)化可以提高 CNN 在各種視覺相關(guān)任務(wù)上的性能。鑒于此,關(guān)于 CNN 設(shè)計(jì)的不同想法被探索出來,如使用不同的激活函數(shù)和損失函數(shù)、參數(shù)優(yōu)化、正則化以及處理單元的重構(gòu)。然而,在表征能力方面的主要改進(jìn)是通過重構(gòu)處理單元來實(shí)現(xiàn)的。尤其是,使用塊而不是層來作為結(jié)構(gòu)單元的想法獲得了極大的贊賞。本綜述將最近的 CNN 架構(gòu)創(chuàng)新分為七個不同的類別。這七個類別分別基于空間利用、深度、多路徑、寬度、特征圖利用、通道提升和注意力。此外,本文還涵蓋了對 CNN 組成部分的基本理解,并揭示了 CNN 目前面臨的挑戰(zhàn)及其應(yīng)用。