面部識(shí)別必看!5篇頂級(jí)論文了解如何實(shí)現(xiàn)人臉?lè)雌墼p、跨姿勢(shì)識(shí)別等

??新智元報(bào)道??

來(lái)源:lionbridge

編輯:鵬飛

【新智元導(dǎo)讀】?面部識(shí)別或面部識(shí)別是計(jì)算機(jī)視覺(jué)中最大的研究領(lǐng)域之一。許多公司都投資于面部識(shí)別技術(shù)的研究和開(kāi)發(fā)。本文篩選了5篇非常重量級(jí)的有關(guān)人臉識(shí)別的機(jī)器學(xué)習(xí)論文,并提煉出論文最關(guān)鍵的信息。來(lái)新智元 AI 朋友圈與AI大咖一起討論吧~

面部識(shí)別是計(jì)算機(jī)視覺(jué)中最大的研究領(lǐng)域之一。現(xiàn)在,我們可以使用面部識(shí)別來(lái)解鎖手機(jī),在安全門上驗(yàn)證身份,并在某些國(guó)家/地區(qū)進(jìn)行刷臉支付。許多公司都投資于面部識(shí)別技術(shù)的研究和開(kāi)發(fā),本文將重點(diǎn)介紹其中的一些研究,并介紹五篇有關(guān)人臉識(shí)別的機(jī)器學(xué)習(xí)論文。

隨著大量實(shí)際應(yīng)用,人臉識(shí)別技術(shù)變得越來(lái)越重要。從智能手機(jī)解鎖到人臉驗(yàn)證付款方式,人臉識(shí)別可以在許多方面提高安全性和監(jiān)視能力。

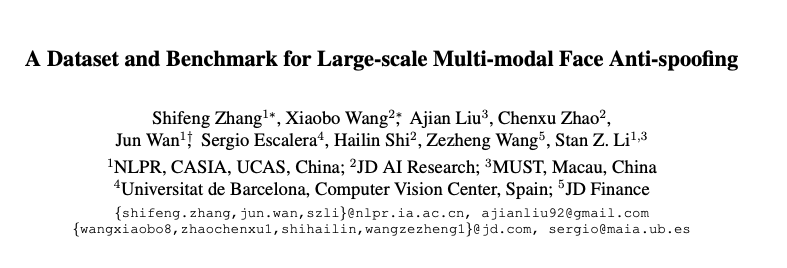

但是,該技術(shù)也帶來(lái)一些風(fēng)險(xiǎn)。可以使用多種面部欺詐方法來(lái)欺詐這些系統(tǒng)。因此,面部防欺詐對(duì)于防止安全漏洞至關(guān)重要。

在本文中,作者提出了一種稱為FaceNet的面部識(shí)別系統(tǒng)。?

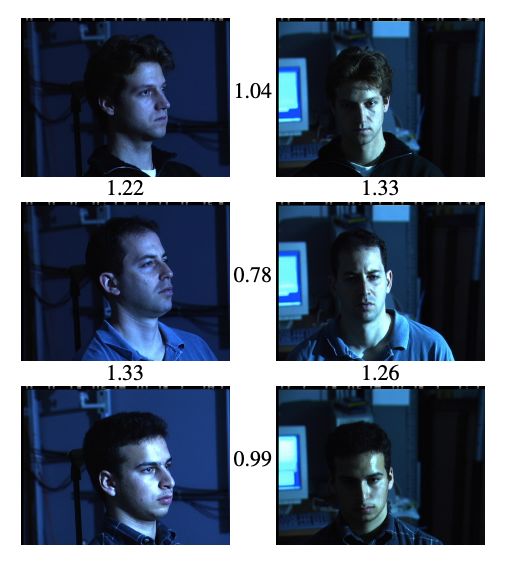

用于面部識(shí)別的當(dāng)前嵌入方法,能夠在受控設(shè)置中實(shí)現(xiàn)高性能。這些方法通過(guò)拍攝一張臉部圖像并將有關(guān)該臉部的數(shù)據(jù)存儲(chǔ)在潛在的語(yǔ)義空間中而起作用。

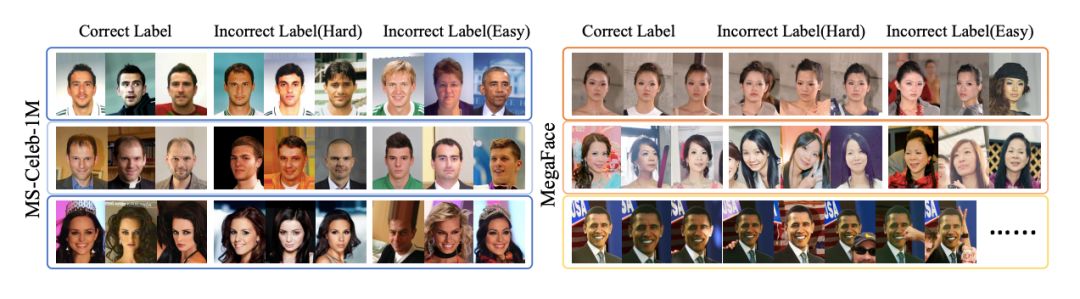

用于面部識(shí)別的當(dāng)前嵌入方法,能夠在受控設(shè)置中實(shí)現(xiàn)高性能。這些方法通過(guò)拍攝一張臉部圖像并將有關(guān)該臉部的數(shù)據(jù)存儲(chǔ)在潛在的語(yǔ)義空間中而起作用。 商湯研究院,加利福尼亞大學(xué)圣地亞哥分校和南洋理工大學(xué)的研究人員研究了大規(guī)模面部圖像數(shù)據(jù)集中的噪聲影響。

商湯研究院,加利福尼亞大學(xué)圣地亞哥分校和南洋理工大學(xué)的研究人員研究了大規(guī)模面部圖像數(shù)據(jù)集中的噪聲影響。

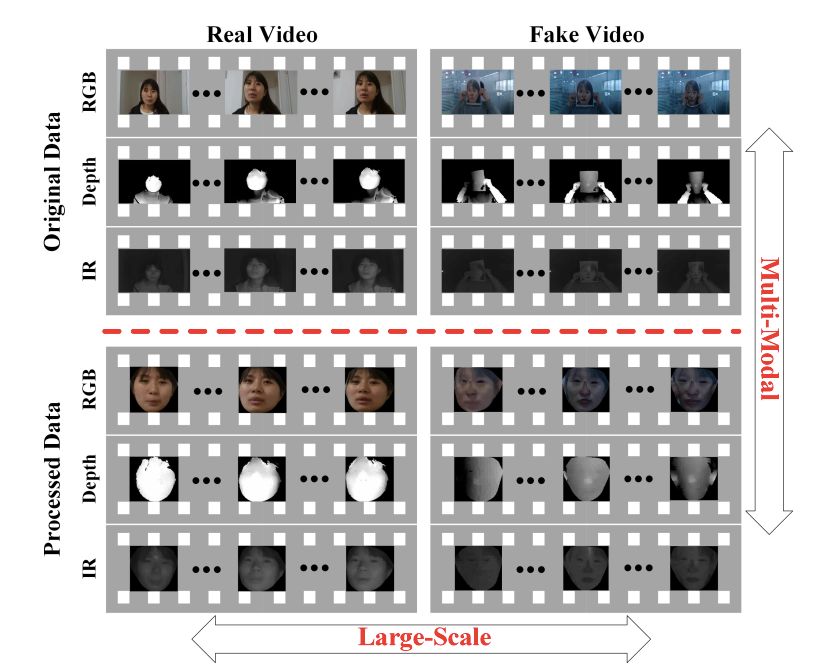

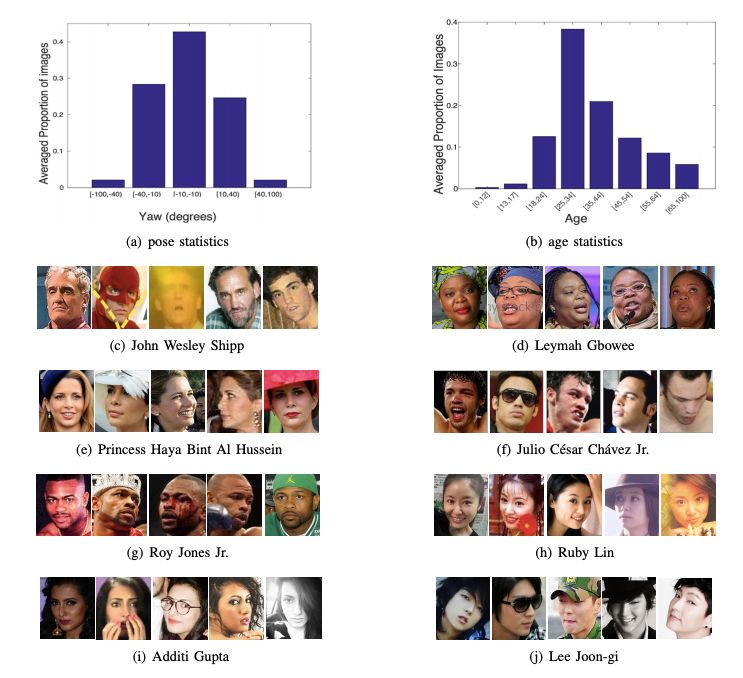

關(guān)于深度卷積神經(jīng)網(wǎng)絡(luò)的面部識(shí)別已經(jīng)進(jìn)行了許多研究。 反過(guò)來(lái),已經(jīng)創(chuàng)建了許多大規(guī)模的面部圖像數(shù)據(jù)集來(lái)訓(xùn)練那些模型。 但是,本文的作者指出,先前發(fā)布的數(shù)據(jù)集并未包含有關(guān)面部姿勢(shì)和年齡變化的大量數(shù)據(jù)。

評(píng)論

圖片

表情