用Transformer進(jìn)行圖像語(yǔ)義分割,性能超最先進(jìn)的卷積方法!

點(diǎn)擊上方“程序員大白”,選擇“星標(biāo)”公眾號(hào)

重磅干貨,第一時(shí)間送達(dá)

豐色 發(fā)自 凹非寺

報(bào)道 | 量子位

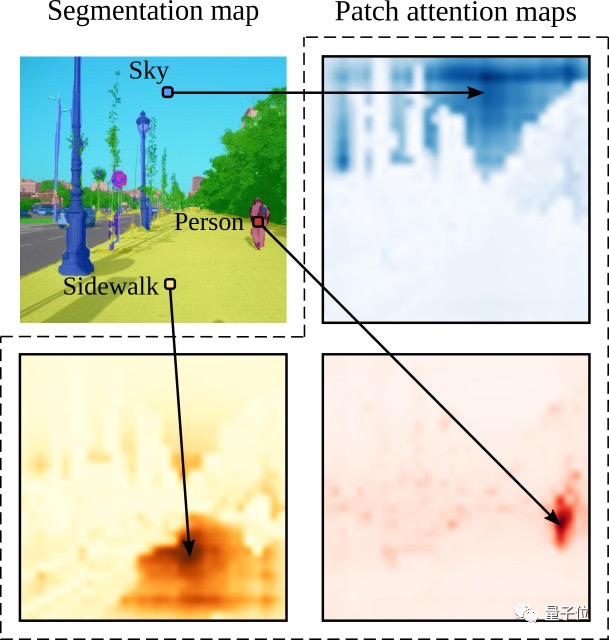

正如大家所知,在進(jìn)行圖像語(yǔ)義分割時(shí),圖像被編碼成一系列補(bǔ)丁后往往很模糊,需要借助上下文信息才能被正確分割。

因此上下文建模對(duì)圖像語(yǔ)義分割的性能至關(guān)重要!

而與以往基于卷積網(wǎng)絡(luò)的方法不同,來(lái)自法國(guó)的一個(gè)研究團(tuán)隊(duì)另辟蹊徑,提出了一種只使用Transformer的語(yǔ)義分割方法。

該方法“效果拔群”,可以很好地捕捉圖像全局上下文信息!

要知道,就連取得了驕人成績(jī)的FCN(完全卷積網(wǎng)絡(luò))都有“圖像全局信息訪問(wèn)限制”的問(wèn)題。(卷積結(jié)構(gòu)在圖像語(yǔ)義分割方面目前有無(wú)法打破的局限)

而這次這個(gè)方法在具有挑戰(zhàn)性的ADE20K數(shù)據(jù)集上,性能都超過(guò)了最先進(jìn)的卷積方法!

不得不說(shuō),Transformer跨界計(jì)算機(jī)視覺(jué)領(lǐng)域真是越來(lái)越頻繁了、效果也越來(lái)越成功了!

那這次表現(xiàn)優(yōu)異的Transformer語(yǔ)義分割,用了什么不一樣的“配方”嗎?

使用Vision Transformer

沒(méi)錯(cuò),這次這個(gè)最終被命名為Segmenter的語(yǔ)義分割模型,主要基于去年10月份才誕生的一個(gè)用于計(jì)算機(jī)視覺(jué)領(lǐng)域的“新秀”Transformer:Vision Transformer,簡(jiǎn)稱ViT。

ViT有多“秀”呢?

ViT采用純Transformer架構(gòu),將圖像分成多個(gè)patches進(jìn)行輸入,在很多圖像分類任務(wù)中表現(xiàn)都不輸最先進(jìn)的卷積網(wǎng)絡(luò)。

缺點(diǎn)就是在訓(xùn)練數(shù)據(jù)集較小時(shí),性能不是很好。

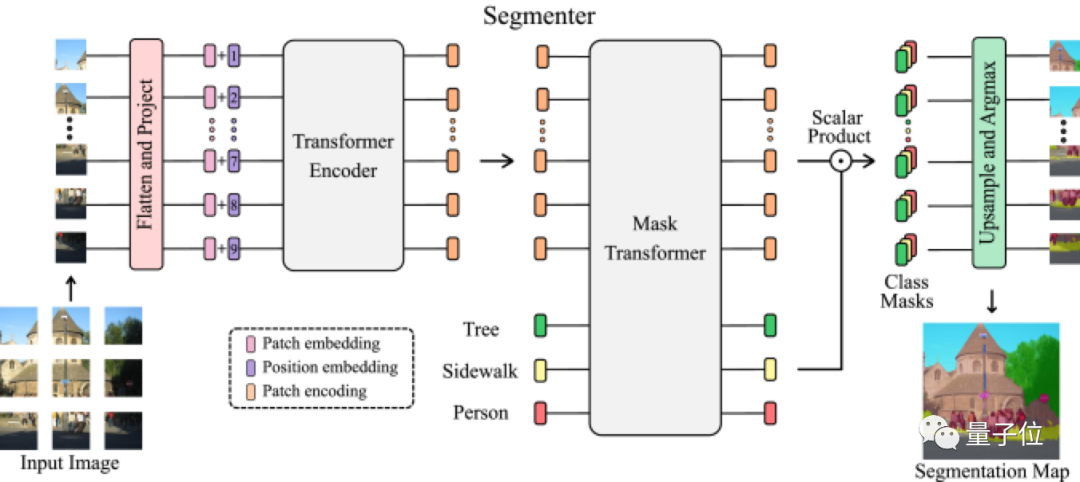

Segmenter作為一個(gè)純Transformer的編碼-解碼架構(gòu),利用了模型每一層的全局圖像上下文。

基于最新的ViT研究成果,將圖像分割成塊(patches),并將它們映射為一個(gè)線性嵌入序列,用編碼器進(jìn)行編碼。再由Mask Transformer將編碼器和類嵌入的輸出進(jìn)行解碼,上采樣后應(yīng)用Argmax給每個(gè)像素一一分好類,輸出最終的像素分割圖。

下面是該模型的架構(gòu)示意圖:

解碼階段采用了聯(lián)合處理圖像塊和類嵌入的簡(jiǎn)單方法,解碼器Mask Transformer可以通過(guò)用對(duì)象嵌入代替類嵌入來(lái)直接進(jìn)行全景分割。

效果如何

多說(shuō)無(wú)益,看看實(shí)際效果如何?

首先他們?cè)贏DE20K數(shù)據(jù)集上比較不同Transformer變體,研究不同參數(shù)(正則化、模型大小、圖像塊大小、訓(xùn)練數(shù)據(jù)集大小,模型性能,不同的解碼器等),全方面比較Segmenter與基于卷積的語(yǔ)義分割方法。

其中ADE20K數(shù)據(jù)集,包含具有挑戰(zhàn)性的細(xì)粒度(fine-grained)標(biāo)簽場(chǎng)景,是最具挑戰(zhàn)性的語(yǔ)義分割數(shù)據(jù)集之一。

下表是不同正則化方案的比較結(jié)果:

他們發(fā)現(xiàn)隨機(jī)深度(Stochastic Depth)方案可獨(dú)立提高性能,而dropout無(wú)論是單獨(dú)還是與隨機(jī)深度相結(jié)合,都會(huì)損耗性能。

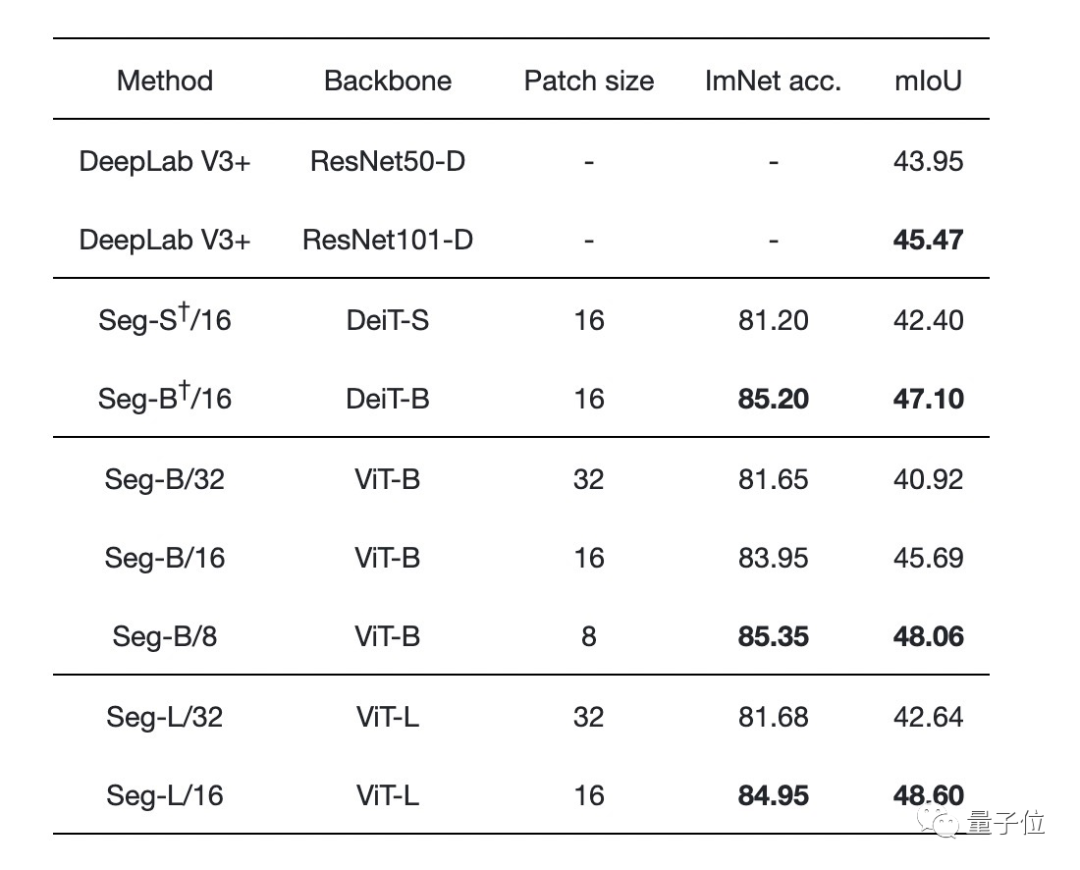

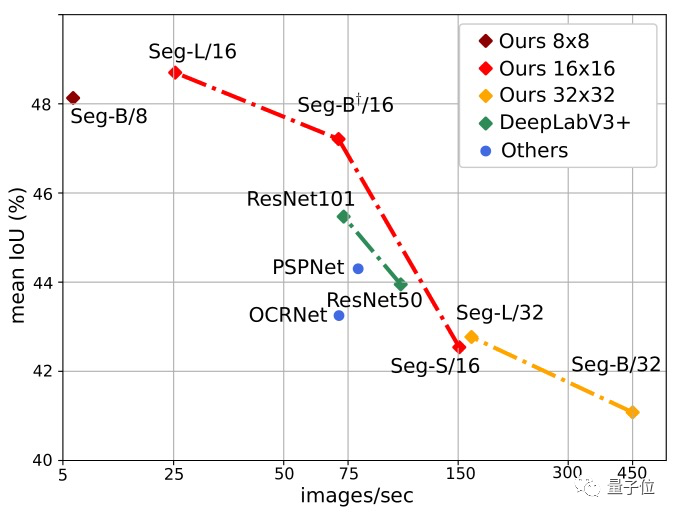

不同圖像塊大小和不同transformer的性能比較發(fā)現(xiàn):

增加圖像塊的大小會(huì)導(dǎo)致圖像的表示更粗糙,但會(huì)產(chǎn)生處理速度更快的小序列。

減少圖像塊大小是一個(gè)強(qiáng)大的改進(jìn)方式,不用引入任何參數(shù)!但需要在較長(zhǎng)的序列上計(jì)算Attention,會(huì)增加計(jì)算時(shí)間和內(nèi)存占用。

Segmenter在使用大型transformer模型或小規(guī)模圖像塊的情況下更優(yōu):

(表中間是帶有線性解碼器的不同編碼器,表底部是帶有Mask Transformer作為解碼器的不同編碼器)

下圖也顯示了Segmenter的明顯優(yōu)勢(shì),其中Seg/16模型(圖像塊大小為16x16)在性能與準(zhǔn)確性方面表現(xiàn)最好。

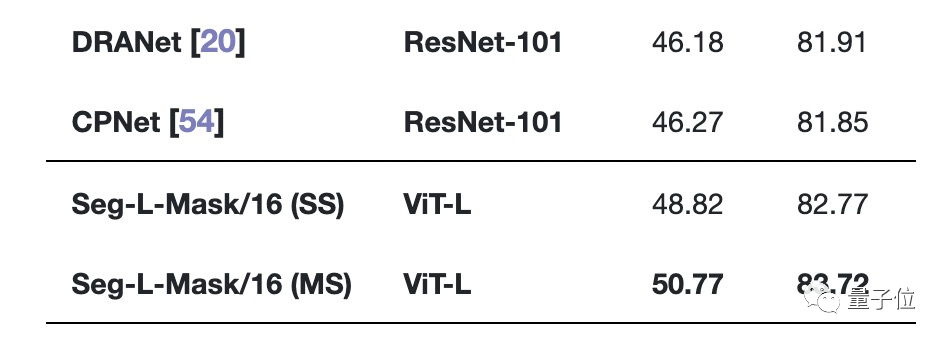

最后,我們?cè)賮?lái)看看Segmenter與SOTA的比較:

在最具挑戰(zhàn)性的ADE20K數(shù)據(jù)集上,Segmenter兩項(xiàng)指標(biāo)均高于所有SOTA模型!

(中間太長(zhǎng)已省略)

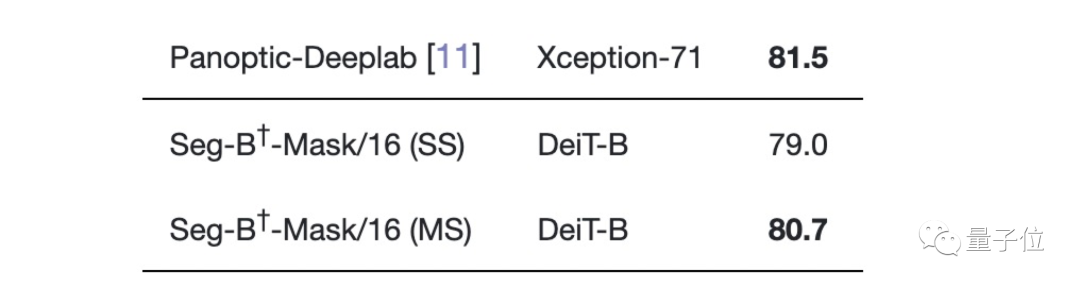

在Cityscapes數(shù)據(jù)集上與大多數(shù)SOTA不相上下,只比性能最好的Panoptic-Deeplab低0.8。

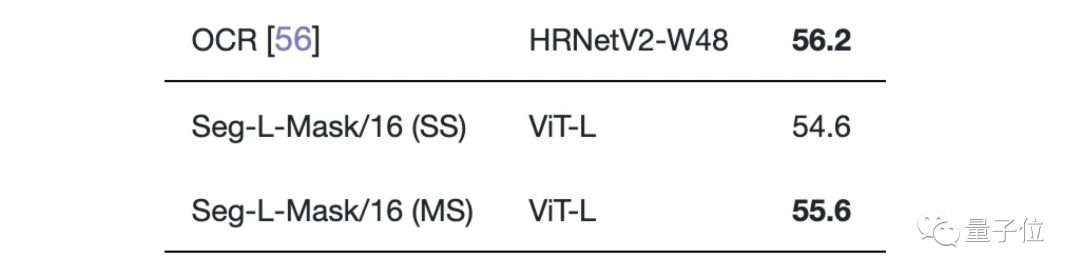

在Pascal Context數(shù)據(jù)集上的表現(xiàn)也是如此。

剩余參數(shù)比較,大家有興趣的可按需查看論文細(xì)節(jié)。

論文地址:

https://www.arxiv-vanity.com/papers/2105.05633/

推薦閱讀

國(guó)產(chǎn)小眾瀏覽器因屏蔽視頻廣告,被索賠100萬(wàn)(后續(xù))

年輕人“不講武德”:因看黃片上癮,把網(wǎng)站和786名女主播起訴了

關(guān)于程序員大白

程序員大白是一群哈工大,東北大學(xué),西湖大學(xué)和上海交通大學(xué)的碩士博士運(yùn)營(yíng)維護(hù)的號(hào),大家樂(lè)于分享高質(zhì)量文章,喜歡總結(jié)知識(shí),歡迎關(guān)注[程序員大白],大家一起學(xué)習(xí)進(jìn)步!

推薦閱讀

國(guó)產(chǎn)小眾瀏覽器因屏蔽視頻廣告,被索賠100萬(wàn)(后續(xù))

年輕人“不講武德”:因看黃片上癮,把網(wǎng)站和786名女主播起訴了

關(guān)于程序員大白

程序員大白是一群哈工大,東北大學(xué),西湖大學(xué)和上海交通大學(xué)的碩士博士運(yùn)營(yíng)維護(hù)的號(hào),大家樂(lè)于分享高質(zhì)量文章,喜歡總結(jié)知識(shí),歡迎關(guān)注[程序員大白],大家一起學(xué)習(xí)進(jìn)步!