(附論文&代碼)ContNet:為什么不同時(shí)使用卷積和變壓器

摘要

比起與最近提出的基于變壓器模型(例如,維特,DeiT)敏感hyper-parameters和極其依賴一堆數(shù)據(jù)擴(kuò)增在中型從頭訓(xùn)練數(shù)據(jù)集(例如,ImageNet1k),可以優(yōu)化ConTNet回旋網(wǎng)像正常(如ResNet)和保持一個(gè)優(yōu)秀的魯棒性。值得指出的是,給定相同的強(qiáng)數(shù)據(jù)增強(qiáng),ConTNet的性能改進(jìn)比ResNet更顯著。作者展示了它在圖像分類和下游任務(wù)上的優(yōu)越性和有效性。例如,作者的ConTNet在ImageNet上達(dá)到81:8%的top-1精度,與DeiT-B相同,但計(jì)算復(fù)雜度低于40%。在COCO2017數(shù)據(jù)集上,ConTNet-M作為Faster-RCNN和Mask-RCNN的骨干,表現(xiàn)也優(yōu)于ResNet50(分別領(lǐng)先2:6%和3:2%)。作者希望ConTNet能夠成為CV任務(wù)的骨干,并為模型設(shè)計(jì)帶來新的思路。

代碼鏈接:https://github.com/yan-hao-tian/ConTNet

簡(jiǎn)而言之,這項(xiàng)工作的貢獻(xiàn)有三方面。

1)據(jù)作者所知,作者提出的ConTNet是第一次探索建立一個(gè)神經(jīng)網(wǎng)絡(luò)與標(biāo)準(zhǔn)變壓器編碼器(STE)和空間卷積。

2)與最近流行的視覺轉(zhuǎn)換器相比,ConTNet更容易優(yōu)化。除了魯棒性,ConTNet在圖像識(shí)別方面表現(xiàn)出色。

3)實(shí)驗(yàn)結(jié)果表明,該方法具有良好的遷移學(xué)習(xí)效果。這些結(jié)果表明,ConTNet提供了一種新的基于轉(zhuǎn)換變壓器的模式來擴(kuò)大模型的接收?qǐng)觥?/span>

框架結(jié)構(gòu)

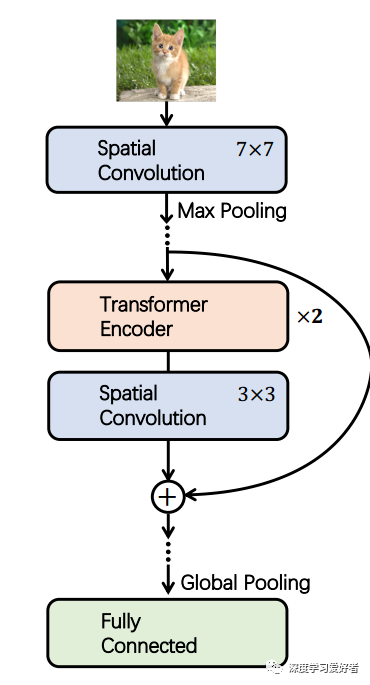

建議的ConTNet框架的說明

ConTNet包含多個(gè)contt塊,由兩個(gè)變壓器編碼器層和一個(gè)卷積層組成。

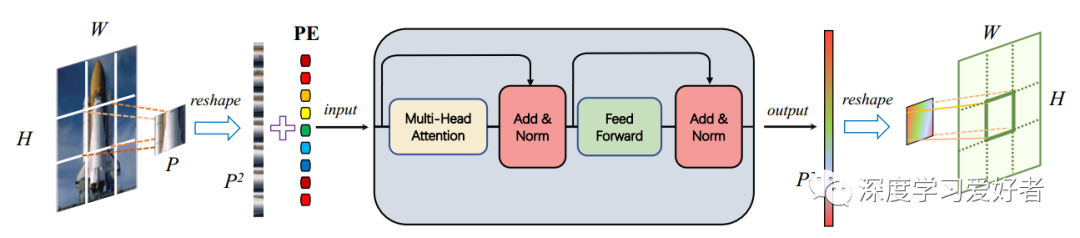

ConTNet中的一個(gè)補(bǔ)丁式標(biāo)準(zhǔn)變壓器編碼器(STE)

PE表示位置編碼。H和W分別為輸入和輸出圖像的高度和寬度。P為patch的大小。p2為STE輸入輸出序列的長(zhǎng)度。

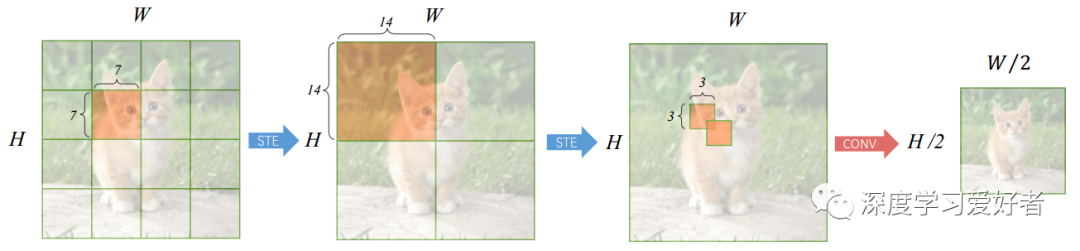

信息流在一個(gè)ConT塊

對(duì)于被橙色陰影覆蓋的區(qū)域,藍(lán)色箭頭表示每個(gè)空間位置的輸出值是從整個(gè)覆蓋區(qū)域通過分段STE計(jì)算出來的。紅色箭頭是一個(gè)conv層,核大小為3,步幅為2,只計(jì)算整個(gè)覆蓋區(qū)域中心位置的輸出值。

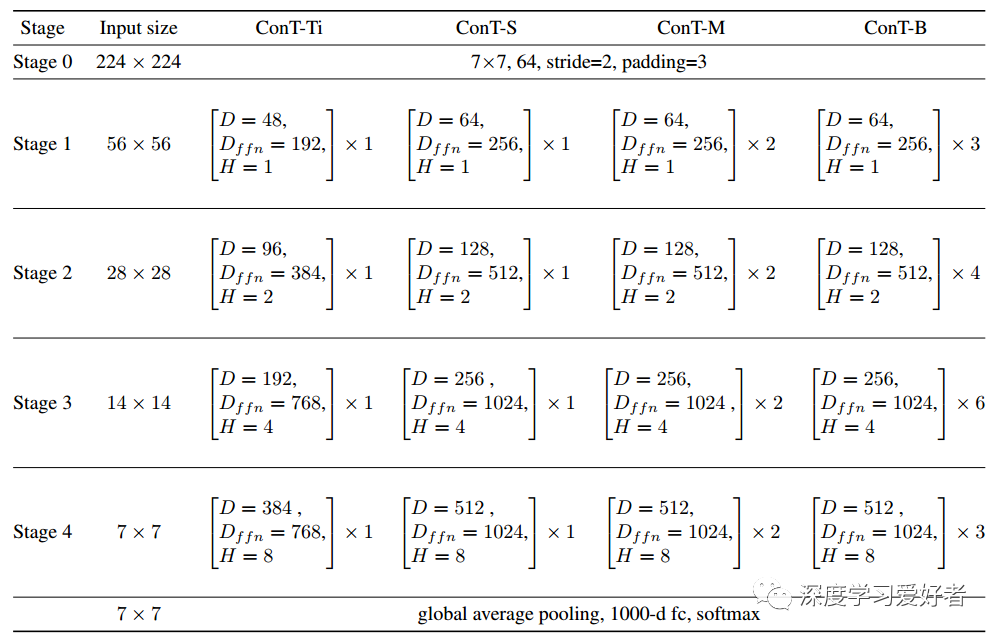

ConTNet系列詳細(xì)設(shè)置

在括號(hào)內(nèi),作者列出了每個(gè)ConTBlock的超參數(shù)。D為MHSA的嵌入維數(shù),Dffn為FFN的維數(shù),H為MHSA的頭數(shù)。托架外,顯示了舞臺(tái)上堆疊塊的數(shù)量。在每一階段,最后一個(gè)conv層進(jìn)行降采樣并增加維數(shù)。

實(shí)驗(yàn)結(jié)果

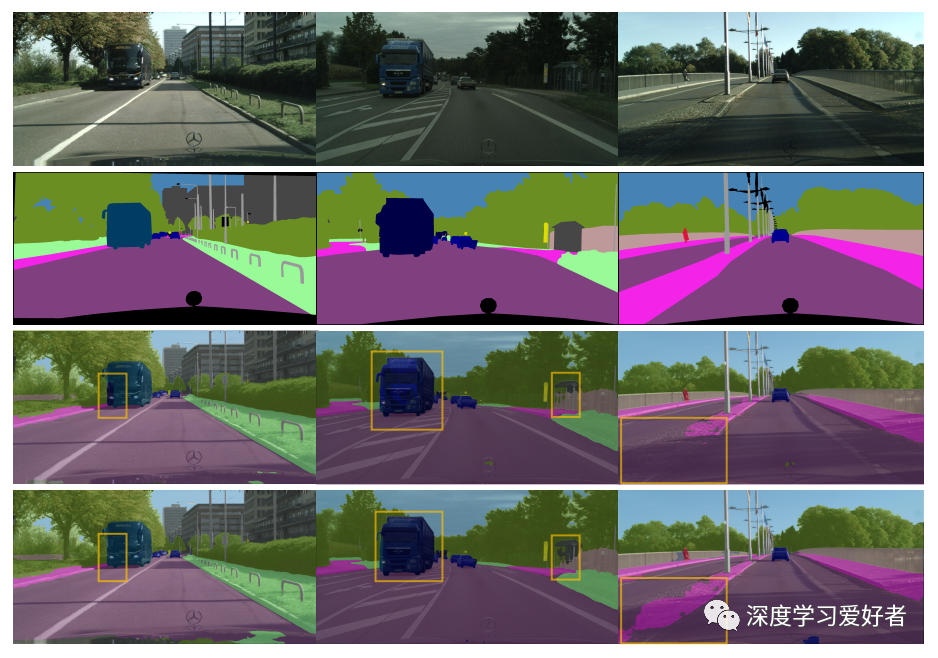

城市景觀驗(yàn)證集上PSPNet分割結(jié)果的可視化比較

每一列是來自驗(yàn)證集的一組樣本,上面兩行是原始圖像及其相應(yīng)的ground truth。下面兩行分別表示具有ResNet50骨干和contm骨干的PSPNet的結(jié)果。黃色的邊界框標(biāo)記了分割結(jié)果呈現(xiàn)顯著差異的區(qū)域。

結(jié)論

結(jié)論

城市景觀驗(yàn)證集上PSPNet分割結(jié)果的可視化比較。每一列是來自驗(yàn)證集的一組樣本,上面兩行是原始圖像及其相應(yīng)的ground truth。下面兩行分別表示具有ResNet50骨干和contm骨干的PSPNet的結(jié)果。黃色的邊界框標(biāo)記了分割結(jié)果呈現(xiàn)顯著差異的區(qū)域。

ConTNet通過標(biāo)準(zhǔn)變壓器編碼器(STE)和空間卷積交替疊加,將變壓器和卷積結(jié)合起來。作者引入一個(gè)權(quán)重共享的補(bǔ)丁方式STE來建模大型內(nèi)核。一系列實(shí)驗(yàn)表明,ConTNet的性能優(yōu)于ResNet,在較低的計(jì)算復(fù)雜度下達(dá)到了與流行視覺轉(zhuǎn)換器相當(dāng)?shù)木取W髡唑?yàn)證了利用ConTNet骨干實(shí)現(xiàn)下游任務(wù)的有效性主要來源于聚合更多的上下文信息。此外,作者還演示了ConTNet與ConNets(例如ResNet)一樣健壯。換句話說,ConTNet的性能不依賴于強(qiáng)大的數(shù)據(jù)增強(qiáng)和花哨的訓(xùn)練技巧,也不敏感的超參數(shù)。最后,在ConTNet中作者使用了普通的卷積和變壓器,如果用最近改進(jìn)的卷積和變壓器來替代,將會(huì)有更好的性能。希望作者的工作能為模型設(shè)計(jì)帶來一些新的思路。

論文鏈接:https://arxiv.org/pdf/2104.13497.pdf

雙一流高校研究生團(tuán)隊(duì)創(chuàng)建 ↓

專注于目標(biāo)檢測(cè)原創(chuàng)并分享相關(guān)知識(shí) ?

整理不易,點(diǎn)贊三連!