算力系列:AI服務器催化HBM需求爆發(fā)

?

?

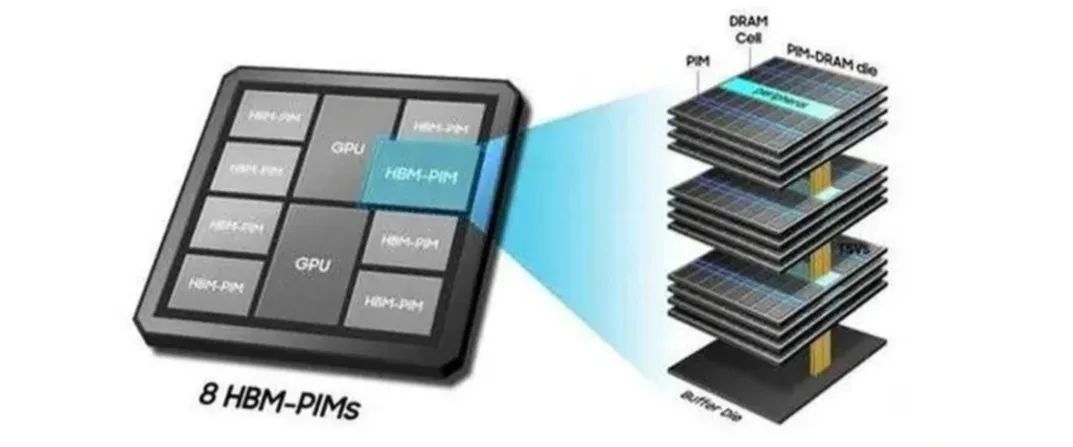

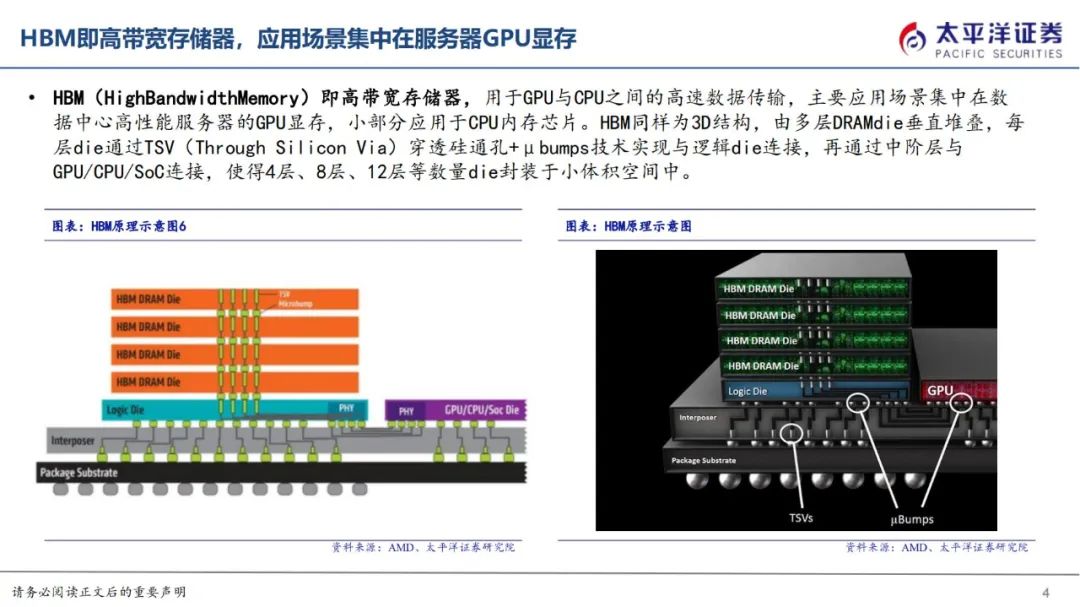

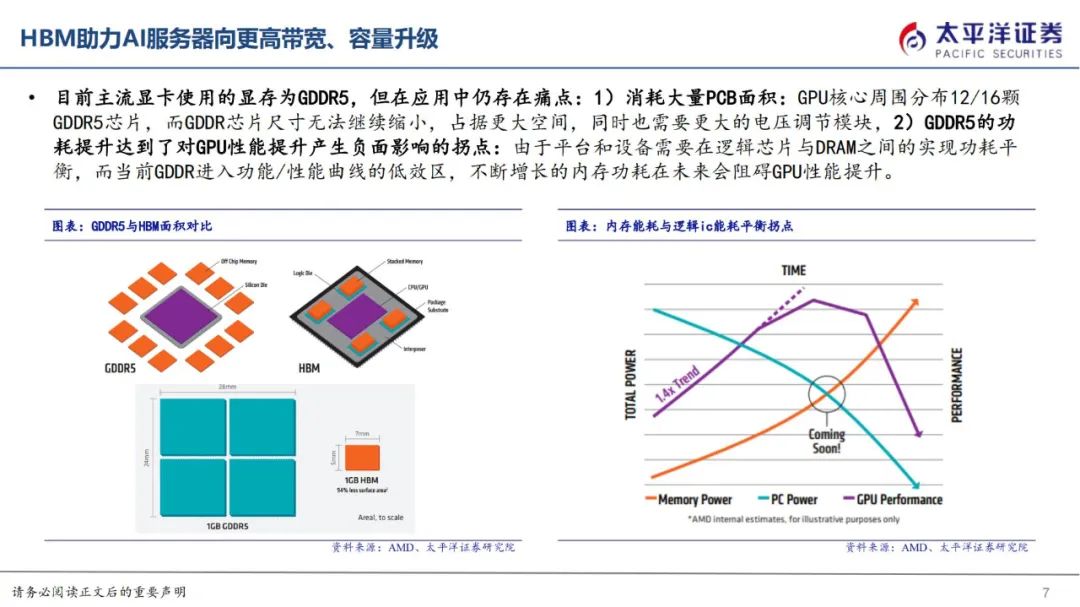

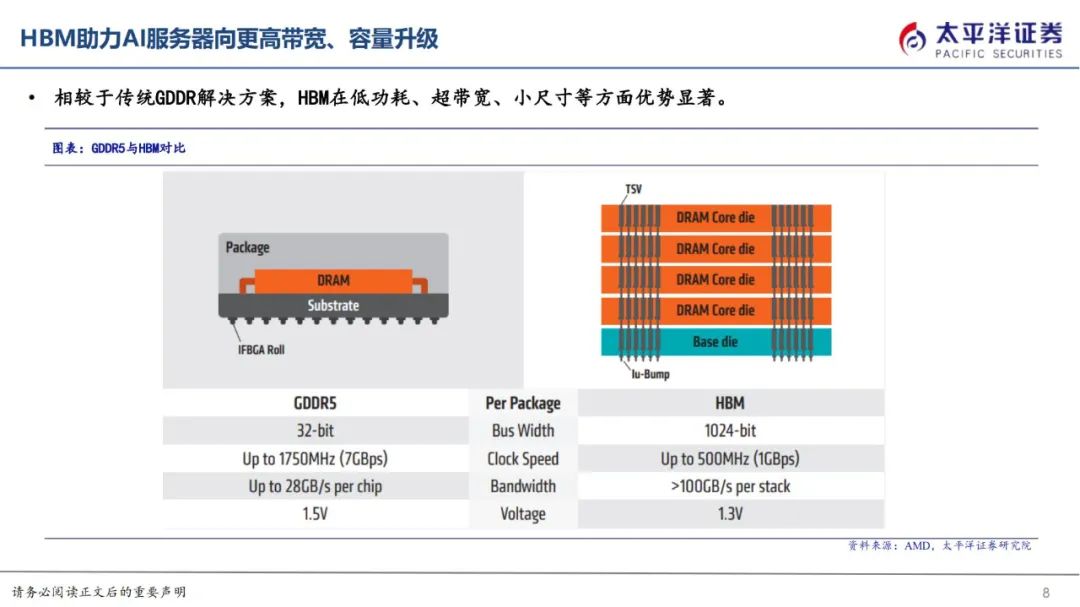

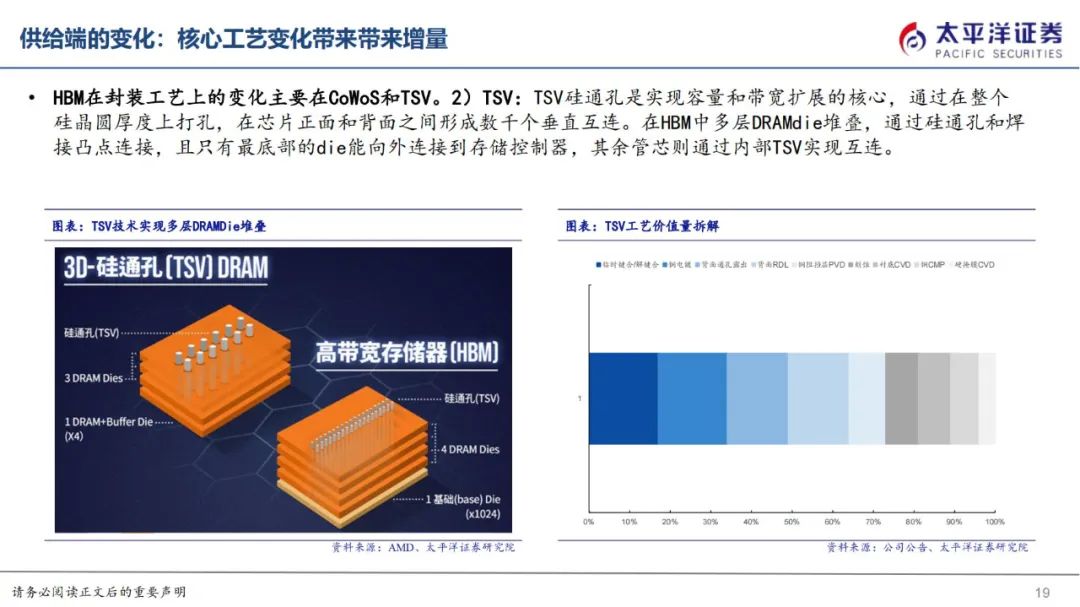

本文來自“AI服務器催化HBM需求爆發(fā),核心工藝變化帶來供給端增量(2024)”。HBM即高帶寬存儲,由多層DRAMdie垂直堆疊,每層die通過TSV穿透硅通孔+μbumps技術實現(xiàn)與邏輯die連接,使得8層、12層die封裝于小體積空間中,從而實現(xiàn)小尺寸于高帶寬、高傳輸速度的兼容,成為高性能AI服務器GPU顯存的主流解決方案。

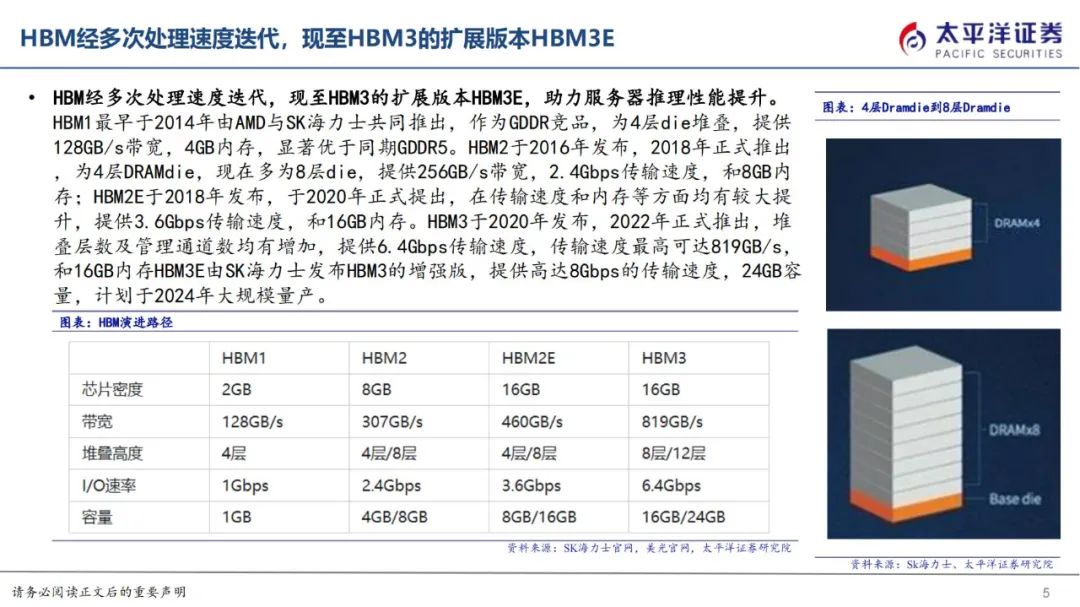

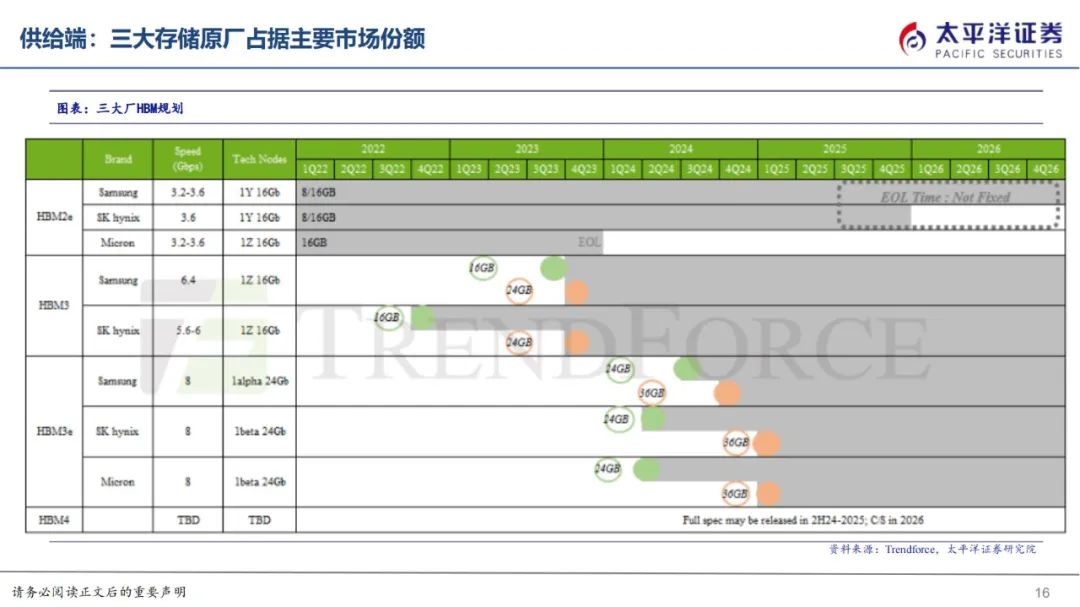

目前迭代至HBM3的擴展版本HBM3E,提供高達8Gbps的傳輸速度和16GB內(nèi)存,由SK海力士率先發(fā)布,將于2024年量。

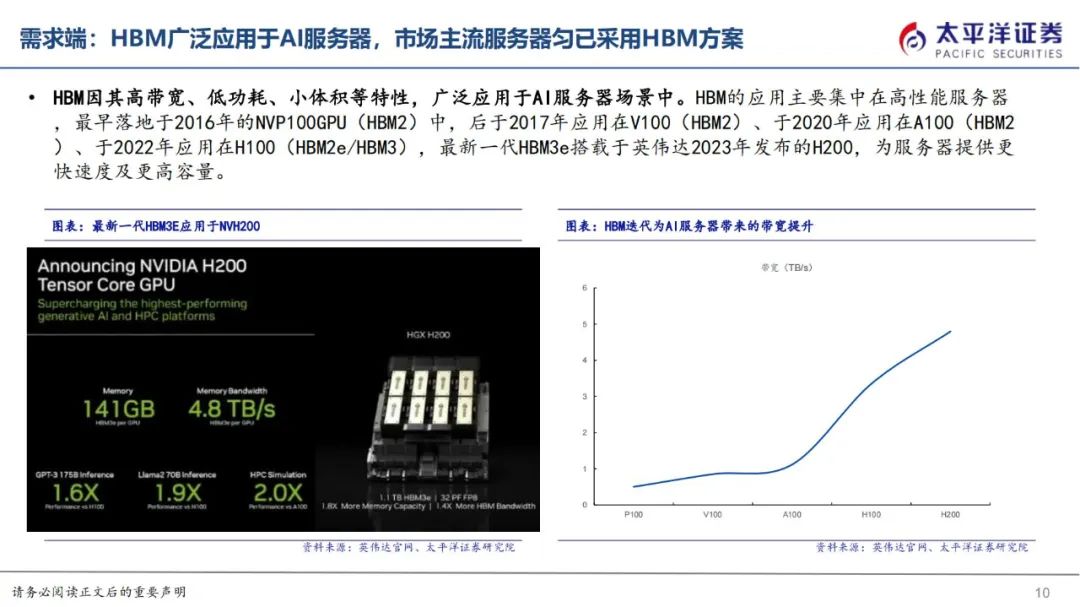

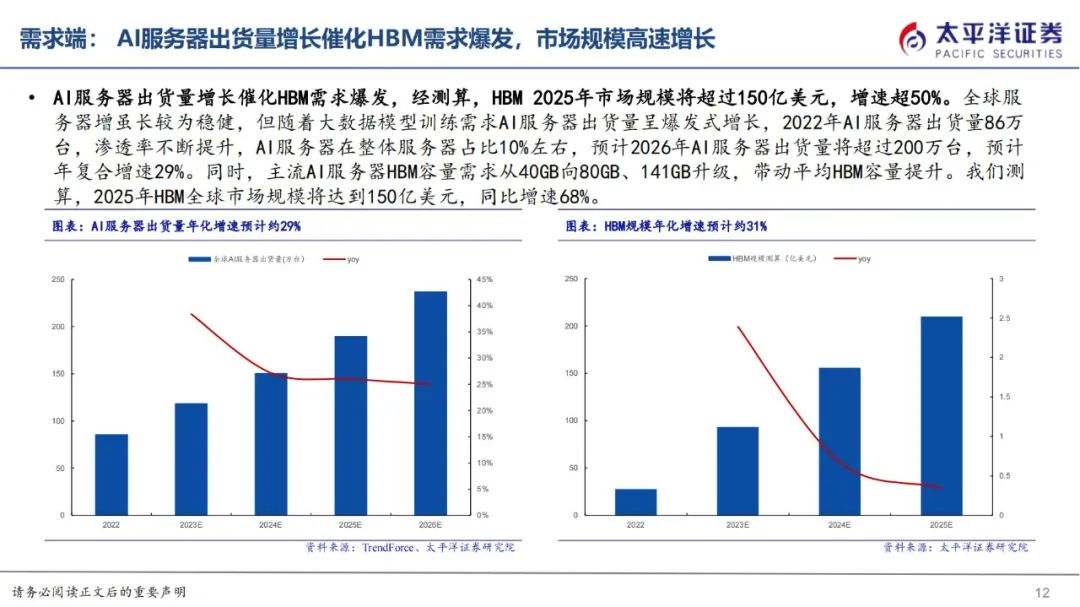

HBM主要應用場景為AI服務器,最新一代HBM3e搭載于英偉達2023年發(fā)布的H200。根據(jù)Trendforce數(shù)據(jù),2022年AI服務器出貨量86萬臺,預計2026年AI服務器出貨量將超過200萬臺,年復合增速29%。AI服務器出貨量增長催化HBM需求爆發(fā),且伴隨服務器平均HBM容量增加,經(jīng)測算,預期25年市場規(guī)模約150億美元,增速超過50%。

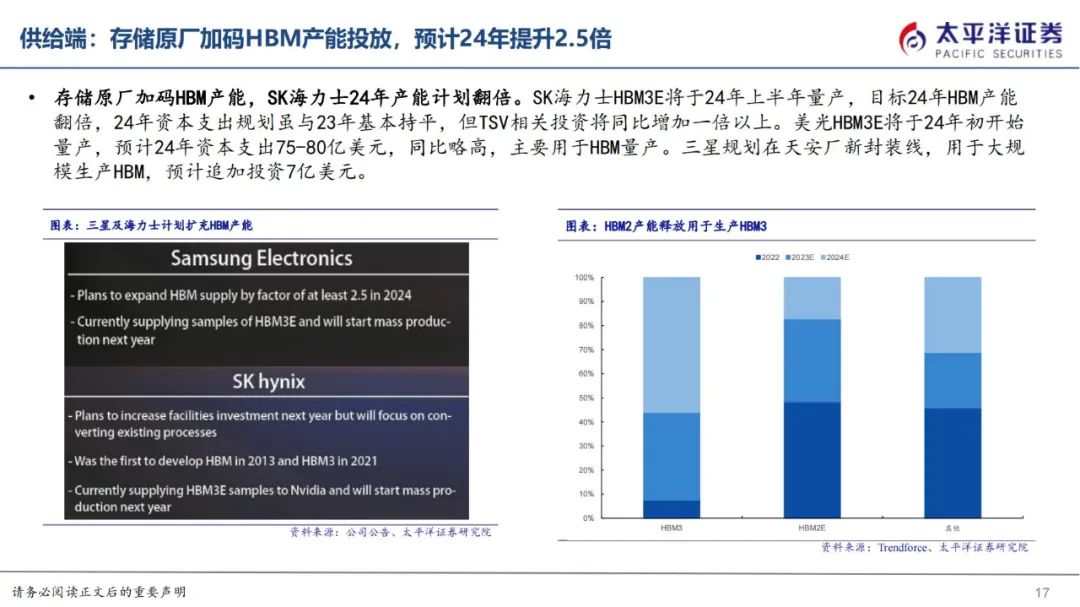

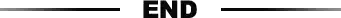

HBM供給廠商主要聚集在SK海力士、三星、美光三大存儲原廠,根據(jù)Trendforce數(shù)據(jù),2023年SK海力士市占率預計為53%,三星市占率38%、美光市占率9%。HBM在工藝上的變化主要在CoWoS和TSV。

下載鏈接:2024 數(shù)字科技前沿應用趨勢:智能科技,跨界相變 2023年AIGC移動市場洞察報告 虛擬數(shù)字人研究報告:溯源、應用、發(fā)展(2024) AI服務器催化HBM需求爆發(fā),核心工藝變化帶來供給端增量(2024) 2024計算機行業(yè)策略:落地為王 2023年度全球十大技術關鍵詞報告 多樣性算力技術愿景白皮書 《AI算力芯片產(chǎn)業(yè)鏈及全景圖》 1、AI算力產(chǎn)業(yè)鏈梳理(2023) 2、國產(chǎn)AI算力芯片全景圖 芯片未來可期:數(shù)據(jù)中心、國產(chǎn)化浪潮和先進封裝(精華)

HBM1最早于2014年由AMD與SK海力士共同推出,作為GDDR競品,為4層die堆疊,提供128GB/s帶寬,4GB內(nèi)存,顯著優(yōu)于同期GDDR5。

HBM2于2016年發(fā)布,2018年正式推出,為4層DRAMdie,現(xiàn)在多為8層die,提供256GB/s帶寬,2.4Gbps傳輸速度,和8GB內(nèi)存;HBM2E于2018年發(fā)布,于2020年正式提出,在傳輸速度和內(nèi)存等方面均有較大提升,提供3.6Gbps傳輸速度,和16GB內(nèi)存。HBM3于2020年發(fā)布,2022年正式推出,堆疊層數(shù)及管理通道數(shù)均有增加,提供6.4Gbps傳輸速度,傳輸速度最高可達819GB/s,和16GB內(nèi)存HBM3E由SK海力士發(fā)布HBM3的增強版,提供高達8Gbps的傳輸速度,24GB容量,計劃于2024年大規(guī)模量產(chǎn)。

HBM因其高帶寬、低功耗、小體積等特性,廣泛應用于AI服務器場景中。HBM的應用主要集中在高性能服務器,最早落地于2016年的NVP100GPU(HBM2)中,后于2017年應用在V100(HBM2)、于2020年應用在A100(HBM2)、于2022年應用在H100(HBM2e/HBM3),最新一代HBM3e搭載于英偉達2023年發(fā)布的H200,為服務器提供更快速度及更高容量。

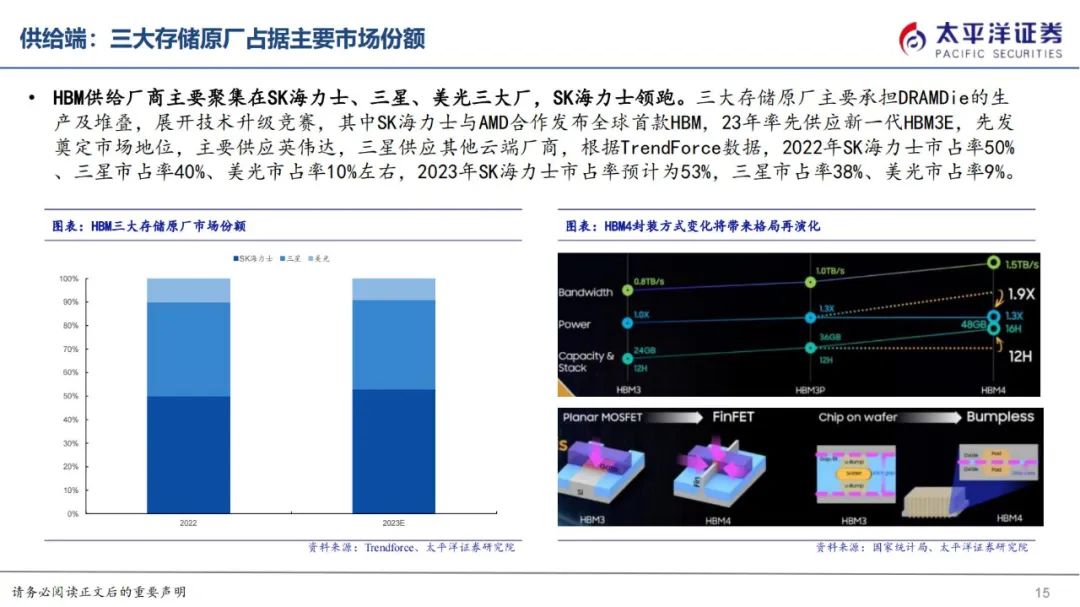

HBM供給廠商主要聚集在SK海力士、三星、美光三大廠,SK海力士領跑。三大存儲原廠主要承擔DRAMDie的生產(chǎn)及堆疊,展開技術升級競賽,其中SK海力士與AMD合作發(fā)布全球首款HBM,23年率先供應新一代HBM3E,先發(fā)奠定市場地位,主要供應英偉達,三星供應其他云端廠商,根據(jù)TrendForce數(shù)據(jù),2022年SK海力士市占率50%、三星市占率40%、美光市占率10%左右,2023年SK海力士市占率預計為53%,三星市占率38%、美光市占率9%。

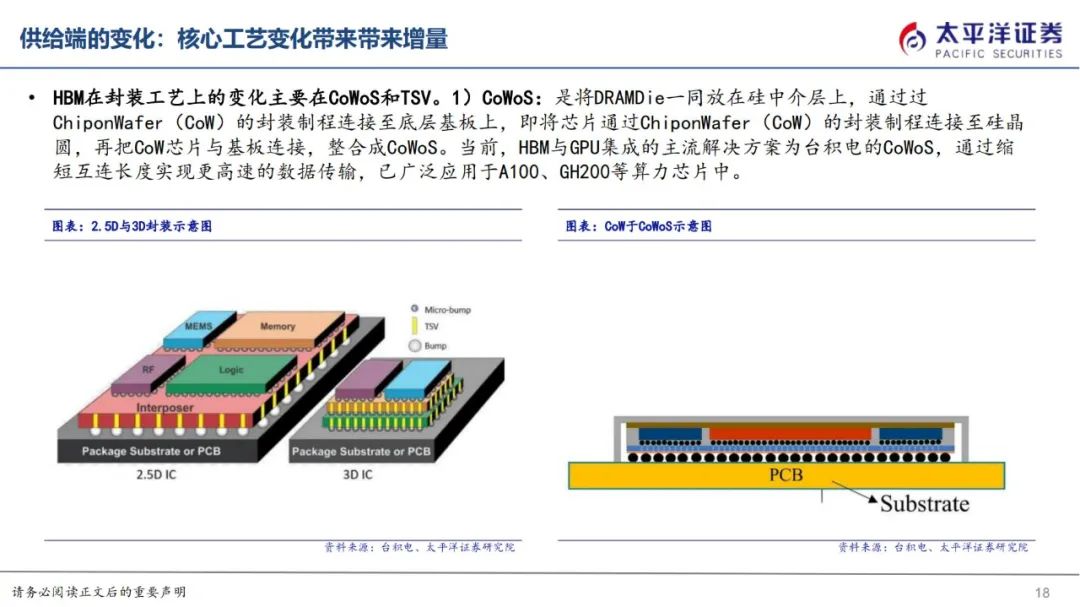

HBM在封裝工藝上的變化主要在CoWoS和TSV。

1)CoWoS:是將DRAMDie一同放在硅中介層上,通過過ChiponWafer(CoW)的封裝制程連接至底層基板上,即將芯片通過ChiponWafer(CoW)的封裝制程連接至硅晶圓,再把CoW芯片與基板連接,整合成CoWoS。當前,HBM與GPU集成的主流解決方案為臺積電的CoWoS,通過縮短互連長度實現(xiàn)更高速的數(shù)據(jù)傳輸,已廣泛應用于A100、GH200等算力芯片中。

2)TSV:TSV硅通孔是實現(xiàn)容量和帶寬擴展的核心,通過在整個硅晶圓厚度上打孔,在芯片正面和背面之間形成數(shù)千個垂直互連。在HBM中多層DRAMdie堆疊,通過硅通孔和焊接凸點連接,且只有最底部的die能向外連接到存儲控制器,其余管芯則通過內(nèi)部TSV實現(xiàn)互連。

相關閱讀:- GPU分析:全球競爭格局與未來發(fā)展

- 2023年GPU顯卡技術詞條報告

- 英偉達GPU龍頭穩(wěn)固,國內(nèi)逐步追趕(詳解)

- GPU/CPU領域散熱工藝的發(fā)展與路徑演繹

- 探析ARM第五代GPU架構

- 新型GPU云桌面發(fā)展白皮書

- 十大國產(chǎn)GPU產(chǎn)品及規(guī)格概述

- GPU平臺生態(tài):英偉達CUDA和AMD ROCm對比分析

- GPU競爭壁壘:微架構和平臺生態(tài)

- GPU微架構、性能指標、場景、生態(tài)鏈及競爭格局(2023)

- 大模型訓練,繞不開GPU和英偉達

- Nvidia/AMD競爭:GPU架構創(chuàng)新和新興領域前瞻探索

- 走進芯時代:AI算力GPU行業(yè)深度報告

- 獨立GPU市場,AMD份額大跌?

- CPU渲染和GPU渲染優(yōu)劣分析

- NVIDIA Hopper GPU:芯片三圍、架構、成本和性能分析

- 國內(nèi)GPU廠商及細分行業(yè)前景(2023)

- ChatGPT對GPU算力的需求測算與分析

- AMD RDNA2 GPU架構詳解

- 算力競賽,開啟AI芯片、光模塊和光芯片需求

- AI算力租賃行業(yè)深度研究(2023)

- 大模型算力:AI服務器行業(yè)(2023)

- 計算設備算力報告(2023年)

- UCIe封裝與異構算力集成

- 算力技術未來發(fā)展路徑概述(2023)

- AI算力研究框架:時勢造英雄,謀定而后動(2023)

- 算力網(wǎng)絡:在網(wǎng)計算(NACA)技術

- 一文理解“高廣深”先進算力網(wǎng)絡

- 聯(lián)邦學習算力加速方案(2023)

- 中國AI服務器算力市場規(guī)模及空間測算(2023)

- 多樣性算力:新一代超異構計算架構

- 大模型AI算力劇增,誰來扛國產(chǎn)GPU大旗?

- 超級芯片GH200發(fā)布,AI算力是H100兩倍

- 中國綠色算力發(fā)展研究報告(2023年)

- 詳解:算力網(wǎng)絡基礎知識(2023)

- AIGC算力全景與趨勢報告(2023)

- AI科普報告(2023):算法、算力、數(shù)據(jù)和應用

- 國內(nèi)外AI芯片、算力綜合對比

- 華為算力編年史(2023)

- AI算力研究框架(2023)

- 大模型訓練,英偉達Turing、Ampere和Hopper算力分析

- AI大語言模型原理、演進及算力測算

- 大算力模型,HBM、Chiplet和CPO等技術打破技術瓶頸

- 走進芯時代:AI算力GPU行業(yè)深度報告

本號資料全部上傳至知識星球,更多內(nèi)容請登錄智能計算芯知識(知識星球)星球下載全部資料。

免責申明: 本號聚焦相關技術分享,內(nèi)容觀點不代表本號立場,可追溯內(nèi)容均注明來源,發(fā)布文章若存在版權等問題,請留言聯(lián)系刪除,謝謝。

溫馨提示:

請搜索“AI_Architect”或“掃碼”關注公眾號實時掌握深度技術分享,點擊“閱讀原文”獲取更多原創(chuàng)技術干貨。