2021年必讀的10 個(gè)計(jì)算機(jī)視覺(jué)論文總結(jié)

極市導(dǎo)讀

?本文是作者總結(jié)的今年計(jì)算機(jī)視覺(jué)領(lǐng)域最有趣的 10 篇研究論文,它是一個(gè)精選的 AI 和 CV 最新突破列表,本篇文章將帶有清晰的視頻解釋和代碼(如果有)。本文末尾列出了對(duì)每篇論文的完整參考。?>>加入極市CV技術(shù)交流群,走在計(jì)算機(jī)視覺(jué)的最前沿

2021 年排名前 10 的計(jì)算機(jī)視覺(jué)論文,包括視頻演示、文章、代碼和論文參考。

世界的經(jīng)濟(jì)活動(dòng)在病毒的沖擊下陷入了歷史罕見(jiàn)的停滯中,但研究并沒(méi)有放慢其狂熱的步伐,尤其是在人工智能領(lǐng)域。今年的論文中除了一般的研究結(jié)果外還強(qiáng)調(diào)了許多重要方面,例如道德方面、重要偏見(jiàn)、治理、透明度等等。人工智能和我們對(duì)人腦及其與人工智能的聯(lián)系的理解不斷發(fā)展,顯示出在不久的將來(lái)改善我們生活質(zhì)量的有前景的應(yīng)用。不過(guò),我們應(yīng)該謹(jǐn)慎選擇應(yīng)用哪種技術(shù)。

“科學(xué)不能告訴我們應(yīng)該做什么,只能告訴我們可以做什么。”—— Jean-Paul Sartre, Being and Nothingness

以下是作者總結(jié)的今年計(jì)算機(jī)視覺(jué)領(lǐng)域最有趣的 10 篇研究論文,簡(jiǎn)而言之,它基本上是一個(gè)精選的 AI 和 CV 最新突破列表,本篇文章將帶有清晰的視頻解釋和代碼(如果有)。本文末尾列出了對(duì)每篇論文的完整參考。

完整視頻鏈接:

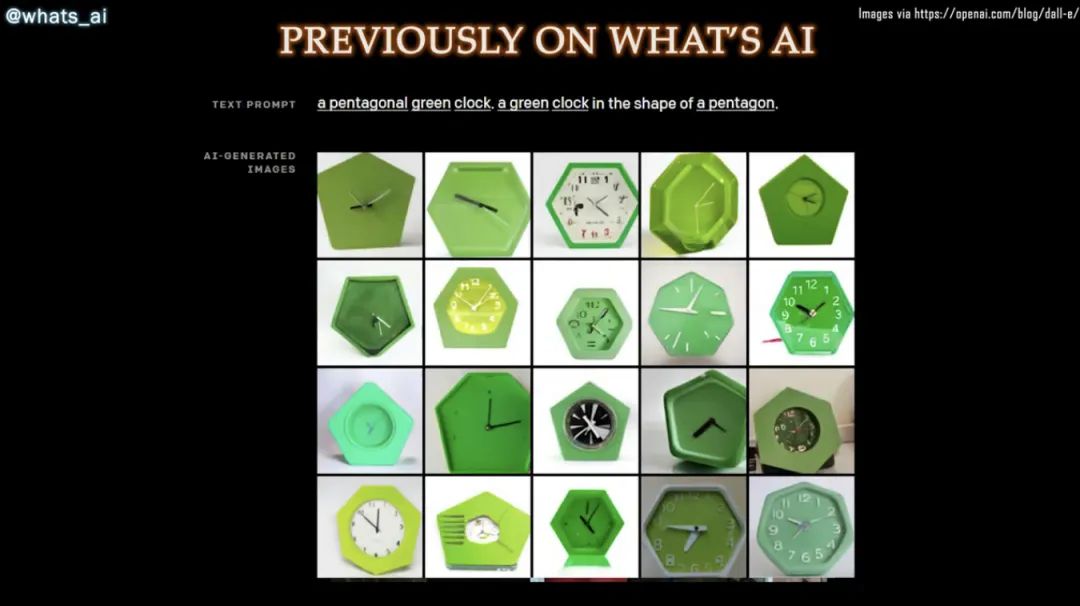

DALL·E: Zero-Shot Text-to-Image Generation from OpenAI [1]

OpenAI 成功訓(xùn)練了一個(gè)能夠從文本標(biāo)題生成圖像的網(wǎng)絡(luò)。它與 GPT-3 和 Image GPT 非常相似,并產(chǎn)生了驚人的結(jié)果。

代碼:https://github.com/openai/DALL-E

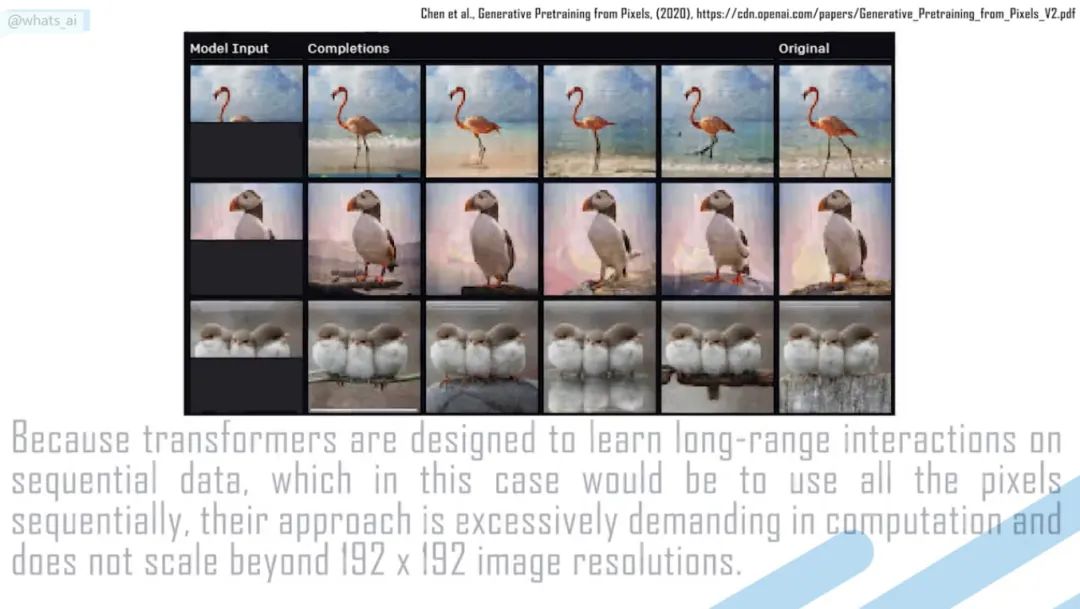

Taming Transformers for High-Resolution Image Synthesis [2]

將 GAN 和卷積方法的效率與Transformers 的表達(dá)能力相結(jié)合,為語(yǔ)義引導(dǎo)的高質(zhì)量圖像合成提供了一種強(qiáng)大且省時(shí)的方法。

代碼:https://github.com/CompVis/taming-transformers

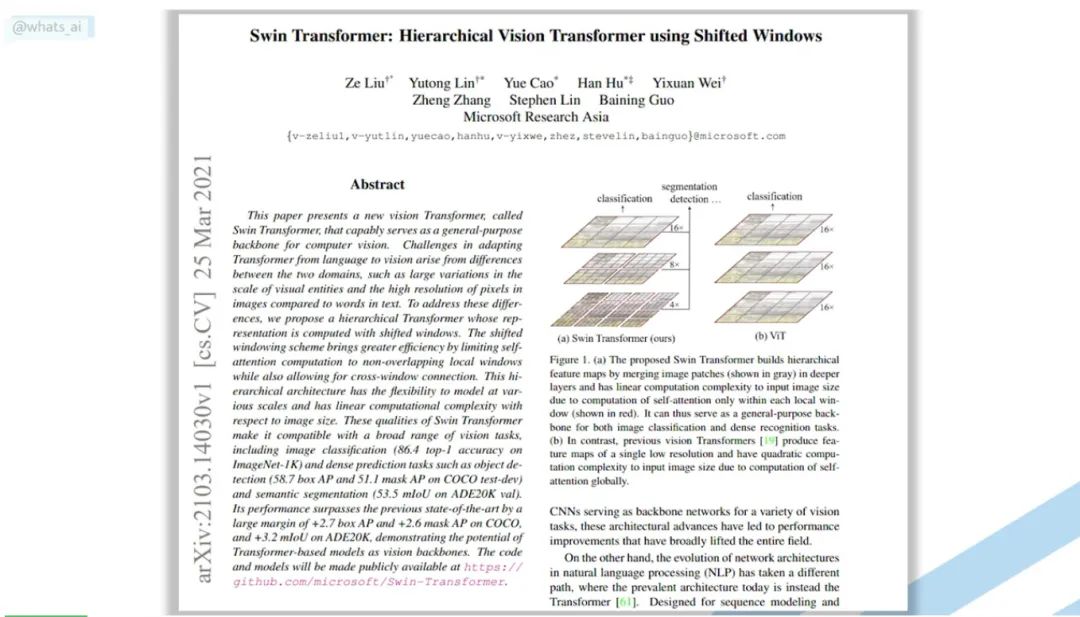

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows [3]

Transformers 會(huì)取代計(jì)算機(jī)視覺(jué)中的 CNNs 嗎?在不到 5 分鐘的時(shí)間內(nèi),通過(guò)一篇名為 Swin Transformer 的新論文了解如何將 Transformer 架構(gòu)應(yīng)用于計(jì)算機(jī)視覺(jué)。

代碼:https://github.com/microsoft/Swin-Transformer

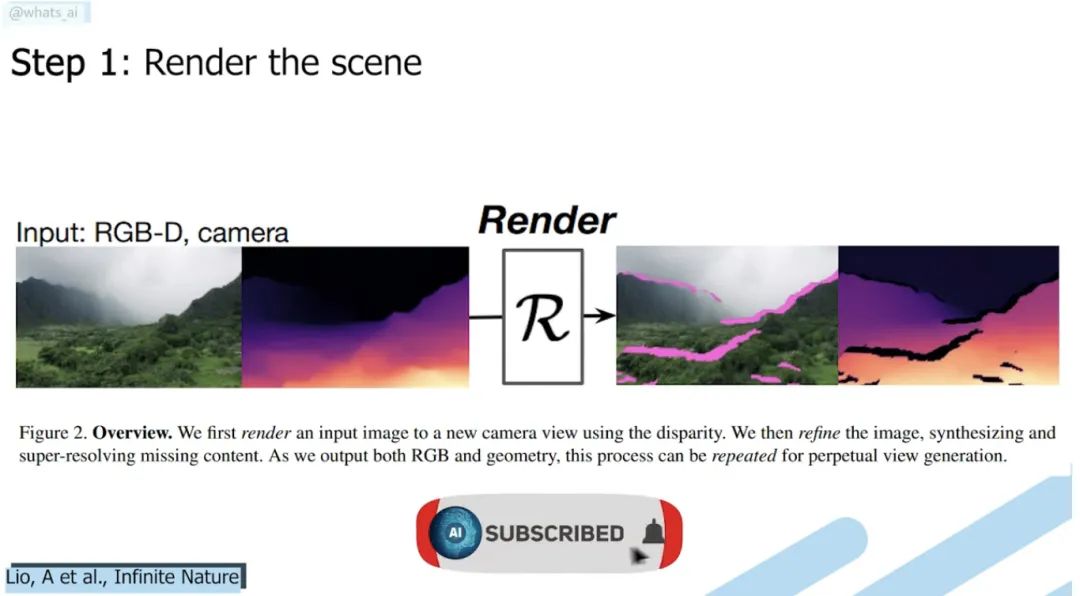

Infinite Nature: Perpetual View Generation of Natural Scenes from a Single Image [4]

視圖合成的下一步:目標(biāo)是拍攝一張圖像,然后就可以進(jìn)到圖像中去探索風(fēng)景!

DEMO:

https://colab.research.google.com/github/google-research/google-research/blob/master/infinite_nature/infinite_nature_demo.ipynb#scrollTo=sCuRX1liUEVM

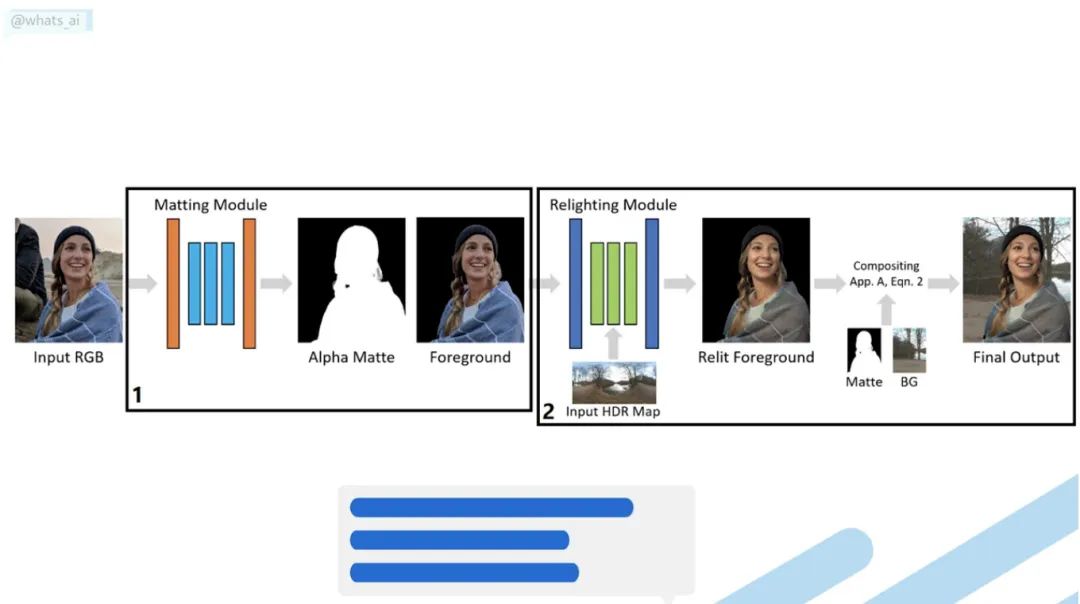

Total Relighting: Learning to Relight Portraits for Background Replacement [5]

根據(jù)添加的新背景的亮度重新為肖像補(bǔ)光。你有沒(méi)有想過(guò)改變圖片的背景,但讓它看起來(lái)很逼真?如果已經(jīng)嘗試過(guò)就會(huì)知道這并不簡(jiǎn)單。你在家里拍一張自己的照片然后改變成海灘的背景, 任何人都會(huì)在一秒鐘內(nèi)說(shuō)“那是經(jīng)過(guò)Photoshop處理的”。對(duì)于電影和專(zhuān)業(yè)視頻,需要完美的燈光和藝術(shù)家來(lái)再現(xiàn)高質(zhì)量的圖像,這非常昂貴。你無(wú)法用自己的照片做到這一點(diǎn)。但是這篇論文做到了

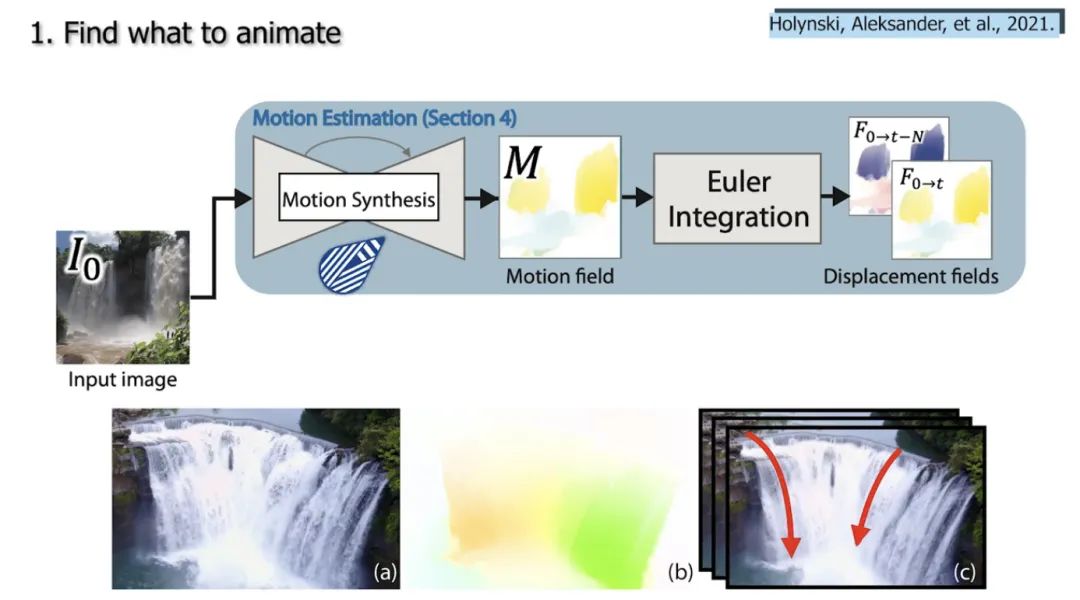

Animating Pictures with Eulerian Motion Fields [6]

該模型只通過(guò)拍攝一張照片,就能夠了解哪些粒子應(yīng)該在移動(dòng),并可以在限循環(huán)中為它們?cè)O(shè)置逼真的動(dòng)畫(huà),同時(shí)完全保留圖片的其余部分,這樣我們可以將圖片轉(zhuǎn)換成動(dòng)畫(huà)……

代碼:https://eulerian.cs.washington.edu/

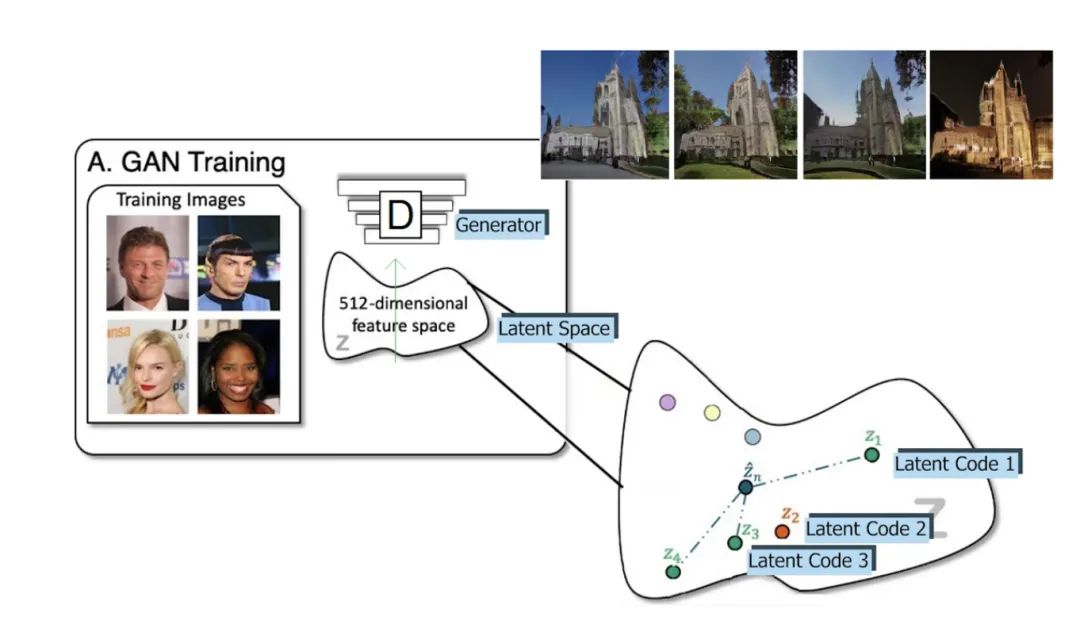

CVPR 2021 Best Paper Award: GIRAFFE — Controllable Image Generation [7]

使用修改后的 GAN 架構(gòu),他們可以在不影響背景或其他對(duì)象的情況下移動(dòng)圖像中的對(duì)象!

代碼:https://github.com/autonomousvision/giraffe

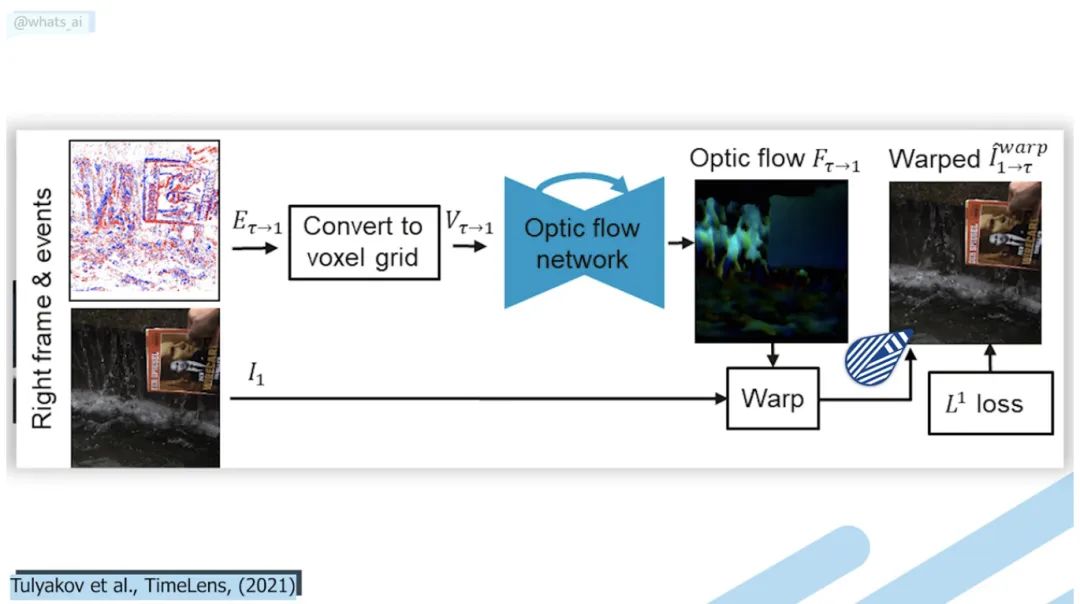

TimeLens: Event-based Video Frame Interpolation [8]

TimeLens 可以理解視頻幀之間粒子的運(yùn)動(dòng),用我們?nèi)庋劭床坏降乃俣戎亟ㄕ嬲l(fā)生的事情。它達(dá)到了智能手機(jī)和其他機(jī)型無(wú)法達(dá)到的效果!

代碼:https://github.com/uzh-rpg/rpg_timelens

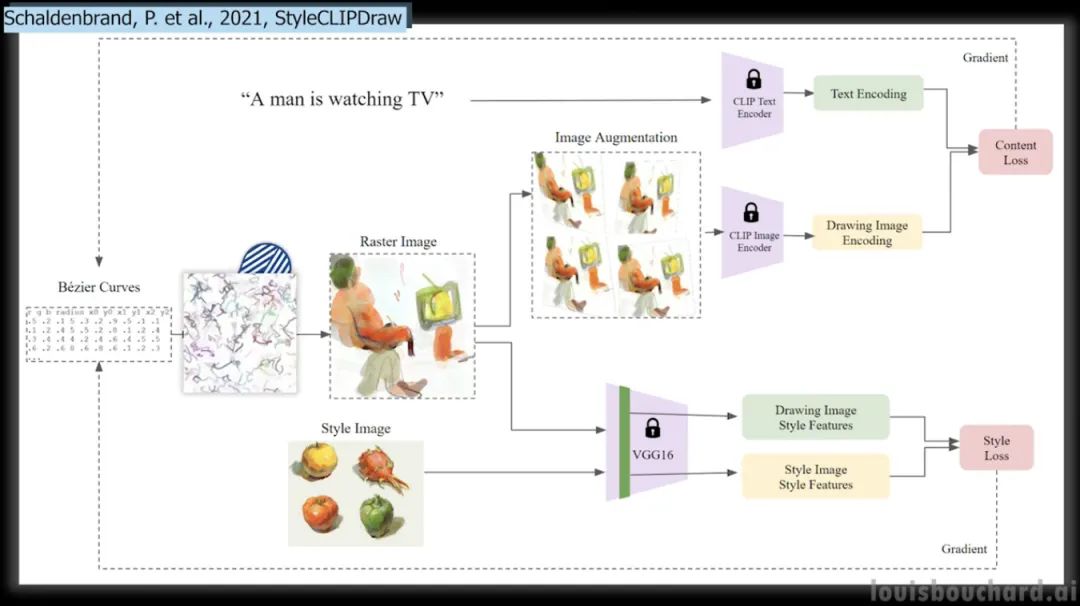

CLIPDraw: Coupling Content and Style in Text-to-Drawing Synthesis [9]

你有沒(méi)有想過(guò)把照片的風(fēng)格,比如左邊這個(gè)很酷的繪畫(huà)風(fēng)格,應(yīng)用到你選擇的新照片上?這個(gè)模型能夠做到,甚至可以僅從文本中實(shí)現(xiàn)這一點(diǎn),并且還提供了可以立即嘗試使用這種新方法及其適用于所有人的 Google Colab 。簡(jiǎn)單的拍一張你要復(fù)制的樣式的圖片,輸入你要生成的文字,這個(gè)算法就會(huì)生成一張新的圖片!結(jié)果非常令人印象深刻,特別它們可以由一行文本制成的!

DEMO:https://colab.research.google.com/github/kvfrans/clipdraw/blob/main/clipdraw.ipynb

https://colab.research.google.com/github/pschaldenbrand/StyleCLIPDraw/blob/master/Style_ClipDraw.ipynb

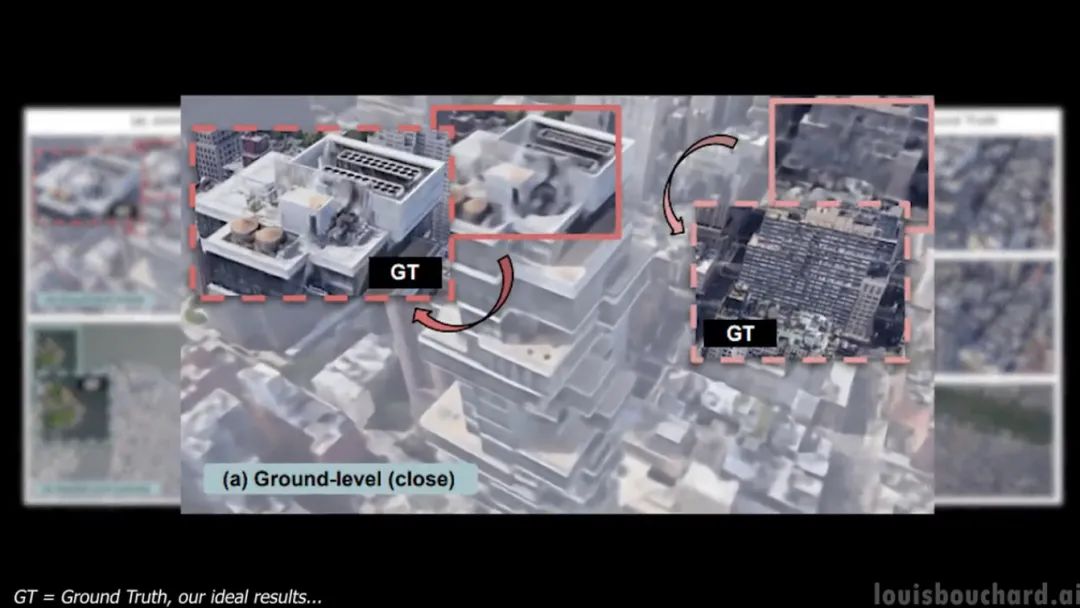

CityNeRF: Building NeRF at City Scale [10]

該模型稱為 CityNeRF,是從 NeRF 發(fā)展而來(lái)的, NeRF 是最早使用輻射場(chǎng)和機(jī)器學(xué)習(xí)從圖像構(gòu)建 3D 模型的模型之一。但 NeRF 效率不高而且只適用于單一規(guī)模。在這里,CityNeRF 同時(shí)應(yīng)用于衛(wèi)星和地面圖像,生成各種 3D 模型。簡(jiǎn)而言之他們將 NeRF 帶入了城市規(guī)模。

代碼:https://city-super.github.io/citynerf/

引用:

[1] A. Ramesh et al., Zero-shot text-to-image generation, 2021. arXiv:2102.12092

[2] Taming Transformers for High-Resolution Image Synthesis, Esser et al., 2020.

[3] Liu, Z. et al., 2021, “Swin Transformer: Hierarchical Vision Transformer using Shifted Windows”, arXiv preprint https://arxiv.org/abs/2103.14030v1[bonus] Yuille, A.L., and Liu, C., 2021. Deep nets: What have they ever done ?for vision?. International Journal of Computer Vision, 129(3), ?pp.781–802, https://arxiv.org/abs/1805.04025.

[4] Liu, A., Tucker, R., Jampani, V., Makadia, A., Snavely, N. and ?Kanazawa, A., 2020. Infinite Nature: Perpetual View Generation of ?Natural Scenes from a Single Image, https://arxiv.org/pdf/2012.09855.pdf

[5] Pandey et al., 2021, Total Relighting: Learning to Relight Portraits ?for Background Replacement, doi: 10.1145/3450626.3459872, https://augmentedperception.github.io/total_relighting/total_relighting_paper.pdf.

[6] Holynski, Aleksander, et al. “Animating Pictures with Eulerian Motion ?Fields.” Proceedings of the IEEE/CVF Conference on Computer Vision and ?Pattern Recognition. 2021.

[7] Michael Niemeyer and Andreas Geiger, (2021), “GIRAFFE: Representing ?Scenes as Compositional Generative Neural Feature Fields”, Published in ?CVPR 2021.

[8] Stepan Tulyakov, Daniel Gehrig, Stamatios Georgoulis, Julius Erbach, ?Mathias Gehrig, Yuanyou Li, Davide Scaramuzza, TimeLens: Event-based ?Video Frame Interpolation, IEEE Conference on Computer Vision and ?Pattern Recognition (CVPR), Nashville, 2021, http://rpg.ifi.uzh.ch/docs/CVPR21_Gehrig.pdf

[9] a) CLIPDraw: exploring text-to-drawing synthesis through language-image encodersb) StyleCLIPDraw: Schaldenbrand, P., Liu, Z. and Oh, J., 2021. ?StyleCLIPDraw: Coupling Content and Style in Text-to-Drawing Synthesis.

[10] Xiangli, Y., Xu, L., Pan, X., Zhao, N., Rao, A., Theobalt, C., Dai, B. ?and Lin, D., 2021. CityNeRF: Building NeRF at City Scale.

本文作者:Louis Bouchard

如果覺(jué)得有用,就請(qǐng)分享到朋友圈吧!

公眾號(hào)后臺(tái)回復(fù)“transformer”獲取最新Transformer綜述論文下載~

#?CV技術(shù)社群邀請(qǐng)函?#

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測(cè)-深圳)

即可申請(qǐng)加入極市目標(biāo)檢測(cè)/圖像分割/工業(yè)檢測(cè)/人臉/醫(yī)學(xué)影像/3D/SLAM/自動(dòng)駕駛/超分辨率/姿態(tài)估計(jì)/ReID/GAN/圖像增強(qiáng)/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實(shí)項(xiàng)目需求對(duì)接、求職內(nèi)推、算法競(jìng)賽、干貨資訊匯總、與?10000+來(lái)自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺(jué)開(kāi)發(fā)者互動(dòng)交流~