延時消息常見實現(xiàn)方案

延時消息(定時消息)指的在分布式異步消息場景下,生產(chǎn)端發(fā)送一條消息,希望在指定延時或者指定時間點被消費端消費到,而不是立刻被消費。

延時消息適用的業(yè)務場景非常的廣泛,在分布式系統(tǒng)環(huán)境下,延時消息的功能一般會在下沉到中間件層,通常是 MQ 中內(nèi)置這個功能或者內(nèi)聚成一個公共基礎服務。

本文旨在探討常見延時消息的實現(xiàn)方案以及方案設計的優(yōu)缺點。

1. 基于外部存儲實現(xiàn)的方案

這里討論的外部存儲指的是在 MQ 本身自帶的存儲以外又引入的其他的存儲系統(tǒng)。

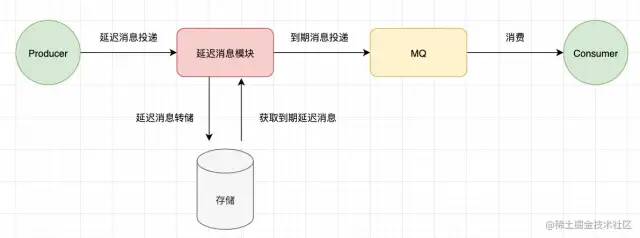

基于外部存儲的方案本質(zhì)上都是一個套路,將 MQ 和 延時模塊 區(qū)分開來,延時消息模塊是一個獨立的服務/進程。延時消息先保留到其他存儲介質(zhì)中,然后在消息到期時再投遞到 MQ。當然還有一些細節(jié)性的設計,比如消息進入的延時消息模塊時已經(jīng)到期則直接投遞這類的邏輯,這里不展開討論。

下述方案不同的是,采用了不同的存儲系統(tǒng)。

基于 數(shù)據(jù)庫(如MySQL)

基于關系型數(shù)據(jù)庫(如MySQL)延時消息表的方式來實現(xiàn)。

CREATE TABLE `delay_msg` (`id` bigint unsigned NOT NULL AUTO_INCREMENT,`delivery_time` DATETIME NOT NULL COMMENT '投遞時間',`payloads` blob COMMENT '消息內(nèi)容',PRIMARY KEY (`id`),KEY `time_index` (`delivery_time`))

通過定時線程定時掃描到期的消息,然后進行投遞。定時線程的掃描間隔理論上就是你延時消息的最小時間精度。

優(yōu)點:

實現(xiàn)簡單;

缺點:

B+Tree索引不適合消息場景的大量寫入;

RocksDB 的方案其實就是在上述方案上選擇了比較合適的存儲介質(zhì)。

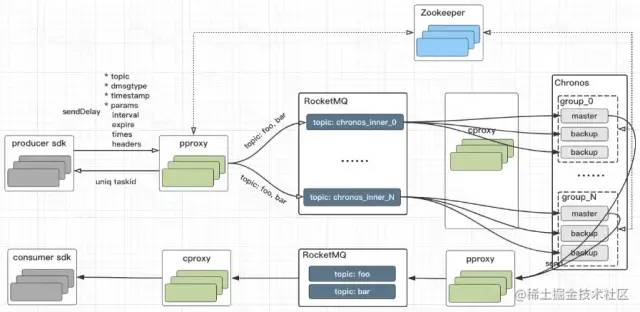

RocksDB 在筆者之前的文章中有聊過,LSM 樹更適合大量寫入的場景。滴滴開源的DDMQ中的延時消息模塊 Chronos 就是采用了這個方案。

DDMQ 這個項目簡單來說就是在 RocketMQ 外面加了一層統(tǒng)一的代理層,在這個代理層就可以做一些功能維度的擴展。延時消息的邏輯就是代理層實現(xiàn)了對延時消息的轉(zhuǎn)發(fā),如果是延時消息,會先投遞到 RocketMQ 中 Chronos 專用的 topic 中。延時消息模塊 Chronos 消費得到延時消息轉(zhuǎn)儲到 RocksDB,后面就是類似的邏輯了,定時掃描到期的消息,然后往 RocketMQ 中投遞。

這個方案老實說是一個比較重的方案。因為基于 RocksDB 來實現(xiàn)的話,從數(shù)據(jù)可用性的角度考慮,你還需要自己去處理多副本的數(shù)據(jù)同步等邏輯。

優(yōu)點:

RocksDB LSM 樹很適合消息場景的大量寫入;

缺點:

實現(xiàn)方案較重,如果你采用這個方案,需要自己實現(xiàn) RocksDB 的數(shù)據(jù)容災邏輯;

再來聊聊 Redis 的方案。下面放一個比較完善的方案。

本方案來源于:基于Redis實現(xiàn)延時隊列服務

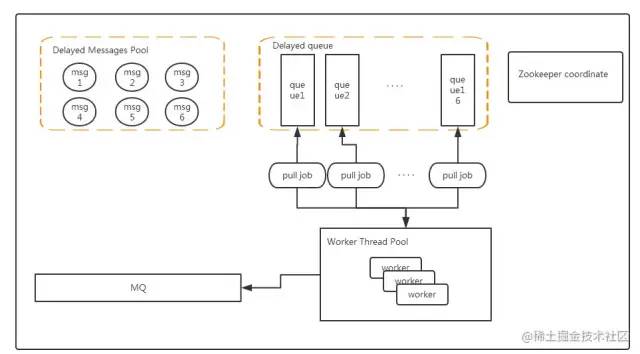

Messages Pool 所有的延時消息存放,結構為KV結構,key為消息ID,value為一個具體的message(這里選擇Redis Hash結構主要是因為hash結構能存儲較大的數(shù)據(jù)量,數(shù)據(jù)較多時候會進行漸進式rehash擴容,并且對于HSET和HGET命令來說時間復雜度都是O(1))

Delayed Queue是16個有序隊列(隊列支持水平擴展),結構為ZSET,value 為 messages pool中消息ID,score為過期時間**(分為多個隊列是為了提高掃描的速度)**

Worker 代表處理線程,通過定時任務掃描 Delayed Queue 中到期的消息

這個方案選用 Redis 存儲在我看來有幾點考慮。

Redis ZSET 很適合實現(xiàn)延時隊列

性能問題,雖然 ZSET 插入是一個 O(logn) 的操作,但是Redis 基于內(nèi)存操作,并且內(nèi)部做了很多性能方面的優(yōu)化。

但是這個方案其實也有需要斟酌的地方,上述方案通過創(chuàng)建多個 Delayed Queue 來滿足對于并發(fā)性能的要求,但這也帶來了多個 Delayed Queue 如何在多個節(jié)點情況下均勻分配,并且很可能出現(xiàn)到期消息并發(fā)重復處理的情況,是否要引入分布式鎖之類的并發(fā)控制設計?

在量不大的場景下,上述方案的架構其實可以蛻化成主從架構,只允許主節(jié)點來處理任務,從節(jié)點只做容災備份。實現(xiàn)難度更低更可控。

上述幾個方案中,都通過線程定時掃描的方案來獲取到期的消息。

定時線程的方案在消息量較少的時候,會浪費資源,在消息量非常多的時候,又會出現(xiàn)因為掃描間隔設置不合理導致延時時間不準確的問題。可以借助 JDK Timer 類中的思想,通過 wait-notify 來節(jié)省 CPU 資源。

獲取中最近的延時消息,然后wait(執(zhí)行時間-當前時間),這樣就不需要浪費資源到達時間時會自動響應,如果有新的消息進入,并且比我們等待的消息還要小,那么直接notify喚醒,重新獲取這個更小的消息,然后又wait,如此循環(huán)。

2. 開源 MQ 中的實現(xiàn)方案

再來講講目前自帶延時消息功能的開源MQ,它們是如何實現(xiàn)的

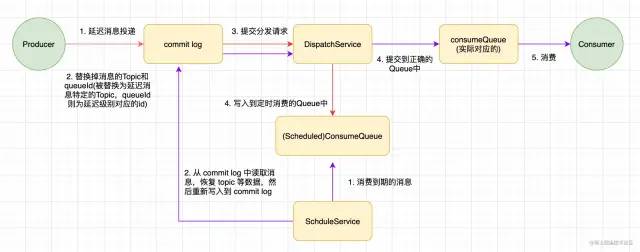

Level 數(shù)固定,每個 Level 有自己的定時器,開銷不大 將 Level 相同的消息放入到同一個 Queue 中,保證了同一 Level 消息的順序性;不同 Level 放到不同的 Queue 中,保證了投遞的時間準確性; 通過只支持固定的Level,將不同延時消息的排序變成了固定Level Topic 的追加寫操作

Level 配置的修改代價太大,固定 Level 不靈活 CommitLog 會因為延時消息的存在變得很大

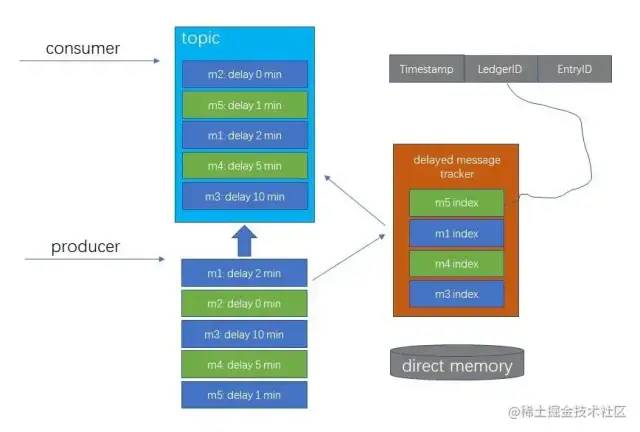

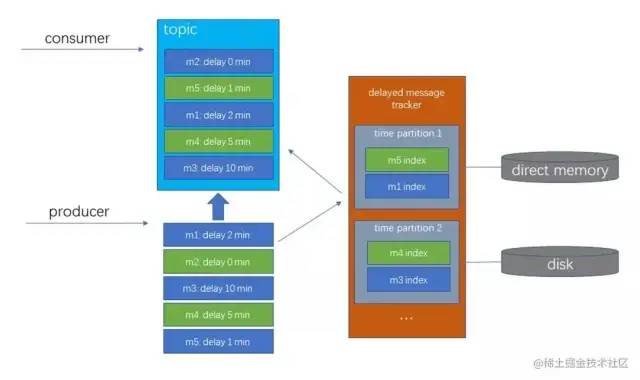

內(nèi)存開銷:?維護延時消息索引的隊列是放在堆外內(nèi)存中的,并且這個隊列是以訂閱組(Kafka中的消費組)為維度的,比如你這個 Topic 有 N 個訂閱組,那么如果你這個 Topic 使用了延時消息,就會創(chuàng)建 N 個 隊列;并且隨著延時消息的增多,時間跨度的增加,每個隊列的內(nèi)存占用也會上升。(是的,在這個方案下,支持任意的延時消息反而有可能讓這個缺陷更嚴重) 故障轉(zhuǎn)移之后延時消息索引隊列的重建時間開銷:?對于跨度時間長的大規(guī)模延時消息,重建時間可能會到小時級別。(摘自 Pulsar 官方公眾號文章) 存儲開銷:延時消息的時間跨度會影響到 Pulsar 中已經(jīng)消費的消息數(shù)據(jù)的空間回收。打個比方,你的 Topic 如果業(yè)務上要求支持一個月跨度的延時消息,然后你發(fā)了一個延時一個月的消息,那么你這個 Topic 中底層的存儲就會保留整整一個月的消息數(shù)據(jù),即使這一個月中99%的正常消息都已經(jīng)消費了。

如果對時間輪不熟悉的可以閱讀筆者的這篇文章?從 Kafka 看時間輪算法設計

時間輪算法適合延時/定時消息的場景,省去延時消息的排序,插入刪除操作都是 O(1) 的時間復雜度; 通過多級時間輪設計,支持了超大時間跨度的延時消息; 通過延時加載,內(nèi)存中只會有最近要消費的消息,更久的延時消息會被存儲在磁盤中,對內(nèi)存友好; 延時消息單獨存儲(schedule log),不會影響到正常消息的空間回收;

作者:Richard_Yi

來源:juejin.cn/post/7052894117105238053