AI技術(shù)課堂 | 深度解讀詞嵌入技術(shù)的基礎(chǔ)原理

引言

詞嵌入是生成式人工智能中的一項(xiàng)關(guān)鍵技術(shù),是一種將詞語或短語從詞匯表(可能包含數(shù)千或數(shù)百萬個詞語)映射到向量的實(shí)數(shù)空間的技術(shù)。這些嵌入捕獲了詞語之間的相似性,因此相似的詞語會被映射到相近的點(diǎn)。詞嵌入可以分為兩類:基于計(jì)數(shù)的方法和預(yù)測方法。基于計(jì)數(shù)的方法計(jì)算某詞語與其鄰近詞語在大型文本語料庫中共同出現(xiàn)的頻率及其他統(tǒng)計(jì)量,然后將這些統(tǒng)計(jì)量映射到一個小的、密集的向量。預(yù)測方法則試圖直接從某詞語的鄰近詞語預(yù)測該詞語,預(yù)測模型的參數(shù)即為詞嵌入。

詞嵌入在自然語言處理(NLP)中有許多具體的應(yīng)用,包括但不限于以下幾個方面:

1. 情感分析:詞嵌入可以幫助機(jī)器理解文本的情感,例如判斷用戶評論是正面的還是負(fù)面的。

2. 文本分類:詞嵌入可以用于新聞分類、垃圾郵件檢測等任務(wù),幫助機(jī)器理解文本的主題并進(jìn)行分類。

3. 命名實(shí)體識別:通過詞嵌入,機(jī)器可以識別出文本中的特定實(shí)體,如人名、地名、組織名等。

4. 機(jī)器翻譯:詞嵌入在機(jī)器翻譯中也起著關(guān)鍵作用,幫助機(jī)器理解源語言,并將其準(zhǔn)確地翻譯成目標(biāo)語言。

5. 語義搜索:詞嵌入可以用于搜索引擎,提高搜索結(jié)果的相關(guān)性,使搜索結(jié)果更符合用戶的查詢意圖。

6. 問答系統(tǒng):詞嵌入可以幫助問答系統(tǒng)理解用戶的問題,并提供準(zhǔn)確的答案。

7. 語音識別:詞嵌入可以幫助語音識別系統(tǒng)理解用戶的語音指令,并執(zhí)行相應(yīng)的操作。

8. 聊天機(jī)器人:詞嵌入可以幫助聊天機(jī)器人理解用戶的輸入,并生成自然、相關(guān)的回復(fù)。

總的來說,詞嵌入是許多自然語言處理任務(wù)的基礎(chǔ),它使機(jī)器能夠理解和處理人類語言,從而實(shí)現(xiàn)更高級的功能。

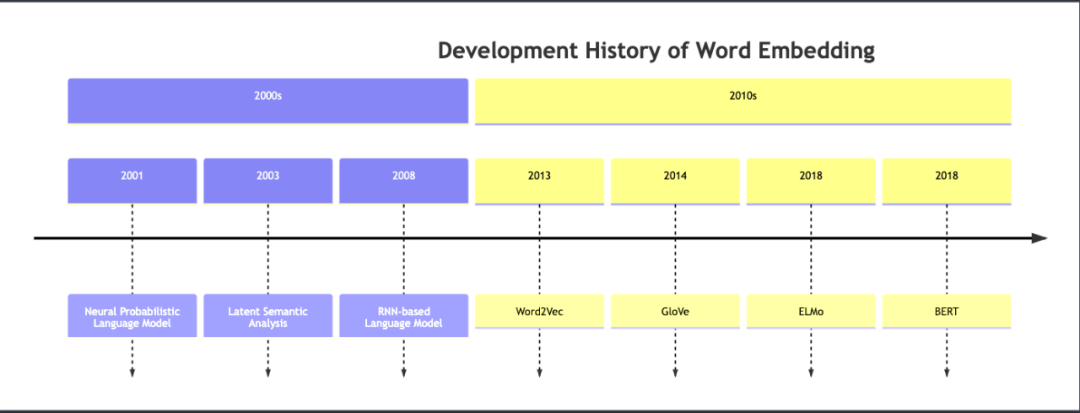

詞嵌入技術(shù)的發(fā)展歷史

以下是關(guān)于詞嵌入(Word Embedding)發(fā)展歷史的時間線圖表:

這個圖表以時間線的形式展示了 Word Embedding 的發(fā)展歷程。從2000年代開始,我們看到了如下的一些關(guān)鍵發(fā)展:

-2001年:神經(jīng)概率語言模型(Neural Probabilistic Language Model)

-2003年:潛在語義分析(Latent Semantic Analysis)

-2008年:基于 RNN 的語言模型(RNN-based Language Model)

進(jìn)入2010年代,Word Embedding 的發(fā)展進(jìn)一步加速:

-2013年:Word2Vec

-2014年:GloVe

-2018年:ELMo 和 BERT

以上就是詞嵌入技術(shù)的主要發(fā)展歷程。

詞嵌入的技術(shù)生態(tài)圖

下圖對詞嵌入的技術(shù)生態(tài)進(jìn)行的歸納。

上圖展示了詞嵌入的各種分類,包括類型(基于計(jì)數(shù)方法還是預(yù)測方法)、預(yù)測方法的具體實(shí)現(xiàn)(如Word2Vec和FastText)、考慮上下文的模型(如ELMo和Transformers)、評估方法(內(nèi)在和外在)以及它的應(yīng)用(NLP任務(wù))。

詞嵌入的質(zhì)量可以通過兩種主要的方式進(jìn)行評估:內(nèi)在評估和外在評估。內(nèi)在評估通過直接測量嵌入的質(zhì)量,例如通過詞語相似性任務(wù)或詞語類比任務(wù)。外在評估則通過測量在某個下游任務(wù)(如文本分類或命名實(shí)體識別)上的性能來間接評估嵌入的質(zhì)量。

如圖所示,能夠?qū)崿F(xiàn)詞嵌入的技術(shù)方案較多,本系列文章主要關(guān)注如下幾種。

· Word2Vec:是一種預(yù)測模型,用于學(xué)習(xí)詞嵌入。它有兩種變體:連續(xù)詞袋模型(CBOW)和Skip-Gram模型。CBOW模型預(yù)測目標(biāo)詞語(如“貓”)給定其上下文(如“黑色的”和“跳上了桌子”)。Skip-Gram模型則反過來,預(yù)測上下文給定目標(biāo)詞語。

· GloVe:是一種基于計(jì)數(shù)的模型,它結(jié)合了上述兩種方法的優(yōu)點(diǎn)。GloVe首先構(gòu)造一個大型的共現(xiàn)矩陣,然后對這個矩陣進(jìn)行分解,得到詞嵌入。

· FastText:是一種預(yù)測模型,它與Word2Vec類似,但是FastText預(yù)測的是包含字符n-gram的詞語。這使得FastText能夠理解詞根、詞綴等詞語內(nèi)部的結(jié)構(gòu),因此對于形態(tài)豐富的語言(如土耳其語)特別有用。

· ELMo:是一種預(yù)測模型,它考慮了詞語的上下文。與Word2Vec和GloVe不同,ELMo為每個詞語生成不同的嵌入,這取決于詞語的上下文。例如,"bank"在"he deposited money in the bank"和"he sat on the bank of the river"中的含義是不同的,因此它的嵌入也應(yīng)該不同。

· Transformer(變換器)模型:如BERT和GPT-2/3/4,使用了自注意力機(jī)制,可以捕獲詞語之間的復(fù)雜關(guān)系。這些模型在許多NLP任務(wù)中都取得了最先進(jìn)的效果。

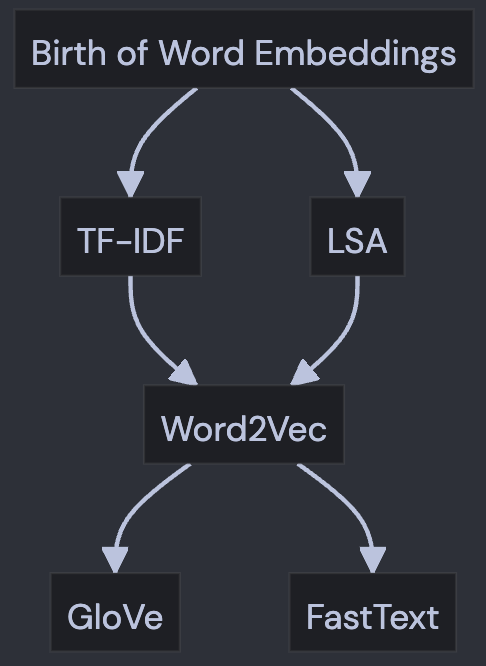

圍繞word2vec的詞嵌入技術(shù)演變

以下是以圍繞word2Vec詞嵌入技術(shù)的演變圖:

上圖解釋如下:

· "Birth of Word Embeddings" 是詞嵌入技術(shù)的起源。

· 從那里,我們看到了兩種早期的詞嵌入技術(shù)的發(fā)展,即 "TF-IDF" 和 "LSA"。

· 這兩種技術(shù)都為 "Word2Vec" 的出現(xiàn)鋪平了道路,Word2Vec 是一種更先進(jìn)的詞嵌入模型。

· 最后,我們看到 "Word2Vec" 為 "GloVe" 和 "FastText" 的開發(fā)提供了基礎(chǔ),這兩種技術(shù)都是當(dāng)前最先進(jìn)的詞嵌入模型。

TF-IDF 例解

TF-IDF (Term Frequency-Inverse Document Frequency) 是一種用于信息檢索和文本挖掘的常用加權(quán)技術(shù)。TF-IDF是一種統(tǒng)計(jì)方法,用以評估一字詞對于一個文件集或一個語料庫中的其中一份文件的重要程度。字詞的重要性隨著它在文件中出現(xiàn)的次數(shù)成正比增加,但同時會隨著它在語料庫中出現(xiàn)的頻率成反比下降。TF-IDF的主要思想是:如果某個詞或短語在一篇文章中出現(xiàn)的頻率TF高,并且在其他文章中很少出現(xiàn),則認(rèn)為此詞或者短語具有很好的類別區(qū)分能力,適合用來分類。

TF-IDF由兩部分組成:TF和IDF。

· TF (Term Frequency),詞頻,即某個詞在文章中出現(xiàn)的頻率。計(jì)算公式為:某個詞在文章中出現(xiàn)的次數(shù) / 文章的總詞數(shù)。

· IDF (Inverse Document Frequency),逆文檔頻率。如果包含詞條的文檔越少,IDF越大,則說明詞條具有很好的類別區(qū)分能力。計(jì)算公式為:log(語料庫的文檔總數(shù) / 包含某個詞的文檔數(shù)+1)。

最后,將TF和IDF相乘,就得到了一個詞在文章中的重要程度。值得注意的是,TF-IDF與一個詞在文檔中的出現(xiàn)次數(shù)成正比,與該詞在整個語料庫中的出現(xiàn)次數(shù)成反比。所以,自動提取關(guān)鍵詞的算法就很清楚了,就是計(jì)算出文檔的每個詞的TF-IDF值,然后按降序排列,取前N個就可以了。

01

通過例子來理解 TF-IDF 的機(jī)制

假設(shè)我們有三篇只包含一句話的文章:

1. 文章A: "The cat sat on the mat."

2. 文章B: "The dog sat on the log."

3. 文章C: "Cats and dogs are mortal enemies."

首先,我們創(chuàng)建一個包含所有單詞的詞匯表:{the, cat, sat, on, mat, dog, log, cats, and, dogs, are, mortal, enemies}。

然后,我們計(jì)算每篇文章中每個詞的TF-IDF值。TF-IDF是一個衡量詞在文檔中重要性的統(tǒng)計(jì)方法,由詞頻(TF)和逆文檔頻率(IDF)兩部分組成。

以文章A中的"cat"為例:

· 詞頻(TF):文章A中"cat"出現(xiàn)一次,文章總詞數(shù)為6,所以TF = 1/6 = 0.167。

· 逆文檔頻率(IDF):"cat"出現(xiàn)在文章A和C中,總共有3篇文章,所以IDF = log(3/2) = 0.176。

· 因此,"cat"在文章A中的TF-IDF值為TF * IDF = 0.167 * 0.176 = 0.029。

我們可以對文章A、B、C中的每個詞重復(fù)這個過程,得到每個詞在每篇文章中的TF-IDF值,這些值可以用作詞嵌入,表示每個詞的重要性。

注:TF-IDF的歸一化處理

量化過程中存在一個問題,例如,當(dāng)某個詞如"the"IDF值為0,導(dǎo)致TF-IDF值為0。但在向量化過程中,文檔中未出現(xiàn)的詞(如某篇文章未出現(xiàn)的詞如"tiger")也會被賦值為0。為了避免混淆,我們通常會對TF-IDF值進(jìn)行平滑處理,最常見的方法是將值加1。根據(jù)需要,這些值可以進(jìn)行歸一化處理。

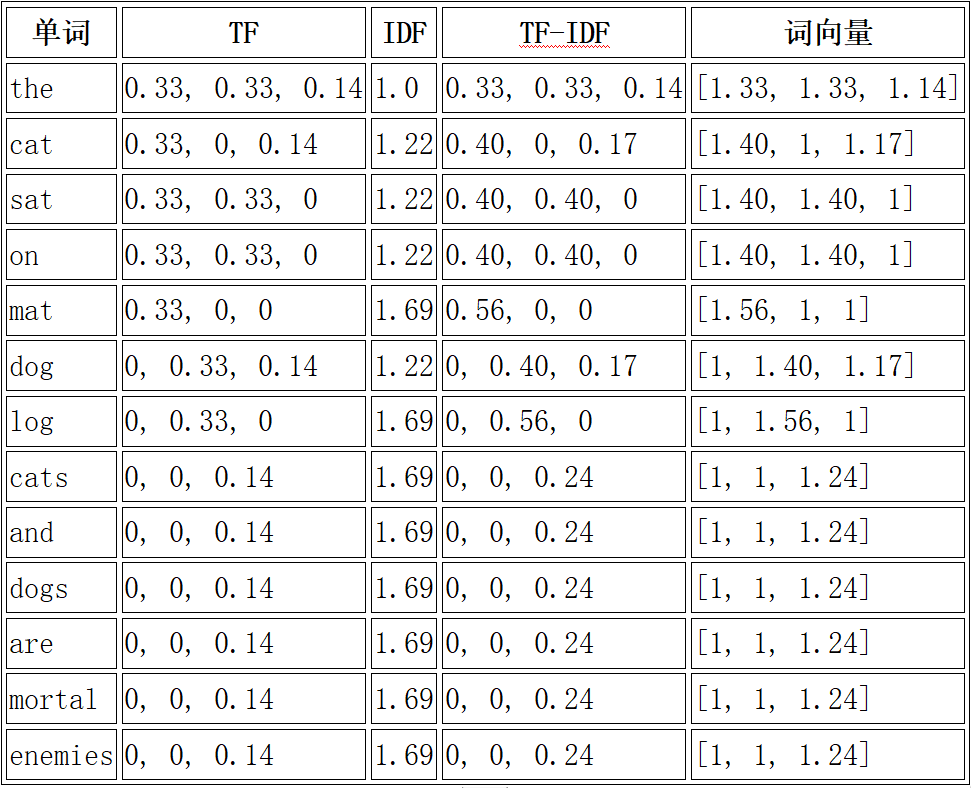

對于上述三篇文章的例子,我們可以計(jì)算出每個詞的 TF、IDF、TF-IDF、和最終的詞向量。以下是計(jì)算結(jié)果(注意,這里的計(jì)算是基于這三篇文章的,實(shí)際應(yīng)用中,TF-IDF的計(jì)算通常是基于一個大規(guī)模的語料庫):

在這個例子中,我們對 TF-IDF 值進(jìn)行了平滑處理,即將所有的 TF-IDF 值加1,以避免混淆。

對于上述三篇文章的例子,我們可以為每篇文章創(chuàng)建一個向量。向量的長度為所有文檔中的唯一單詞的數(shù)量,即13。向量中的每個元素值是該單詞在本文檔中的 TF-IDF 值。如果某個詞沒有在文章中出現(xiàn),其對應(yīng)的向量位置的值設(shè)為 0。以下是計(jì)算結(jié)果:

· 文章A的向量:[1.33, 1.40, 1.40, 1.40, 1.56, 0, 0, 0, 0, 0, 0, 0, 0]

· 文章B的向量:[1.33, 0, 1.40, 1.40, 0, 1.40, 1.56, 0, 0, 0, 0, 0, 0]

· 文章C的向量:[0, 1.17, 0, 0, 0, 1.17, 0, 1.24, 1.24, 1.24, 1.24, 1.24, 1.24]

這些向量更準(zhǔn)確地表示了每篇文章的詞匯分布。對于沒有在文章中出現(xiàn)的詞,其對應(yīng)的向量位置的值為 0,這樣可以更好地區(qū)分文章的內(nèi)容。

02

TF-IDF的優(yōu)缺點(diǎn)分析

TF-IDF是一種常用的文本分析方法,它通過計(jì)算詞頻(TF)和逆文檔頻率(IDF)來衡量一個詞在文本中的重要性。

TF-IDF的一個主要優(yōu)點(diǎn)是它能夠區(qū)分出對文檔意義影響較大的單詞。這是因?yàn)門F-IDF不僅考慮了單詞在文檔中出現(xiàn)的頻率(TF),還考慮了單詞在整個文檔集合中的分布情況(IDF)。

例如,考慮兩個單詞:"the"和"rocket"。在一篇關(guān)于太空探索的文章中,"the"可能出現(xiàn)的頻率非常高,但是它幾乎在所有的英文文章中都會出現(xiàn),因此它對于文章的意義貢獻(xiàn)不大。相反,"rocket"可能出現(xiàn)的頻率較低,但是它只在少數(shù)一些關(guān)于太空或科技的文章中出現(xiàn),因此它對于文章的意義貢獻(xiàn)較大。TF-IDF就能夠通過降低"the"的權(quán)重,提高"rocket"的權(quán)重,從而更好地反映出文章的主題。

TF-IDF的一個主要缺點(diǎn)是它無法處理單詞的同義詞和多義詞問題。這是因?yàn)門F-IDF是基于單詞的字面意義進(jìn)行計(jì)算的,它無法理解單詞的語義。

例如,考慮兩個單詞:"car"和"automobile"。這兩個單詞的意思是相同的,但是TF-IDF會將它們視為兩個完全不同的單詞。因此,如果一個文檔中出現(xiàn)了"car",而另一個文檔中出現(xiàn)了"automobile",那么TF-IDF可能會認(rèn)為這兩個文檔的相似度不高,盡管它們實(shí)際上是在討論同一個主題。

另一個TF-IDF的缺點(diǎn)是,它假設(shè)所有的單詞都是獨(dú)立的,不考慮單詞之間的順序和語境。這就導(dǎo)致TF-IDF無法理解詞組或短語的意義,也無法處理否定和諷刺等復(fù)雜的語言現(xiàn)象。

為了改進(jìn)這些問題,我們可以考慮使用其他類型的詞嵌入方法,如Word2Vec或GloVe,這些方法可以捕捉到詞之間的語義關(guān)系,并且可以處理詞頻偏斜的問題。

01

概述

LSA (Latent Semantic Analysis),潛在語義分析,是一種自然語言處理、信息檢索的技術(shù),用于分析和比較文檔中的語義結(jié)構(gòu)。LSA 使用統(tǒng)計(jì)計(jì)算方法以及無監(jiān)督的學(xué)習(xí)技術(shù)在大量文本數(shù)據(jù)中尋找隱藏的(latent)語義結(jié)構(gòu)。這種技術(shù)基于奇異值分解(SVD)對詞-文檔矩陣進(jìn)行降維,挖掘詞與詞之間、文檔與文檔之間以及詞與文檔之間的關(guān)系。通過將單詞和文檔映射到一個"概念"空間來理解語義。這個"概念"空間是一個多維空間,其中每個維度代表一個"概念"或"主題"。例如,如果我們在處理新聞文章,那么這些"概念"可能包括"政治"、"經(jīng)濟(jì)"、"體育"等。

LSA 使用詞-文檔矩陣(行代表唯一的單詞,列代表文檔),其中每個元素表示特定單詞在特定文檔中出現(xiàn)的頻率。然后,LSA 對這個矩陣進(jìn)行奇異值分解(SVD),得到的結(jié)果可以用于識別文檔和單詞之間的模式。SVD 是一種矩陣分解技術(shù),它將原始矩陣分解為三個矩陣的乘積,這三個矩陣分別代表了單詞、概念和文檔。

LSA 被廣泛應(yīng)用于信息檢索和信息過濾等任務(wù)。例如,搜索引擎可以使用 LSA 來理解用戶的查詢,然后找到最相關(guān)的文檔。此外,LSA 還被用于自動文檔分類、自動文檔摘要、自動文檔鏈接等任務(wù)。例如,新聞聚合網(wǎng)站可以使用 LSA 來自動分類新聞文章,或者生成新聞?wù)?/span>

LSA 的發(fā)展歷史可以追溯到20世紀(jì)80年代,當(dāng)時的研究主要集中在信息檢索領(lǐng)域。隨著時間的推移,LSA 的應(yīng)用領(lǐng)域已經(jīng)擴(kuò)展到了許多其他的自然語言處理任務(wù)。例如,LSA 現(xiàn)在也被用于情感分析、機(jī)器翻譯和語音識別等任務(wù)。

02

LSA的工作機(jī)理

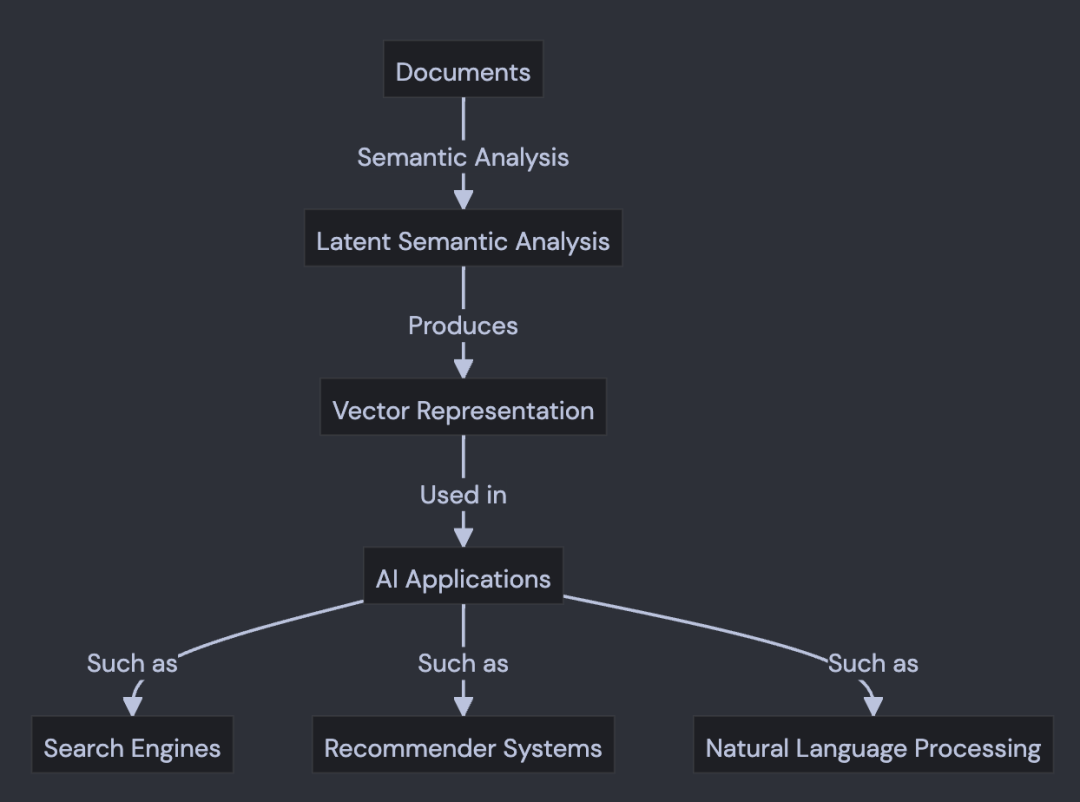

下面的圖表,展示了 LSA 如何將文檔和單詞映射到一個"概念"空間,以及如何在各種 AI 應(yīng)用中使用這種映射。

LSA的主要步驟包括:

1. 創(chuàng)建一個詞-文檔矩陣,其中每個元素表示一個詞在一個文檔中出現(xiàn)的頻率。

2. 對詞-文檔矩陣進(jìn)行奇異值分解(SVD),得到三個矩陣:詞矩陣、奇異值矩陣和文檔矩陣。

3. 通過保留前k個最大的奇異值來近似詞-文檔矩陣,這樣就可以減少噪聲和提取最重要的語義特征。

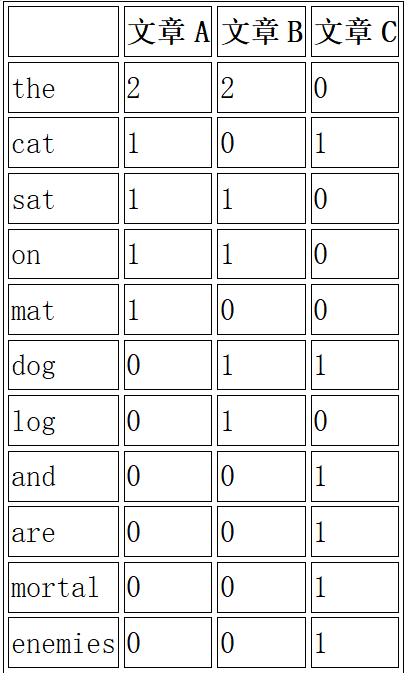

假設(shè)我們有以下三篇文章:

1. 文章A: "The cat sat on the mat."

2. 文章B: "The dog sat on the log."

3. 文章C: "Cats and dogs are mortal enemies."

首先,我們需要創(chuàng)建一個詞-文檔矩陣。在這個例子中,我們的矩陣可能如下所示:

然后,我們對這個矩陣進(jìn)行奇異值分解(SVD),得到三個矩陣:U(詞矩陣)、Σ(奇異值矩陣)和V(文檔矩陣)。我們可以通過保留前k個最大的奇異值來近似詞-文檔矩陣,這樣就可以減少噪聲和提取最重要的語義特征。

我們采用可以通過Python 程序進(jìn)行奇異值分解。由于篇幅關(guān)系,我沒有把源代碼放在這里,感興趣的讀者,可以聯(lián)系作者。

我們的計(jì)算結(jié)果如下:

Sigma values: [3.77394233 2.39944979]

在上述例子中,我們使用了奇異值分解(SVD)對詞-文檔矩陣進(jìn)行分解,得到了三個矩陣:U、Σ和V。

1. U 矩陣:這是一個詞-主題矩陣,每一行對應(yīng)一個詞,每一列對應(yīng)一個主題。在這個例子中,我們選擇了兩個主題(由 n_components 參數(shù)決定),所以 U 矩陣有兩列。U 矩陣的每個元素表示對應(yīng)的詞在對應(yīng)的主題中的權(quán)重。例如,U 矩陣的第一行 [2.7876937, -0.47829262] 表示第一個詞 "the" 在兩個主題中的權(quán)重。

2. Σ 矩陣:這是一個對角矩陣,對角線上的元素是奇異值,表示了每個主題的重要性。在這個例子中,我們有兩個主題,所以 Σ 矩陣有兩個元素 [3.77394233, 2.39944979],第一個主題的重要性更高。

3. V 矩陣:這是一個文檔-主題矩陣,每一行對應(yīng)一個主題,每一列對應(yīng)一個文檔。在這個例子中,我們有三篇文檔,所以 V 矩陣有三列。V 矩陣的每個元素表示對應(yīng)的文檔在對應(yīng)的主題中的權(quán)重。例如,V 矩陣的第一列 [0.69692343, -0.11957316] 表示第一篇文檔 "文章A" 在兩個主題中的權(quán)重。

通過這三個矩陣,我們可以得到每個詞在每個主題中的權(quán)重,每個文檔在每個主題中的權(quán)重,以及每個主題的重要性。這為我們提供了一種理解和表示詞、文檔和主題關(guān)系的方式。

注:LSA中的“主題”的解釋

在上述例子中,“兩個主題”是指我們在進(jìn)行奇異值分解(SVD)時選擇的主題數(shù)量。這個數(shù)量是可以自由選擇的,它決定了我們想要從數(shù)據(jù)中提取多少個主題或概念。

主題在這里可以被理解為一組相關(guān)的詞的集合,這些詞在一起可以表示某種特定的概念或主題。例如,在一個關(guān)于體育的文檔集中,一個主題可能包含像“球隊(duì)”、“比賽”、“運(yùn)動員”這樣的詞,而另一個主題可能包含像“訓(xùn)練”、“健身”、“健康”這樣的詞。

在我們的例子中,我們選擇了兩個主題,這意味著我們試圖找到兩組詞,這兩組詞可以最好地表示我們的文檔集的主題或概念。然而,這兩個主題具體代表什么,通常是難以直接解釋的,因?yàn)樗鼈兪峭ㄟ^機(jī)器學(xué)習(xí)算法從數(shù)據(jù)中自動提取出來的,可能并不直接對應(yīng)我們通常理解的具體主題。

最后,我們可以使用U矩陣中的行作為詞嵌入。這些嵌入不僅考慮了詞頻,還考慮了詞語之間的語義關(guān)系。例如,"cat"和"dog"可能會有相似的嵌入,因?yàn)樗鼈冊谖臋n中出現(xiàn)的上下文相似。

03

LSA的優(yōu)劣勢分析

潛在語義分析(LSA)是一種常用的文本分析方法,它通過分析單詞的共現(xiàn)模式,將單詞映射到一個"概念"空間,從而能夠處理單詞的同義詞和多義詞問題。例如,"汽車"和"車輛"這兩個詞雖然字面上不同,但在很多上下文中,它們的意思是相同的,LSA能夠識別出這種語義相似性。

LSA 的一個主要優(yōu)點(diǎn)是它能夠處理單詞的同義詞和多義詞問題。例如,LSA 能夠理解"汽車"和"車輛"是同義詞。舉個具體的例子,考慮兩個句子:"我需要一支筆來寫信"和"我需要一支鋼筆來書寫一封信件"。盡管這兩個句子中的單詞并不完全相同,但是它們的意思是相似的。如果我們只是基于單詞的字面意義來比較這兩個句子,可能會認(rèn)為它們的相似度不高。但是,如果我們使用LSA,那么這兩個句子會被映射到相近的位置,因?yàn)樗鼈兌忌婕暗?寫"和"信"這兩個概念。

然而,LSA也存在一些缺點(diǎn)。首先,由于LSA基于的是詞-文檔矩陣,這個矩陣只記錄了每個單詞在每個文檔中出現(xiàn)的頻率,而沒有記錄單詞出現(xiàn)的順序,因此,LSA無法處理詞序信息。例如,"貓追狗"和"狗追貓"這兩個句子的意思完全不同,但在LSA中,它們會被映射到完全相同的位置。

另一個LSA的缺點(diǎn)是,當(dāng)處理大規(guī)模數(shù)據(jù)集時,可能會遇到計(jì)算復(fù)雜性問題。因?yàn)長SA需要對詞-文檔矩陣進(jìn)行奇異值分解,這個操作的計(jì)算復(fù)雜性隨著文檔數(shù)量和詞匯表大小的增加而增加。

TF-IDF 和 LSA的對比小結(jié)

1. TF-IDF是一種用于計(jì)算詞語重要性的數(shù)值方法,它只考慮了詞頻(TF)和逆文檔頻率(IDF)兩個因素,沒有考慮詞語的語義信息。

2. LSA是一種用于從文本數(shù)據(jù)中提取語義結(jié)構(gòu)的方法,它通過對詞-文檔矩陣進(jìn)行奇異值分解,可以挖掘詞語之間的語義關(guān)系。

3. TF-IDF更注重于單個文檔中詞語的重要性,而LSA更注重于整個語料庫中詞語的語義關(guān)系。

4. TF-IDF計(jì)算簡單,容易理解,但是無法捕捉詞語的語義關(guān)系。LSA雖然計(jì)算復(fù)雜,但是可以提取出詞語的語義信息。

本文為“詞嵌入技術(shù)詳解系列之基礎(chǔ)技術(shù)(上篇)”,了解更多請點(diǎn)擊以下鏈接:

關(guān)聯(lián) · 閱讀

詞嵌入技術(shù)詳解系列之基礎(chǔ)技術(shù)(上篇)

詞嵌入技術(shù)詳解系列之基礎(chǔ)技術(shù)(中篇)

詞嵌入技術(shù)詳解系列之基礎(chǔ)技術(shù)(下篇)報告推薦

推薦閱讀

本文由「流媒體網(wǎng)」原創(chuàng)出品,