【新智元導(dǎo)讀】近日,國(guó)際模式識(shí)別大會(huì)(ICPR 2020)拉開帷幕,各個(gè)workshop也公布了各項(xiàng)挑戰(zhàn)賽的結(jié)果,來(lái)自中國(guó)的DeepBlueAI 團(tuán)隊(duì)斬獲了由ICPR 2020、Kaggle和JDAI等聯(lián)合舉辦大規(guī)模商品圖像識(shí)別挑戰(zhàn)賽冠軍。

隨著互聯(lián)網(wǎng)技術(shù)和電子商務(wù)的迅猛發(fā)展,人們的購(gòu)物方式逐步由傳統(tǒng)實(shí)體店購(gòu)物變?yōu)榫W(wǎng)絡(luò)購(gòu)物。為了充分滿足客戶海量、多樣化的網(wǎng)上購(gòu)物需求,人工智能零售系統(tǒng)需要快速地從圖像和視頻中自動(dòng)識(shí)別出產(chǎn)品的存貨單元(Stock Keeping Unit,SKU)級(jí)別的類別,然而,許多SKU級(jí)別的產(chǎn)品都是細(xì)粒度的,可以看出它們?cè)谝曈X(jué)上是相似的。JDAI構(gòu)建了一個(gè)名為Products-10K[1]的產(chǎn)品識(shí)別數(shù)據(jù)集,這是迄今為止最大的一個(gè)產(chǎn)品識(shí)別數(shù)據(jù)集,其中包含了約10000種經(jīng)常被中國(guó)消費(fèi)者購(gòu)買的產(chǎn)品,涵蓋了時(shí)尚、3C、食品、保健、家居用品等全品類。該賽題由JDAI和ICPR 2020、Kaggle等聯(lián)合舉辦,要求參數(shù)者開發(fā)算法基于提供的產(chǎn)品圖片進(jìn)行細(xì)粒度分類。

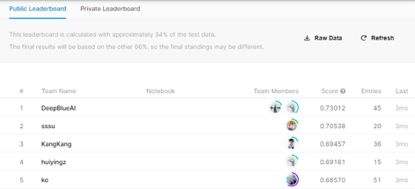

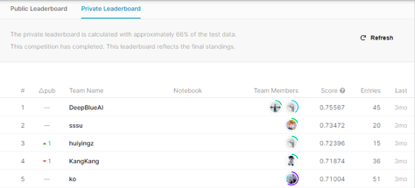

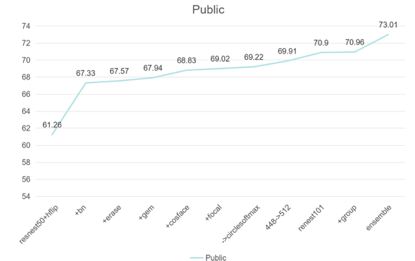

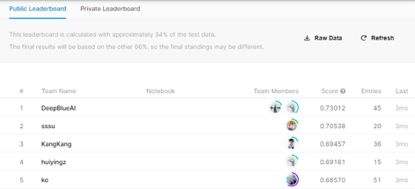

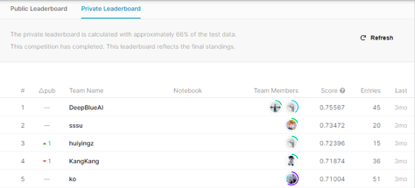

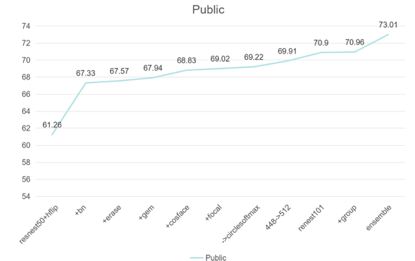

DeepBlueAI團(tuán)隊(duì)通過(guò)數(shù)據(jù)分析,網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)以及l(fā)oss改進(jìn)等逐步優(yōu)化算法,最好的單模在Public & Private上的分?jǐn)?shù)分別是0.70918/0.73618,均超過(guò)了第2名最好的成績(jī),并且通過(guò)模型集成的方法,取得Public & Private第一名的成績(jī),領(lǐng)先第2名兩個(gè)百分點(diǎn)。?

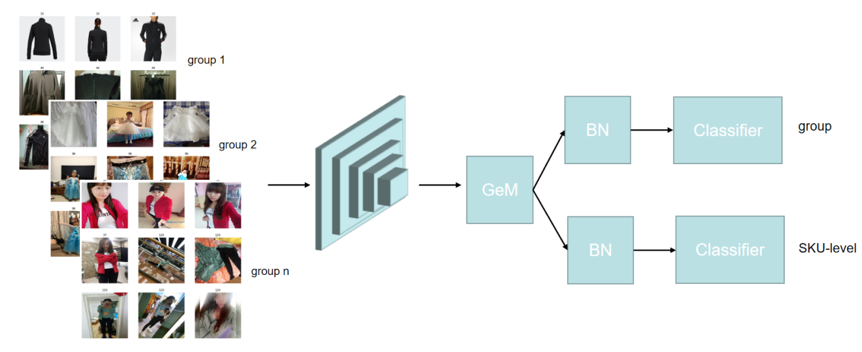

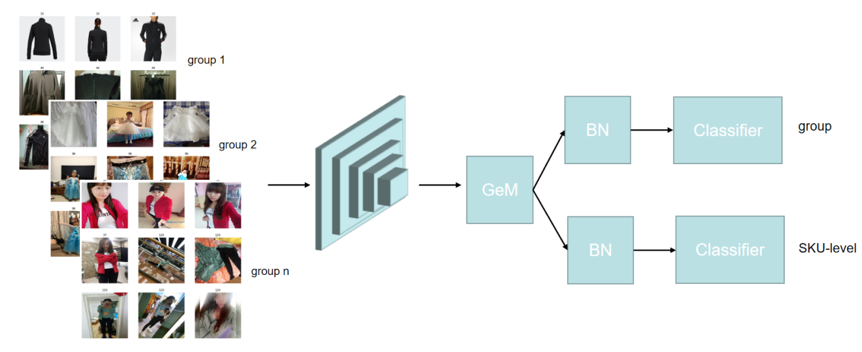

該賽題提供了約150000張圖片,10000個(gè)細(xì)粒度的SKU級(jí)別的標(biāo)簽,以及360個(gè)組別標(biāo)簽,經(jīng)過(guò)數(shù)據(jù)分析可以總結(jié)該數(shù)據(jù)集有以下特點(diǎn):雖然提供了150000張圖片,但是由于類別數(shù)比較多,大部分類別的圖片數(shù)量都少于20張;大部分類別在視覺(jué)上比較相似;如下圖所示,每一行雖然看起來(lái)十分相似,但是卻屬于不同的SKU標(biāo)簽。

同一個(gè)細(xì)粒度標(biāo)簽下的圖片包含了商店場(chǎng)景和消費(fèi)者場(chǎng)景,商店場(chǎng)景的背景比較簡(jiǎn)單,消費(fèi)者場(chǎng)景背景比較復(fù)雜;如下圖所示,每一列都屬于同一個(gè)SKU標(biāo)簽,大部分商店場(chǎng)景圖片都是白色背景,但消費(fèi)者拍攝的圖片背景比較多樣化。

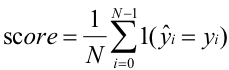

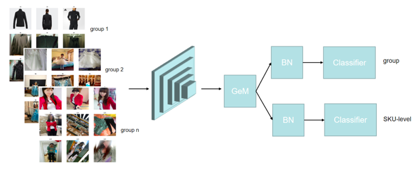

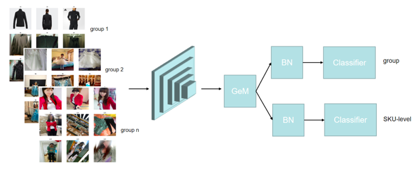

本次競(jìng)賽方案采用了resnest[2]作為基礎(chǔ)骨架網(wǎng)絡(luò)進(jìn)行特征提取,并且使用了GeM pooling[3]對(duì)骨架網(wǎng)絡(luò)最后一層特征進(jìn)行池化,基于池化的向量進(jìn)行g(shù)roup和SKU-level的多任務(wù)分類,分類器采用了CircleSoftmax[4]調(diào)整類間間距,并且在每一個(gè)分類器之前引入了一個(gè)BNNeck[5]的結(jié)構(gòu)。Loss上采用了FocalLoss[6]和CrossEntropy Loss聯(lián)合訓(xùn)練的方式。數(shù)據(jù)增強(qiáng)上,采用了常規(guī)的翻轉(zhuǎn)、隨機(jī)擦除、顏色增強(qiáng)、AugMix[7]等

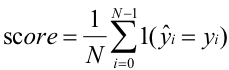

Generalized Mean Pooling (GeM Pooling)假設(shè)是CNN提取后的第k個(gè)特征圖,是第k個(gè)特征圖池化后的結(jié)果。則GeM Pooling[3]的計(jì)算過(guò)程可由下式表示:

GeM Pooling可以看作Average Pooling和Max Pooling的延申,當(dāng)p=1時(shí),GeM Pooling退化成Average Pooling,當(dāng)p無(wú)窮大時(shí),GeM pooling 等效于Max Pooling.

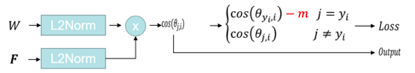

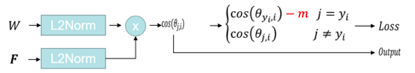

在分類器的選擇上,使用了全連接層構(gòu)建基線模型,通過(guò)數(shù)據(jù)分析發(fā)現(xiàn)該數(shù)據(jù)集存在類內(nèi)距離大,類間距離小等特點(diǎn),因此借鑒了人臉識(shí)別常用的分類器CosFace[8]和CircleSoftmax[4],通過(guò)在訓(xùn)練過(guò)程中引入調(diào)整分類超平面的方式,使得測(cè)試時(shí)的不同類別的特征更容易區(qū)分。如下圖,分別是Cosface[8]和CircleSoftmax[4]的訓(xùn)練測(cè)試過(guò)程。

CosFace訓(xùn)練測(cè)試過(guò)程

CircleSoftmax訓(xùn)練測(cè)試過(guò)程

Loss設(shè)計(jì)

Loss設(shè)計(jì)上使用了Focal Loss[6]和CrossEntropy Loss聯(lián)合訓(xùn)練的方案,避免了Focal Loss需要調(diào)整超參和過(guò)度放大困難樣本權(quán)重的問(wèn)題。

以上是DeepBlueAI團(tuán)隊(duì)參賽的優(yōu)化路線圖,首先通過(guò)水平翻轉(zhuǎn)增強(qiáng)以及resnest50構(gòu)建了基線模型,取得Public榜單61.26的成績(jī);通過(guò)在池化層后面引入BNNeck,數(shù)據(jù)增強(qiáng)上引入隨機(jī)擦除,并把平均池化層替換層GeM Pooling層,取得了Public榜單約68的成績(jī);通過(guò)替換分類器為CircleSoftmax以及聯(lián)合FocalLoss損失進(jìn)行訓(xùn)練的策略,取得了Public榜單69的成績(jī);通過(guò)增大分辨率以及增加網(wǎng)絡(luò)層數(shù),聯(lián)合組別信息進(jìn)行訓(xùn)練,取得了單模Public榜單約71的成績(jī);最后通過(guò)模型集成,取得了Public榜單73.01的成績(jī),并且在該賽題排名第一。?

DeepBlueAI團(tuán)隊(duì)針對(duì)大規(guī)模細(xì)粒度商品圖像識(shí)別任務(wù),通過(guò)數(shù)據(jù)分析、數(shù)據(jù)增強(qiáng)、網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)以及l(fā)oss改進(jìn)等設(shè)計(jì)了一個(gè)簡(jiǎn)單的細(xì)粒度圖像識(shí)別算法。該算法取得了Public & Private第一名的成績(jī),領(lǐng)先第2名兩個(gè)百分點(diǎn),有望幫助人工智能零售系統(tǒng)快速并準(zhǔn)確地從圖像和視頻中自動(dòng)識(shí)別出產(chǎn)品的存貨單元級(jí)別的類別,優(yōu)化消費(fèi)者的購(gòu)物體驗(yàn)。?

羅志鵬,DeepBlue Technology北京AI研發(fā)中心負(fù)責(zé)人,畢業(yè)于北京大學(xué),曾任職于微軟亞太研發(fā)集團(tuán)。現(xiàn)主要負(fù)責(zé)公司AI平臺(tái)相關(guān)研發(fā)工作,帶領(lǐng)團(tuán)隊(duì)已在CVPR、ICCV、ECCV、KDD、NeurIPS、SIGIR、AAAI等數(shù)十個(gè)世界頂級(jí)會(huì)議挑戰(zhàn)賽中獲得二十多項(xiàng)冠軍,以一作在KDD、WWW等國(guó)際頂會(huì)上發(fā)表論文,具有多年跨領(lǐng)域的人工智能研究和實(shí)戰(zhàn)經(jīng)驗(yàn)。?

?

參考文獻(xiàn):

1. Bai Y, Chen Y, Yu W, et al. Products-10K: A Large-scale Product Recognition Dataset[J]. arXiv preprint arXiv:2008.10545, 2020.

2. Zhang H, Wu C, Zhang Z, et al. Resnest: Split-attention networks[J]. arXiv preprint arXiv:2004.08955, 2020.

3. Radenovi? F, Tolias G, Chum O. Fine-tuning CNN image retrieval with no human annotation[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 41(7): 1655-1668.

4. Sun Y, Cheng C, Zhang Y, et al. Circle loss: A unified perspective of pair similarity optimization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 6398-6407.

5. Luo, H., Gu, Y., Liao, X., Lai, S., Jiang, W.: Bag of tricks and a strong baseline for deep person re-identification (2019).

6. Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE international conference on computer vision. 2017: 2980-2988.

7. Hendrycks D, Mu N, Cubuk E D, et al. Augmix: A simple data processing method to improve robustness and uncertainty[J]. arXiv preprint arXiv:1912.02781, 2019.

8. Wang H, Wang Y, Zhou Z, et al. Cosface: Large margin cosine loss for deep face recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 5265-5274.