YOLOv6:又快又準的目標檢測框架開源啦

近日,美團視覺智能部研發(fā)了一款致力于工業(yè)應(yīng)用的目標檢測框架 YOLOv6,能夠同時專注于檢測的精度和推理效率。在研發(fā)過程中,視覺智能部不斷進行了探索和優(yōu)化,同時吸取借鑒了學(xué)術(shù)界和工業(yè)界的一些前沿進展和科研成果。在目標檢測權(quán)威數(shù)據(jù)集 COCO 上的實驗結(jié)果顯示,YOLOv6 在檢測精度和速度方面均超越其他同體量的算法,同時支持多種不同平臺的部署,極大簡化工程部署時的適配工作。特此開源,希望能幫助到更多的同學(xué)。

1. 概述

精度與速度遠超 YOLOv5 和 YOLOX 的新框架

2. YOLOv6關(guān)鍵技術(shù)介紹

2.1 Hardware-friendly 的骨干網(wǎng)絡(luò)設(shè)計

2.2 更簡潔高效的 Decoupled Head

2.3 更有效的訓(xùn)練策略

3. 實驗結(jié)果

4. 總結(jié)與展望

1. 概述

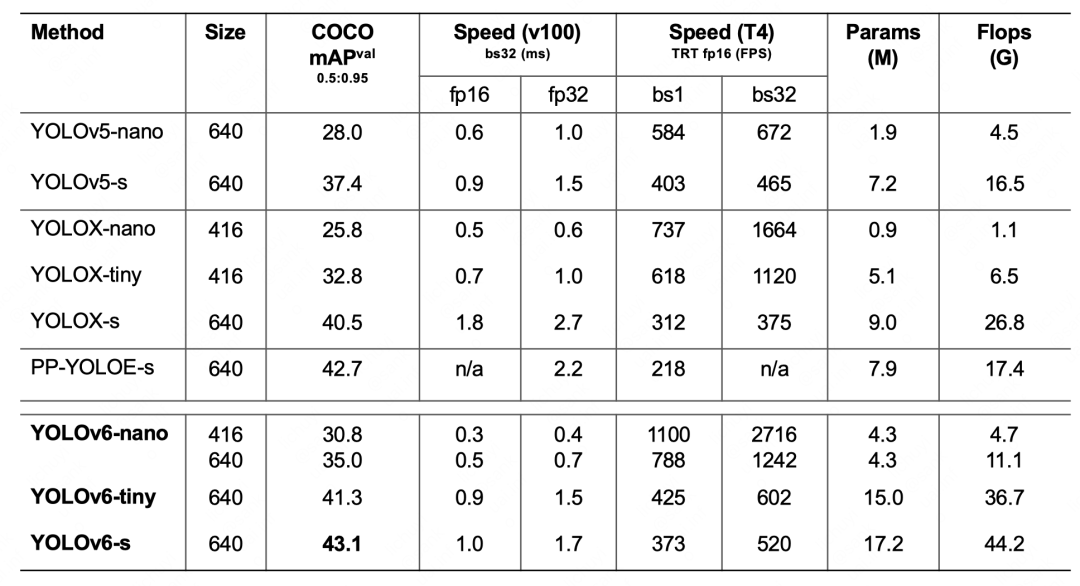

精度與速度遠超 YOLOv5 和 YOLOX 的新框架

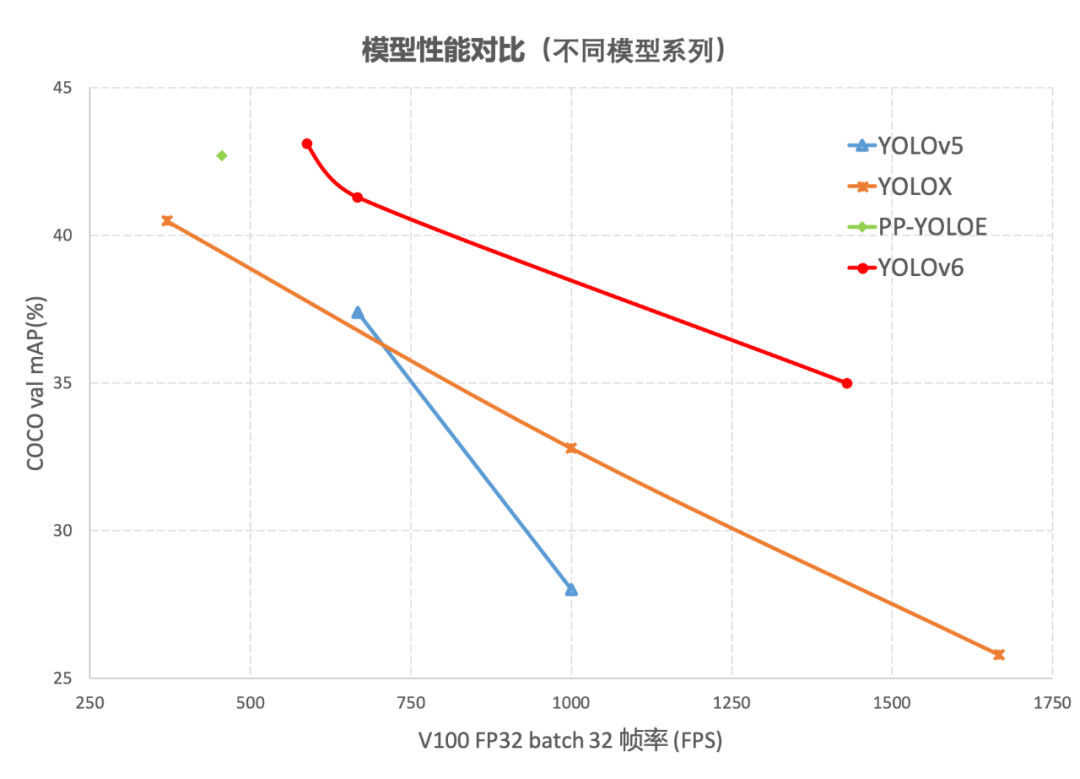

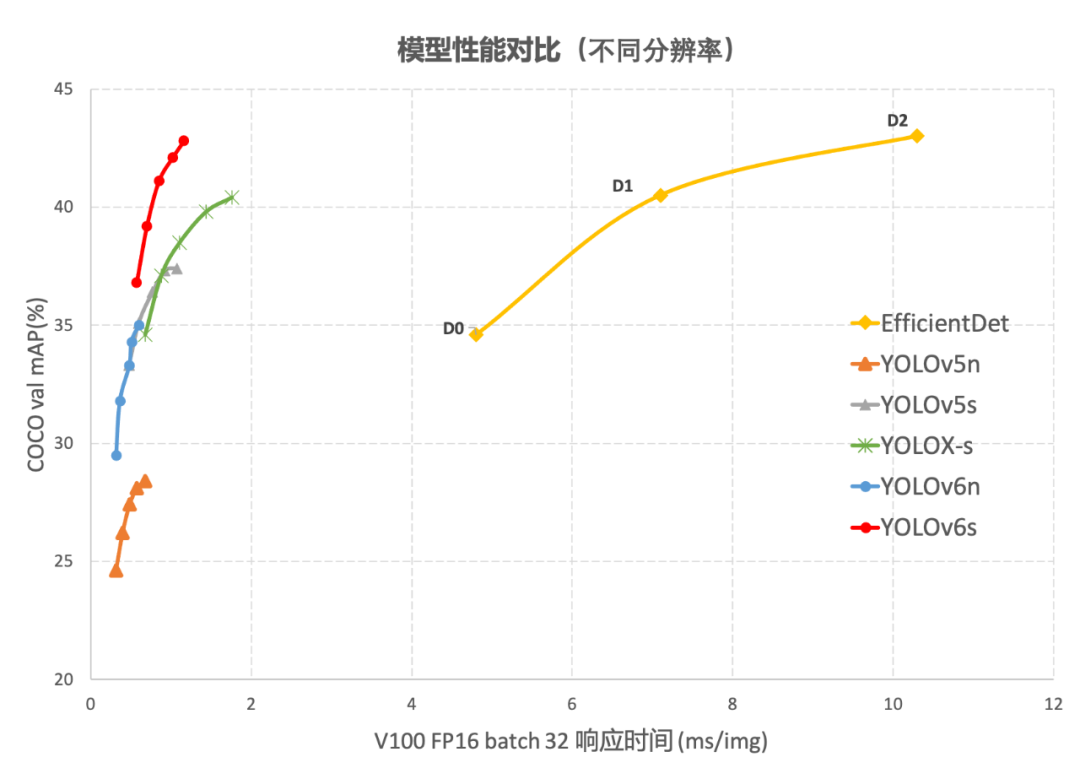

圖1-1 YOLOv6 各尺寸模型與其他模型性能對比

2. YOLOv6關(guān)鍵技術(shù)介紹

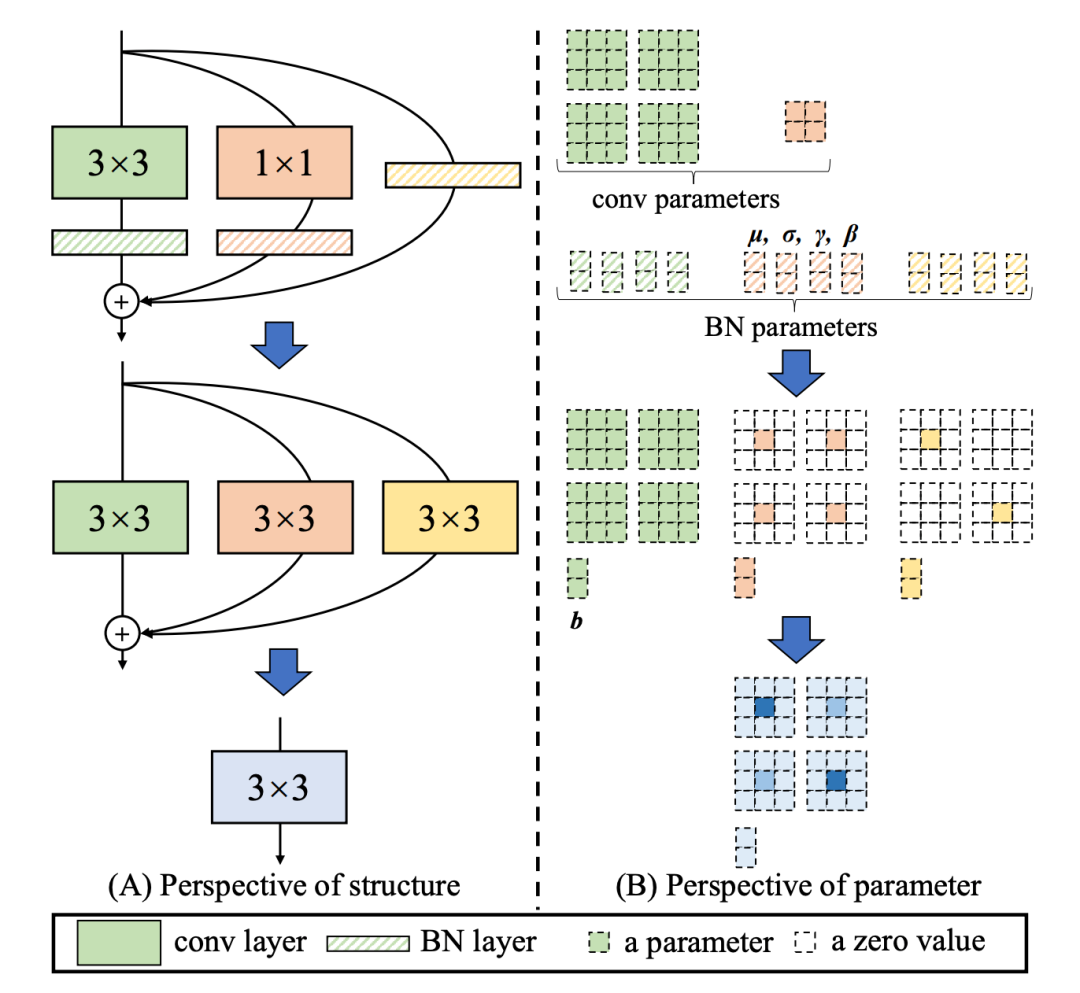

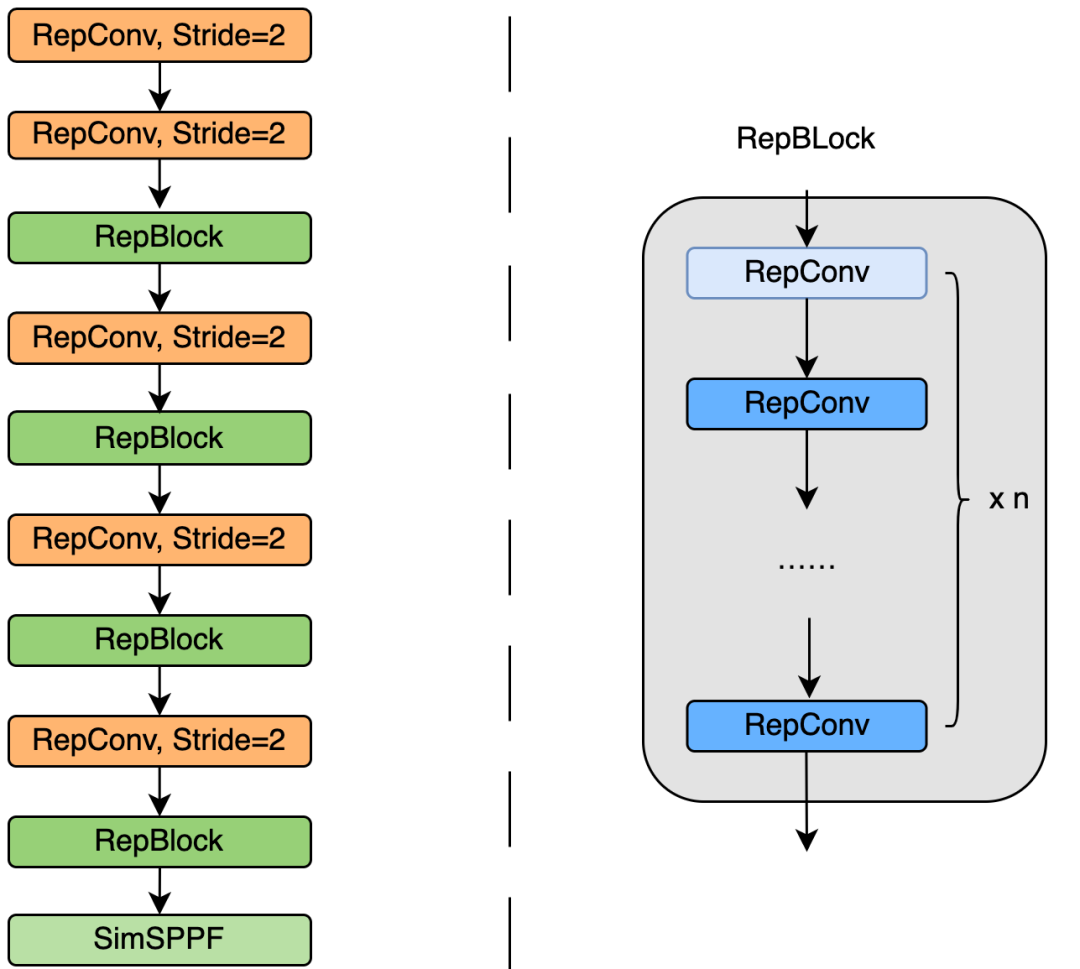

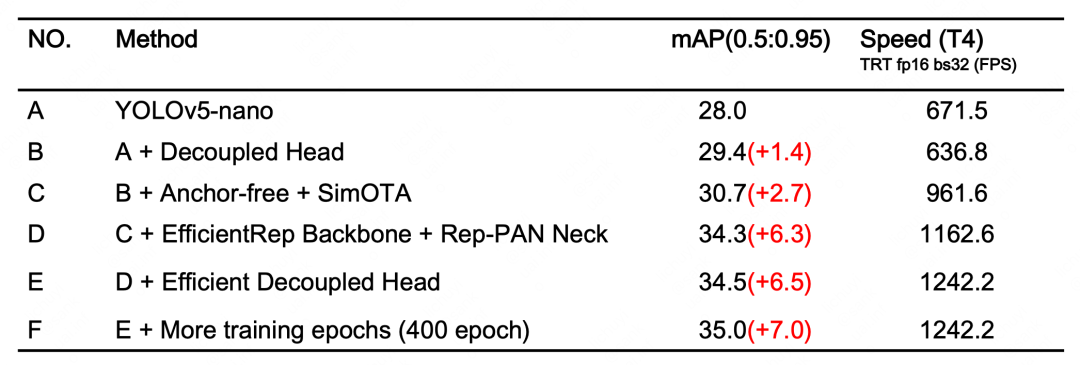

我們統(tǒng)一設(shè)計了更高效的 Backbone 和 Neck :受到硬件感知神經(jīng)網(wǎng)絡(luò)設(shè)計思想的啟發(fā),基于 RepVGG style[4] 設(shè)計了可重參數(shù)化、更高效的骨干網(wǎng)絡(luò) EfficientRep Backbone 和 Rep-PAN Neck。 優(yōu)化設(shè)計了更簡潔有效的 Efficient Decoupled Head,在維持精度的同時,進一步降低了一般解耦頭帶來的額外延時開銷。 在訓(xùn)練策略上,我們采用Anchor-free 無錨范式,同時輔以 SimOTA[2] 標簽分配策略以及 SIoU[9] 邊界框回歸損失來進一步提高檢測精度。

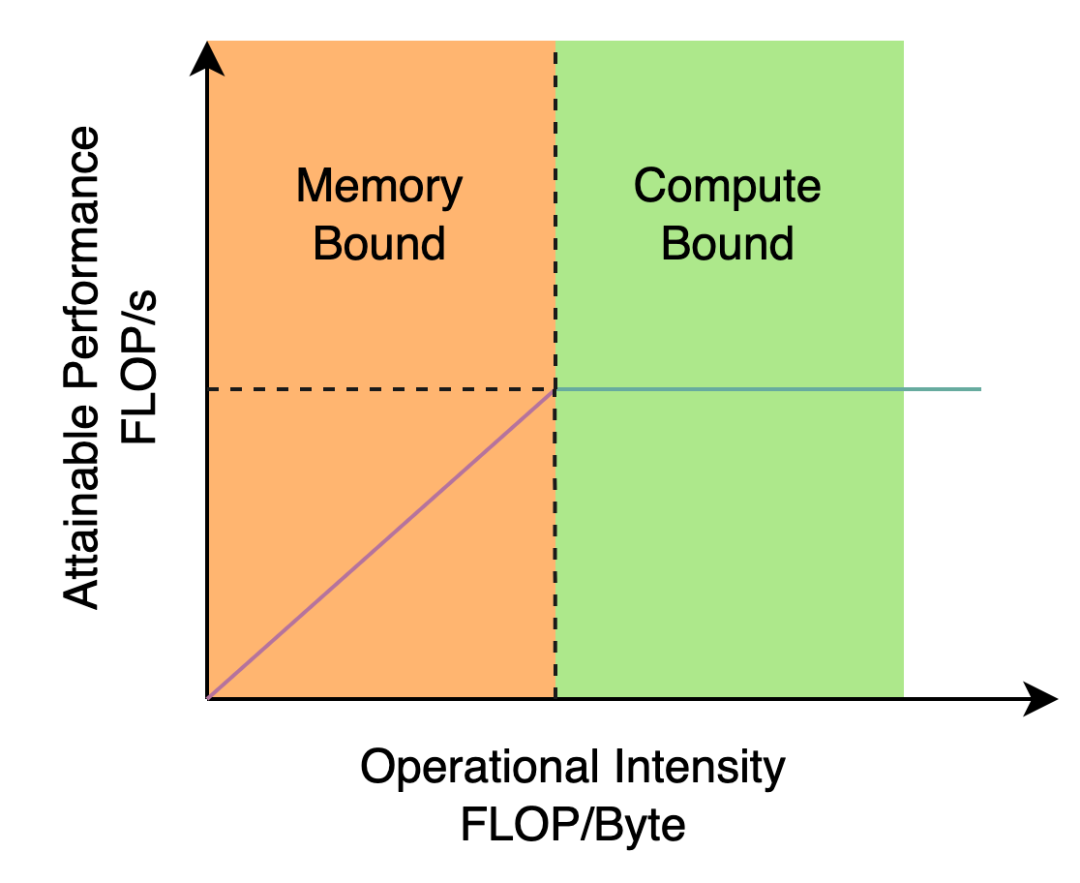

2.1 Hardware-friendly 的骨干網(wǎng)絡(luò)設(shè)計

引入了 RepVGG[4] style 結(jié)構(gòu)。 基于硬件感知思想重新設(shè)計了 Backbone 和 Neck。

2.2 更簡潔高效的 Decoupled Head

2.3 更有效的訓(xùn)練策略

3. 實驗結(jié)果

YOLOv6-nano 在 COCO val 上 取得了 35.0% AP 的精度,同時在 T4 上使用 TRT FP16 batchsize=32 進行推理,可達到 1242FPS 的性能,相較于 YOLOv5-nano 精度提升 7% AP,速度提升 85%。 YOLOv6-tiny 在 COCO val 上 取得了 41.3% AP 的精度, 同時在 T4 上使用 TRT FP16 batchsize=32 進行推理,可達到 602FPS 的性能,相較于 YOLOv5-s 精度提升 3.9% AP,速度提升 29.4%。 YOLOv6-s 在 COCO val 上 取得了 43.1% AP 的精度, 同時在 T4 上使用 TRT FP16 batchsize=32 進行推理,可達到 520FPS 的性能,相較于 YOLOX-s 精度提升 2.6% AP,速度提升 38.6%;相較于 PP-YOLOE-s 精度提升 0.4% AP的條件下,在T4上使用 TRT FP16 進行單 batch 推理,速度提升 71.3%。

4. 總結(jié)與展望

完善 YOLOv6 全系列模型,持續(xù)提升檢測性能。 在多種硬件平臺上,設(shè)計硬件友好的模型。 支持 ARM 平臺部署以及量化蒸餾等全鏈條適配。 橫向拓展和引入關(guān)聯(lián)技術(shù),如半監(jiān)督、自監(jiān)督學(xué)習(xí)等等。 探索 YOLOv6 在更多的未知業(yè)務(wù)場景上的泛化性能。

5. 參考文獻

6. 作者簡介

——The End——

分享

收藏

點贊

在看

評論

圖片

表情