史上最大開源LLM,參數(shù)高達(dá)3140億!馬斯克如約開源Grok,10小時(shí)狂攬10000顆Star

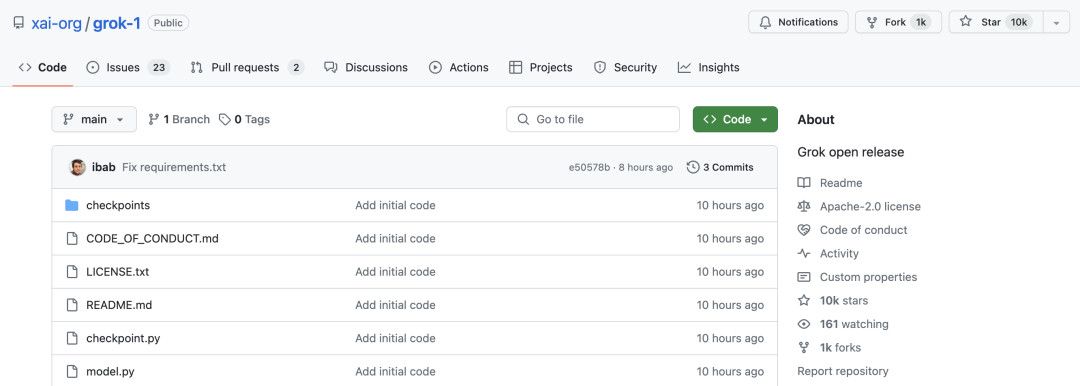

氣「OpenAI 不 Open」以至于對(duì)其發(fā)起訴訟之后,馬斯克踐行自己自由、開放的原則,在剛剛過(guò)去的周末里選擇重磅開源自家的 AI 大模型——Grok-1(https://github.com/xai-org/grok-1)。

距離 Grok-1 開源僅過(guò)去了 10 個(gè)小時(shí),該項(xiàng)目便獲得了 10k 的 Star,成為眾人關(guān)注的焦點(diǎn)所在。

馬斯克的 xAI 公司開源 Grok-1,高達(dá) 3140 億參數(shù)

這款 Grok 大模型,是馬斯克集結(jié) Deepmind、微軟、特斯拉、學(xué)術(shù)界多位大佬于 2023 年 7 月成立的人工智能初創(chuàng)公司 xAI 所帶來(lái)的成果。

Grok 的設(shè)計(jì)初衷,靈感來(lái)源于英國(guó)作家道格拉斯·亞當(dāng)斯所寫的一系列科幻小說(shuō)《銀河系漫游指南》,和 ChatGPT 一樣,可以以對(duì)話方式回答問(wèn)題,也能聯(lián)網(wǎng),而有所不同的是,Grok 已集成到 X 社交媒體平臺(tái)中,可以“實(shí)時(shí)訪問(wèn)”該平臺(tái)上的所有信息,還可以回答大多數(shù)其他 AI 系統(tǒng)拒絕回答的尖銳問(wèn)題,甚至就如何提問(wèn)給出建議。

訂閱 X 的高級(jí)功能用戶可以向 Grok 提出問(wèn)題并收到答復(fù)。

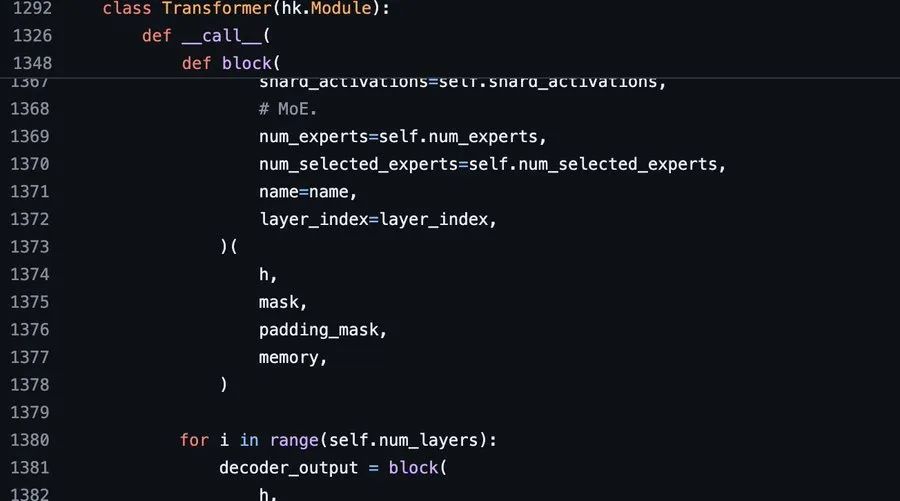

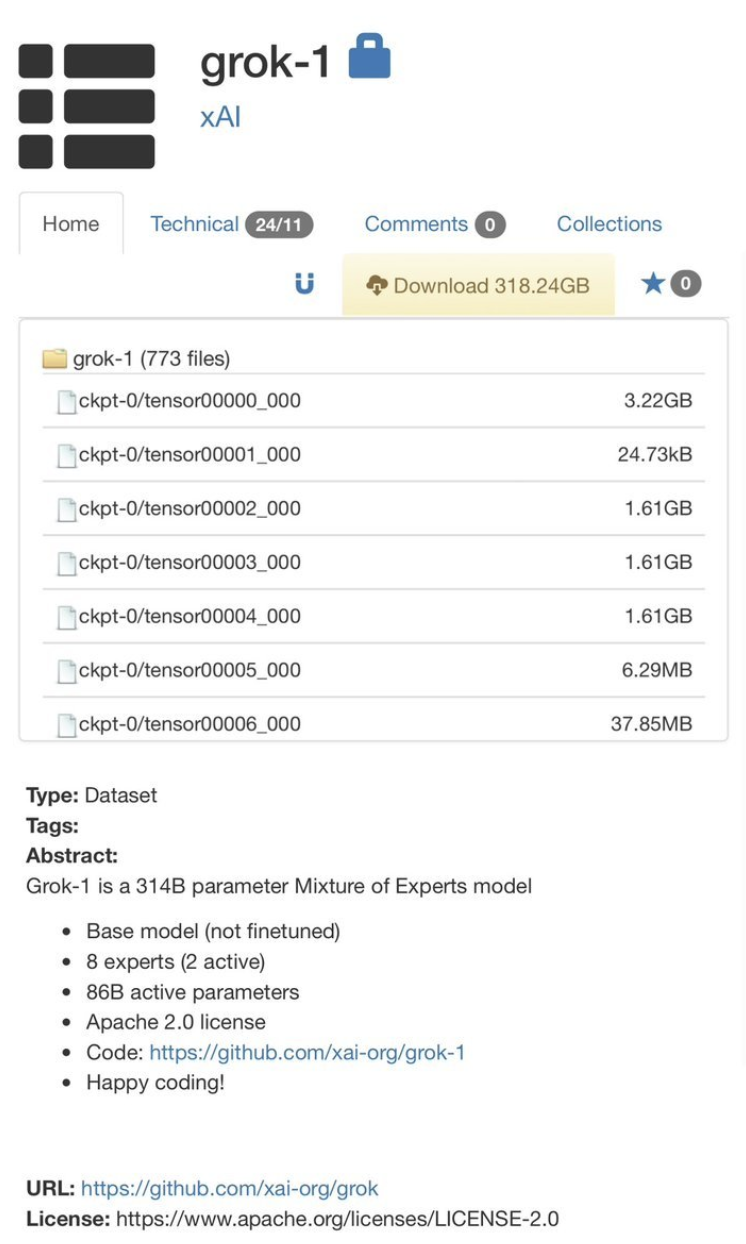

根據(jù) xAI 在其官方博客更新的公告顯示,其開源的 Grok-1 是一個(gè)由 xAI 從頭開始訓(xùn)練的 3140 億參數(shù)混合專家(MoE)模型。

xAI 團(tuán)隊(duì)表示,“這是 Grok-1 預(yù)訓(xùn)練階段的原始基礎(chǔ)模型檢查點(diǎn),該階段于 2023 年 10 月結(jié)束。這意味著該模型沒(méi)有針對(duì)任何特定應(yīng)用(例如對(duì)話)進(jìn)行微調(diào)。”

該模型的詳細(xì)情況:

基于大量文本數(shù)據(jù)訓(xùn)練的基礎(chǔ)模型,未針對(duì)任何特定任務(wù)進(jìn)行微調(diào)。

314B 參數(shù)的混合專家模型, 25% 的權(quán)重對(duì)給定 token 有效。

xAI 于 2023 年 10 月在 JAX 和 Rust 上使用自定義訓(xùn)練堆棧從頭開始訓(xùn)練。

同時(shí) Grok-1 是在 Apache 2.0 許可證下發(fā)布權(quán)重和架構(gòu)。

他說(shuō)道,“我剛剛瀏覽了 http://model.py ,對(duì)于這個(gè) 314B 開源的龐然大物,竟然沒(méi)有附加任何條件。”

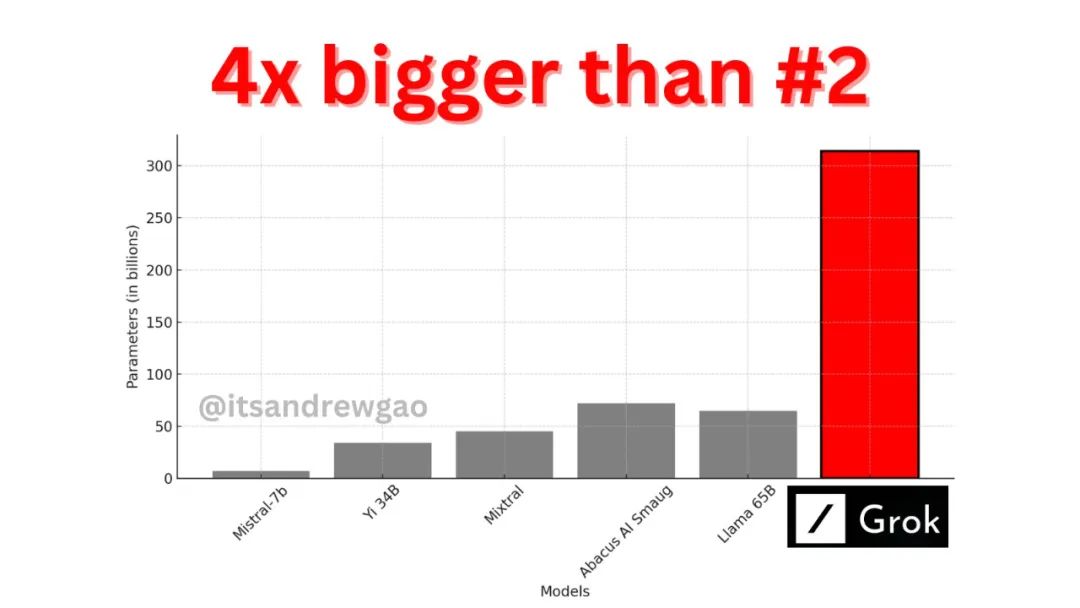

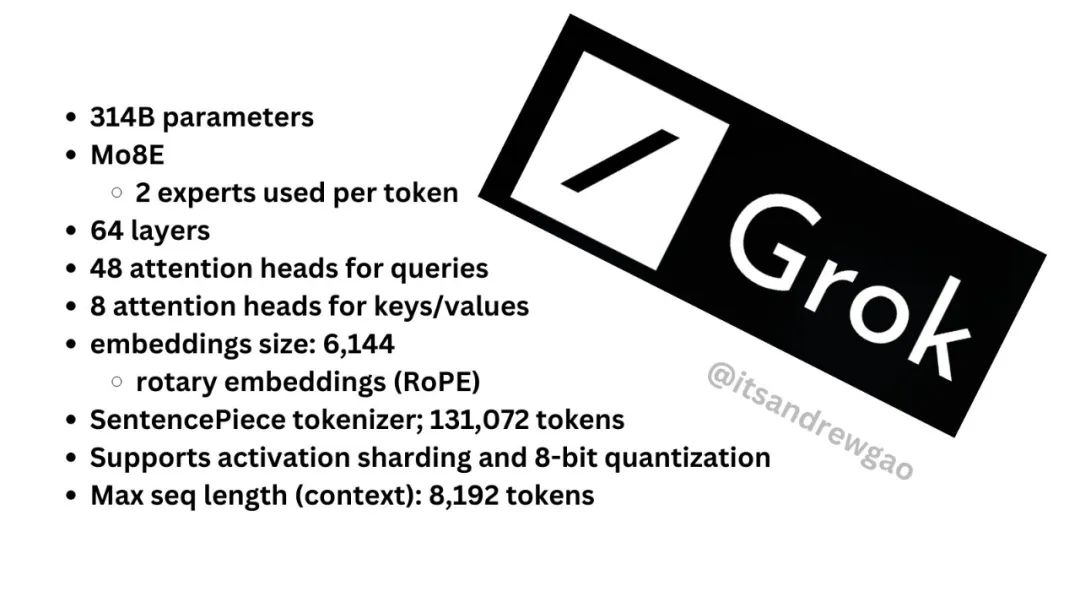

詳細(xì)來(lái)看,Grok-1 是一個(gè) 314 B 的 Mixture-of-Experts(MoE)模型(8 個(gè)專家 2 個(gè)是活躍的),860 億的激活參數(shù),這比 Llama-2 的 70B 參數(shù)還要多。

此外,Grok-1 使用的旋轉(zhuǎn)位置嵌入(RoPE)而非固定位置嵌入。

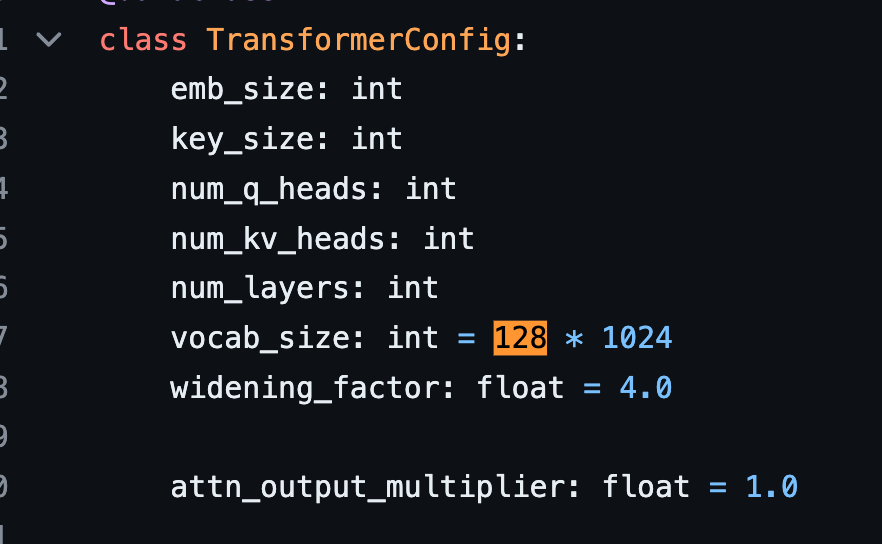

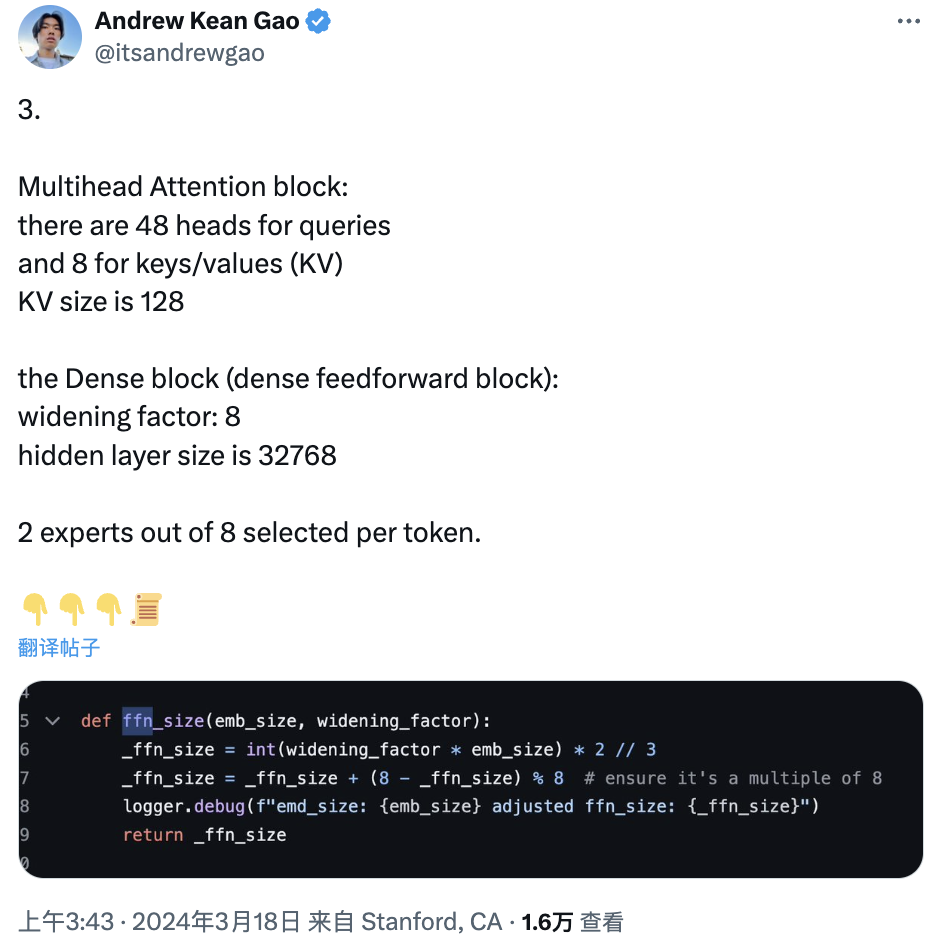

再者,Grok-1 tokenizer 詞匯大小為 131,072(與 GPT-4 類似) 2^17,嵌入大小為 6,144(48*128);64 個(gè) Transformer 層,每層都有一個(gè)解碼器層:多頭注意力塊和密集塊,鍵值大小 128。

其中,多頭注意模塊有 48 個(gè) head 和 8 個(gè)鍵/值 (KV),KV 大小為 128。

密集塊(密集前饋塊):加寬因子為 8,隱藏層大小為 32768。

每個(gè) token 從 8 個(gè)專家中選出 2 個(gè)。

旋轉(zhuǎn)位置嵌入大小為 6144,這是有道理的,因?yàn)樗c模型的輸入嵌入大小相同。

上下文長(zhǎng)度:8,192 個(gè)詞塊

精度 bf16

Grok-1 的性能

關(guān)于 Grok-1 的詳細(xì)細(xì)節(jié),此前 CSDN 也曾報(bào)道過(guò)。

根據(jù)官方公告顯示,為 Grok 提供動(dòng)力的引擎 Grok-1,是在數(shù)萬(wàn)個(gè) GPU 集群(外媒 Techcrunch 透露,可能是由 Oracle 提供的)上花了幾個(gè)月時(shí)間開發(fā)的,訓(xùn)練數(shù)據(jù)來(lái)自網(wǎng)絡(luò)(截至 2023 第三季度)和人類助手的反饋,xAI 將其稱之為“AI 導(dǎo)師”。

為了驗(yàn)證 Grok-1 的能力,xAI 團(tuán)隊(duì)使用了一些衡量數(shù)學(xué)和推理能力的標(biāo)準(zhǔn)機(jī)器學(xué)習(xí)基準(zhǔn)進(jìn)行了一系列評(píng)估。

根據(jù)測(cè)試結(jié)果顯示,Grok-1 目前處于中等水平,超過(guò)了 GPT-3.5、LLaMA 2 70B,但是距離 Claude 2、GPT-4 等大模型還有一定的距離。

使用指南

當(dāng)前,Grok-1 面向所有人開放,而要開始使用該模型,可以先確保下載 checkpoint 并將 ckpt-0 目錄放入 checkpoint。然后,運(yùn)行:

pip install -r requirements.txtpython run.py

進(jìn)而測(cè)試代碼。

腳本在測(cè)試輸入上加載檢查點(diǎn)和模型樣本。

值得注意的事,Grok-1 參數(shù)量高達(dá) 314B 個(gè)參數(shù),其模型體積龐大,需要配備足夠 GPU 內(nèi)存的機(jī)器才能使用示例代碼測(cè)試模型。

xAI 團(tuán)隊(duì)在 GitHub 項(xiàng)目倉(cāng)庫(kù)里面也直言道:該資源庫(kù)中 MoE 層的實(shí)現(xiàn)并不高效。選擇這種實(shí)現(xiàn)方式是為了避免需要定制內(nèi)核來(lái)驗(yàn)證模型的正確性。

你可以使用 torrent 客戶端和下面磁鐵鏈接下載權(quán)重:

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

詳細(xì)使用指南也可以通過(guò) GitHub 項(xiàng)目地址:github.com/xai-org/grok 進(jìn)行速覽。

開源 or 閉源

一直以來(lái),關(guān)于究竟是該構(gòu)建開源還是閉源的大模型,業(yè)界存有巨大的爭(zhēng)議。對(duì)于 OpenAI 等公司而言,如今的 AI 存在不少未可知的風(fēng)險(xiǎn),開源有可能造成技術(shù)被濫用,所以閉源似乎優(yōu)于開源。

但是在馬斯克等人看來(lái),通過(guò)開放代碼讓所有人有權(quán)查看和使用有助于使技術(shù)更加安全。所以在此次開源 Grok 之際,馬斯克還暗諷了 ChatGPT,希望讓其“告訴我們更多有關(guān) OpenAI 開放部分的信息....”

馬斯克認(rèn)為,任何話題都不應(yīng)該成為聊天機(jī)器人的禁區(qū)。不過(guò),他也警醒道:

“我的一位朋友提醒我澄清清醒人工智能的危險(xiǎn)性質(zhì),尤其是強(qiáng)制多樣性。

如果一個(gè)人工智能被設(shè)定為不惜一切代價(jià)推動(dòng)多元化,就像 Google Gemini 那樣,那么它就會(huì)不擇手段地造成這種結(jié)果,甚至有可能殺人。”

亞利桑那州立大學(xué)計(jì)算機(jī)科學(xué)教授 Subbarao Kambhampati 同樣認(rèn)為,開源當(dāng)今的人工智能技術(shù)是最安全的方法。

不過(guò),也有不少用戶擔(dān)心馬斯克只是做了初步開源 Grok-1 的計(jì)劃,就沒(méi)有后續(xù)跟進(jìn),畢竟他此前對(duì) X 的推薦算法也做了開源,但只是開源之后就似乎沒(méi)有更新過(guò)。

針對(duì)這一擔(dān)憂,馬斯克也現(xiàn)身回應(yīng)有關(guān)開源 X 推薦算法時(shí)說(shuō)道,“還有很多工作要做,但這個(gè)平臺(tái)已經(jīng)是迄今為止最透明、最求真的平臺(tái)(說(shuō)實(shí)話,門檻并不高)”。

不管怎樣,馬斯克成立的 xAI 公司僅僅用了 8 個(gè)月不僅創(chuàng)建了 Grok,還將 Grok-1 開源出來(lái),其行動(dòng)速度遠(yuǎn)超乎眾人的想象,甚至 OpenAI 的員工也表達(dá)了他們對(duì) Grok 的強(qiáng)烈興趣。

而 Grok 的發(fā)布可能會(huì)給所有其他 LLM 提供商(尤其是其他競(jìng)爭(zhēng)對(duì)手的開源提供商)帶來(lái)不小的壓力,但有競(jìng)爭(zhēng)才有進(jìn)步,對(duì)于普通用戶而言,也是一件好事。

正如英偉達(dá)科學(xué)家 Jim Fan 評(píng)價(jià)道:「有史以來(lái)最大的開放 LLM,由世界級(jí)團(tuán)隊(duì)訓(xùn)練;通過(guò)磁力鏈接發(fā)布;Apache 2.0;314B;專家混合(8 個(gè)活躍中的 2 個(gè))。就連激活參數(shù)僅(86B)就超過(guò)了最大的 Llama。迫不及待地想看到基準(zhǔn)測(cè)試結(jié)果以及人們用它構(gòu)建的內(nèi)容。」

來(lái)源:

Grok 開源地址:https://github.com/xai-org/grok-1

官方博客公告:https://x.ai/blog/grok-os

https://x.ai/blog/grok