Jeff Dean萬(wàn)字長(zhǎng)文:2020谷歌10大領(lǐng)域AI技術(shù)發(fā)展

??新智元報(bào)道??

??新智元報(bào)道??

來(lái)源:GoogleAI Blog

編輯:QJP、小勻

【新智元導(dǎo)讀】2021年已經(jīng)度過(guò)十余天,Jeff Dean也在醞釀后在Google AI Blog發(fā)表了一篇萬(wàn)字長(zhǎng)文,回顧了谷歌AI2020年的發(fā)展與成就,同時(shí),也展望了接下來(lái)的工作重點(diǎn)。

Jeff Dean發(fā)了一篇幾萬(wàn)字長(zhǎng)文,回顧了這一年來(lái)谷歌在各個(gè)領(lǐng)域的成就與突破,并展望了2021年的工作目標(biāo)。

?

「當(dāng)我20多年前加入谷歌的時(shí)候,只想弄清楚如何真正開(kāi)始使用電腦在網(wǎng)絡(luò)上提供高質(zhì)量和全面的信息搜索服務(wù)。時(shí)間快進(jìn)到今天,當(dāng)面對(duì)更廣泛的技術(shù)挑戰(zhàn)時(shí),我們?nèi)匀挥兄瑯拥目傮w目標(biāo),那就是組織全世界的信息,使其普遍可獲取和有用。

?

2020年,隨著世界被冠狀病毒重塑,我們看到了技術(shù)可以幫助數(shù)十億人更好地交流,理解世界和完成任務(wù)。我為我們所取得的成就感到驕傲,也為即將到來(lái)的新的可能性感到興奮。」

?

Google Research 的目標(biāo)是解決一系列長(zhǎng)期而又重大的問(wèn)題,從預(yù)測(cè)冠狀病毒疾病的傳播,到設(shè)計(jì)算法、自動(dòng)翻譯越來(lái)越多的語(yǔ)言,再到減少機(jī)器學(xué)習(xí)模型中的偏見(jiàn)。

本文涵蓋了今年的關(guān)鍵亮點(diǎn)。

新冠病毒和健康

COVID-19的影響給人們的生活帶來(lái)了巨大的損失,世界各地的研究人員和開(kāi)發(fā)人員聯(lián)合起來(lái)開(kāi)發(fā)工具和技術(shù),以幫助公共衛(wèi)生官員和政策制定者理解和應(yīng)對(duì)這場(chǎng)流行病。

?

蘋果和谷歌在2020年合作開(kāi)發(fā)了暴露通知系統(tǒng)(ENS) ,這是一種支持藍(lán)牙的隱私保護(hù)技術(shù),如果人們暴露在其他檢測(cè)呈陽(yáng)性的人群中,可以通知他們。

?

ENS 補(bǔ)充了傳統(tǒng)的接觸者追蹤工作,并由50多個(gè)國(guó)家、州和地區(qū)的公共衛(wèi)生當(dāng)局部署,以幫助遏制感染的傳播。

?

在流感大流行的早期,公共衛(wèi)生官員表示,他們需要更全面的數(shù)據(jù)來(lái)對(duì)抗病毒的快速傳播。我們的社區(qū)流動(dòng)性報(bào)告,提供了對(duì)人口流動(dòng)趨勢(shì)的匿名追蹤,不僅幫助研究人員了解政策的影響,如居家指令和社會(huì)距離,同時(shí)還進(jìn)行了經(jīng)濟(jì)影響的預(yù)測(cè)。

?

?

我們自己的研究人員也探索了用這種匿名數(shù)據(jù)來(lái)預(yù)測(cè)COVID-19的傳播,用圖神經(jīng)網(wǎng)絡(luò)代替?zhèn)鹘y(tǒng)的基于時(shí)間序列的模型。

?

冠狀病毒疾病搜索趨勢(shì)癥狀允許研究人員探索時(shí)間或癥狀之間的聯(lián)系,比如嗅覺(jué)缺失---- 嗅覺(jué)缺失有時(shí)是病毒的癥狀之一。為了進(jìn)一步支持更廣泛的研究社區(qū),我們推出了谷歌健康研究應(yīng)用程序,以提供公眾參與研究的方式。

?

圖:COVID-19搜索趨勢(shì)正在幫助研究人員研究疾病傳播和癥狀相關(guān)搜索之間的聯(lián)系

?

谷歌的團(tuán)隊(duì)正在為更廣泛的科學(xué)界提供工具和資源,這些科學(xué)界正在努力解決病毒對(duì)健康和經(jīng)濟(jì)的影響。

?

圖:一個(gè)模擬新冠病毒擴(kuò)散的時(shí)空?qǐng)D

?

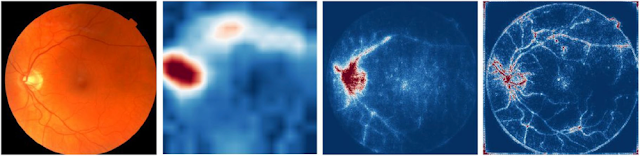

我們還致力于幫助識(shí)別皮膚疾病,幫助檢測(cè)老年黃斑變性(在美國(guó)和英國(guó)是導(dǎo)致失明的主要原因,在全世界是第三大致盲原因) ,以及潛在的新型非侵入性診斷(例如,能夠從視網(wǎng)膜圖像中檢測(cè)出貧血的跡象)。

?

圖:深度學(xué)習(xí)模型從視網(wǎng)膜圖像中量化血紅蛋白水平。血紅蛋白水平是檢測(cè)貧血的一項(xiàng)指標(biāo)

?

今年,同樣的技術(shù)如何可以窺視人類基因組,也帶來(lái)了令人興奮的演示。谷歌的開(kāi)源工具DeepVariant,使用卷積神經(jīng)網(wǎng)絡(luò)基因組測(cè)序數(shù)據(jù)識(shí)別基因組變異,并在今年贏得了FDA的4個(gè)類別中的3個(gè)類別的最佳準(zhǔn)確性的挑戰(zhàn)。丹納-法伯癌癥研究所領(lǐng)導(dǎo)的一項(xiàng)研究使用同樣的工具,在2367名癌癥患者中,將導(dǎo)致前列腺癌和黑色素瘤的遺傳變異的診斷率提高了14% 。

天氣、環(huán)境和氣候變化

?

機(jī)器學(xué)習(xí)能幫助我們更好地了解環(huán)境,并幫助人們?cè)谌粘I钪幸约霸跒?zāi)難情況下做出有用的預(yù)測(cè)。

?

對(duì)于天氣和降水預(yù)報(bào),像 NOAA 的 HRRR 這樣基于計(jì)算物理的模型一直占據(jù)著主導(dǎo)地位。然而,我們已經(jīng)能夠證明,基于ML的預(yù)報(bào)系統(tǒng)能夠以更好的空間分辨率預(yù)測(cè)當(dāng)前的降水量(“西雅圖的本地公園是不是在下雨? ”而不僅僅是“西雅圖在下雨嗎? ”)它能夠產(chǎn)生長(zhǎng)達(dá)8小時(shí)的短期預(yù)報(bào),比 HRRR 準(zhǔn)確得多,并且能夠以更高的時(shí)間和空間分辨率更快地計(jì)算預(yù)報(bào)。

?

?

我們還開(kāi)發(fā)了一種改進(jìn)的技術(shù),稱為 HydroNets,它使用一個(gè)神經(jīng)網(wǎng)絡(luò)來(lái)建模真實(shí)的河流系統(tǒng),以更準(zhǔn)確地了解上游水位對(duì)下游洪水的相互作用,做出更準(zhǔn)確的水位預(yù)測(cè)和洪水預(yù)報(bào)。利用這些技術(shù),我們已經(jīng)將印度和孟加拉國(guó)的洪水警報(bào)覆蓋范圍擴(kuò)大了20倍,幫助在25萬(wàn)平方公里內(nèi)更好地保護(hù)了2億多人。

?

可訪問(wèn)性(Accessibility)

機(jī)器學(xué)習(xí)繼續(xù)為提高可訪問(wèn)性提供了驚人的機(jī)會(huì),因?yàn)樗梢詫W(xué)會(huì)將一種感官輸入轉(zhuǎn)化為其他輸入。舉個(gè)例子,我們發(fā)布了 Lookout,一個(gè) Android 應(yīng)用程序,可以幫助視力受損的用戶識(shí)別包裝食品,無(wú)論是在雜貨店還是在他們家的廚房櫥柜里。

?

?

Lookout 背后的機(jī)器學(xué)習(xí)系統(tǒng)演示了一個(gè)功能強(qiáng)大但緊湊的機(jī)器學(xué)習(xí)模型,可以在有近200萬(wàn)個(gè)產(chǎn)品的手機(jī)上實(shí)時(shí)完成這一任務(wù)。

?

同樣,使用手語(yǔ)交流的人很難使用視頻會(huì)議系統(tǒng),因?yàn)榧词顾麄冊(cè)谑终Z(yǔ),基于音頻的揚(yáng)聲器檢測(cè)系統(tǒng)也檢測(cè)不到他們?cè)谥鲃?dòng)說(shuō)話。為視頻會(huì)議開(kāi)發(fā)實(shí)時(shí)自動(dòng)手語(yǔ)檢測(cè),我們提出了一種實(shí)時(shí)手語(yǔ)檢測(cè)模型,并演示了如何利用該模型為視頻會(huì)議系統(tǒng)提供一種識(shí)別手語(yǔ)者為主動(dòng)說(shuō)話者的機(jī)制。

?

機(jī)器學(xué)習(xí)在其他領(lǐng)域的應(yīng)用

2020年,我們與 FlyEM 團(tuán)隊(duì)合作,發(fā)布了果蠅半腦連接體,這是一種大型突觸分辨率圖譜的大腦連接,重建使用大規(guī)模機(jī)器學(xué)習(xí)模型應(yīng)用于高分辨率電子顯微鏡成像的腦組織。這些連接體信息將幫助神經(jīng)科學(xué)家進(jìn)行各種各樣的研究,幫助我們更好地理解大腦是如何運(yùn)作的。

?

負(fù)責(zé)任的人工智能

為了更好地理解語(yǔ)言模型的行為,我們開(kāi)發(fā)了語(yǔ)言可解釋性工具(LIT) ,這是一個(gè)可以更好地解釋語(yǔ)言模型的工具包,使得交互式探索和分析語(yǔ)言模型的決策成為可能。

?

我們開(kāi)發(fā)了在預(yù)訓(xùn)練語(yǔ)言模型中測(cè)量性別相關(guān)性的技術(shù),以及在谷歌翻譯中減少性別偏見(jiàn)的可擴(kuò)展技術(shù)。

?

為了幫助非專業(yè)人員解釋機(jī)器學(xué)習(xí)結(jié)果,我們擴(kuò)展了2019年引入的 TCAV 技術(shù),現(xiàn)在提供了一套完整而充分的概念。我們可以說(shuō)“毛”和“長(zhǎng)耳朵”是“兔子”預(yù)測(cè)的重要概念。通過(guò)這項(xiàng)工作,我們還可以說(shuō),這兩個(gè)概念足以充分解釋預(yù)測(cè); 您不需要任何其他概念。

?

?

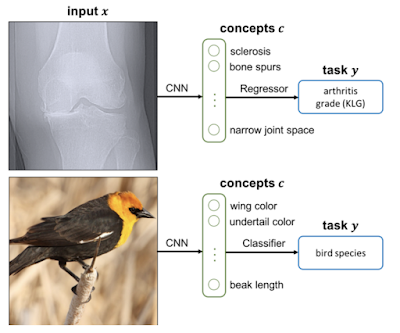

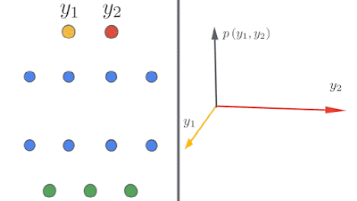

概念瓶頸模型是一種技術(shù),通過(guò)訓(xùn)練模型,使其中一層與預(yù)先定義的專家概念(例如,“骨刺呈現(xiàn)” ,或“翅膀顏色” ,如下所示)保持一致,然后再對(duì)任務(wù)做出最終預(yù)測(cè),這樣我們不僅可以解釋這些概念,還可以動(dòng)態(tài)地打開(kāi)/關(guān)閉這些概念。

?

自然語(yǔ)言理解

?

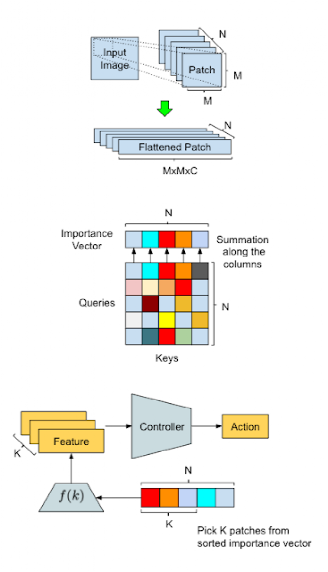

更好地理解語(yǔ)言是我們今年看到相當(dāng)大進(jìn)展的一個(gè)領(lǐng)域。谷歌和其他公司在這個(gè)領(lǐng)域的大部分工作現(xiàn)在都依賴于transformer,這是一種特殊風(fēng)格的神經(jīng)網(wǎng)絡(luò)模型,最初是為了解決語(yǔ)言問(wèn)題而開(kāi)發(fā)的(但是越來(lái)越多的證據(jù)表明,它們對(duì)圖像、視頻、語(yǔ)音、蛋白質(zhì)折疊以及其他各種各樣的領(lǐng)域也很有用)。

?

在2020年,我們描述了 Meena,一個(gè)對(duì)話機(jī)器人,可以聊任何事情。

?

?

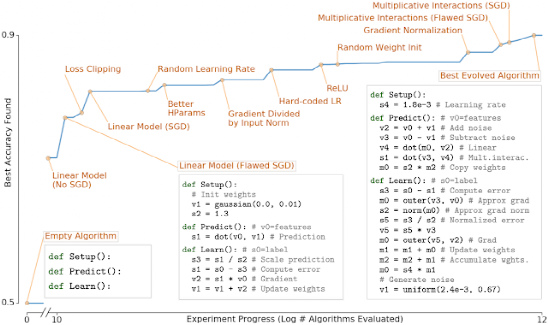

機(jī)器學(xué)習(xí)算法

強(qiáng)化學(xué)習(xí)

AutoML

更好地理解ML算法和模型

機(jī)器感知