細膩度圖像分類BCNN

[1] Lin T Y, RoyChowdhury A, Maji S. Bilinear cnn models for fine-grained visual recognition[C]//Proceedings of the IEEE International Conference on Computer Vision. 2015: 1449-1457.

[2] Lin T Y, RoyChowdhury A, Maji S. Bilinear CNNs for Fine-grained Visual Recognition//arXiv. 2017.

摘要

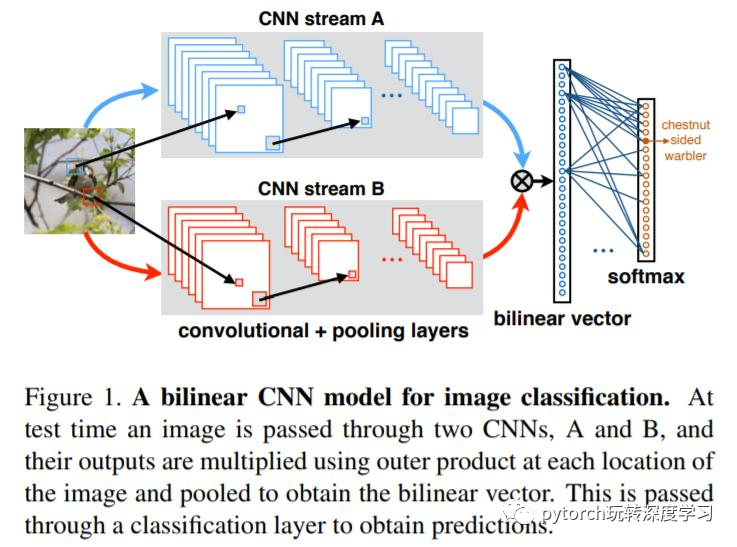

定義:雙線性CNN模型:包含兩個特征提取器,其輸出經(jīng)過外積(外積WiKi)相乘、池化后獲得圖像描述子。

優(yōu)點:

該架構(gòu)能夠以平移不變的方式,對局部的對級(pairwise)特征交互進行建模,適用于細粒度分類。

能夠泛化多種順序無關(guān)的特征描述子,如Fisher 向量,VLAD及O2P。實驗中使用使用卷積神經(jīng)網(wǎng)絡(luò)的作為特征提取器的雙線性模型。

雙線性形式簡化了梯度計算,能夠?qū)蓚€網(wǎng)絡(luò)在只有圖像標(biāo)簽的情況下進行端到端訓(xùn)練。

實驗結(jié)果:

對ImageNet數(shù)據(jù)集上訓(xùn)練的網(wǎng)絡(luò)進行特定領(lǐng)域的微調(diào),該模型在CUB200-2011數(shù)據(jù)集上,訓(xùn)練時達到了84.1%的準(zhǔn)確率。

作者進行了實驗及可視化以分析微調(diào)的效果,并在考慮模型速度和精確度的情況下選擇了兩路網(wǎng)絡(luò)。

結(jié)果顯示,該架構(gòu)在大多數(shù)細粒度數(shù)據(jù)集上都可以與先前算法相媲美,并且更加簡潔、易于訓(xùn)練。更重要的是,準(zhǔn)確率最高的模型可以在NVIDIA Tesla K40 GPU上以8 f/s的速度高效運行。代碼鏈接:http://vis-www.cs.umass.edu/bcnn

介紹

細粒度識別

對同屬一個子類的物體進行分類,通常需要對高度局部化、且與圖像中姿態(tài)及位置無關(guān)的特征進行識別。例如,“加利福尼亞海鷗”與“環(huán)狀海鷗”的區(qū)分就要求對其身體顏色紋理,或羽毛顏色的微細差異進行識別。

通常的技術(shù)分為兩種:局部模型:先對局部定位,之后提取其特征,獲得圖像特征描述。缺陷:外觀通常會隨著位置、姿態(tài)及視角的改變的改變。

整體模型:直接構(gòu)造整幅圖像的特征表示。包括經(jīng)典的圖像表示方式,如Bag-of-Visual-Words,及其適用于紋理分析的多種變種。

基于CNN的局部模型要求對訓(xùn)練圖像局部標(biāo)注,代價昂貴,并且某些類沒有明確定義的局部特征,如紋理及場景。作者思路

局部模型高效性的原因:本文中,作者聲稱局部推理的高效性在于其與物體的位置及姿態(tài)無關(guān)。紋理表示通過將圖像特征進行無序組合的設(shè)計,而獲得平移無關(guān)性。

紋理表征性能不佳的思考:基于SIFT及CNN的紋理表征已經(jīng)在細粒度物體識別上顯示出高效性,但其性能還亞于基于局部模型的方法。其可能原因就是紋理表示的重要特征并沒有通過端到端訓(xùn)練獲得,因此在識別任務(wù)中沒有達到最佳效果。

洞察點:某些廣泛使用的紋理表征模型都可以寫作將兩個合適的特征提取器的輸出,外積之后,經(jīng)池化得到。

首先,(圖像)先經(jīng)過CNNs單元提取特征,之后經(jīng)過雙線性層及池化層,其輸出是固定長度的高維特征表示,其可以結(jié)合全連接層預(yù)測類標(biāo)簽。最簡單的雙線性層就是將兩個獨立的特征用外積結(jié)合。這與圖像語義分割中的二階池化類似。

實驗結(jié)果:作者在鳥類、飛機、汽車等細粒度識別數(shù)據(jù)集上對模型性能進行測試。表明B-CNN性能在大多細粒度識別的數(shù)據(jù)集上,都優(yōu)于當(dāng)前模型,甚至是基于局部監(jiān)督學(xué)習(xí)的模型,并且相當(dāng)高效