「煉丹」師的福音!支持AMD GPU,PyTorch 1.8來了!

新智元報(bào)道

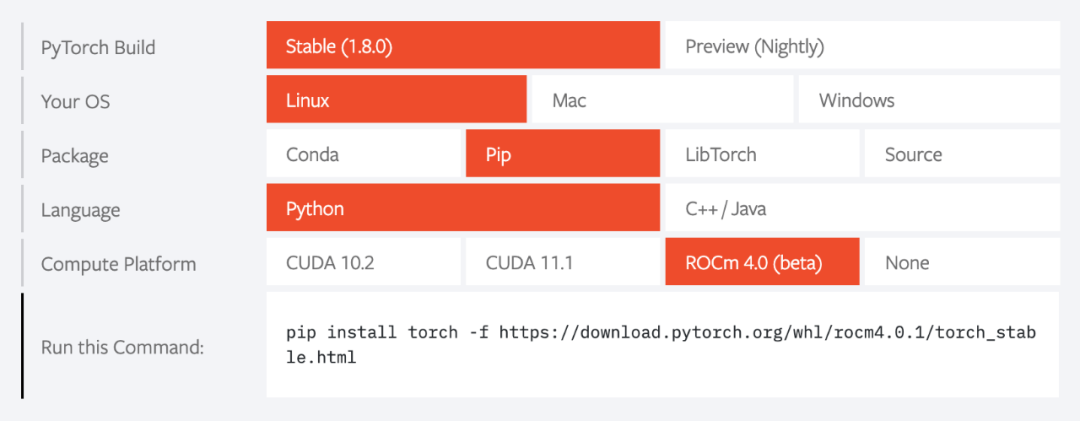

【新智元導(dǎo)讀】PyTorch1.8發(fā)布,整體來看,本次更新涵蓋1.7版本發(fā)布以來,共計(jì)3000多次Github提交,包括編譯、代碼優(yōu)化、科學(xué)計(jì)算前端 API 以及通過 pytorch.org 提供的二進(jìn)制文件支持AMD ROCm。

PyTorch是一個(gè)開源的Python機(jī)器學(xué)習(xí)庫(kù)。2017年1月,由Facebook人工智能研究院(FAIR)基于Torch推出了PyTorch,用于自然語(yǔ)言處理等應(yīng)用程序。

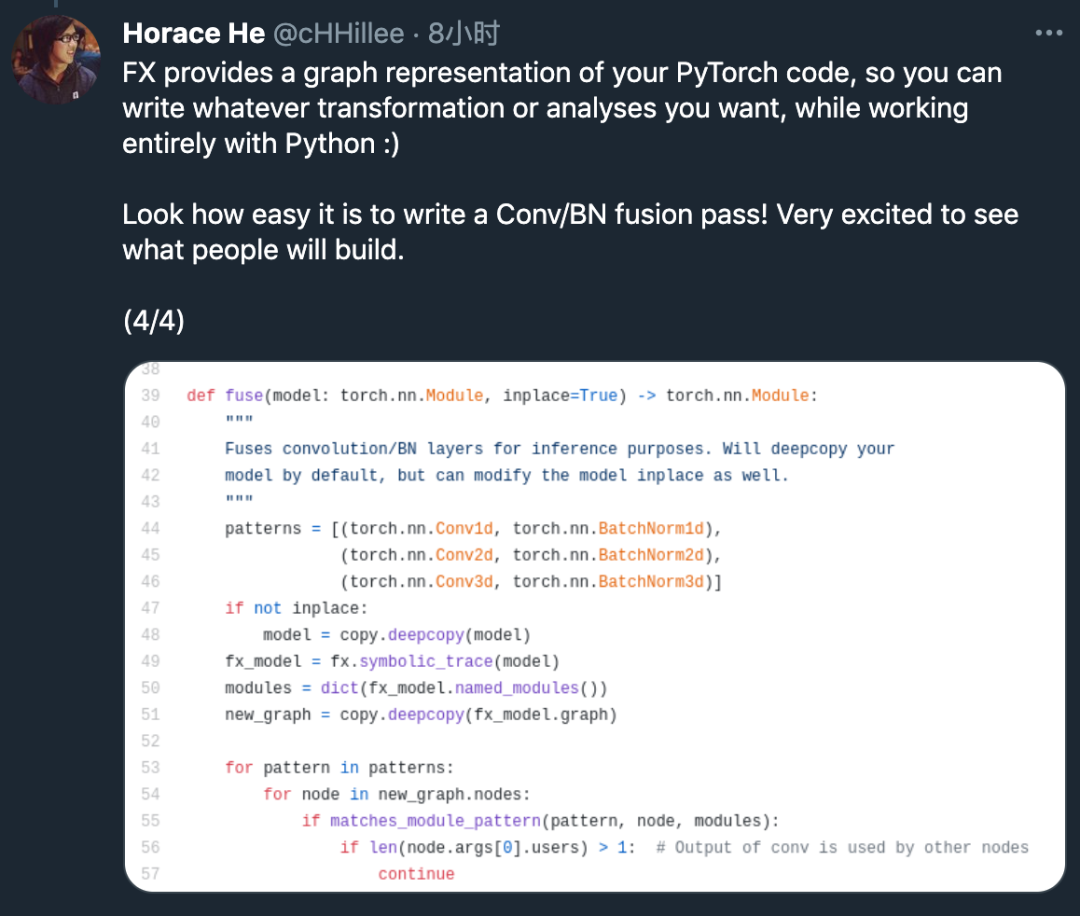

支持通過 torch.fx進(jìn)行函數(shù)轉(zhuǎn)換;

增加和調(diào)整 API以支持 FFT( torch.fft )、線性代數(shù)函數(shù)( torch.linalg )

添加了復(fù)雜張量自動(dòng)求導(dǎo)(autograd)的支持,并提升了矩陣計(jì)算 hessian 和 jacobian 的能力;

對(duì)分布式訓(xùn)練進(jìn)行了重大更新和改進(jìn),包括:改進(jìn) NCCL 可靠性,支持管道并行,RPC 分析,支持添加梯度壓縮的通訊 鉤子。

[穩(wěn)定版] Torch.fft 支持高性能 NumPy 中的 FFT

[測(cè)試版] torch.linalg 將支持 NumPy 中的線性代數(shù)函

[測(cè)試版] 利用 FX 進(jìn)行 Pthon 代碼轉(zhuǎn)換。

ZeroRedundancyOptimizer:有助于減少每個(gè)線程的內(nèi)存占用;

進(jìn)程組 NCCL 發(fā)送/接收:允許用戶在 Python 層(而非 C++ 層)實(shí)現(xiàn)集合操作;

RPC 中用 TensorPipe 支持 CUDA:為使用 PyTorch RPC 和多 GPU 機(jī)器的用戶帶來速度提升;

遠(yuǎn)程模塊:允許用戶像操作本地模塊那樣操作遠(yuǎn)程 worker 上的模塊。

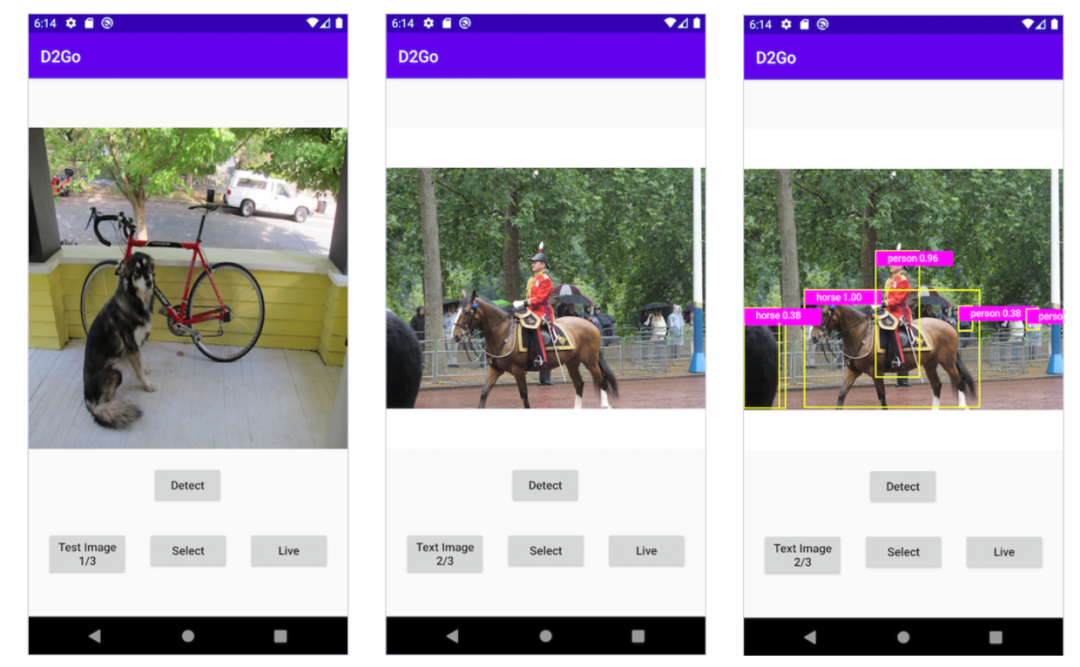

iOS 端用 DeepLabV3 進(jìn)行圖像分割

Android 端用 DeepLabV3 進(jìn)行圖像分割

Benchmark utils

FX Graph Mode Quantization

強(qiáng)化 PyTorch Dispatcher 的能力,使其適應(yīng) C++ 中后端開發(fā)

AMD GPU 二進(jìn)制文件現(xiàn)已推出

需要注意的是,PyTorch 1.8 僅在 Linux 系統(tǒng)中支持 AMD ROCm。