PyTorch 1.8發(fā)布,支持AMD GPU和Python函數轉換

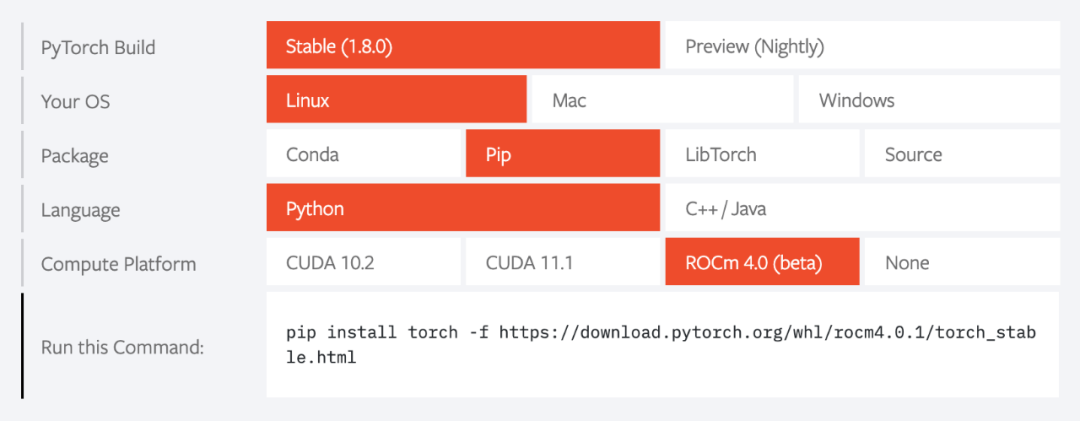

近日,PyTorch 團隊發(fā)布了 PyTorch 1.8 版本。該版本整合了自去年 10 月 1.7 版本發(fā)布以來的 3000 多次 commit,提供了編譯、代碼優(yōu)化、科學計算前端 API 方面的主要更新和新特性。值得一提的是,該版本新增了對 AMD ROCm 的支持。

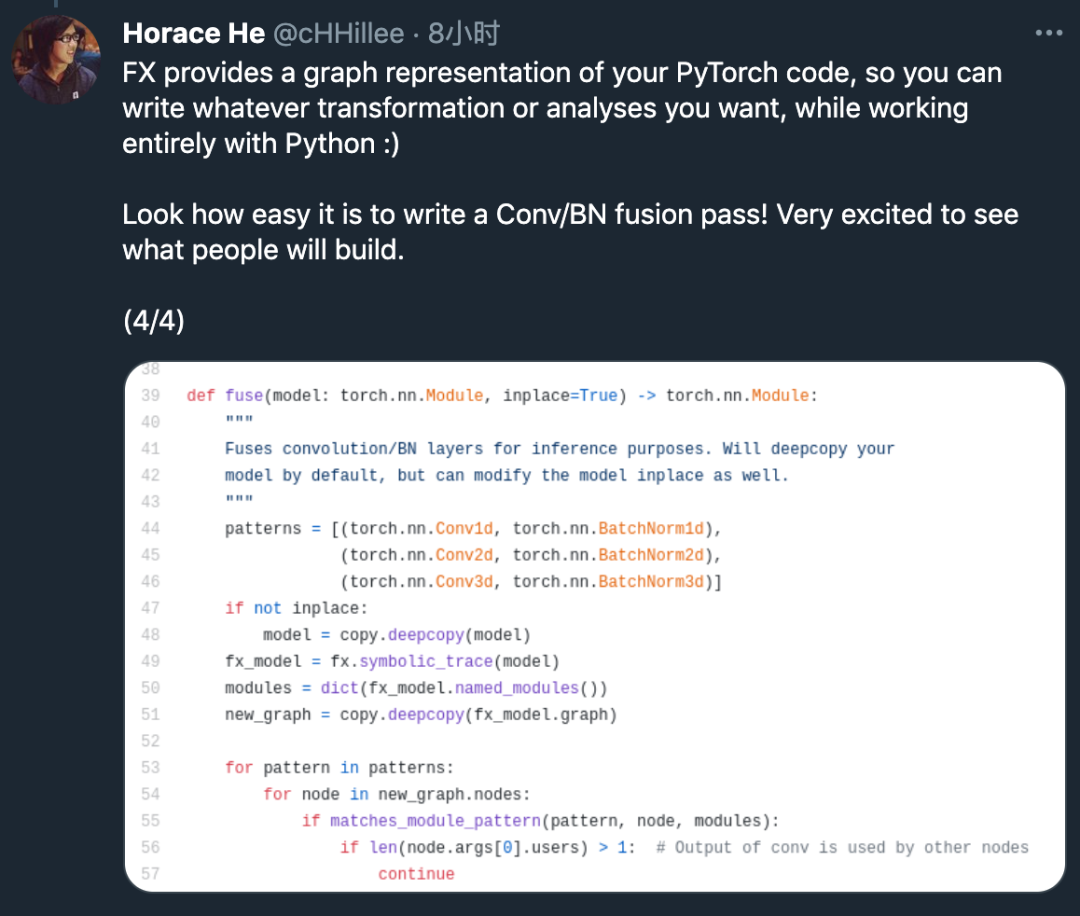

支持 Python 函數轉換;

添加或穩(wěn)定化 API,以支持 FFT (torch.fft)、線性代數函數 (torch.linalg);

添加對復雜張量 autograd 的支持;

多項更新用于提升 Hessian 與 Jacobian 矩陣計算的性能;

改進分布式訓練,包括提升 NCCL 可靠性、支持 pipeline 并行化、RPC profiling,以及通過添加梯度壓縮來支持通信鉤子(hook)。

ZeroRedundancyOptimizer:有助于減少每個線程的內存占用;

Process Group NCCL Send/Recv:該特性允許用戶在 Python 層(而非 C++ 層)實現集合操作;

CUDA-support in RPC using TensorPipe:該特性為使用 PyTorch RPC 和多 GPU 機器的用戶帶來速度提升;

Remote Module:該特性允許用戶像操作本地模塊那樣操作遠程 worker 上的模塊。

往期精彩:

【原創(chuàng)首發(fā)】機器學習公式推導與代碼實現30講.pdf

【原創(chuàng)首發(fā)】深度學習語義分割理論與實戰(zhàn)指南.pdf

點個在看

評論

圖片

表情