基于深度學(xué)習(xí)的超分辨率圖像技術(shù)發(fā)展軌跡一覽

? 作者 | 黃浴

轉(zhuǎn)載自知乎

導(dǎo)讀:近年來,使用深度學(xué)習(xí)技術(shù)的圖像超分辨率(SR)取得了顯著進(jìn)步。本文中,奇點(diǎn)汽車自動(dòng)駕駛首席科學(xué)家黃浴對基于深度學(xué)習(xí)技術(shù)的圖像超分辨率技術(shù)進(jìn)行了一次全面的總結(jié),分析了這門技術(shù)近年來的發(fā)展軌跡。

我們一般可以將現(xiàn)有的 SR 技術(shù)研究大致分為三大類:監(jiān)督 SR ,無監(jiān)督 SR 和特定領(lǐng)域 SR (人臉)。

監(jiān)督SR

如今已經(jīng)有各種深度學(xué)習(xí)的超分辨率模型。這些模型依賴于有監(jiān)督的超分辨率,即用LR圖像和相應(yīng)的基礎(chǔ)事實(shí)( GT )HR 圖像訓(xùn)練。 雖然這些模型之間的差異非常大,但它們本質(zhì)上是一組組件的組合,例如模型框架,上采樣方法,網(wǎng)絡(luò)設(shè)計(jì)和學(xué)習(xí)策略等。從這個(gè)角度來看,研究人員將這些組件組合起來構(gòu)建一個(gè)用于擬合特定任務(wù)的集成 SR 模型。

由于圖像超分辨率是一個(gè)病態(tài)問題,如何進(jìn)行上采樣(即從低分辨率產(chǎn)生高分辨率)是關(guān)鍵問題。基于采用的上采樣操作及其在模型中的位置, SR 模型可歸因于四種模型框架:預(yù)先采樣 SR ,后上采樣 SR ,漸進(jìn)上采樣 SR 和迭代上下采樣 SR ,如圖所示。

除了在模型中的位置之外,上采樣操作如何實(shí)現(xiàn)它們也非常重要。為了克服插值法的缺點(diǎn),并以端到端的方式學(xué)習(xí)上采樣操作,轉(zhuǎn)置卷積層(Transposed Convolution Layer)和亞像素層(Sub-pixel Layer)可以引入到超分辨率中。

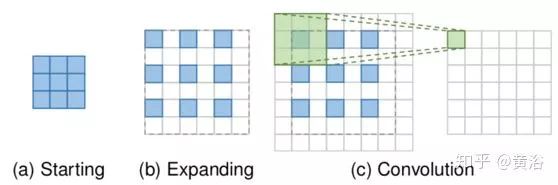

轉(zhuǎn)置卷積層,即反卷積層,基于尺寸類似于卷積層輸出的特征圖來預(yù)測可能的輸入。具體地說,它通過插入零值并執(zhí)行卷積來擴(kuò)展圖像,從而提高了圖像分辨率。為了簡潔起見,以 3×3 內(nèi)核執(zhí)行 2 次上采樣為例,如圖所示。首先,輸入擴(kuò)展到原始大小的兩倍,其中新添加的像素值被設(shè)置為 0(b)。然后應(yīng)用大小為 3×3、步長 1 和填充 1 的內(nèi)核卷積(c)。這樣輸入特征圖實(shí)現(xiàn)因子為2 的上采樣,而感受野最多為 2×2 。

由于轉(zhuǎn)置卷積層可以以端到端的方式放大圖像大小,同時(shí)保持與 vanilla 卷積兼容的連接模式,因此它被廣泛用作 SR 模型的上采樣層。然而,它很容易在每個(gè)軸上產(chǎn)生“不均勻重疊(uneven overlapping)”,并且在兩個(gè)軸的乘法進(jìn)一步產(chǎn)生了特有的不同幅度棋盤狀圖案,從而損害了 SR 性能。

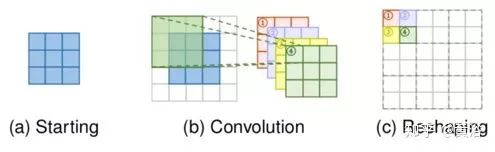

亞像素層也是端到端學(xué)習(xí)的上采樣層,通過卷積生成多個(gè)通道然后重新整形,如圖所示。首先卷積產(chǎn)生具有 s2 倍通道的輸出,其中 s 是上采樣因子(b)。假設(shè)輸入大小為 h×w×c ,則輸出大小為 h×w×s2c。之后,執(zhí)行整形( shuffle )操作產(chǎn)生大小為 sh×sw×c 的輸出(c)。感受野大小可以達(dá)到 3×3 。

由于端到端的上采樣方式,亞像素層也被 SR 模型廣泛使用。與轉(zhuǎn)置卷積層相比,亞像素層的最大優(yōu)勢是具有較大的感知場,提供更多的上下文信息,能幫助生成更準(zhǔn)確的細(xì)節(jié)。然而,亞像素層的感受野的分布是不均勻的,塊狀區(qū)域?qū)嶋H上共享相同的感受野,這可能導(dǎo)致在塊邊界附近的一些畸變。

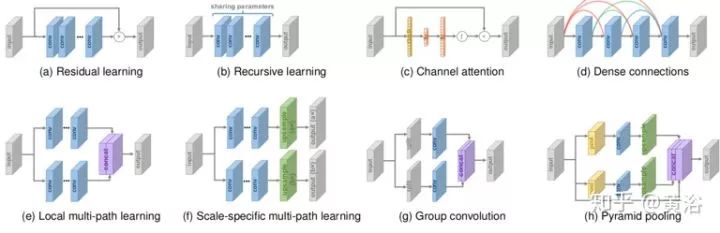

各種深度學(xué)習(xí)的模型已經(jīng)被用于 SR ,如圖所示。

ResNet 學(xué)習(xí)殘差而不是徹底的映射,已被 SR 模型廣泛采用,如上圖(a)所示。其中,殘差學(xué)習(xí)策略可以大致分為兩種類型,即全局和局部殘差學(xué)習(xí)。

由于超分辨率是圖像到圖像的轉(zhuǎn)換任務(wù),其中輸入圖像與目標(biāo)圖像高度相關(guān),全局殘差學(xué)習(xí)僅學(xué)習(xí)兩個(gè)圖像之間的殘差。在這種情況下,它避免學(xué)習(xí)從完整圖像到另一個(gè)圖像的復(fù)雜轉(zhuǎn)換,而只需要學(xué)習(xí)殘差圖來恢復(fù)丟失的高頻細(xì)節(jié)。由于大多數(shù)區(qū)域殘差接近于零,模型的復(fù)雜性和學(xué)習(xí)難度都大大降低。這種方法在預(yù)上采樣的 SR 框架普遍采用。

局部殘差學(xué)習(xí)類似于 ResNet 的殘差學(xué)習(xí),用于緩解不斷增加的網(wǎng)絡(luò)深度引起的退化問題并提高學(xué)習(xí)能力。

實(shí)踐中,上述方法都是通過快捷連接(通常有小常數(shù)因子的縮放)和逐元素加法操作實(shí)現(xiàn)的。區(qū)別在于,前者直接連接輸入圖像和輸出圖像,而后者通常在不同深度的網(wǎng)絡(luò)中層之間添加多個(gè)快捷方式。

??遞歸學(xué)習(xí)

遞歸學(xué)習(xí)(以遞歸方式多次應(yīng)用相同模塊)也被超分辨率采用,如上圖 (b)所示。在實(shí)踐中,遞歸學(xué)習(xí)固有地帶來了消失(vanishing)或爆漲(exploding)梯度問題,因此殘差學(xué)習(xí)和多信號監(jiān)督等一些技術(shù)通常與遞歸學(xué)習(xí)相結(jié)合,以減輕這些問題。

??通道關(guān)注

考慮到不同通道之間特征表征的相互依賴和作用,一種“擠壓-激發(fā)(SAE,squeeze-and-excitation)”模塊明確對通道相互依賴性建模,來提高表示能力,如上圖(c)所示。其中用全局平均池化將每個(gè)輸入通道壓縮到通道描述子(即一個(gè)常數(shù))中,然后將這些描述子饋送到兩個(gè)全連接層產(chǎn)生通道尺度因子。基于通道乘法,用尺度因子重新縮放輸入通道得到最終輸出。

??致密連接

致密連接在視覺任務(wù)中變得越來越流行。在致密塊的每個(gè)層,所有前層的特征圖用作輸入,并且其自身特征圖用作所有后續(xù)層的輸入,在一個(gè)有 l 層致密塊中帶來 l·(l - 1)/ 2 個(gè)連接。致密連接,不僅有助于緩解梯度消失問題、增強(qiáng)信號的傳播并促進(jìn)特征重用,而且在連接之后采用小增長率(即致密塊的通道數(shù))和通道縮減來大大減少參數(shù)量。

為了融合低級和高級特征以提供更豐富的信息來重建高質(zhì)量的細(xì)節(jié),致密連接被引入 SR 領(lǐng)域,如上圖(d)所示。

??多路徑學(xué)習(xí)

多路徑學(xué)習(xí)指模型存在多個(gè)路徑傳遞特征,這些路徑執(zhí)行不同的操作以提供更好的建模功能。具體而言,它可以分為三種類型:全局法、局部法和特定尺度法。

全局多路徑學(xué)習(xí)是指用多個(gè)路徑提取圖像不同方面的特征。這些路徑可以在傳播中相互交叉,從而大大增強(qiáng)了特征提取的能力。

本地多路徑學(xué)習(xí)用新塊進(jìn)行多尺度特征提取,如上圖(e)所示。該塊采用不同內(nèi)核大小的卷積同時(shí)提取特征,然后將輸出連接起來并再次進(jìn)行相同的操作。快捷方式通過逐元素添加來連接該塊的輸出和輸入。通過這種局部多路徑學(xué)習(xí),SR 模型可以更好地從多個(gè)尺度提取圖像特征,進(jìn)一步提高性能。

特定尺度多路徑學(xué)習(xí)共享模型的主要部分(即特征提取的中間部分),并分別在網(wǎng)絡(luò)的開頭和結(jié)尾附加特定尺度的預(yù)處理路徑和上采樣路徑,如上圖(f)所示。在訓(xùn)練期間,僅啟用和更新與所選尺度對應(yīng)的路徑。這樣大多數(shù)參數(shù)在不同尺度上共享。

??高級卷積

卷積運(yùn)算是深度神經(jīng)網(wǎng)絡(luò)的基礎(chǔ),改進(jìn)卷積運(yùn)算可獲得更好的性能或更快的速度。這里給出兩個(gè)方法:擴(kuò)張卷積( Dilated Convolution )和群卷積( Group Convolution )。 眾所周知,上下文信息有助于在圖像超分辨率生成逼真的細(xì)節(jié)。擴(kuò)張卷積能將感受野增加兩倍,最終實(shí)現(xiàn)更好的性能。群卷積以很少的性能損失可減少大量的參數(shù)和操作,如上圖( g )所示。

??像素遞歸學(xué)習(xí)

大多數(shù) SR 模型認(rèn)為這是一個(gè)與像素?zé)o關(guān)的任務(wù),因此無法正確地確定生成像素之間的相互依賴性。在人注意力轉(zhuǎn)移機(jī)制推動(dòng)下,一種遞推網(wǎng)絡(luò)可依次發(fā)現(xiàn)參與的補(bǔ)丁并進(jìn)行局部增強(qiáng)。以這種方式,模型能夠根據(jù)每個(gè)圖像自身特性自適應(yīng)地個(gè)性化最佳搜索路徑,從而充分利用圖像全局的內(nèi)依賴性( intra-dependence )。不過,需要長傳播路徑的遞歸過程,特別對超分辨率的 HR 圖像,大大增加了計(jì)算成本和訓(xùn)練難度。

??金字塔池化

金字塔池化模塊更好地利用全局和局部的上下文信息,如上圖( h )所示。 具體地,對于尺寸為 h×w×c 的特征圖,每個(gè)特征圖被劃分為 M×M 個(gè)區(qū)間,并經(jīng)歷全局平均池化產(chǎn)生 M×M×c 個(gè)輸出。 然后,執(zhí)行 1×1 卷積輸出壓縮到一個(gè)單信道。 之后,通過雙線性插值將低維特征圖上采樣到與原始特征圖相同的大小。 使用不同的 M,該模塊可以有效地整合全局和局部的上下文信息。

??小波變換

眾所周知,小波變換( WT )是一種高效的圖像表示,將圖像信號分解為表示紋理細(xì)節(jié)的高頻小波和包含全局拓?fù)湫畔⒌牡皖l小波。將 WT 與基于深度學(xué)習(xí)的 SR 模型相結(jié)合,這樣插值 LR 小波的子帶作為輸入,并預(yù)測相應(yīng) HR 子帶的殘差。 WT 和逆 WT 分別用于分解LR輸入和重建 HR 輸出。

另外學(xué)習(xí)策略問題,涉及損失函數(shù)的設(shè)計(jì)(包括像素?fù)p失,內(nèi)容損失,紋理損失,對抗損失和周期連續(xù)損失)、批處理歸一化(BN)、課程學(xué)習(xí)(Curriculum Learning)和多信號監(jiān)督( Multi-supervision )等等。

無監(jiān)督SR

現(xiàn)有的超分辨率工作主要集中在監(jiān)督學(xué)習(xí)上,然而難以收集不同分辨率的相同場景的圖像,因此通常通過對 HR 圖像預(yù)定義退化來獲得 SR 數(shù)據(jù)集中的 LR 圖像。為了防止預(yù)定義退化帶來的不利影響,無監(jiān)督的超分辨率成為選擇。在這種情況下,只提供非配對圖像( HR 或 LR )用于訓(xùn)練,實(shí)際上得到的模型更可能應(yīng)對實(shí)際場景中的 SR 問題。

??零擊(zero shot)超分辨率

單個(gè)圖像內(nèi)部的統(tǒng)計(jì)數(shù)據(jù)足以提供超分辨率所需的信息,所以零擊超分辨率(ZSSR)在測試時(shí)訓(xùn)練小圖像特定的 SR 網(wǎng)絡(luò)進(jìn)行無監(jiān)督 SR ,而不是在大數(shù)據(jù)集上訓(xùn)練通用模型。具體來說,核估計(jì)方法直接從單個(gè)測試圖像估計(jì)退化內(nèi)核,并在測試圖像上執(zhí)行不同尺度因子的退化來構(gòu)建小數(shù)據(jù)集。然后在該數(shù)據(jù)集上訓(xùn)練超分辨率的小 CNN 模型用于最終預(yù)測。

ZSSR 利用圖像內(nèi)部特定信息的跨尺度復(fù)現(xiàn)這一特點(diǎn),對非理想條件下(非 bi-cubic 退化核獲得的圖像,受模糊、噪聲和壓縮畸變等影響)更接近現(xiàn)實(shí)世界場景的圖像,比以前的方法性能提高一大截,同時(shí)在理想條件下( bi-cubic 插值構(gòu)建的圖像),和以前方法結(jié)果差不多。盡管這樣,由于需要在測試期間為每個(gè)圖像訓(xùn)練單個(gè)網(wǎng)絡(luò),使得其測試時(shí)間遠(yuǎn)比其他 SR 模型長。

??弱監(jiān)督 SR

為了在超分辨率中不引入預(yù)退化,弱監(jiān)督學(xué)習(xí)的 SR 模型,即使用不成對的 LR-HR 圖像,是一種方案。一些方法學(xué)習(xí) HR-LR 退化模型并用于構(gòu)建訓(xùn)練 SR 模型的數(shù)據(jù)集,而另外一些方法設(shè)計(jì)周期循環(huán)( cycle-in-cycle )網(wǎng)絡(luò)同時(shí)學(xué)習(xí) LR-HR 和 HR-LR 映射。

由于預(yù)退化是次優(yōu)的,從未配對的 LR-HR 數(shù)據(jù)集中學(xué)習(xí)退化是可行的。一種方法稱為“兩步法”:

1)訓(xùn)練 HR-LR 的 GAN 模型,用不成對的 LR-HR 圖像學(xué)習(xí)退化; 2)基于第一個(gè) GAN 模型,使用成對的 LR-HR 圖像訓(xùn)練 LR- HR 的 GAN 模型執(zhí)行 SR 。

特定SR

參考文獻(xiàn)

Z Wang, J Chen, S Hoi,“Deep Learning for Image Super-resolution: A Survey”, Arxiv 1902.06068,2019 W Yang et al.,“Deep Learning for Single Image Super-Resolution: A Brief Review”, Archiv 1808.03344, 2018 Z Li et al.,“Feedback Network for Image Super-Resolution”, CVPR 2019 C Chen et al.,“Camera Lens Super-Resolution”, CVPR 2019 K Zhang et al.,“Deep Plug-and-Play Super-Resolution for Arbitrary Blur Kernels”, CVPR 2019

◆

精彩推薦

◆

推薦閱讀

??目標(biāo)檢測算法YOLO-V3結(jié)構(gòu)詳解

這38篇原創(chuàng)文章,帶我入門深度學(xué)習(xí)!

機(jī)器學(xué)習(xí)降壓神器(附代碼)

超前沿 | 約束多目標(biāo)優(yōu)化最新進(jìn)展

CNN中常用的四種卷積詳解

【智能算法】硬核干貨算法文章匯總